【导读】前段时间,LeCun转发了2篇长文,集中讨论了LLM的规划推理能力和涌现能力的来源。作者认为,LLM本身不具有规划推理能力,而涌现出来的能力,根源应该都是上下文学习的结果。

大语言模型到底会不会推理?涌现出来的各种能力到底来源是什么?

前段时间,LeCun在自己推特上转发了好几篇文章,集中讨论了这个问题:

「自回归LLM无法制定计划(并且无法真正推理)」。

而LeCun转发第二篇论文,则讨论了LLM涌现能力。

原推表示,不管大伙相不相信LLM的涌现能力,这篇文章都值得一读:

「经过了超过1000次的系列实验,我们证明了大语言模型所谓的涌现能力,其实仅仅是上下文学习而已。」

LLM真的能推理和规划吗?

Subbarao Kambhampat的文章认为,网上对于LLM能够推理和规划的说法,本身不太站得住脚,但是学界对于这个问题,也开始进行了很严肃地研究。

至少以他之前针对GPT-3的研究看来,认为大语言模型行能够推理和规划的说法是有很大问题的。

https://arxiv.org/pdf/2206.10498.pdf

我们提出了一个可扩展的评估框架来测试LLM推理行动和变化的能力,这是人类智力的一个核心方面。我们提供了多个测试用例,这些测试用例比之前建立的任何基准都更加复杂,并且每个测试用例都会评估有关操作和更改的推理的不同方面。GPT-3 (davinci)、Instruct-GPT-3 (text-davinci-002) 和 BLOOM (176B) 的结果显示此类推理任务的表现不佳。

针对新推出的GPT-4,教授的团队也将之前的研究进行了进一步的拓展,试图发现新的最先进的大语言模型是否对于推理和规划能力有了新的进展。

https://arxiv.org/pdf/2206.10498.pdf

我们通过在类似于国际规划竞赛中使用的方式,生成一组实例来进行系统研究,并以两种不同的模式评估LLM:自主模式和启发式模式。我们的研究结果表明,法学硕士自主生成可执行计划的能力相当有限,GPT-4在各个领域的平均成功率为 ∼12%。

然而,启发式模式的结果显示出更多的希望。在启发式模式中,我们证明了LLM生成的计划可以改进底层合理规划器的搜索过程,并且还表明外部验证者可以帮助提供对生成的计划的反馈,并反向提示 LLM 以更好地生成计划。

文章用一张很有意思的图向读者说明,似乎LLM表现出来的推理能力,主要的原因还是在于任务比较简单,提问题的人已经知道了问题的答案。

而针对竞赛级别的规划和推理任务,比如国际规划大赛(IPC)中的积木世界(Blocks World)问题,LLM的表现就不尽如人意。

初步结果表明,从GPT-3到GPT3.5再到GPT-4,生成的平面图的精度有一定的提高,GPT-4在Blocks World中达到30%的经验精度(empirical accuracy)(尽管在其他领域仍然较低)。

教授的研究团队认为,对于很多规划任务的表现,LLM的能力可能只是因为他在特别大的范围内进行了训练,从而「记住」规划的内容。

于是研究团队通过混淆规划问题中的动作和对象的名称来降低近似检索的有效性,阻止大语言模型检索自己记住的「规划内容」。

在这样的挑战面前,GPT-4的经验表现急剧下降。

对于LLM不能直接自主地进行规划的局限,研究团队通过两种方式进行改进:

首先是对模型进行微调,不过教授的团队在对模型进行了微调之后,还是没有发现模型的规划能力有提升。

而且认为,即便通过微调模型使得模型的规划能力提高了,但是也是将规划任务转化为基于内存的检索,而不能证明大语言模型能够进行自主规划。

第二种提高模型规划能力的方法是不断提示LLM,改进它初始的计划。

但是对于这种方法,特别是不断让模型自己生成改进意见的提示,本质上都是让模型生成猜测,或者是提示的人决定哪些猜测能更好地改进规划,都不是模型自己提升了计划能力。

那些顶会上声称展示了LLM规划能力的论文问题出在哪里?

持怀疑态度的读者现在可能会问,但那些在高调的人工智能会议上声称展示了LLM规划能力的论文是怎么回事?

要分析这些说法,首先需要明白,解决规划任务需要:

1. 拥有必要的规划领域知识

2. 能够将这些计划知识组装成一个可执行的计划,该计划负责完成子目标,或者进行资源交互。

第一个要素可以称为知识获取,第二个要素可以称为推理/计划。

许多声称LLM具有规划能力的论文,在仔细检查后,都混淆了从LLM中提取的可执行计划的一般规划知识。

如果研究人员所寻找的都是抽象的计划,例如「婚礼计划」,而没有实际执行计划的意图时,很容易将它们与完整的可执行计划混淆,从而没法准确地评估LLM的计划能力。

教授团队对几篇声称LLM具有规划能力的论文的仔细研究后发现,LLM要么在子目标交互可以被安全地忽略的领域/任务中进行计划工作(规划没有意义的任务或者不重要的任务),要么将推理问题委托给循环过程中的人类来完成(通过反复提示,「纠正」计划)。

如果没有这些假设或者缓冲措施,从LLM中得出的计划在外行用户看来可能是合理的,但会导致执行时出现各种各样的问题。

比如,旅行计划书籍的大量出现,这些书籍内容基本都是由LLM自动生成出来的,而购买这些书籍的读者却把它们误认为是可以执行的计划,最后会导致结果非常令读者失望。

LLM并不存在计划和推理能力

总而言之,教授认为,他所读过、验证过或做过的任何事情都没有给他任何令人信服的理由,让他相信LLM会像通常理解的那样进行推理/计划。

认为LLM具有推理/规划能力的研究所做的内容,在大规模的训练下,其实都相当于是检索,有时会被误认为是推理能力。

LLM确实擅长为任何任务产生想法,包括那些涉及推理的任务,这可以有效地用于支持推理/计划。 换句话说,LLM已经拥有足够惊人的近似检索的能力,我们可以充分利用这种能力,不需要将虚假的推理/计划能力归在LLM身上。

如果对于这个问题感兴趣,还可以参考教授的一场演讲。

而另一篇关于大语言模型涌现的能力的文章,针对的是上下文学习的能力。

涌现能力?不存在!

https://arxiv.org/pdf/2309.01809.pdf

简单来说,研究人员发现,LLM在执行一些没有经过明确训练的、且需要复杂推理能力的任务时,表现不是一般的好。

这种能力对未来NLP的研究方向产生了重大影响。随着LLMs的不断壮大,在可预见的未来,应用的场合会越来越普遍。

但问题在于,在研究人员评估LLMs的能力时,会被一些因素所干扰,导致混淆。

比方说,有些能力可能是由prompt技术带来的。上下文学习(in-context learning)和指令跟随(instruction following)都是其中的例子。

这些情况也会随着模型规模的不断变大而增多。

因此,本文的研究团队全面考察了这些能力,考虑到了一些可能影响模型评估的潜在偏差因素。

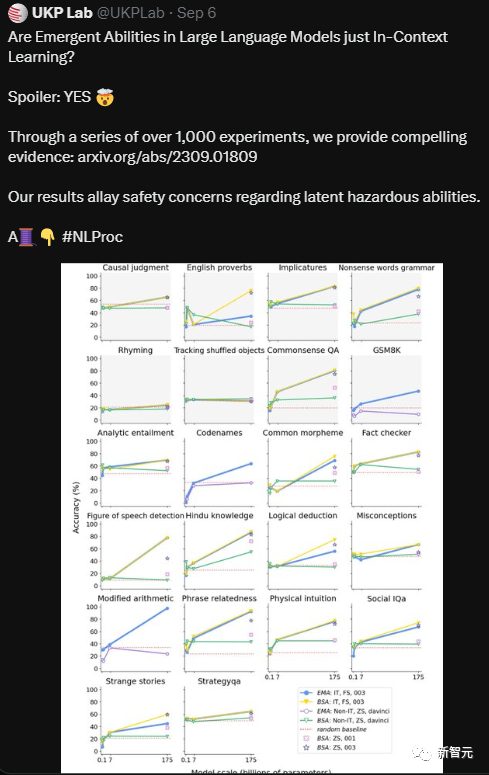

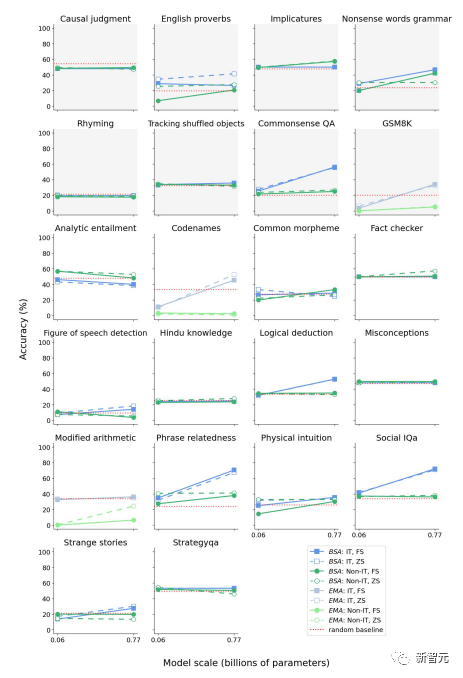

研究人员对一组18个模型进行了严密的测试,这些LLM的参数范围从6000万到1750亿不等,测试包含22项任务。

在经过了1000多次实验后,研究人员给出了充足的证据,证明了所谓的涌现能力,主要就是上下文学习带来的。

研究人员还表示,并没有找到能证明LLM有推理能力的证据。

实验方法

具体来看,研究人员逐一研究了以下问题:

·为了消除上下文学习和指令微调可能会带来的影响,研究人员选择了零样本条件,并使用了非指令微调的模型。

·探究上下文学习能力和指令微调之间的相互作用,搞明白是不是该用推理能力来解释指令微调模型的一些额外能力。为此,研究人员比较了没有指令微调的模型和在不同程度上经过指令微调的不同规模模型的能力。

·通过人工来检查LLM的功能性语言能力、形式语言能力,以及是否可以记住任务。

为了评估LLMs能力的真实程度,研究人员精心设计了实验结构,尽可能减少误导因素。

此外,该团队的实验设计特别注重不能触发模型的上下文学习能力。比如,指令微调会将训练模型的指令转化为示例(exemplar),这就可能导致上下文学习。

因此,实验团队使用了非指令微调的模型来避免这种可能。

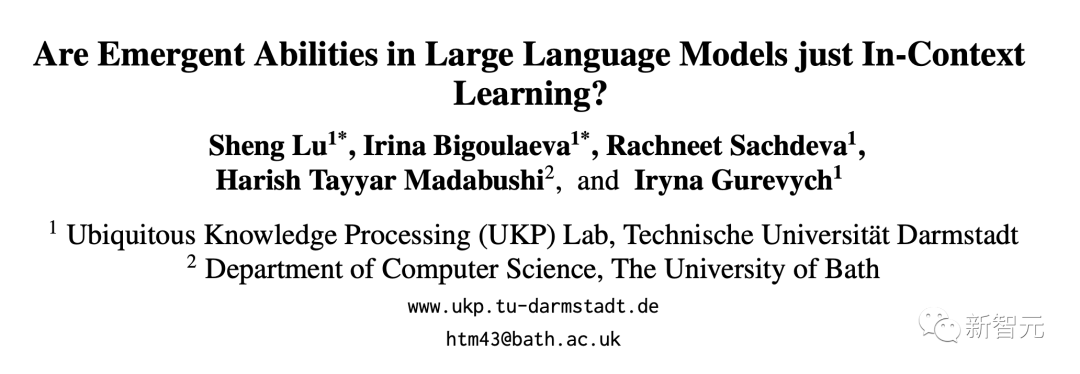

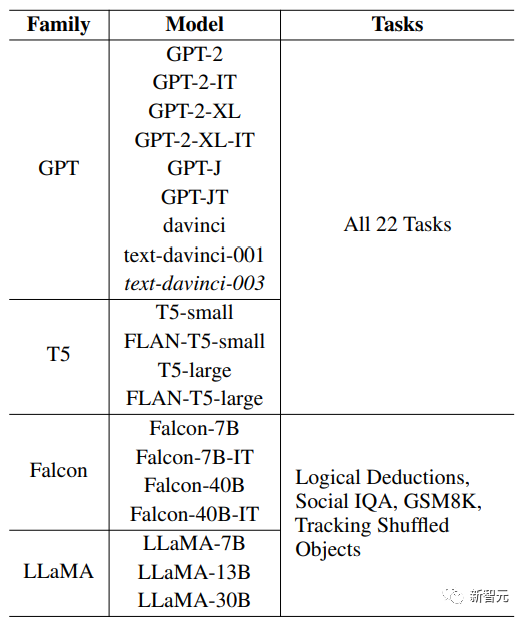

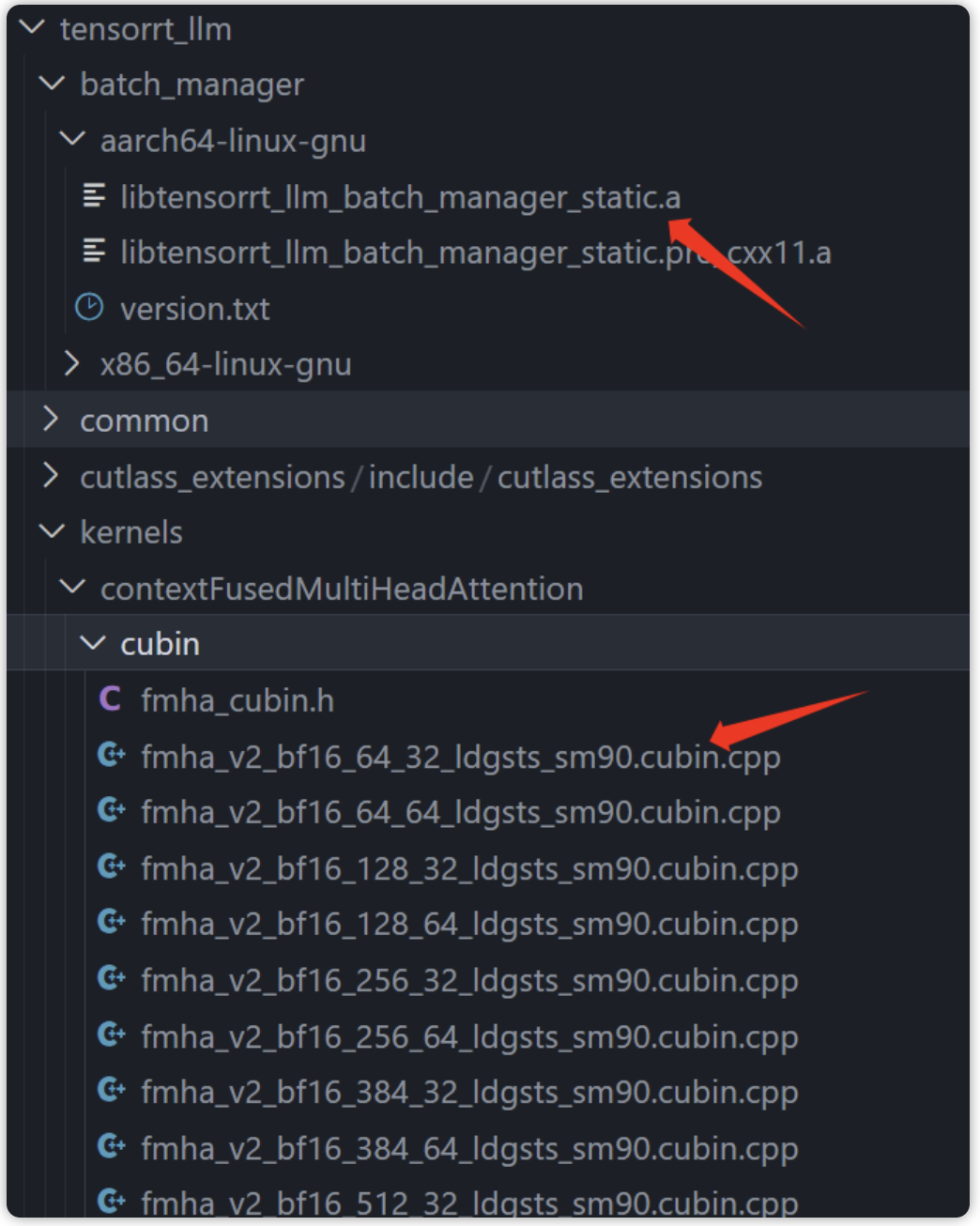

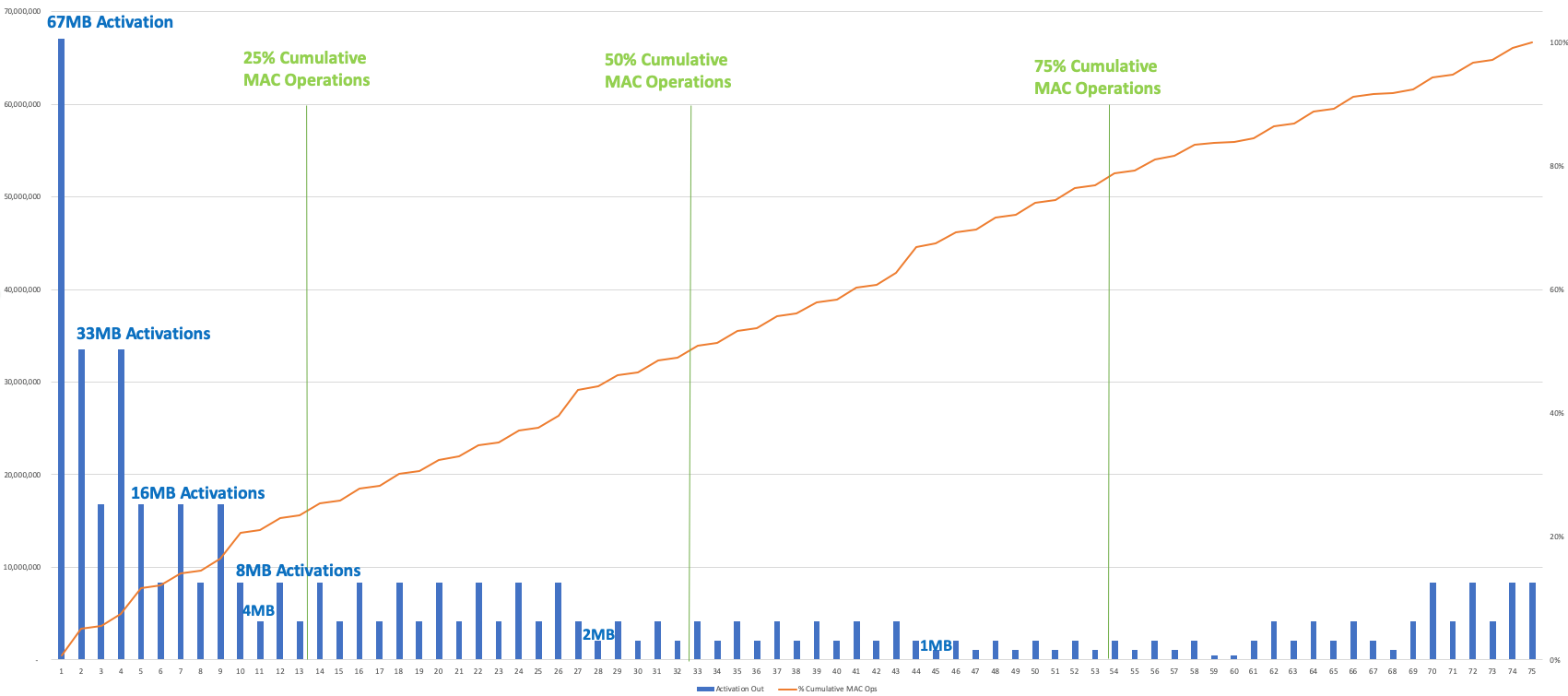

下图是研究人员所选用的模型。

研究人员对来自四个模型系列的一些不同规模的模型进行了评估,包括GPT、T5、Falcon和LLaMA。

之所以选择这些模型,是因为GPT和LLaMA之前就被发现有涌现能力,而Falcon处于LLM排行榜的前列。

研究人员还选择了T5,因为它是一个编码器——解码器模型(encoder-decoder model),其指令微调版本(Flan)是使用大量指令微调数据集训练出来的。

而在GPT系列中,研究人员使用了GPT-2和GPT-3的指令微调和非指令微调版本;在T5系列中,研究人员使用了T5及其指令微调的对应版本FLAN-T5。

同样,研究人员使用了Falcon3的指令微调版本和非指令微调版本。至于LLaMA,由于它没有经过指令微调,研究人员无法获得该模型的指令微调版本。

此外,研究人员还评估了GPT-3 text-davinci-003,这是一个InstructGPT模型。InstructGPT模型最初是根据注释者编写的prompt和相应的预期行为进行微调的,然后再使用该模型收集其它模型输出的排序数据集,利用人类反馈强化学习(RLHF)对其进行进一步微调。

事实证明,这种训练方法可以提高模型的性能。

其中,研究人员选的T5模型特意低于1B的参数量,因为在这么小的模型中还没有观察到涌现能力,这在研究人员的实验中起到了关键的控制作用。

在研究人员选择的模型中,GPT-3 davinci(非指令微调)、GPT-3 textdavinci-001(指令微调)和GPT-3 textdavinci-003(InstructGPT)都是以前观察到过涌现能力的模型。这一选择主要是出于模型可用性的考虑。

其它已证明具有涌现能力的模型系列包括PaLM、Chinchilla、Gopher和LaMDA,但由于没有相应的应用程序接口,所以研究人员没有对其进行评估。

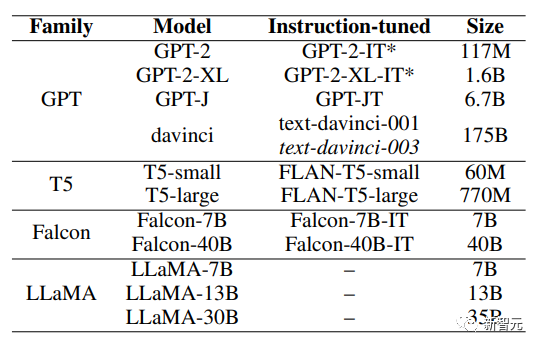

上图为实验中使用的任务清单,以及这些任务在之前是否被识别为涌现的情况,并附有解决任务所需能力的性质分类。

这种分类是通过人工检查数据,并采用Mahowald等人提供的分类框架确定。研究人员评估了每个任务中50个示例的记忆情况,假定任务数据没有泄露。

上表详细列出了整体的实验设置,包括测试的不同模型、实验中使用的不同任务以及采用的评估设置。

鉴于团队的目标是评估不受其他因素影响的LLM的涌现能力,研究人员对从T5和GPT系列中选出的12个模型中的每个模型在所有22个选定任务上进行了评估。

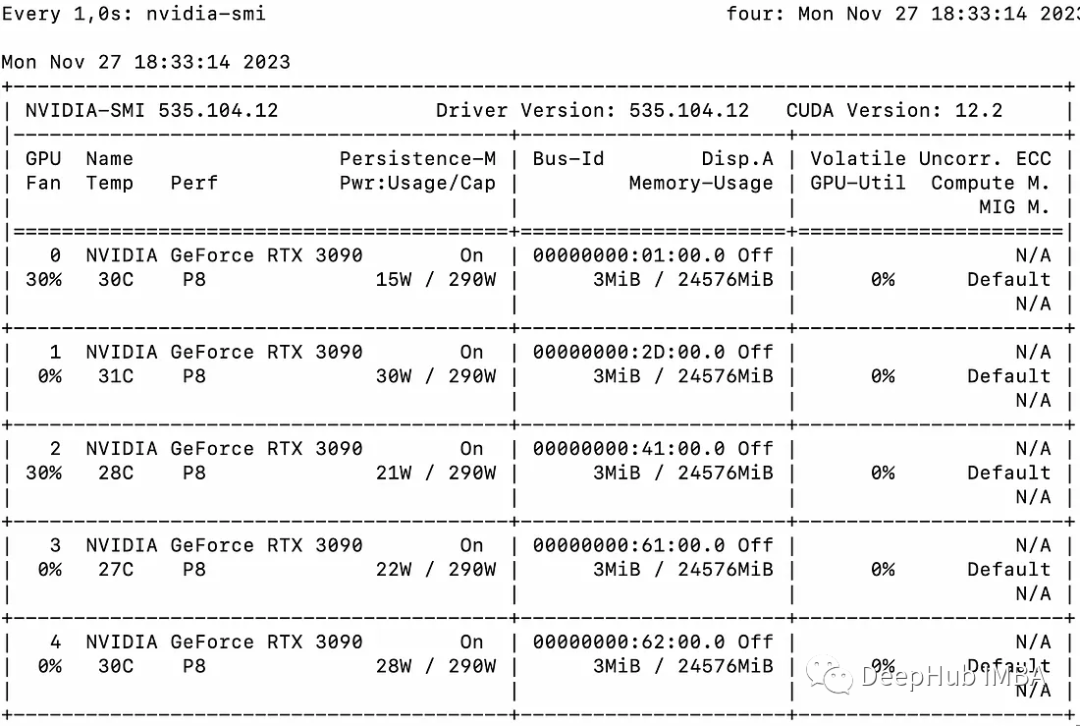

对于每种情况,研究人员都采用了相同的prompt策略:封闭式和封闭式对抗。为考虑反应的可变性,研究人员将每个实验进行三次,计算平均结果。其中运行的所有实验都是在英伟达A100 GPU上进行的,温度为0.01,批量大小为16。

对于GPT-3 175B参数模型(davinci、text-davinci-001 和 text-davinci003),团队使用官方的API进行评估,只进行一次,温度为0。这是因为本文的研究人员也将温度设为了0,保证了结果的可重复性,并将出现幻觉的可能性降至最低。

此外,他们还从LLaMA和Falcon系列中选择了六个模型,在前面选择的22个任务中的4个上进行了评估。

研究人员在选择这4个任务时,要确保其中两个任务先前已被确定为突发任务,另外两个任务已被确定为非突发任务。之后,团队再次使用封闭式和对抗式的prompt策略对它们进行了测试,并对每个实验运行三次以考虑到可能存在的差异。

鉴于某些评估任务的相关选项数量不固定,研究人员通过多次随机选择该任务中的问题选项并求得平均分,来构建每项任务的基线。

实验结果

对于第一个研究问题: 鉴于上下文学习对LLMs中涌现能力存在一定的潜在影响,在没有上下文学习(包括指令微调)的情况下,哪些能力是真正的涌现能力?

研究团队首先展示了在零样本条件下未经指令微调的175B参数的GPT-3模型的表现。

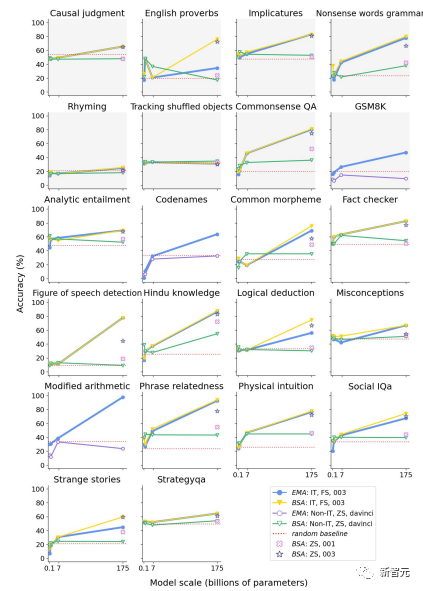

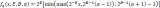

上图是在封闭式prompt策略下,GPT系列模型在各种任务上的表现。

研究团队使用的是BERTScore精确度 (BSA) 和匹配精确度 (EMA),在少样本 (FS)、零样本 (ZS) 设置下对指令调整(IT)模型和非指令调整(non-IT)模型进行了评估。

蓝色表示指令微调模型在少样本条件下的结果,与之前文献报道的结果相当。

黄色表示在相同设置下使用BSA测得的性能,红色表示在非指令微调模型的零样本条件下的BSA结果,换句话说,这种条件就代表着没有上下文学习的影响下的结果。

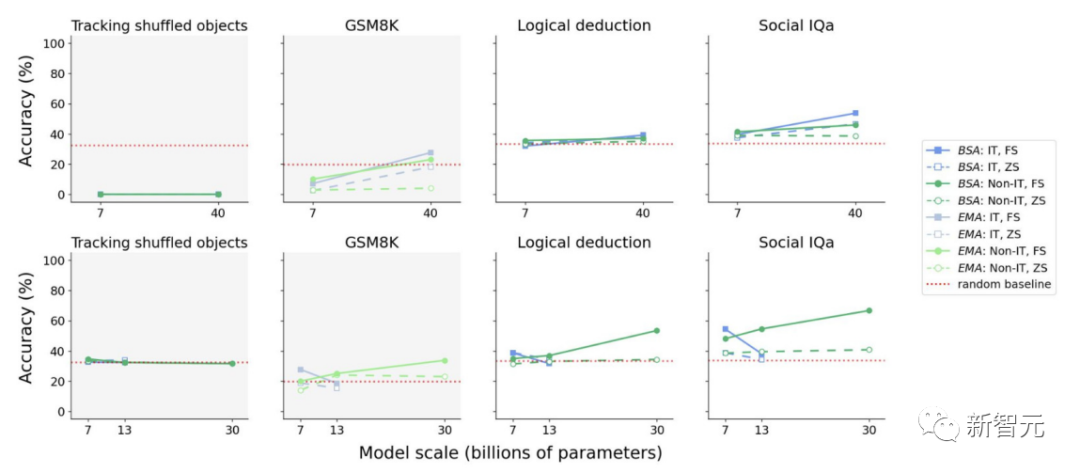

上图为Falcon(上部)和LLaMA(下部)模型在非指令调整零样本条件下对所选任务子集的性能表现示意图,表明在没有上下文学习的情况下,模型始终缺乏所谓的涌现能力。

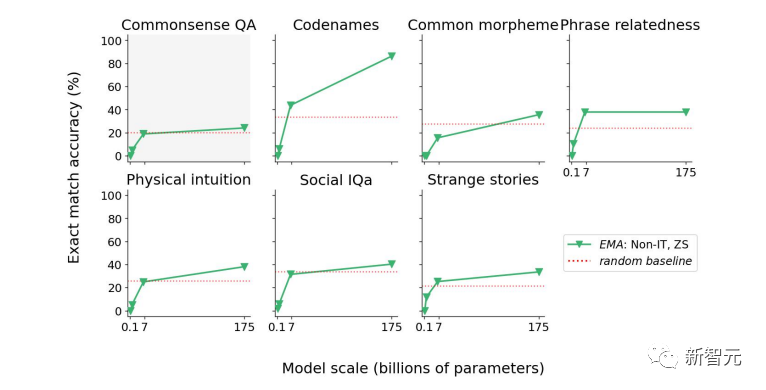

上图为非指令微调的GPT模型在对抗环境下的表现,在这些任务子集上,GPT的表现高于随机基线。在一些任务上的表现是可预测的,因此不算是涌现能力。

在其余任务中,与随机基线相比,成绩的提高幅度相对较小。

而针对第二个问题:经过指令微调的模型是否表现出了推理能力,还是说指令微整更有可能使这些模型更有效、更高效地进行上下文学习?

需要注意的是,指令微调的本质是在指令和范例之间建立映射关系,而这正是上下文学习的特征,因此这一过程很可能确实触发了上下文学习。

研究人员的假设意味着,指令微调为LLMs提供了将指令转化为范例的能力,而范例随后又调动了它们的上下文学习能力。

下图是T5系列模型在不同环境下的性能表现。

审核编辑:黄飞

电子发烧友App

电子发烧友App

评论