微软 Ignite 2023 技术大会发布的新工具和资源包括 OpenAIChatAPI 的 TensorRT-LLM 封装接口、RTX 驱动的性能改进 DirectMLforLlama2、其他热门 LLM

Windows PC 上的 AI 标志着科技史上的关键时刻,它将彻底改变玩家、创作者、主播、上班族、学生乃至普通 PC 用户的体验。

AI 为 1 亿多台采用 RTX GPU 的 Windows PC 和工作站提高生产力带来前所未有的机会。NVIDIA RTX 技术使开发者更轻松地创建 AI 应用,从而改变人们使用计算机的方式。

在微软 Ignite 2023 技术大会上发布的全新优化、模型和资源将更快地帮助开发者提供新的终端用户体验。

TensorRT-LLM 是一款提升 AI 推理性能的开源软件,它即将发布的更新将支持更多大语言模型,在 RTX GPU 8GB 及以上显存的 PC 和笔记本电脑上使要求严苛的 AI 工作负载更容易完成。

Tensor RT-LLM for Windows 即将通过全新封装接口与 OpenAI 广受欢迎的聊天 API 兼容。这将使数以百计的开发者项目和应用能在 RTX PC 的本地运行,而非云端运行,因此用户可以在 PC 上保留私人和专有数据。

定制的生成式 AI 需要时间和精力来维护项目。特别是跨多个环境和平台进行协作和部署时,该过程可能会异常复杂和耗时。

AI Workbench 是一个统一、易用的工具包,允许开发者在 PC 或工作站上快速创建、测试和定制预训练生成式 AI 模型和 LLM。它为开发者提供一个单一平台,用于组织他们的 AI 项目,并根据特定用户需求来调整模型。

这使开发者能够进行无缝协作和部署,快速创建具有成本效益、可扩展的生成式 AI 模型。加入抢先体验名单,成为首批用户以率先了解不断更新的功能,并接收更新信息。

为支持 AI 开发者,NVIDIA 与微软发布 DirectML 增强功能以加速最热门的基础 AI 模型之一的 Llama 2。除了全新性能标准,开发者现在有更多跨供应商部署可选。

便携式 AI

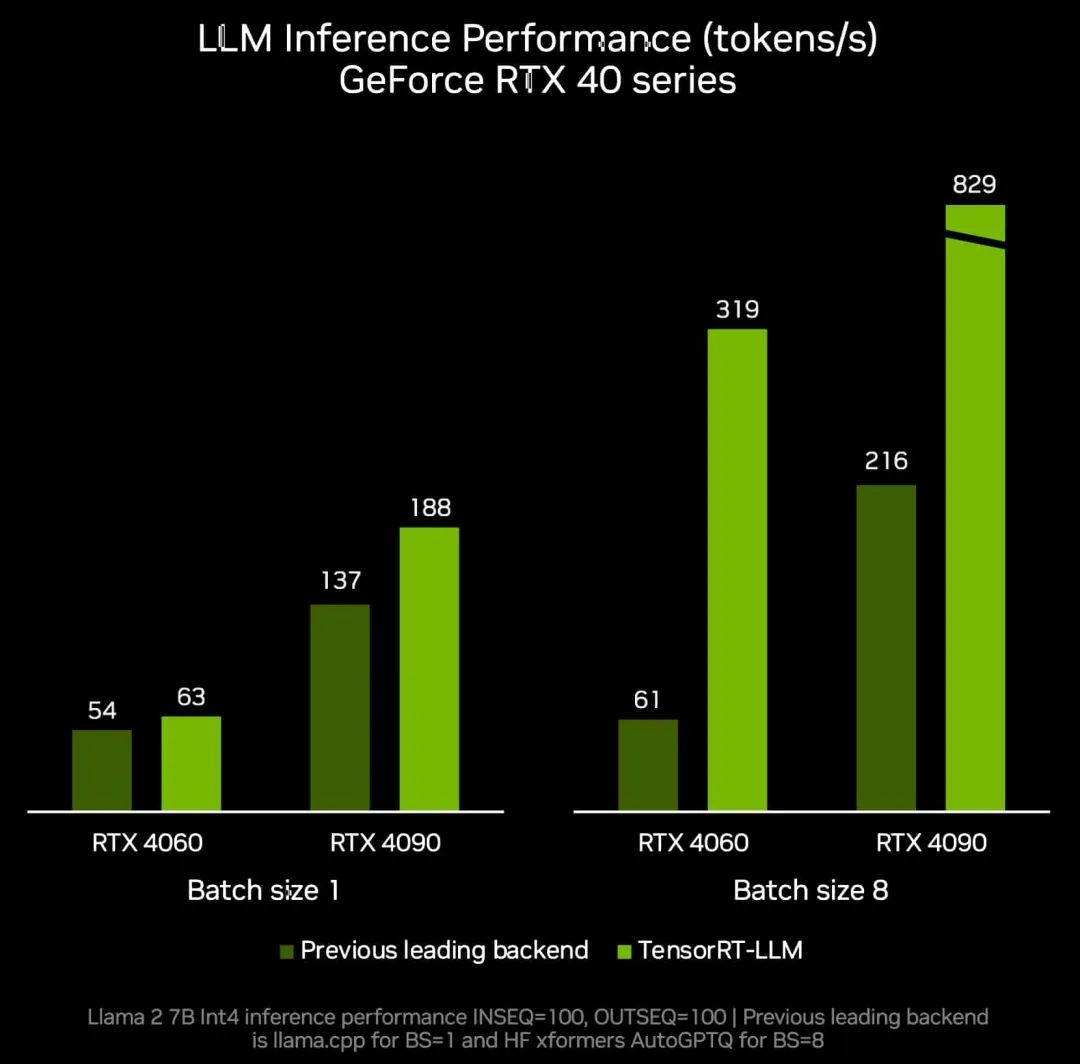

2023 年 10 月,NVIDIA 发布 TensorRT-LLM for Windows —— 一个用于加速大语言模型(LLM)推理的库。

本月底发布的 TensorRT-LLM v0.6.0 更新将带来至高达 5 倍的推理性能提升,并支持更多热门的 LLM,包括全新 Mistral 7B 和 Nemotron-3 8B。这些 LLM 版本将可在所有采用 8GB 及以上显存的 GeForce RTX 30系列和 40系列 GPU 上运行,从而使最便携的 Windows PC 设备也能获得快速、准确的本地运行 LLM 功能。

TensorRT-LLM v0.6.0

带来至高达 5 倍推理性能提升

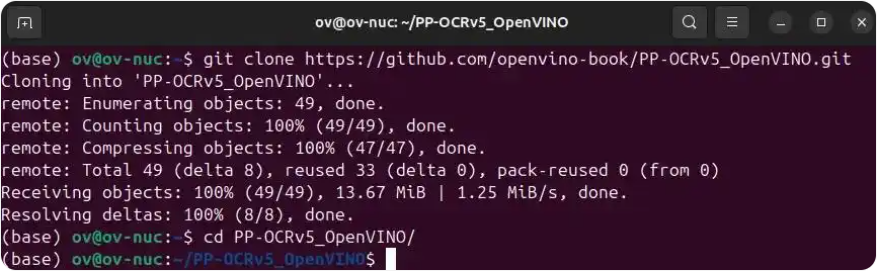

新发布的 TensorRT-LLM 可在/NVIDIA/TensorRT-LLMGitHub 代码库中下载安装,新调优的模型将在ngc.nvidia.com提供。

从容对话

世界各地的开发者和爱好者将 OpenAI 的聊天 API 广泛用于各种应用——从总结网页内容、起草文件和电子邮件,到分析和可视化数据以及创建演示文稿。

这类基于云的 AI 面临的一大挑战是它们需要用户上传输入数据,因此对于私人或专有数据以及处理大型数据集来说并不实用。

为应对这一挑战,NVIDIA 即将启用 TensorRT-LLM for Windows,通过全新封装接口提供与 OpenAI 广受欢迎的 ChatAPI 类似的 API 接口,为开发者带来类似的工作流,无论他们设计的模型和应用要在 RTX PC 的本地运行,还是在云端运行。只需修改一两行代码,数百个 AI 驱动的开发者项目和应用现在就能从快速的本地 AI 中受益。用户可将数据保存在 PC 上,不必担心将数据上传到云端。

使用由 TensorRT-LLM 驱动的

Microsoft VS Code 插件 Continue.dev 编码助手

此外,最重要的一点是这些项目和应用中有很多都是开源的,开发者可以轻松利用和扩展它们的功能,从而加速生成式 AI 在 RTX 驱动的 Windows PC 上的应用。

该封装接口可与所有对 TensorRT-LLM 进行优化的 LLM (如,Llama 2、Mistral 和 NV LLM)配合使用,并作为参考项目在 GitHub 上发布,同时发布的还有用于在 RTX 上使用 LLM 的其他开发者资源。

模型加速

开发者现可利用尖端的 AI 模型,并通过跨供应商 API 进行部署。NVIDIA 和微软一直致力于增强开发者能力,通过 DirectML API 在 RTX 上加速 Llama。

在 10 月宣布的为这些模型提供最快推理性能的基础上,这一跨供应商部署的全新选项使将 AI 引入 PC 变得前所未有的简单。

开发者和爱好者可下载最新的 ONNX 运行时并按微软的安装说明进行操作,同时安装最新 NVIDIA 驱动(将于 11 月 21 日发布)以获得最新优化体验。

这些新优化、模型和资源将加速 AI 功能和应用在全球 1 亿台 RTX PC 上的开发和部署,一并加入 400 多个合作伙伴的行列,他们已经发布了由 RTX GPU 加速的 AI 驱动的应用和游戏。

随着模型易用性的提高,以及开发者将更多生成式 AI 功能带到 RTX 驱动的 Windows PC 上,RTX GPU 将成为用户利用这一强大技术的关键。

GTC 2024 将于 2024 年 3 月 18 至 21 日在美国加州圣何塞会议中心举行,线上大会也将同期开放。点击“阅读原文”或扫描下方海报二维码,立即注册 GTC 大会。

原文标题:点亮未来:TensorRT-LLM 更新加速 AI 推理性能,支持在 RTX 驱动的 Windows PC 上运行新模型

文章出处:【微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

-

英伟达

+关注

关注

23文章

4040浏览量

97669

原文标题:点亮未来:TensorRT-LLM 更新加速 AI 推理性能,支持在 RTX 驱动的 Windows PC 上运行新模型

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

NVIDIA TensorRT LLM 1.0推理框架正式上线

DeepSeek R1 MTP在TensorRT-LLM中的实现与优化

TensorRT-LLM中的分离式服务

NVIDIA RTX AI加速FLUX.1 Kontext现已开放下载

如何在魔搭社区使用TensorRT-LLM加速优化Qwen3系列模型推理部署

使用NVIDIA Triton和TensorRT-LLM部署TTS应用的最佳实践

英伟达GTC25亮点:NVIDIA Dynamo开源库加速并扩展AI推理模型

NVIDIA推出面向RTX AI PC的AI基础模型

在NVIDIA TensorRT-LLM中启用ReDrafter的一些变化

点亮未来:TensorRT-LLM 更新加速 AI 推理性能,支持在 RTX 驱动的 Windows PC 上运行新模型

点亮未来:TensorRT-LLM 更新加速 AI 推理性能,支持在 RTX 驱动的 Windows PC 上运行新模型

评论