来源|Case Studies in Thermal Engineering

原文 |https://doi.org/10.1016/j.csite.2023.102925

01背景介绍

大型数据中心和其他大型计算基础设施由数千个机架组成,支持数万台服务器和其他电子设备。这些电子设备消耗大量的电力,产生大量的热量。2019年,数据中心消耗了约3%的全球电力。由于对数据中心的需求巨大,预计这一数字将以每年12%的速度增长。

在一个典型的直流系统中,冷却系统占总能量的40%。产生的热量可能会导致服务器过热,威胁到服务器的安全运行,如果不及时有效地散热,可能会导致服务器故障。此外,CPU的温度对功率有直接的影响。因此,适宜的CPU温度可以提供显著的节能效果。

风冷是最常用的冷却系统。风冷需要使用强大的风扇,并在电子设备之间提供空间,以放置笨重的散热器,并允许足够的气流。用于计算的电子设备不仅性能越来越好,还具有更大的功率,即最大理论负载下的功耗。因此,迫切需要改进目前的冷却解决方案。

02成果掠影

近年来,液冷作为传统风机强制风冷的补充或替代方法被引入电子设备机架。液冷直流系统最近成为重要的和流行的散热设备,并且液冷系统具有更好的传输特性,具有更优异的经济性。近期,

法国的Mohamad Hnayno教授,Ali Chehade教授和Chadi Maalouf教授介绍了在OVHcloud实验室

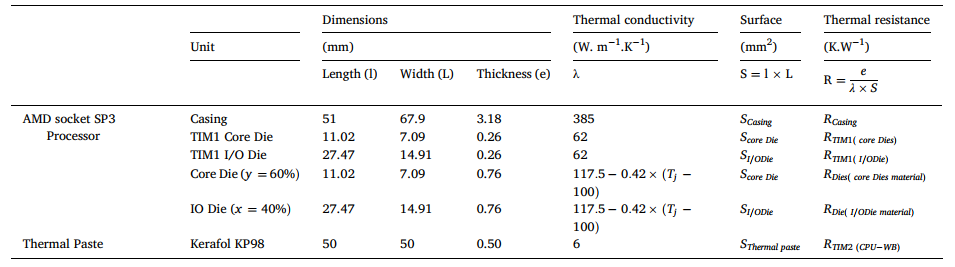

开发的一种新的单相浸入/液冷技术的实验研究,将直接到芯片的水冷系统与被动的单浸入冷却技术相结合。实验装置测试了三种介质流体(S5X, SmartCoolant和ThermaSafe R)的影响,水回路配置的影响,以及服务器的功率/配置。结果表明,该系统冷却需求取决于流体的粘度。当黏度从4.6 mPa s增加到9.8 mPa s时,冷却性能下降了约6%。此外,所有的IT服务器配置都在不同的进水温度和流速下进行了验证。在一个600千瓦的数据中心(DC)比较了本文的技术和OVHcloud之前使用的液冷系统的能源性能。与液冷系统相比,所提出的技术减少了至少20.7%的直流电力消耗。最后,在服务器层面对空气和液冷系统的冷却性能和所提出的解决方案进行了计算比较。使用该解决方案时,与风冷系统相比节能至少20%,与液冷系统相比节能至少7%。

研究成果以“Experimental investigation of a data-centre cooling system using a new single-phase immersion/liquid technique”为题发表于《Case Studies in Thermal Engineering》。

03图文导读

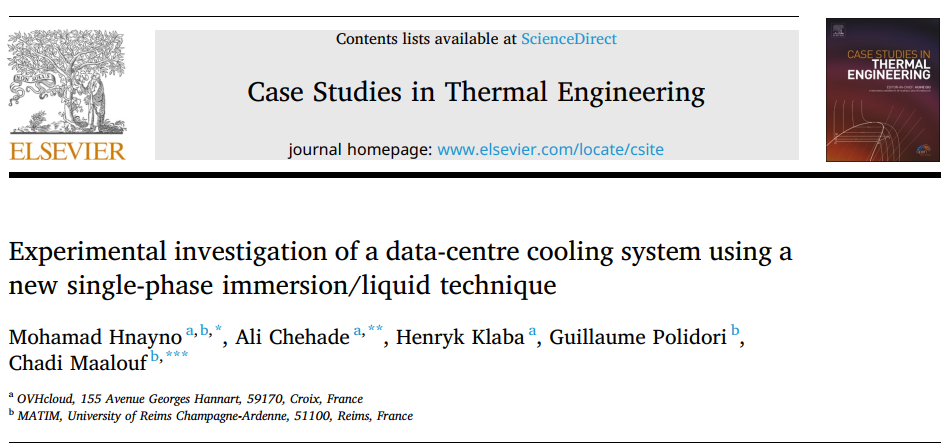

图1.IC系统示意图。

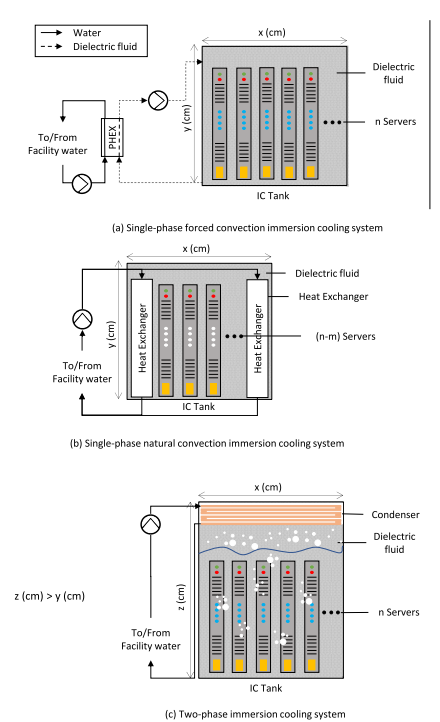

图2.单相浸没/液冷技术架构。

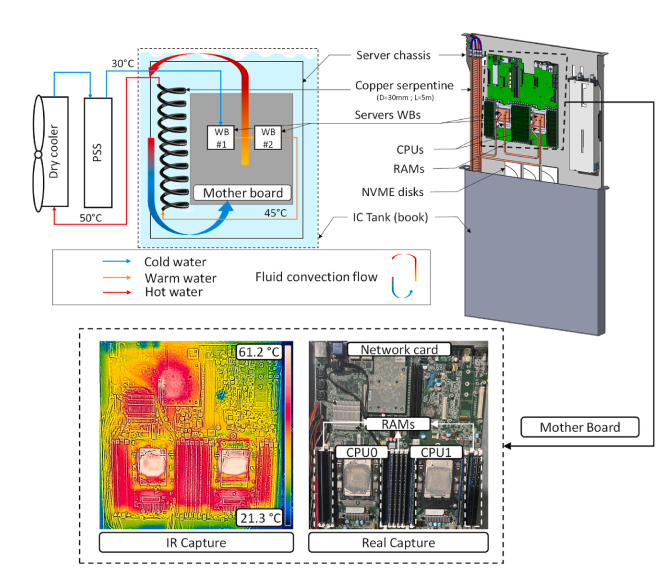

图3.(a) IC IT机架(48台服务器),(b) 600kw IC集装箱。

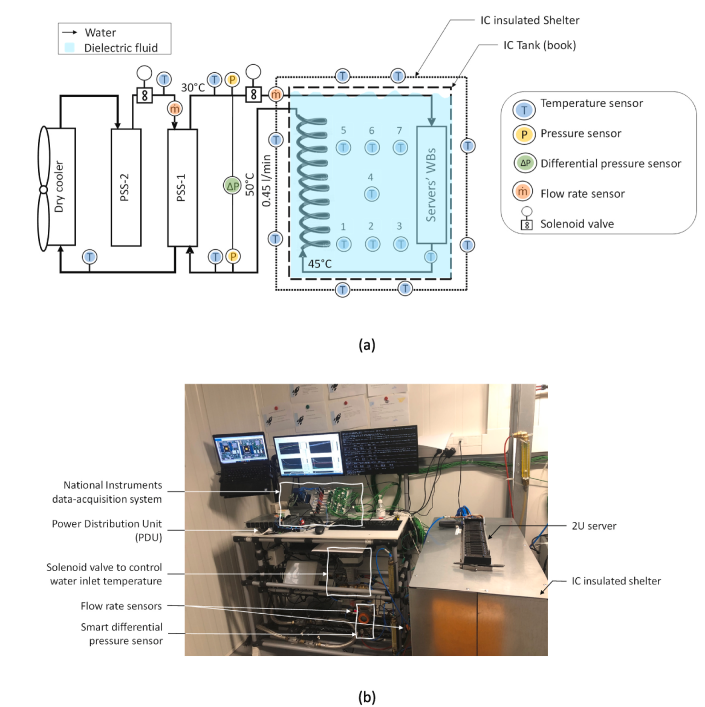

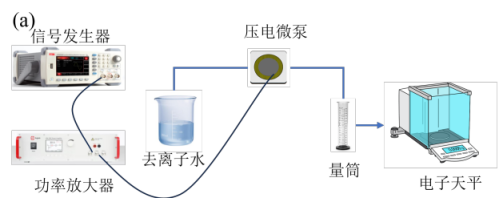

图4.(a) IC实验室实验装置方案,(b) IC实验装置照片。

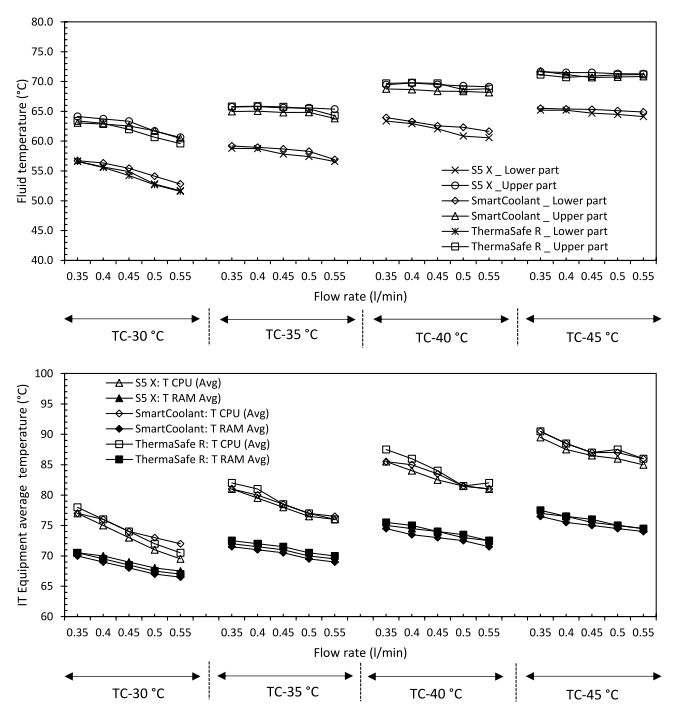

图5.在使用S5 X、SmartCoolant和ThermaSafe R流体时,(a) IC流体温度和(b) IT 温度在不同tc和流速下的变化。

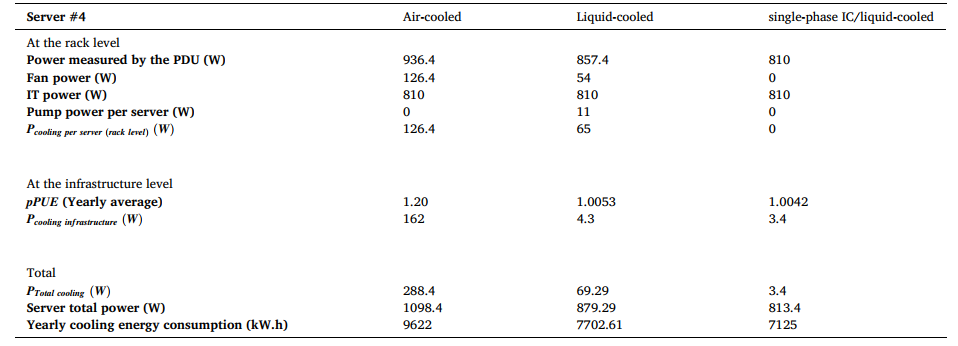

表1.比较在OVHcloud实验DC中使用的风冷、液冷和浸泡/液冷服务器(服务器#4)。

审核编辑:汤梓红

-

服务器

+关注

关注

13文章

10096浏览量

90902 -

数据中心

+关注

关注

16文章

5527浏览量

74661 -

液冷

+关注

关注

5文章

146浏览量

5682

发布评论请先 登录

曙光数创液冷方案助力数据中心绿色发展

聚焦液冷痛点:英特尔UQD互换性认证助力数据中心高效发展

曙光数创亮相2025亚洲数据中心峰会暨展览会

易飞扬浸没液冷延长器与硅光液冷光模块主题研究 ——液冷光互连技术的数据中心革命

曙光数创推出液冷数据中心全生命周期定制新服务

海瑞思科技助力数据中心液冷分水器泄漏检测

英特尔引领液冷革新,与壳牌共筑数据中心高效冷却新范式

RAKsmart液冷技术如何实现PUE<1.2的绿色数据中心

流量与压力传感:数据中心液冷的″智慧之眼″

数据中心液冷技术和风冷技术的比较

一种新型数据中心液冷系统的实验研究

一种新型数据中心液冷系统的实验研究

评论