近年来,随着数字经济的蓬勃发展,数据中心建设规模不断扩大,导致机房单位面积功耗居高不下,对数据中心散热制冷技术提出了更高的要求。同时,根据国家对数据中心的节能要求,全国范围内新建数据中心要求PUE(Power Usage Effectiveness,电源利用效率)<1.2,而传统的风冷制冷方式已经无法满足数据中心的散热需求,更加高效的液冷方案应运而生。特别在人工智能领域,随着智算需求的爆发,液冷方案已经成为数据中心的首选。

1液冷VS风冷

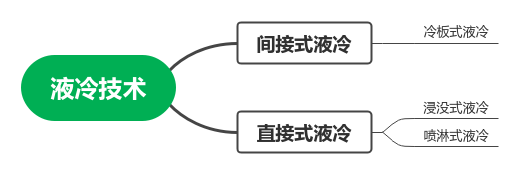

液冷,是利用液体介质冷却发热器件,达到制冷目的。风冷,是利用空气与发热器件换热,达到制冷目的。 数据中心中液冷技术有直接式和间接式液冷两种,其中直接式又分为浸没式和喷淋式两种。

冷板式液冷:好比睡凉席,通过冷板贴在发热器件上为发热器件散热。

浸没式液冷:好比泡冷水澡,发热器件完全“泡”在冷却液中并通过直接接触热交换。

喷淋式液冷:好比冲淋浴,通过喷淋冷却液方式为发热器件散热。

数据中心风冷技术有多年的技术演进过程,发展出了机械式风冷、冷冻水、间接蒸发等技术。

机械式风冷:通常用于机房精密空调,主要通过压缩机机械做功改变制冷剂的状态来制冷。

冷冻水制冷:在机械风冷式制冷基础上,叠加了冷却水循环和冷冻水循环实现制冷,提高了制冷量。

间接蒸发制冷:通过非直接接触式换热器,实现外部自然冷风与数据中心热回风进行热交换,利用了自然冷却提高制冷效率。

由于液冷在制冷效率上的先天优势,配置有液冷系统的数据中心相比传统风冷数据中心,在PUE和WUE(Water Usage Effectiveness,水资源使用效率)关键能源效率指标上,都具有优势。

PUE:PUE是衡量数据中心能源效率的核心指标,表示数据中心总能耗与其IT设备能耗之比。液冷系统中没有风冷系统中的压缩机、风机等高耗电器件,冷却液体可以直接对设备高温器件(GPU、CPU等)进行散热,从而降低PUE。

WUE:WUE是衡量数据中心水资源效率的指标,如0.8 L/kWh表示为每消耗1度电同时消耗0.8升水。液冷系统通过冷却水高效循环制冷,对比间接蒸发冷却系统通过蒸发喷淋消耗大量水资源,液冷对水资源的依赖程度更低。

液冷与风冷指标对比:

| 指标 | 液冷 | 风冷 |

|---|---|---|

| PUE | 通常在1.1~1.2之间,部分高效液冷系统的PUE甚至可以降到1.05以下。 | 通常在1.4~2.0之间。 |

| WUE | 可达到0.8 L/kWh以下。 | 通常大于2 L/kWh,依赖环境干湿空气条件。 |

2为什么选择液冷

液冷作为数据中心高功率密度散热场景的优先选项,主要有两方面原因:一方面是由于液体的高导热和高比热容特性,液冷技术相对于传统空气制冷技术,具有更高的散热效率;另一方面是液冷系统仅需要水泵等少量耗能元件,能够显著降低PUE。

高导热性

导热性指的是材料传递热量的能力,液体通常比空气具有更好的导热性,能够更快地从热源吸收并传导热量。水的导热性大约是0.6 W/m·K,空气的导热性只有0.025 W/m·K。当设备发热时,液冷系统中的液体能够迅速吸收热量并将其带走,而空气制冷则需要更多时间来进行热量交换。

高比热容

比热容是指物质吸收或释放的热量与其温度变化之间的比值,热容越大,物质就能存储更多的热量,而不容易升温。水的比热容大约是4.18 J/g·K,空气的比热容大约是1.00 J/g·K。设备在长时间内持续工作,液冷系统也能更稳定地调节温度。

系统功耗低

在实际工程应用中,液冷系统中没有压缩机、风机等高耗电器件,仅需要水泵、传感器等少量耗电器件,能够显著降低PUE。

各种制冷技术可以实现的PUE范围参见下表。

| 制冷技术 | PUE范围 |

|---|---|

| 风冷直膨技术 | 1.4~2.0 |

| 氟泵技术 | 1.2~1.5 |

| 带自然冷的冷冻水技术 | 1.2~1.5 |

| 间接蒸发冷却技术 | 1.1~1.3 |

| 冷板式液冷技术 | <1.2 |

| 浸没式液冷技术 | <1.1 |

说明 实际PUE值可能会受到多种因素的影响,包括地理位置、气候条件、数据中心设计等。

由上表可见,使用液冷技术进行制冷,是实现PUE<1.2节能要求的必须路径。

3数据中心液冷方案

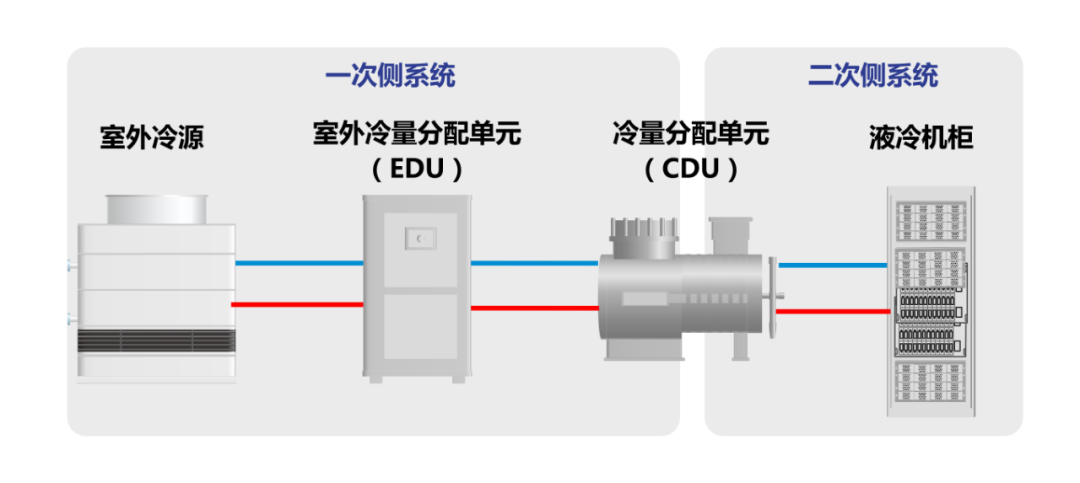

目前液冷技术在数据中心的实际应用中,以冷板式液冷最为广泛。ZTE中兴提供先进的数据中心冷板式液冷解决方案,集成室外冷源、EDU(External Distribution Unit,外部分配单元)、CDU(Cooling Distribution Unit,冷量分配单元)、液冷机柜等关键设备。具备以下优势:

全链条:从服务器到基础设施的端到端解决方案,覆盖设计、交付、运维全过程。

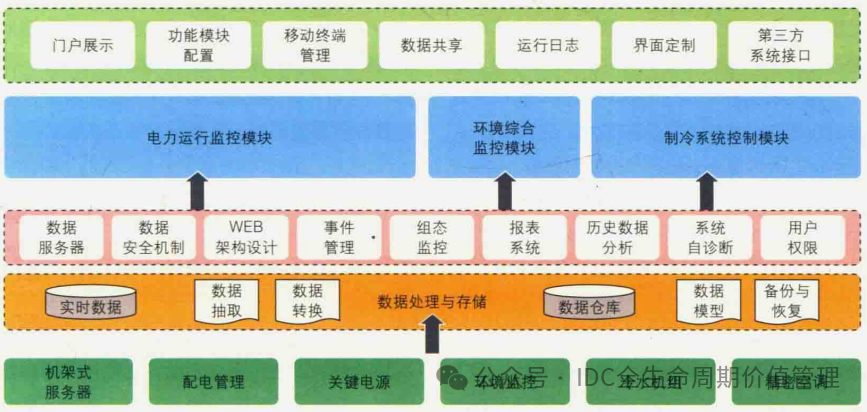

全控制:对液冷和风冷设备统一管理,系统级调优,实现节能最优。

全场景:适配新建、改造数据中心场景,满足不同建筑形式和不同机柜规模需求。

全地域:摆脱地域气候条件限制,安全可靠。

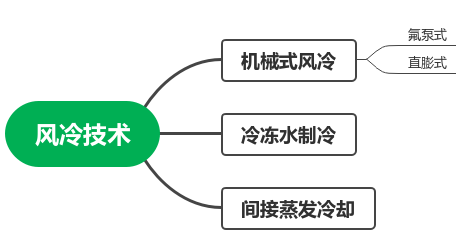

ZTE中兴冷板式液冷系统架构如下图。

室外冷源:通常为闭式塔或干冷器,是液冷系统的外部冷量输入来源。

EDU:EDU是液冷系统一次侧的循环动力源,机组由水泵、过滤器、管路组件、传感器、配电控制箱等主要部件以及稳压装置(选配)、自动补液装置(选配)等辅助功能模块组成。EDU主要功能是为一次侧工质提供循环动力,同时可集成冷却塔的配电与控制,实现对一次侧系统温度、压力、流量的统一监控。

CDU:CDU是液冷系统中的核心设备,机组由液-液换热器、水泵、管路组件、传感器、配电控制箱等主要部件以及过滤器、稳压装置、自动补液装置等辅助功能模块组成。液冷CDU作为冷板式液冷系统二次侧的循环换热中心,其主要功能是为二次侧工质提供再冷却和循环动力,并对整个二次侧系统进行集中控制。

液冷机柜:为液冷系统定制的服务器机柜,适配19英寸或21英寸IT设备(服务器、交换机)。机柜由机柜结构件、manifold(分集水器)、液冷软管、流体连接器、供电单元及管理单元等组成。

一/二次侧管路:包括管路和相应阀门,管路采用环网结构。一二次侧管路连接起室外冷源、CDU、EDU和液冷机柜,将冷却液输送到需要热交换的设备中。

近日,国际数据公司(IDC)发布了最新的《中国半年度液冷服务器市场(2024下半年)跟踪》报告,数据显示中国液冷服务器市场在2024年继续保持快速增长,市场规模达到23.7亿美元,与2023年相比增长67.0%。其中,冷板式解决方案市场占有率进一步提高。IDC预计,2024-2029年,中国液冷服务器市场年复合增长率将达到46.8%,2029年市场规模将达到162亿美元。

在工信部发布的2024年第28号文件中,正式发布了由中兴通讯股份有限公司参与编写的YD/T 6049-2024《冷板式液冷整机柜服务器技术要求和测试方法》,该标准为首个液冷整机柜服务器领域的行业标准。规定了冷板式液冷整机柜服务器的机柜、供液组件、供配电组件、计算节点、交换节点、整机柜内组网、机柜管理模块技术要求和测试方法,适用于数据中心冷板式液冷整机柜服务器的设计、生产及测试。

由此可见业界和市场对高效、低碳节能的液冷技术已形成共识,未来已来,您对当前数据中心液冷方案有什么看法?您认为液冷方案在未来会如何发展?欢迎在评论区分享您的观点。

-

数据中心

+关注

关注

16文章

5515浏览量

74628 -

人工智能

+关注

关注

1813文章

49734浏览量

261395 -

液冷

+关注

关注

5文章

146浏览量

5678

原文标题:从风冷到液冷:数据中心如何走向节能高效的未来

文章出处:【微信号:ztedoc,微信公众号:中兴文档】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

曙光数创液冷方案助力数据中心绿色发展

华为液冷热管理控制器TMU荣获“数据中心冷却创新奖”

数据中心液冷服务器该配什么样的 UPS 不间断电源?

睿海光电以高效交付与广泛兼容助力AI数据中心800G光模块升级

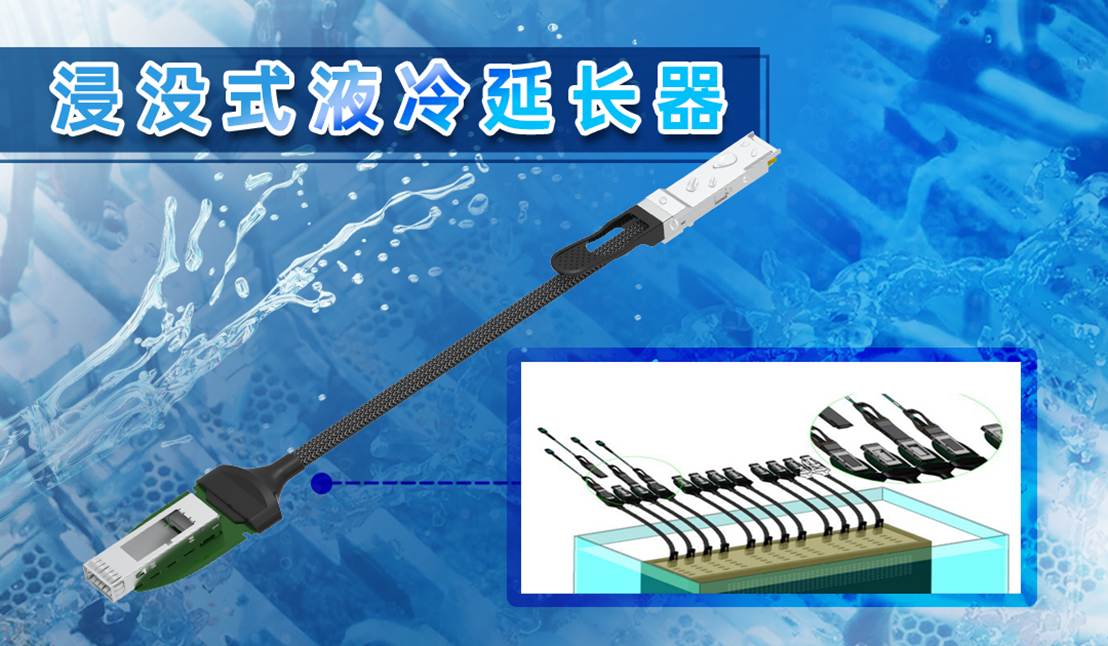

易飞扬浸没液冷延长器与硅光液冷光模块主题研究 ——液冷光互连技术的数据中心革命

Gems全维度传感器方案在液冷数据中心的应用

曙光数创推出液冷数据中心全生命周期定制新服务

海瑞思科技助力数据中心液冷分水器泄漏检测

英特尔引领液冷革新,与壳牌共筑数据中心高效冷却新范式

RAKsmart液冷技术如何实现PUE<1.2的绿色数据中心

流量与压力传感:数据中心液冷的″智慧之眼″

数据中心液冷技术和风冷技术的比较

数据中心液冷技术和风冷技术的比较

评论