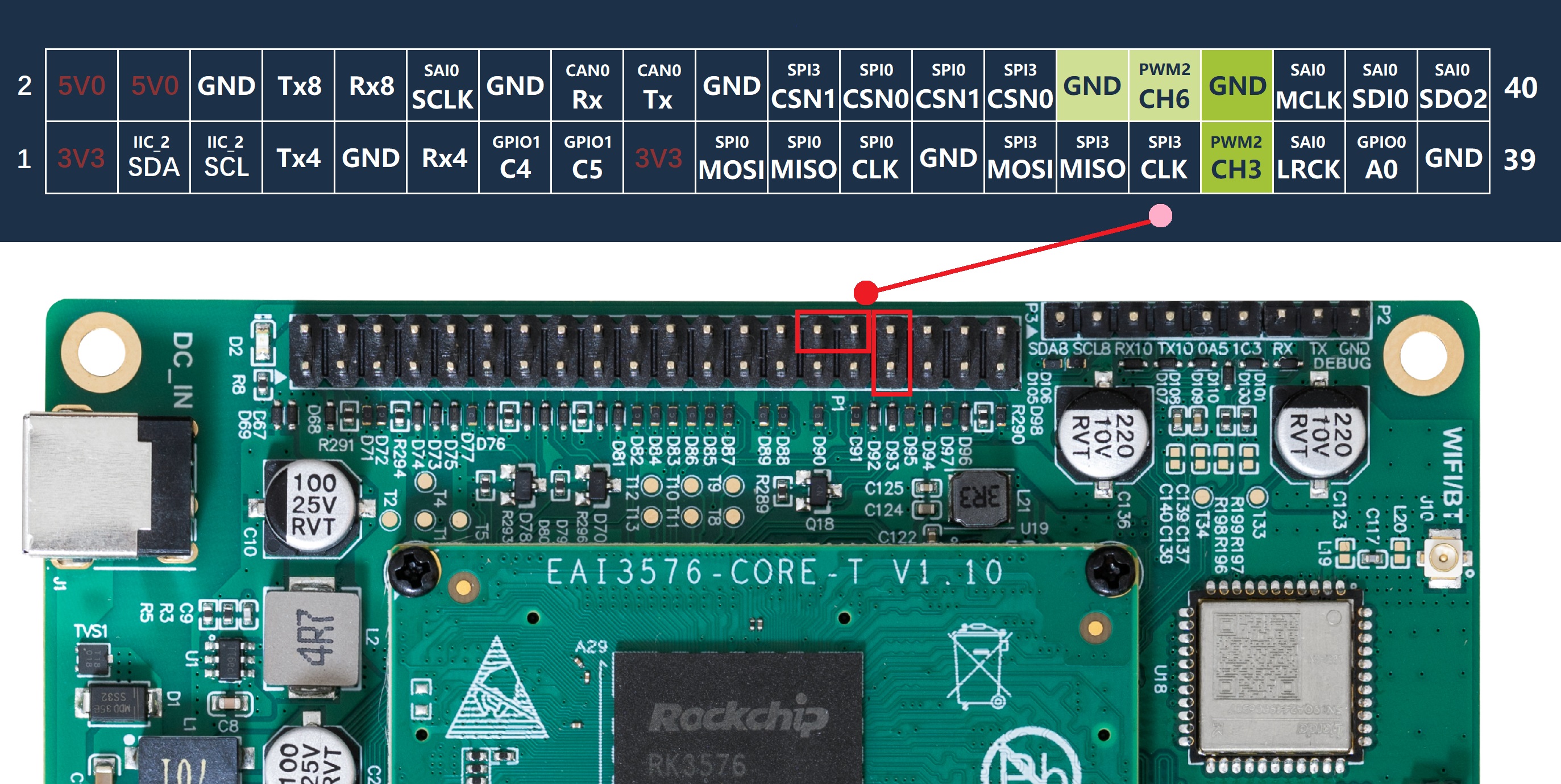

核心结论:部署流程分为5大核心步骤,依次为基础环境安装、模型下载、模型格式转换、部署程序编译、开发板运行测试,1.5b模型适配4+32G开发板,7b模型需8+64G版,内存不足则需配置swap分区。 本次实验是基于合众恒跃HZ-RK3576-MINIEVM ,基于瑞芯微 RK3576/RK3576J 处理器的工业评估板,采用四核 A72 + 四核 A53 架构,主频 2.2GHz。2 路 Ethernet、2 路 USB3.0、2 路 USB2.0 等通信接口。同时引出 1 路 MIPI LCD、1 路 HDMI OUT、2 路 MIPI CAMERA、1 路 MICIN、1 路 H/P OUT 等音视频多媒体接口,支持多屏异显。1 路 debug 接口、1 路 OTG 接口用来调试和烧录。1 路 2x20P 排针兼容树莓派、1 路 2x17P 排针用于扩展 IO。 各位如需跟着一起部署操练,附上开发板购买链接,直接扫二维码即可:

1. 安装基础环境

1.1 新建并激活 conda 环境

1.打开Ubuntu终端,执行命令:conda create -n RKLLM-Toolkit python=3.8

2.激活环境:conda activate RKLLM-Toolkit

1.2 配置 RKLLM 转换环境

1.在家目录新建文件夹:mkdir -p software/rkllm

2.解压rknn-llm-release-v1.1.4压缩包至该目录

3.进入工具包路径:cd rkllm-toolkit/packages

4.安装工具:pip3 install rkllm_toolkit-1.1.4-cp38-cp38-linux_x86_64.whl

2. 下载 deepseek 模型

2.1 安装下载工具

在激活的conda环境中执行:pip3 install huggingface-cli -i https://mirrors.huaweicloud.com/repository/pypi/simple

2.2 下载模型

1.新建模型存储目录:mkdir -p rkllm/rknn-llm-release-v1.1.4/rkllm-toolkit/examples/huggingface/

2.配置下载加速:export HF_ENDPOINT=https://hf-mirror.com

3.进入目标目录:cd rkllm/rknn-llm-release-v1.1.4/rkllm-toolkit/examples/huggingface/

4.新建并进入模型子目录:mkdir deepseek-r1-1.5b && cd deepseek-r1-1.5b

5.执行下载命令:huggingface-cli download deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B --local-dir . --local-dir-use-symlinks False(官网直接下载可更快)

3. 转换模型为 RKLLM 格式

3.1 准备转换脚本

将data_quant.json、export_deepseek_1.5b_rkllm.py、export_deepseek_7b_rkllm.py三个文件,拷贝至rkllm-toolkit/examples目录

3.2 转换 1.5b 版本

1.确保激活conda环境:conda activate RKLLM-Toolkit

2.执行转换:python3 export_deepseek_1.5b_rkllm.py

3.成功标识:出现INFO: Model has been saved to ./deepseek-1.5b-w8a8-rk3576.rkllm!

3.3 转换 7b 及以上版本

1.执行转换脚本:python3 export_deepseek_7b_rkllm.py

2.设备要求:PC需保证虚拟机内存充足

3.内存不足解决方案:创建10G交换分区

◦dd if=/dev/zero of=/userdata/swapfile bs=1M count=10240

◦chmod 0600 /userdata/swapfile

◦mkswap /userdata/swapfile

◦swapon /userdata/swapfile

4. 编译部署程序

4.1 编译与文件传输

1.解压部署例程压缩包(xsc_deepseek.zip),可以放到板子直接编译,路径已修改好

2.拷贝模型文件:将转换后的.rkllm文件,拷贝至解压后的rkllm_model目录

3.编译程序:进入解压目录,执行./build-linux.sh

4.通过adb工具传输文件到开发板

◦传输依赖库:

adb push lib/libgomp/libgomp.so /usr/lib/libgomp.so.1

adb push lib/librkllm_api/librkllmrt.so /usr/lib

◦传输可执行文件和模型:adb push install/xscdeepseek_rkllm_demo/ /data

5. 开发板运行测试

5.1 前期准备

1.烧录系统镜像到rk3576开发板

2.配置swap分区(仅8+64G版本运行7b模型时需执行)

◦创建10G swap文件:dd if=/dev/zero of=/userdata/swapfile bs=1M count=10240(执行较慢)

◦设置权限:chmod 0600 /userdata/swapfile

◦创建文件系统:mkswap /userdata/swapfile

◦开启分区:swapon /userdata/swapfile

◦查看状态:free -mh

5.2 运行测试(通用步骤)

1.登录开发板:通过ssh连接(建议网线连接,减少冗余打印)

2.运行1.5b模型:

◦cd /xsc_deepseek_rkllm_demo

◦./xsc_deepseek_demo rkllm_model/deepseek-1.5b-w8a8-rk3576.rkllm 5000 5000

1.运行7b模型:

◦cd /xsc_deepseek_rkllm_demo

◦./xsc_deepseek_demo rkllm_model/deepseek-7b-w8a8-rk3576.rkllm 5000 5000

5.3 版本限制说明

•4+32G开发板:仅支持1.5b模型

•8+64G开发板:支持1.5b和7b模型,运行7b需配置swap分区

5.4实测截图(2GB内存如何运行大模型?)

审核编辑 黄宇

-

开发板

+关注

关注

25文章

6144浏览量

113816 -

DeepSeek

+关注

关注

2文章

825浏览量

2840

发布评论请先 登录

工业级全能选手!合众恒跃 RK3576 开发板深度解析:多核架构 + 全接口覆盖,适配多行业场景

基于米尔瑞芯微RK3576开发板的Qwen2-VL-3B模型NPU多模态部署评测

【幸狐Omni3576边缘计算套件试用体验】CPU部署DeekSeek-R1模型(1B和7B)

如何基于Android 14在i.MX95 EVK上运行Deepseek-R1-1.5B和性能

【幸狐Omni3576边缘计算套件试用体验】DeepSeek 部署及测试

ATK-DLRK3588开发板deepseek-r1-1.5b/7b部署指南

BQ3588/BQ3576系列开发板成功部署 DeepSeek-R1开发板

基于合众恒跃rk3576 开发板deepseek-r1-1.5b/7b 部署指南

基于合众恒跃rk3576 开发板deepseek-r1-1.5b/7b 部署指南

评论