[首发于智驾最前沿微信公众号]最近有位小伙伴在后台留言提问:端到端算法是怎样训练的?是模仿学习、强化学习和离线强化学习这三类吗?其实端到端(end-to-end)算法在自动驾驶、智能体决策系统里,确实会用到模仿学习(包括行为克隆、逆最优控制/逆强化学习等)、强化学习(RL),以及近年来越来越受关注的离线强化学习(OfflineRL/BatchRL)这三类。

什么是“端到端”训练?

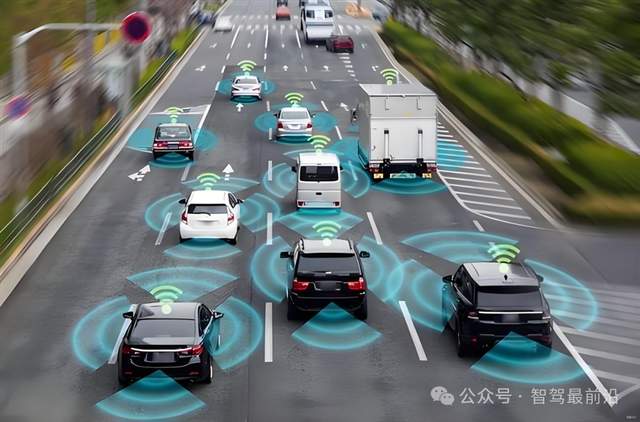

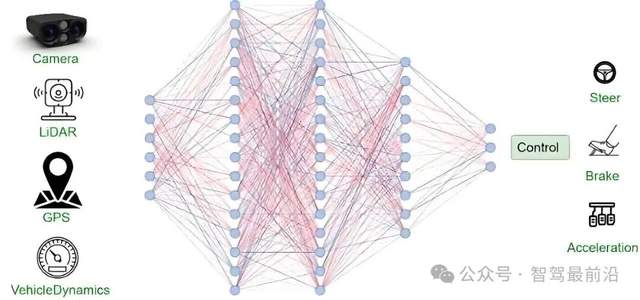

端到端(end-to-end)在自动驾驶中的应用越来越多,所谓端到端,就是指系统直接把最原始的感知输入(比如摄像头图像、传感器数据等)映射到最终控制输出(比如车辆的转向、加减速、刹车等动作)。不像传统的自动驾驶把“感知→识别→规划→控制”拆成好几个模块,每个模块各自工作,端到端是把这些步骤合并到一个整体神经网络/模型。

端到端示意图,图片源自:网络

这样做的好处是流程简单、模型整体可优化、理论上可以在足够多数据+合适训练方法下能学到复杂映射逻辑。但对数据量、训练方法、泛化能力要求较高。既然只要有足够的数据就可以训练出足够聪明的端到端,那该用什么方式教它?这些方式又有什么优缺点呢?

模仿学习(ImitationLearning)

模仿学习,也称示范学习(learningfromdemonstration),是端到端训练里最直观、应用最广的一类方法。它的核心思想是,假设你已经有专家(人类驾驶员/经验控制系统/优秀策略)做的一系列“状态-动作”的示范,模型就可以根据这些示范去学习。

在模仿学习里,比较经典的做法是行为克隆(BehaviorCloning,BC)。也就是把专家数据当成训练集,把状态作为输入,把专家对应的动作作为“标签/groundtruth”,用回归或分类方式训练网络。

为了让模型不只是简单复制动作,还能理解“为什么”这么做,也会用到“逆最优控制/逆强化学习”(

InverseOptimalControl/InverseReinforcementLearning,IRL)这类方式,这样可以从专家行为中反推“奖励函数”(即专家为什么做出这些动作、背后的目标是什么),然后再基于这个奖励函数训练policy。

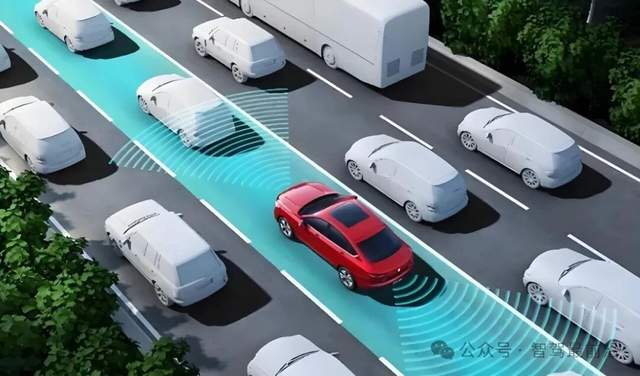

图片源自:网络

优点和挑战

模仿学习/行为克隆最大的优点就是简单直接、数据利用高效。它可以将复杂的策略学习问题转化为标准的监督学习任务,从而充分利用大量高质量的专家示范数据,快速学会一个在数据分布内表现合理的策略。在专家行为覆盖充分、环境动态相对稳定的场景下,这种方法能取得非常不错的效果。

模仿学习/行为克隆带来的问题也不少。模仿学习泛化能力与鲁棒性较差,如果模型遇到专家示范里如罕见、危险或者极端情景(紧急刹车、非常规转向、路况突变等等)等从未出现过的情况,模型因为训练时没见过类似场景,也没有示范动作,可能无法判断该怎么做。

行为克隆会忽略决策过程的“序列性/时序相关性”,它把每一帧状态与动作当独立样本对待,而现实中动作之间高度相关、且一个动作会影响未来状态。这样做容易导致所谓的分布偏移问题,当系统因为一点错误偏离了专家轨迹,就可能越偏越远。

强化学习(ReinforcementLearning)

端到端训练中另一种广泛使用的方法是强化学习(RL)。不同于模仿学习依赖专家示范/标签数据,RL是通过智能体(agent)与环境交互做动作、观察结果、得到“奖励”或“惩罚”,从而形成一个学习策略(policy),最终可以使长期累积的奖励最大化。

当将强化学习与深度神经网络相结合,就发展出了深度强化学习(DeepRL/DRL)。DRL能够直接将高维的原始感知输入(如图像、激光雷达点云)映射到动作或控制信号,从而实现从感知到决策的端到端学习。这种强大的表征和学习能力,使其在处理自动驾驶、机器人控制等具有复杂输入和连续决策需求的任务时,展现出巨大的潜力。

图片源自:网络

优点和挑战

用强化学习训练端到端模型,有一个明显好处,那就是它理论上不依赖“专家示范”,而是通过“试错+奖励机制”,探索出一个新的,甚至是“专家都没见过”的策略;在面对复杂、多变、动态环境时,有可能获得比单纯模仿更灵活、更强鲁棒性的策略。

但想让强化学习真的落地并不容易。对于RL来说,给出一个能真实反映安全、效率、舒适、法规等综合目标的奖励函数非常难。如果奖励函数设计不合理,RL容易学出一些奇怪但奖励高的策略。

RL的训练过程还依赖大量与环境的交互和试错,导致数据采集、仿真与训练的计算成本和时耗都非常高。若直接在真实车辆上部署训练,则会因为智能体在探索初期产生的策略极不稳定,导致危险行为甚至事故的发生。即便在模拟器中训练,也存在“模拟↔真实”的差异(sim-to-realgap)。

端到端RL的可解释性也比较差,因为神经网络内部没有清晰的人类可理解模块(如“检测行人→判断优先级→规划轨迹→控制”),而是一整个黑箱映射。这样在出现错误或异常行为时,很难追溯到具体的原因。

离线强化学习(OfflineRL/BatchRL)

近年来,有技术方案中提出离线强化学习(OfflineRL,也叫BatchRL)的方法,以解决将RL用于现实系统(自动驾驶、医疗、机器人)时面临的安全/资源/实际交互等难题。离线RL的基本设定是不让模型在训练时与真实环境互动。而是先收集一批类似于专家示范数据或日志的历史交互数据,然后用这些静态数据训练一个策略。训练过程中不再需要交互。

离线RL可被视为一种结合了数据驱动与策略优化的混合方案。它既像模仿学习那样利用静态的历史交互数据进行训练,避免了在线试错的安全风险与成本;同时又保留了传统强化学习的核心机制,通过对数据中的状态与动作价值进行估计与优化,使策略能够在已有数据的基础上进一步提升性能。这种形式使得它能在保证安全的前提下,尝试学习出比行为克隆更优、更鲁棒的策略。

图片源自:网络

优点和挑战

离线RL的最大优势是安全性和可用已有数据,并可以减少对真实世界探索的依赖,对于自动驾驶、医疗、金融、机器人等高风险领域尤为适用。它将RL的潜力与现实约束结合起来,是一个很有前景的发展方向。

但因为其训练时不能再探索新状态/动作,只能依赖数据集中已有的状态/动作组合,这就带来“分布偏移”(distributionshift)的问题。也就是说,当训练出来的策略在现实中使用时,可能遇到数据集中没有覆盖到的状态/动作,从而表现不可靠。为了解决这个问题,有技术方案中提出引入各种约束/正则/不确定性惩罚/动作空间限制/模型-基方法等机制,从而约束模型行为。

其他学习方法

1)自监督学习(Self-SupervisedLearning)

对于自动驾驶这种依赖大量视觉/传感器数据的系统,数据量极大,但手工标注不仅费时成本也高。于是有技术方案中引入自监督学习思路,让系统先从大量未标注的原始数据中学习有意义的特征/表示,再用于downstream的端到端控制/决策任务,这样可以减少对人工标注的依赖。

2)“教师-学生”(Teacher-Student)/特权信息蒸馏

这种方法被称为教师—学生框架。其采用分阶段训练的思路,先利用仿真或数据中才可获得的信息(如精确地图、物体真实状态等),训练一个强大的“教师”模型,使其掌握决策与规划能力;接着训练一个“学生”模型,它仅能使用实际车辆可获取的传感器输入信息(如摄像头图像、雷达点云),通过模仿教师模型的决策输出,间接学习到教师的推理能力。

这样可以把现实中可获取的信息+强模型决策能力结合起来,降低了直接从原始感知信号进行端到端策略学习的难度,是提升系统性能与可靠性的重要途径。

图片源自:网络

3)混合/混合阶段训练(Hybrid/StagedTraining)

训练端到端模型可以不单靠一种训练方式,也可以组合多种方式,如先用模仿学习或自监督学习做“预训练/初始化”(

pre-training/behaviorcloning/feature-learning),然后再用强化学习或离线RL在此基础上fine-tune/优化策略。在这样的“混合训练pipeline”中,可以兼顾“模仿专家行为”的初步安全/合理性,以及“探索和优化策略”的灵活性/鲁棒性。

4)进化/进化式学习方法(如Neuroevolution)

除了基于梯度下降的反向传播与强化学习,还有一种值得关注的技术路径是进化算法在神经网络优化中的应用,即神经进化。该方法不依赖梯度计算,而是通过模拟自然进化中的种群生成、变异、交叉与适者生存机制,迭代地优化网络结构、参数或行为策略。这种梯度无关的优化方式,能够处理不可导或奖励稀疏的复杂环境,具备一定的鲁棒性与探索优势。虽然在当前自动驾驶端到端系统中并非主流方案,但它为应对传统方法难以解决的优化问题提供了一种补充思路。

最后的话

对于端到端而言,训练算法的选择固然重要,但想让车辆学会安全、可靠的驾驶能力,更取决于数据质量、训练策略、场景覆盖与运行监控等要素。这些因素有时会比模型结构本身更重要。

审核编辑 黄宇

-

自动驾驶

+关注

关注

791文章

14671浏览量

176541

发布评论请先 登录

端到端智驾模拟软件推荐:为什么aiSim是业界领先的自动驾驶模拟平台?

端到端智驾模拟软件推荐——为什么选择Keymotek的aiSim?

一文读懂特斯拉自动驾驶FSD从辅助到端到端的演进

端到端自动驾驶相较传统自动驾驶到底有何提升?

Nullmax端到端自动驾驶最新研究成果入选ICCV 2025

如何训练好自动驾驶端到端模型?

如何训练好自动驾驶端到端模型?

评论