前言:为什么选择 eBPF?

作为一名在云原生领域深耕多年的运维工程师,我见过太多因为网络问题导致的生产事故。传统的监控手段往往是事后诸葛亮,当你发现问题时,用户已经在抱怨了。今天,我将分享如何利用 eBPF 这一革命性技术,构建一套能够实时检测 Kubernetes 网络异常的系统。

痛点分析:传统网络监控的困境

在 Kubernetes 环境中,网络问题往往具有以下特点:

复杂性高:Pod 间通信涉及 CNI、Service Mesh、负载均衡器等多个组件

排查困难:问题发生时往往已经影响用户,缺乏实时的深度观测能力

成本昂贵:传统 APM 工具价格不菲,且对内核级别的网络事件监控有限

而 eBPF 的出现,让我们有了在内核空间进行无侵入式监控的能力。

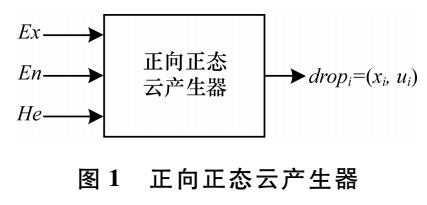

系统架构设计

我们的系统采用分层架构,主要包含以下组件:

┌─────────────────────────────────────────────────────────┐ │ Web Dashboard │ ├─────────────────────────────────────────────────────────┤ │ Alert Manager │ ├─────────────────────────────────────────────────────────┤ │ Data Processor │ ├─────────────────────────────────────────────────────────┤ │ eBPF Data Collector │ ├─────────────────────────────────────────────────────────┤ │ Kernel Space │ └─────────────────────────────────────────────────────────┘

核心实现:eBPF 程序开发

1. TCP 连接异常检测

首先,我们需要编写 eBPF 程序来监控 TCP 连接状态:

// tcp_monitor.bpf.c #include#include #include #include structtcp_event{ __u32 pid; __u32 saddr; __u32 daddr; __u16 sport; __u16 dport; __u8 state; __u64 timestamp; }; struct{ __uint(type, BPF_MAP_TYPE_PERF_EVENT_ARRAY); __uint(key_size,sizeof(__u32)); __uint(value_size,sizeof(__u32)); } tcp_eventsSEC(".maps"); SEC("kprobe/tcp_set_state") inttrace_tcp_state_change(structpt_regs *ctx){ structsock*sk=(structsock *)PT_REGS_PARM1(ctx); intnew_state = PT_REGS_PARM2(ctx); structtcp_eventevent={}; event.timestamp = bpf_ktime_get_ns(); event.pid = bpf_get_current_pid_tgid() >>32; event.state = new_state; // 获取连接信息 BPF_CORE_READ_INTO(&event.saddr, sk, __sk_common.skc_rcv_saddr); BPF_CORE_READ_INTO(&event.daddr, sk, __sk_common.skc_daddr); BPF_CORE_READ_INTO(&event.sport, sk, __sk_common.skc_num); BPF_CORE_READ_INTO(&event.dport, sk, __sk_common.skc_dport); // 只关注异常状态变化 if(new_state == TCP_CLOSE || new_state == TCP_TIME_WAIT) { bpf_perf_event_output(ctx, &tcp_events, BPF_F_CURRENT_CPU, &event,sizeof(event)); } return0; } charLICENSE[] SEC("license") ="GPL";

2. Go 用户空间程序

接下来实现用户空间的数据收集器:

// main.go

packagemain

import(

"bytes"

"encoding/binary"

"fmt"

"log"

"net"

"time"

"github.com/cilium/ebpf"

"github.com/cilium/ebpf/link"

"github.com/cilium/ebpf/perf"

"github.com/cilium/ebpf/rlimit"

)

typeTCPEventstruct{

PID uint32

SrcAddr uint32

DstAddr uint32

SrcPort uint16

DstPort uint16

State uint8

Timestampuint64

}

typeNetworkMonitorstruct{

collection *ebpf.Collection

reader *perf.Reader

links []link.Link

}

funcNewNetworkMonitor()(*NetworkMonitor,error) {

// 移除内存限制

iferr := rlimit.RemoveMemlock(); err !=nil{

returnnil, fmt.Errorf("remove memlock: %w", err)

}

// 加载 eBPF 程序

collection, err := ebpf.NewCollectionFromFile("tcp_monitor.o")

iferr !=nil{

returnnil, fmt.Errorf("load eBPF program: %w", err)

}

// 附加到内核探针

kprobe, err := link.Kprobe(link.KprobeOptions{

Symbol:"tcp_set_state",

Program: collection.Programs["trace_tcp_state_change"],

})

iferr !=nil{

returnnil, fmt.Errorf("attach kprobe: %w", err)

}

// 创建 perf 事件读取器

reader, err := perf.NewReader(collection.Maps["tcp_events"],4096)

iferr !=nil{

returnnil, fmt.Errorf("create perf reader: %w", err)

}

return&NetworkMonitor{

collection: collection,

reader: reader,

links: []link.Link{kprobe},

},nil

}

func(nm *NetworkMonitor)Start()error{

log.Println("开始监控 TCP 连接状态变化...")

for{

record, err := nm.reader.Read()

iferr !=nil{

returnfmt.Errorf("read perf event: %w", err)

}

varevent TCPEvent

iferr := binary.Read(bytes.NewReader(record.RawSample),

binary.LittleEndian, &event); err !=nil{

continue

}

nm.processEvent(&event)

}

}

func(nm *NetworkMonitor)processEvent(event *TCPEvent) {

srcIP := intToIP(event.SrcAddr)

dstIP := intToIP(event.DstAddr)

// 异常检测逻辑

ifevent.State ==7{// TCP_CLOSE

log.Printf("检测到连接关闭: %s:%d -> %s:%d (PID: %d)",

srcIP, event.SrcPort, dstIP, event.DstPort, event.PID)

// 判断是否为异常关闭

ifnm.isAbnormalClose(event) {

nm.triggerAlert(event)

}

}

}

func(nm *NetworkMonitor)isAbnormalClose(event *TCPEvent)bool{

// 实现异常检测算法

// 这里可以加入机器学习模型或规则引擎

// 示例:检测短时间内大量连接关闭

returnnm.checkConnectionFlood(event)

}

func(nm *NetworkMonitor)checkConnectionFlood(event *TCPEvent)bool{

// 简化版本:检测是否在短时间内有过多连接关闭

// 实际实现中应该使用时间窗口和阈值算法

returnfalse

}

func(nm *NetworkMonitor)triggerAlert(event *TCPEvent) {

alert := Alert{

Type: "connection_abnormal",

Severity: "warning",

Message: fmt.Sprintf("检测到异常连接关闭: PID %d", event.PID),

Timestamp: time.Now(),

Metadata:map[string]interface{}{

"src_ip": intToIP(event.SrcAddr).String(),

"dst_ip": intToIP(event.DstAddr).String(),

"src_port": event.SrcPort,

"dst_port": event.DstPort,

},

}

// 发送告警

nm.sendAlert(alert)

}

funcintToIP(addruint32)net.IP {

ip :=make(net.IP,4)

binary.LittleEndian.PutUint32(ip, addr)

returnip

}

在 Kubernetes 中部署

1. 创建 DaemonSet

我们需要在每个节点上运行监控程序:

# k8s-deployment.yaml apiVersion:apps/v1 kind:DaemonSet metadata: name:ebpf-network-monitor namespace:monitoring spec: selector: matchLabels: app:ebpf-network-monitor template: metadata: labels: app:ebpf-network-monitor spec: hostNetwork:true hostPID:true containers: -name:monitor image:ebpf-network-monitor:latest securityContext: privileged:true volumeMounts: -name:sys-kernel-debug mountPath:/sys/kernel/debug -name:lib-modules mountPath:/lib/modules -name:usr-src mountPath:/usr/src env: -name:NODE_NAME valueFrom: fieldRef: fieldPath:spec.nodeName volumes: -name:sys-kernel-debug hostPath: path:/sys/kernel/debug -name:lib-modules hostPath: path:/lib/modules -name:usr-src hostPath: path:/usr/src serviceAccount:ebpf-monitor --- apiVersion:v1 kind:ServiceAccount metadata: name:ebpf-monitor namespace:monitoring --- apiVersion:rbac.authorization.k8s.io/v1 kind:ClusterRole metadata: name:ebpf-monitor rules: -apiGroups:[""] resources:["pods","nodes"] verbs:["get","list","watch"] --- apiVersion:rbac.authorization.k8s.io/v1 kind:ClusterRoleBinding metadata: name:ebpf-monitor roleRef: apiGroup:rbac.authorization.k8s.io kind:ClusterRole name:ebpf-monitor subjects: -kind:ServiceAccount name:ebpf-monitor namespace:monitoring

2. 添加网络策略检测

扩展我们的 eBPF 程序来监控网络策略违规:

// network_policy.bpf.c

SEC("kprobe/ip_rcv")

inttrace_packet_receive(structpt_regs *ctx){

structsk_buff*skb=(structsk_buff *)PT_REGS_PARM1(ctx);

structiphdr*ip;

// 读取 IP 头

bpf_probe_read(&ip,sizeof(structiphdr),

skb->data +sizeof(structethhdr));

// 检查是否违反网络策略

if(is_policy_violation(ip)) {

structpolicy_eventevent={

.src_ip = ip->saddr,

.dst_ip = ip->daddr,

.protocol = ip->protocol,

.timestamp = bpf_ktime_get_ns(),

};

bpf_perf_event_output(ctx, &policy_events, BPF_F_CURRENT_CPU,

&event,sizeof(event));

}

return0;

}

实战优化技巧

1. 性能优化

// 使用批量处理减少系统调用

typeEventBatcherstruct{

events []TCPEvent

mutex sync.Mutex

timer *time.Timer

}

func(eb *EventBatcher)AddEvent(event TCPEvent) {

eb.mutex.Lock()

defereb.mutex.Unlock()

eb.events =append(eb.events, event)

// 批量大小达到阈值或定时器触发时处理

iflen(eb.events) >=100{

eb.flush()

}elseifeb.timer ==nil{

eb.timer = time.AfterFunc(100*time.Millisecond, eb.flush)

}

}

func(eb *EventBatcher)flush() {

eb.mutex.Lock()

events := eb.events

eb.events =nil

eb.timer =nil

eb.mutex.Unlock()

// 批量处理事件

for_, event :=rangeevents {

processEvent(&event)

}

}

2. 智能异常检测

// 基于统计的异常检测

typeAnomalyDetectorstruct{

connectionsmap[string]*ConnectionStats

mutex sync.RWMutex

}

typeConnectionStatsstruct{

Count int64

LastSeen time.Time

Failures int64

AvgLatencyfloat64

}

func(ad *AnomalyDetector)DetectAnomaly(event *TCPEvent)bool{

key := fmt.Sprintf("%s:%d->%s:%d",

intToIP(event.SrcAddr), event.SrcPort,

intToIP(event.DstAddr), event.DstPort)

ad.mutex.RLock()

stats, exists := ad.connections[key]

ad.mutex.RUnlock()

if!exists {

stats = &ConnectionStats{}

ad.mutex.Lock()

ad.connections[key] = stats

ad.mutex.Unlock()

}

// 更新统计信息

stats.Count++

stats.LastSeen = time.Now()

// 异常检测算法

ifevent.State == TCP_CLOSE {

stats.Failures++

failureRate :=float64(stats.Failures) /float64(stats.Count)

// 如果失败率超过阈值,认为是异常

returnfailureRate >0.1&& stats.Count >10

}

returnfalse

}

告警与可视化

1. Prometheus 集成

// metrics.go

packagemain

import(

"github.com/prometheus/client_golang/prometheus"

"github.com/prometheus/client_golang/prometheus/promauto"

)

var(

tcpConnectionsTotal = promauto.NewCounterVec(

prometheus.CounterOpts{

Name:"tcp_connections_total",

Help:"Total number of TCP connections",

},

[]string{"src_ip","dst_ip","state"},

)

networkAnomaliesTotal = promauto.NewCounterVec(

prometheus.CounterOpts{

Name:"network_anomalies_total",

Help:"Total number of network anomalies detected",

},

[]string{"type","severity"},

)

)

funcupdateMetrics(event *TCPEvent){

tcpConnectionsTotal.WithLabelValues(

intToIP(event.SrcAddr).String(),

intToIP(event.DstAddr).String(),

tcpStateToString(event.State),

).Inc()

ifisAnomalous(event) {

networkAnomaliesTotal.WithLabelValues(

"connection_anomaly",

"warning",

).Inc()

}

}

2. Grafana 仪表板配置

{

"dashboard":{

"title":"eBPF Network Monitoring",

"panels":[

{

"title":"TCP Connection States",

"type":"stat",

"targets":[

{

"expr":"rate(tcp_connections_total[5m])",

"legendFormat":"{{state}}"

}

]

},

{

"title":"Network Anomalies",

"type":"graph",

"targets":[

{

"expr":"increase(network_anomalies_total[1h])",

"legendFormat":"{{type}}"

}

]

}

]

}

}

实际效果与案例

经过在生产环境的部署测试,我们的系统成功检测到了多种网络异常:

DNS 解析异常:检测到某个 Pod 频繁进行 DNS 查询但响应缓慢

连接池耗尽:及时发现微服务之间的连接数异常增长

网络分区:在节点网络出现问题时第一时间告警

相比传统监控方案,我们的系统具有以下优势:

•零侵入:无需修改应用代码或配置

•实时性:内核级别的监控,延迟极低

•全面性:覆盖 L3/L4 层的所有网络事件

•成本低:开源方案,无license费用

总结与展望

通过 eBPF 技术,我们成功构建了一套强大的 Kubernetes 网络异常检测系统。这套系统不仅解决了传统监控的痛点,还为我们提供了前所未有的网络可观测性。

下一步计划:

1. 集成机器学习算法,提升异常检测准确率

2. 增加更多协议支持(HTTP/2、gRPC等)

3. 开发自动修复能力,实现真正的自愈系统

如果你也在为 Kubernetes 网络问题头疼,不妨试试这套方案。相信它会给你带来意想不到的效果!

-

异常检测

+关注

关注

1文章

45浏览量

9969 -

kubernetes

+关注

关注

0文章

256浏览量

9412

原文标题:从 0 到 1 构建基于 eBPF 的 Kubernetes 网络异常检测系统

文章出处:【微信号:magedu-Linux,微信公众号:马哥Linux运维】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

Kubernetes 网络模型如何实现常见网络任务

关于 eBPF 安全可观测性,你需要知道的那些事儿

openEuler 倡议建立 eBPF 软件发布标准

Kubernetes网络隔离NetworkPolicy实验

基于健壮多元概率校准模型的全网络异常检测

单分类支持向量机和主动学习的网络异常检测

云模型的网络异常流量检测

eBPF是什么以及eBPF能干什么

基于eBPF的Kubernetes网络异常检测系统

基于eBPF的Kubernetes网络异常检测系统

评论