数据中心与能源消耗

预计到2025年,全球发电量将达到26,787TWh,其中数据中心和加密货币将消耗约536TWh,约占全球总发电量的2%。按照目前的趋势,数据中心的电力消耗到2030年很可能达到甚至超过1,000TWh,接近全球总电力消耗的5%。

如今,全球电力供应仍主要依赖煤炭、天然气、石油等非可再生能源,但随着数字化转型步伐越来越快,电力需求将会越来越高,因此必须提升可再生能源发电量来为这些技术提供支持,同时还要提高这些应用场景的能源利用效率。

在超大规模数据中心〔包括运行人工智能(AI)和高性能计算(HPC)工作负载的数据中心〕中,电子设备冷却是一个耗电量非常大的领域。各类AI和HPC部署对冷却的要求高低不一、差异巨大,但通常都需要长时间持续工作,而且它们的功率密度可能高达常规数据中心服务器应用的10倍以上。能源的价格正持续上涨,但电力供应却难以跟上,因此提高数据中心冷却效率已成为近年来值得关注的焦点问题。

一些新建的数据中心采用了与可再生能源发电设施同步建设的方式,旨在利用这些可再生能源为数据中心供电。从能源使用的角度来看,这种做法非常经济高效,但冷却技术带来的工作能耗需求仍然很高,足以大幅推高此类项目的初始资本成本。

业界专家设计了许多创新方法,将数据中心转型为更节能的平台,例如在沿海地区部署全浸没在水下的数据中心舱。然而,美国传统的数据中心通常建在气候干旱的偏远地区。廉价土地的充足供应、较少的监管限制以及优惠的税收政策,使这些地区成为了理想的数据中心选址地点,但代价就更高的冷却需求以及有限或昂贵的水资源供应。

本文将探讨当今数据中心设施的冷却方法,以及未来有望改变电子设备冷却行业的新技术。

01数据中心冷却技术的发展趋势

超高密度数据中心的机架功率密度已从不到10kW上升到某些情况下超过100kW。在如此高的功率密度面前,大家普遍认为风冷技术无法满足要求,而且效率过低,难以和液冷技术竞争。在这些方法中,单相直接芯片(DTC)液冷技术在亟需更高效冷却方法的市场中具备优势。

DTC技术在冷却主要处理硬件方面已经颇为成熟并且高效。然而,这种方法往往无法顾及网络、内存和存储等硬件芯片,致使它们只能采用风冷。而单相或两相浸没式冷却就是解决这一问题的潜在方案。在浸没式冷却中,整个数据中心机架都浸没在具有良好热传导性能的绝缘液体中,从而有效地将电子元器件产生的热量传递至液体中,随后通过热交换器(单相)或蒸汽与冷凝管理系統(双相)实现高效冷却。后门热交换器也正在逐渐普及,尤其是在改造风冷为主的传统数据中心的场景中。

风冷的前期成本非常低,而DTC和浸没式冷却则属于成本高、复杂的冷却方式之一。对于资金充裕、盈利预期良好的新建数据中心而言,液冷方案显然是理想选择。然而,在高昂的前期成本面前,一些老旧数据中心甚至某些新建项目仍在依赖采用传统空调技术、效率低下的风冷系统。部分地区的监管要求可能会限制此类低效冷却技术的应用,但运营成本上升带来的经济压力更可能促使数据中心放弃传统风冷方案。目前,通过优化风扇布局、机架位置以及气流设计等手段,已经可以显著提升系统效率、降低成本。

浸没式冷却技术有望成为一种非常高效、可持续的冷却技术,尤其是考虑到该技术能够应对非常高的热密度。根据估计,与传统风冷相比,浸没式冷却技术可将数据中心的冷却能耗降低达90%。随着AI和HPC领域的新技术推动机架功率密度不断提高,这项冷却技术有望进一步得到普及。不过,由于浸没式冷却还是一项比较新的技术,其基础设施的供应暂时还无法跟上数据中心大规模部署的步伐。然而,随着越来越多浸没式冷却企业涌现,并从数据中心的大规模投资中获利,这一状况在未来几年内有望改变。

液冷方法(尤其是浸没式冷却)的另一项潜在优势,在于它能够将废热收集起来,为游泳池、学校、商业区、室内园艺设施、废弃物处理、化学加工/精炼等应用领域供热;废热甚至还可以供应给热能储存系统,这些系统可根据用电需求将废热转化为电能。

02数据中心冷却技术的未来

新技术的发展,对AI和HPC的响应速度提出了更高的要求,因而需要将它们部署在更接近终端用户的位置,这与上文讨论的限制因素叠加在一起,构成了更大的挑战。越来越多的应用场景都开始采用AI、虚拟现实(VR)、增强现实(AR)和自动化功能,它们都需要毫秒级的响应时间,所以必须部署在靠近用户的地方。而大多数此类终端应用场景都位于人口稠密的城市地区,要想在这里建设更多数据中心,势必要面临房租贵、空间小、污染和用水限制严格、供电容量不足等问题。在空间受限的前提下,要实现数据中心的性能目标,就必须在密度上做文章了。

因此,数据中心机架的功率密度将会不断提高,比如一个晶圆级AI处理器的功耗就可能高达数十千瓦;然而冷却技术却滞后于数据中心的增长和扩张。随着越来越多AI和HPC技术得到部署,以及云基础设施为了满足日益增长的需求而不断扩展,这种趋势只会进一步恶化。

对数据中心运营商来说,摆在他们面前的一项艰巨任务,就是彻底改造传统风冷系统,并将液冷技术融入到新的数据中心设计中。毕竟,对正在运行的数据中心进行任何环境改动,都伴随着巨大的风险和复杂的运维工作。因此,在资金充足的情况下,运营商为了适应新变化,都更倾向于从头开始建设新的数据中心,而不是改造现有的数据中心。随着电子设备冷却行业不断并购,数据中心运营商与冷却企业之间的合作日益增多,这将促进先进冷却技术的普及。

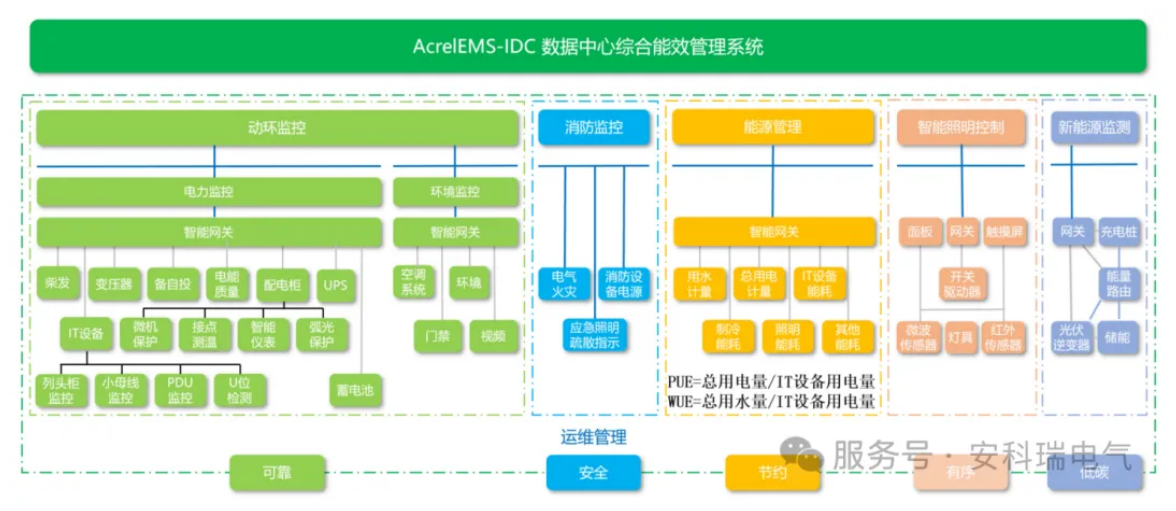

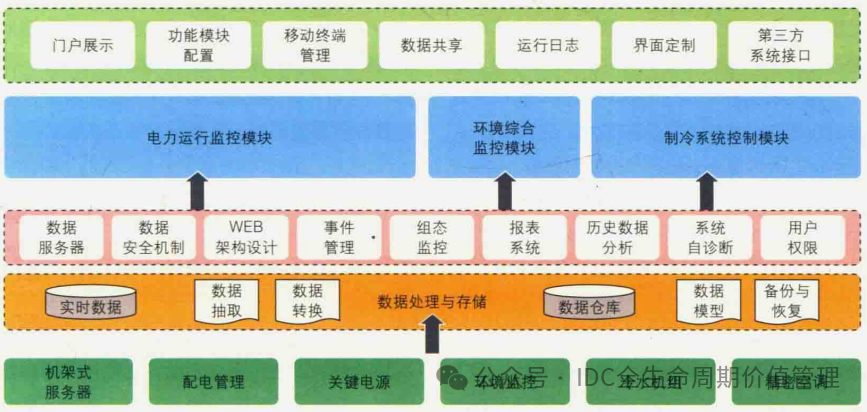

要追赶这一趋势,需要使用更严谨的传感、分析和优化方案。传统的算法冷却控制系统可能会被更先进的冷却优化技术(包括AI)所取代,以协调数据中心内可能存在的数以万计的传感器和冷却装置。而实现优化的方式之一,是借助先进的监控和分析技术,让数据中心能够运行在高于传统目标值的温度下,同时又能够确保没有任何硬件的温度达到导致性能下降的程度。

结语

目前,风冷仍占据数据中心冷却的主导地位,但在不久之后,改造和新建的数据中心就会开始采用风冷/液冷混合技术,而未来的数据中心或超高密度数据中心将会采用先进的液冷技术。为了实现这样的目标,DTC必须进一步提高可靠性,因为即使是几秒钟的DTC故障,也可能导致服务器长时间停机或损坏。浸没式冷却技术可以满足这一可靠性需求,而且能够实现更高的功率密度,但其代价是复杂性增加,以及需要更专业的安装和维护。

未来,机架功率密度将会超过100kW乃至300kW,工程师在考虑散热问题时不能只局限于机架。如何将冷却过程中产生的多余热能加以收集利用,将变得愈发关键,尤其是在许多政府和机构正寻求立法,要求数据中心实现显著的可持续性水平的背景下。

-

冷却

+关注

关注

0文章

47浏览量

18311 -

数据中心

+关注

关注

16文章

5538浏览量

74686

原文标题:AI与HPC:数据中心冷却技术的发展和未来展望

文章出处:【微信号:贸泽电子,微信公众号:贸泽电子】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

技术资讯 I 数据中心能否承受高温运行?

华为液冷热管理控制器TMU荣获“数据中心冷却创新奖”

物联网未来发展趋势如何?

尼得科从5月开始量产AI数据中心新型冷却系统产品——行间式(In Row式)大型CDU

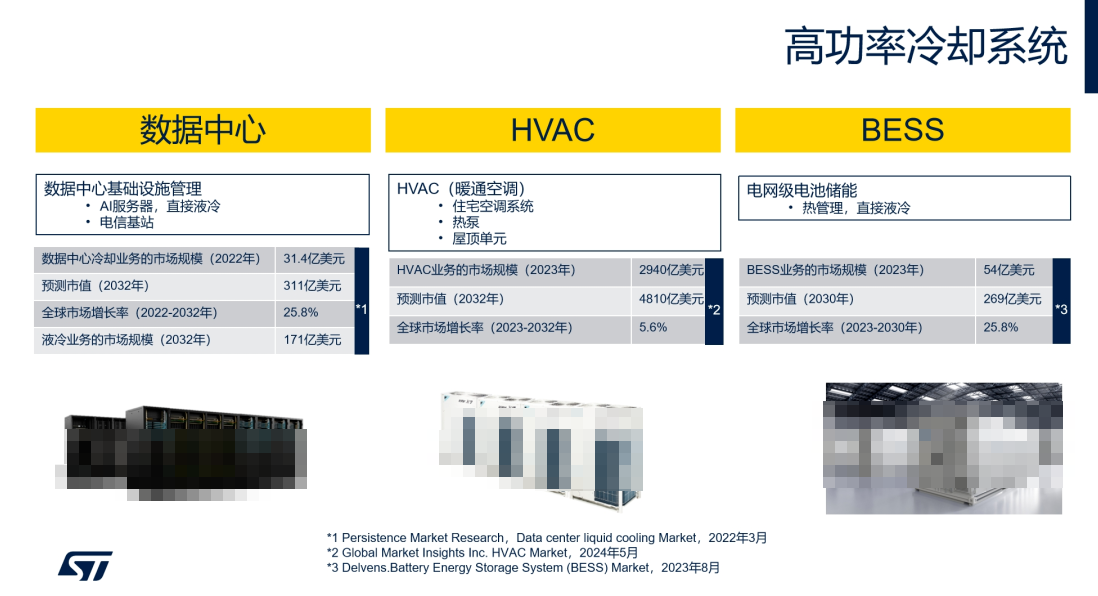

ST电机控制方案如何为数据中心等高功率冷却系统“降温增效”

华为亮相2025数据中心冷却高峰论坛(长三角)

工业电机行业现状及未来发展趋势分析

适用于数据中心和AI时代的800G网络

华为全新升级星河AI数据中心网络

Molex莫仕助力数据中心浸没式冷却系统未来发展

数据中心发展与改造

数据中心中温冷源供应系统

数据中心冷却技术的发展趋势

数据中心冷却技术的发展趋势

评论