概述

随着大模型技术的进步,具身智能也迎来了快速的发展。但在国内众多企业与高校推动相关技术发展的过程中,核心挑战仍在于具身操作泛化能力,即如何在有限的具身数据下,使机器人适应复杂场景并实现技能高效迁移。

为此,京东探索研究院李律松、李东江博士团队联合地瓜机器人秦玉森团队、中科大徐童团队、深圳大学郑琪团队、松灵机器人及睿尔曼智能吴波团队共同提出具身智能原子技能库架构,并得到了清华 RDT 团队在baseline 方法上的技术支持。

该方案是业界首个基于三轮数据驱动的具身智能原子技能库构建框架,突破了传统端到端具身操作的数据瓶颈,可动态自定义和更新原子技能,并结合数据收集与 VLA 少样本学习构建高效技能库。

与此同时,这也将是首个面向具身产业应用的数据采集新范式,旨在形成数据标准,解决当前具身智能领域数据匮乏的问题,特别是在高校与产业之间数据和范式的流动上,从而加速具身大模型研究的推进与实际落地。

论文标题:An Atomic Skill Library Construction Method for Data-Efficient EmbodiedManipulation

原文链接:https://arxiv.org/pdf/2501.15068

研究背景

具身智能,即具身人工智能,在生成式 AI 时代迎来重要突破。通过跨模态融合,将文本、图像、语音等数据映射到统一的语义向量空间,为具身智能技术发展提供新契机。VLA(视觉-语言-动作)模型在数据可用性与多模态技术推动下不断取得进展。然而,现实环境的复杂性使具身操作模型在泛化性上仍面临挑战。端到端训练依赖海量数据,会导致“数据爆炸”问题,限制 VLA 发展。将任务分解为可重用的原子技能降低数据需求,但现有方法受限于固定技能集,无法动态更新。

为解决此问题,团队提出了基于三轮数据驱动的原子技能库构建方法,可在仿真或真实环境的模型训练中减少数据需求。如图所示,VLP(视觉-语言-规划)模型将任务分解为子任务,高级语义抽象模块将子任务定义为通用原子技能集,并通过数据收集与VLA微调构建技能库。随着三轮更新策略的动态扩展,技能库不断扩增,覆盖任务范围扩大。该方法将重点从端到端技能学习转向细颗粒度的原子技能构建,有效解决数据爆炸问题,并提升新任务适应能力。

基于三轮数据驱动的原子技能库构建与推理流程

基于三轮数据驱动的原子技能库构建与推理流程为什么需要 VLP?

VLP 需要具有哪些能力?

从产业落地角度看,具身操作是关键模块。目前,端到端 VLA 进行高频开环控制,即便中间动作失败,仍输出下一阶段控制信号。因此,VLA 在高频控制机器人/机械臂时,强烈依赖VLP提供低频智能控制,以指导阶段性动作生成,并协调任务执行节奏。

为统一训练与推理的任务分解,本文构建了集成视觉感知、语言理解和空间智能的VLP Agent。如图所示,VLP Agent 接收任务指令文本与当前观察图像,并利用Prismatic生成场景描述。考虑到 3D 世界的复杂性,我们设计了一种空间智能感知策略:首先,Dino-X检测任务相关物体并输出边界框;然后,SAM-2提供精细分割掩码,并基于规则判断物体间的空间关系。最终,这些视觉与空间信息与任务指令一同输入GPT-4,生成完整执行计划并指定下一个子任务。VLP Agent 通过该方法在原子技能库构建中有效分解端到端任务,并在推理过程中提供低频控制信号,规划并指导高频原子技能的执行。

基于空间智能信息的 VLP Agent 具身思维链框架

基于空间智能信息的 VLP Agent 具身思维链框架VLA 存在的问题是什么?

在框架中起什么作用?

VLA 技术从专用数据向通用数据演进,机器人轨迹数据已达1M episodes级别;模型参数规模从千亿级向端侧部署发展;性能上,VLA 从单一场景泛化至多场景,提升技能迁移能力。尽管端到端任务采集与训练有助于科研算法优化,但在通用机器人应用中,人为定义端到端任务易导致任务穷尽问题。在单任务下,物品位置泛化、背景干扰、场景变化仍是主要挑战,即便强大预训练模型仍需大量数据克服;多任务下,数据需求呈指数级增长,面临“数据爆炸”风险。

提出的三轮数据驱动的原子技能库方法可结合SOTA VLA模型,通过高级语义抽象模块将复杂子任务映射为结构化原子技能,并结合数据收集与 VLA 少样本学习高效构建技能库。VLA 可塑性衡量模型从多本体迁移至特定本体的能力,泛化性则评估其应对物体、场景、空间变化的表现。以RDT-1B作品为例,我们基于6000 条开源数据及2000 条自有数据微调VLA 模型。测试结果表明,模型在物品和场景泛化上表现优异,但在物品位置泛化方面存在一定局限,且训练步数对最终性能影响显著。为进一步优化,团队进行了两项实验包括位置泛化能力提升及训练步长优化测试。这类VLA 模型性能测试对于原子技能库构建至关重要,测试结果不仅优化了Prompt 设计,也进一步增强了高级语义抽象模块在子任务映射与技能定义中的精准性。

为什么构建原子技能库?

怎样构建?

具身操作技能学习数据源包括互联网、仿真引擎和真实机器人数据,三者获取成本递增,数据价值依次提升。在多任务多本体机器人技能学习中,OpenVLA和Pi0依托预训练VLM,再用真实轨迹数据进行模态对齐并训练技能,而RDT-1B直接基于百万级机器人真实轨迹数据预训练,可适配不同本体与任务。无论模型架构如何,真实轨迹数据仍是关键。原子技能库的构建旨在降低数据采集成本,同时增强任务适配能力,提升具身操作的通用性,以满足产业应用需求。

基于数据驱动的原子技能库构建方法,结合端到端具身操作VLA与具身规划VLP,旨在构建系统化的技能库。VLP 将TASK A, B, C, ..., N分解为Sub-task #1, #2, ..., #a+1。高级语义抽象模块基于SOTAVLA模型测试可调整任务粒度,进一步将子任务映射为通用原子技能定义*1, *2, ..., *b+1,并通过数据收集与 VLA 少样本学习,构建包含*1', *2', ..., *b+1'的原子技能库。面对新任务TASK N+1,若所需技能已在库中,则可直接执行;若缺失,则触发高级语义抽象模块,基于现有技能库进行原子技能定义更新,仅需对缺失的原子技能收集额外数据与 VLA 微调。随着原子技能库动态扩增,其适应任务范围不断增加。相比传统TASK 级数据采集,提出的原子技能库所需要的数据采集量根据任务难度成指数级下降,同时提升技能适配能力。

实验与结果分析

验证问题

- 在相同物体点位下采集轨迹数据,所提方法能否以更少数据达到端到端方法性能?

- 在收集相同数量的轨迹数据下,所提方法能否优于端到端方法?

- 面对新任务,所提方法是否能够在不依赖或者少依赖新数据的条件下仍然有效?

- 所提方法是否适用于不同VLA模型,并保持有效性和效率?

实验设置

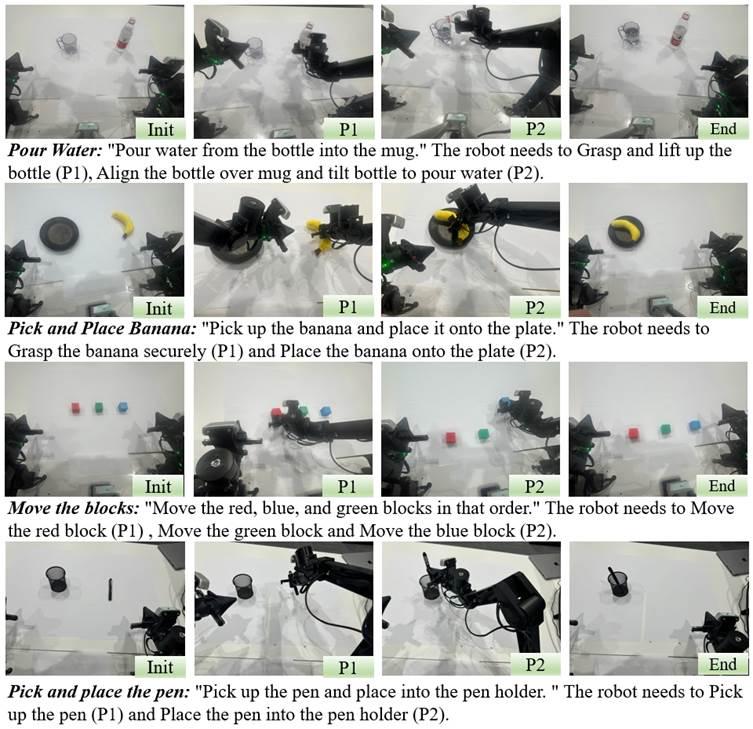

针对上述问题,我们设计了四个挑战性任务,并在RDT-1B和Octo基准模型上,以Agilex 双臂机器人进行测试。实验采用端到端方法和所提方法分别采集数据,以对比两者在数据利用效率和任务泛化能力上的表现。具体实验设置如下:

- 拿起香蕉并放入盘子

- 端到端方法:从4 个香蕉点位和2 个盘子点位采集24 条轨迹。

- 所提方法:保持数据分布一致,分解为12 条抓取香蕉轨迹和6 条放置香蕉轨迹。

- 为匹配端到端数据量,进一步扩大采样范围,从8 个香蕉点位采集24 条抓取轨迹,3 个盘子点位采集24 条放置轨迹。

- 拿起瓶子并向杯中倒水

- 端到端方法:从3 个瓶子点位和3 个杯子点位采集27 条轨迹。

- 所提方法:分解为9 条抓取瓶子轨迹和9 条倒水轨迹,确保数据分布一致。

- 进一步扩大采样范围,从9 个瓶子点位采集27 条抓取轨迹,9 个杯子点位采集27 条倒水轨迹。

- 拿起笔并放入笔筒

- 端到端方法:从4 个笔点位和2 个笔筒点位采集24 条轨迹。

- 所提方法:分解为12 条抓取笔轨迹和6 条放置笔轨迹,保持数据分布一致。

- 进一步扩大采样范围,从8 个笔点位采集24 条抓取轨迹,3 个笔筒点位采集24 条放置轨迹。

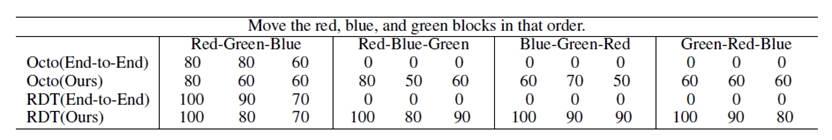

- 按指定顺序抓取积木(红、绿、蓝)

- 端到端方法:采集10 条轨迹,固定积木位置,按顺序抓取红色、绿色、蓝色积木。

- 所提方法:为匹配端到端数据量,分别采集10 条抓取红色、绿色、蓝色积木轨迹,共30 条。

任务定义与可视化

任务定义与可视化实验结果

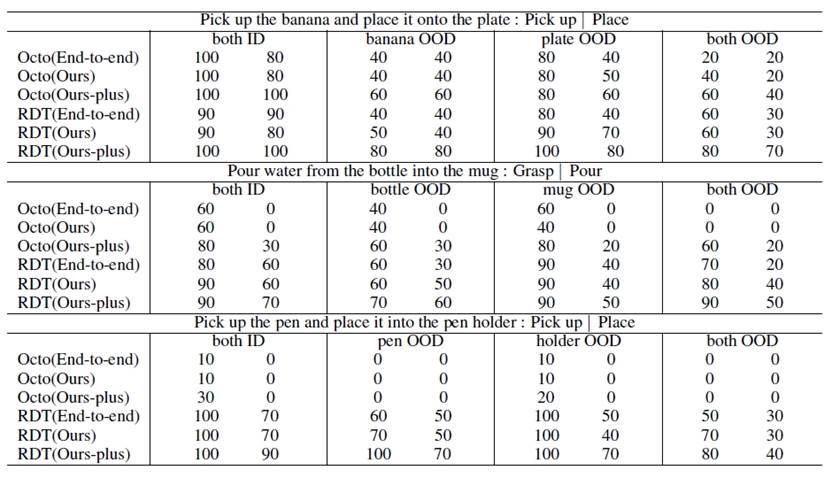

前三个任务用于验证所提方法在数据效率和操作性能上的表现,第四个任务则评估其新任务适应能力。为确保公平性,每种实验设置均在Octo和RDT-1B上进行10 次测试,对比端到端方法与所提方法(“Ours” 和 “Ours-plus”)。如表1所示,“End-To-End”:原始端到端VLA方法;“Ours”:保持数据分布一致,但数据量更小;“Ours-plus”:保持数据量一致,但采集更多点位;“ID”:任务点位在训练数据分布内;“OOD”:任务点位超出训练数据分布。在第四个任务中,设定红-绿-蓝顺序抓取积木为已知任务,并采集数据训练模型。针对其他颜色顺序的未知任务,直接调用已训练的技能进行测试,以评估方法的泛化能力(见表 2)。结果分析如下:

Q1: 从表 1 可见,Octo 和 RDT-1B在使用所提方法后,成功率与端到端方法相当甚至更高。在拿起瓶子并向杯中倒水任务中,OOD 测试成功率提升 20%,表明该方法在相同点位分布下,减少数据需求同时提升性能。

Q2: 在相同数据量下,所提方法显著提升成功率。例如,在拿起香蕉并放入盘子任务中,OOD 情况下成功率提高 40%,归因于从更多点位采集数据,增强模型泛化能力。

Q3: 从表 2 可见,端到端方法仅适用于已知任务,无法泛化新任务,而所提方法能通过已有技能组合成功执行不同的新任务。

Q4: 表 1 和表 2 进一步验证,所提方法在多种VLA模型上均提升数据效率、操作性能和新任务适应能力,适用于不同模型的泛化与优化。

表1:与原始端到端方法实验结果对比

表1:与原始端到端方法实验结果对比 表2:与原始端到端方法方块抓取任务实验结果对比

表2:与原始端到端方法方块抓取任务实验结果对比小结

基于三轮数据驱动的原子技能库构建框架,旨在解决传统端到端具身操作策略带来的“数据爆炸”问题,为具身智能产业应用提供创新解决方案。该框架具有广泛价值,可用于提升物流仓储、智能制造、医疗辅助等领域的自动化水平。例如,在医疗辅助和服务机器人领域,它能够增强自主交互能力,助力精准操作。希望此项工作能够为行业提供重要启示,促进学术界与产业界的深度合作,加速具身智能技术的实际应用。

-

机器人

+关注

关注

213文章

30603浏览量

219667 -

数据

+关注

关注

8文章

7315浏览量

93993 -

人工智能

+关注

关注

1813文章

49750浏览量

261621 -

具身智能

+关注

关注

0文章

284浏览量

782

发布评论请先 登录

具身智能大算力开发平台S600重磅亮相,地瓜机器人引领端云一体机器人进化新范式

乐聚机器人与地瓜机器人达成战略合作,联合发布Aelos Embodied具身智能

喜讯 | 京东联合地瓜机器人等多家企业高校,推出业内首个具身智能原子技能库架构

喜讯 | 京东联合地瓜机器人等多家企业高校,推出业内首个具身智能原子技能库架构

评论