自从模型广场上新后,有不少朋友来咨询小助手如何开启模型的推理部署,今天,小助手就以Stable Diffusion WebUI为例,教大家如何捷智算平台开启模型的推理部署。

Web UI模型详细部署教程

进入捷智算,在菜单栏找到【模型广场】就可以看到上新的模型~

一、选择模型类型

根据自己兴趣的模型点击【推理部署】,我们找到StableDiffusionWebUI点击【推理部署】。

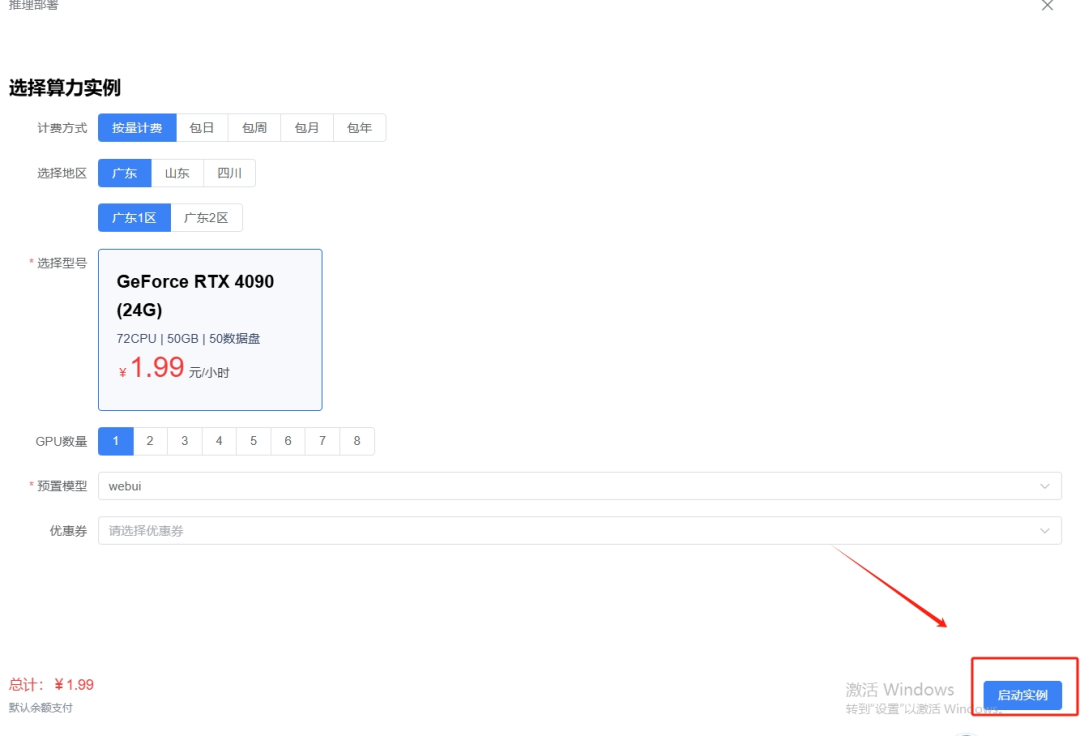

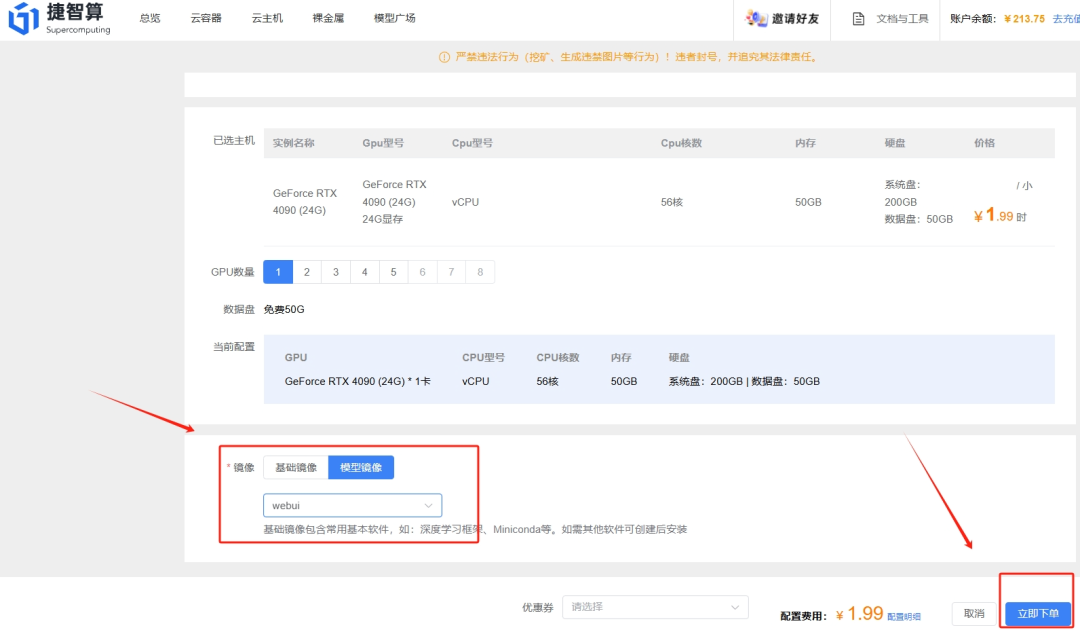

二、购买容器

选择需要的GPU卡及分区,然后点击【启动实例】

也可以在购买容器页面点击【模型镜像】,选择需要的模型镜像,进入部署好模型的容器。

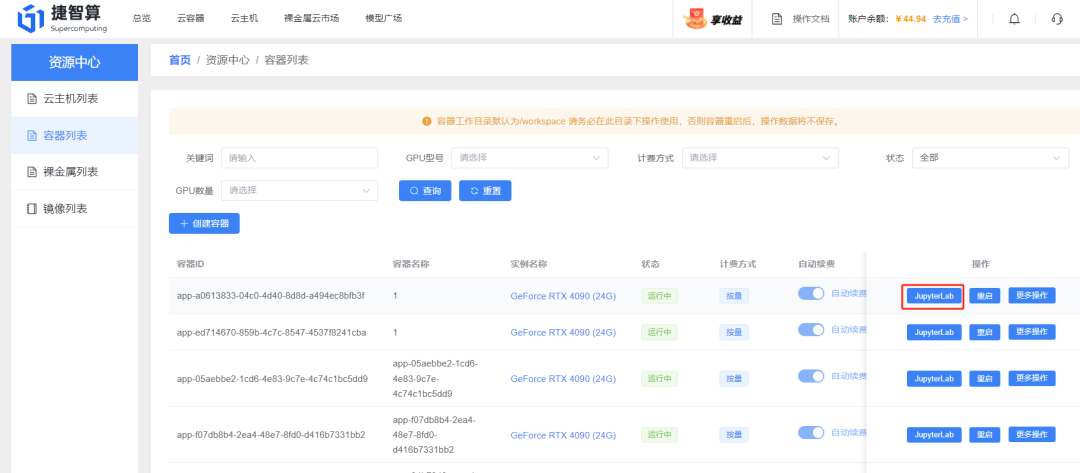

三、打开jupyter文档

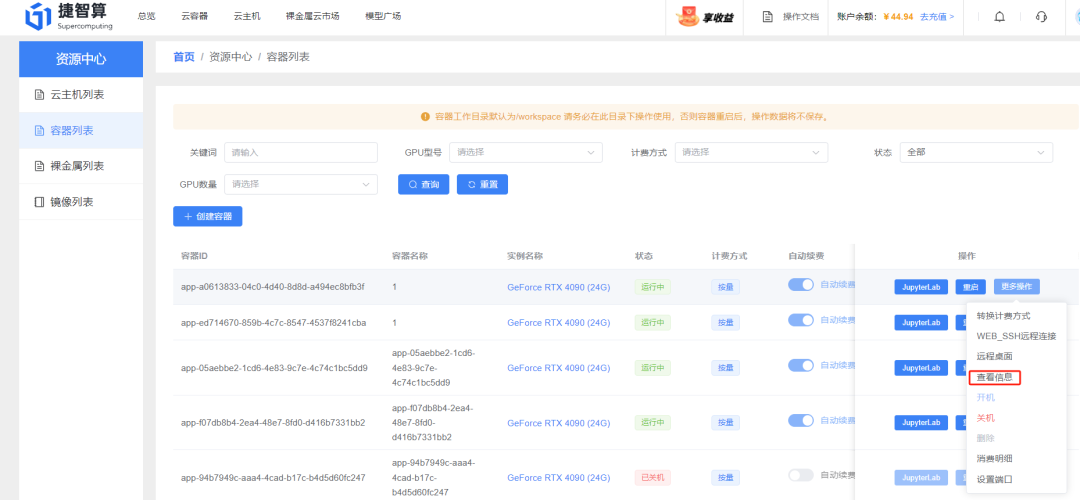

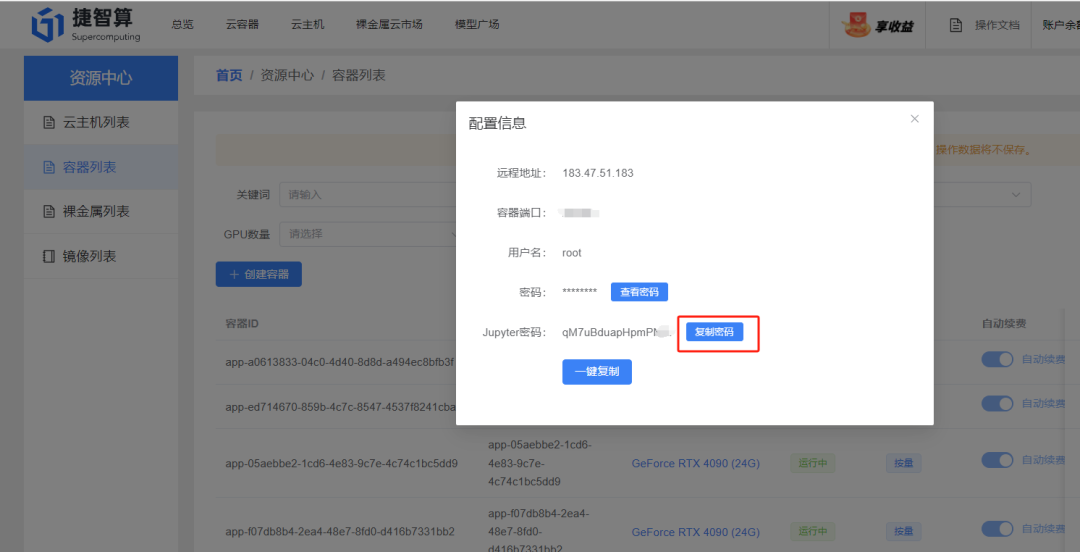

创建实例运行成功后点击【更多操作】-【查看信息】,获取并复制jupyter密码

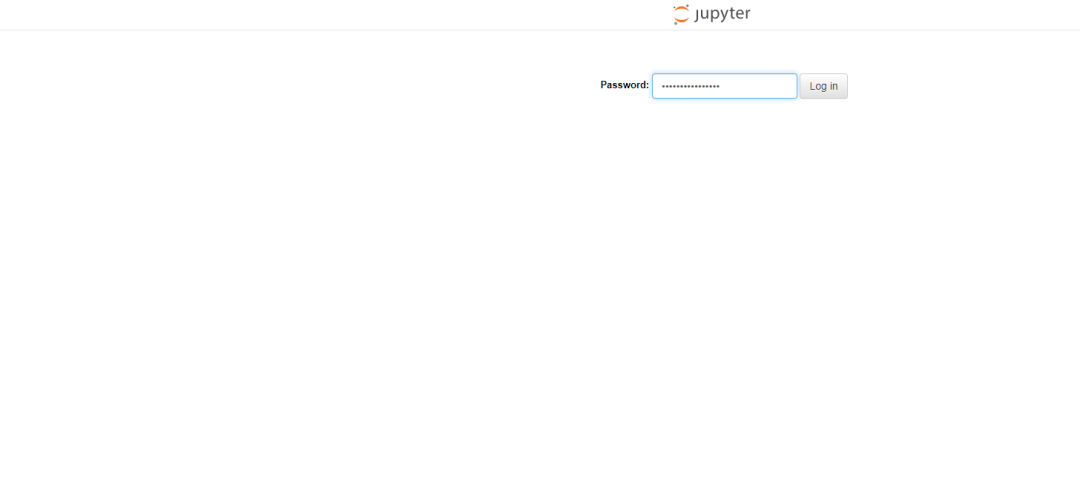

获取密码后点击jupyter,输入复制的密码

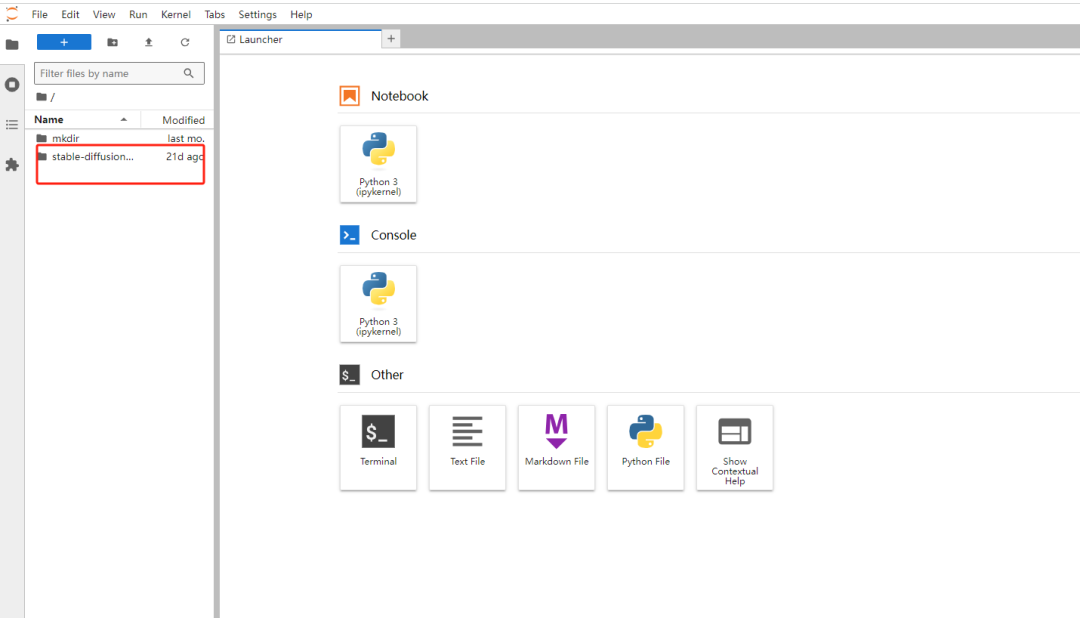

就可以进去到模型的jupyter文件页面啦~例如选的是Stable diffusion模型,则点击Stable Diffusion文件夹

四、启动模型

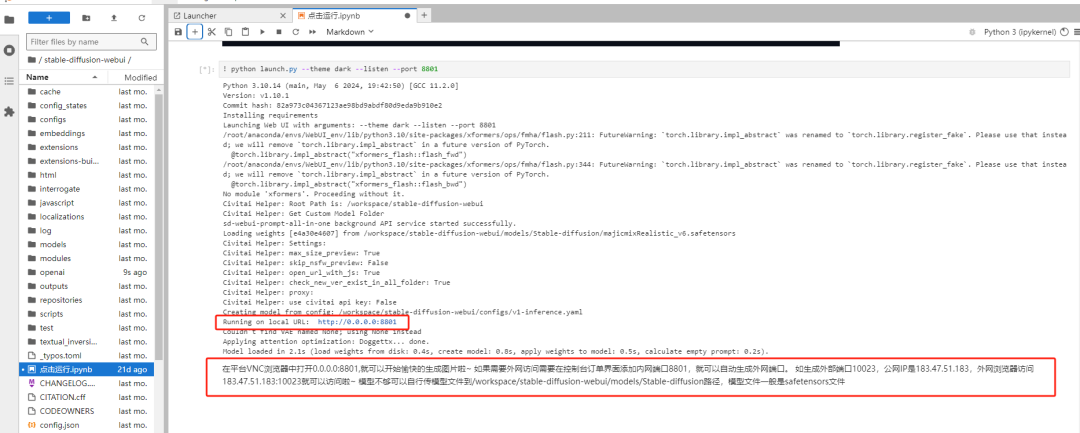

点击模型启动ipynb格式文件,按教程点击点击上方 ▸▸ 按键直接运行

点击Restart,重启内核运行

看到显示URL链接就说明模型启动成功啦~

五、配置外网端口并外网打开

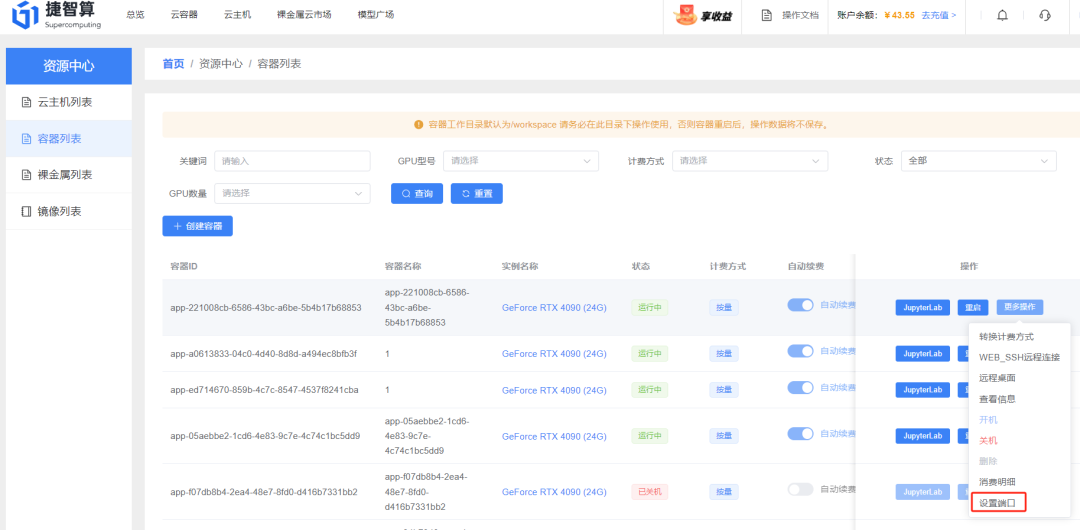

要留意一下哦!模型广场web的一般是链接是0.0.0.0:8801,但是只能在内网打开(也就是不能在您自己的电脑打开模型链接的意思),如果想外网分享链接,需要申请端口开放。返回控制台,点击【更多操作】-【设置端口】

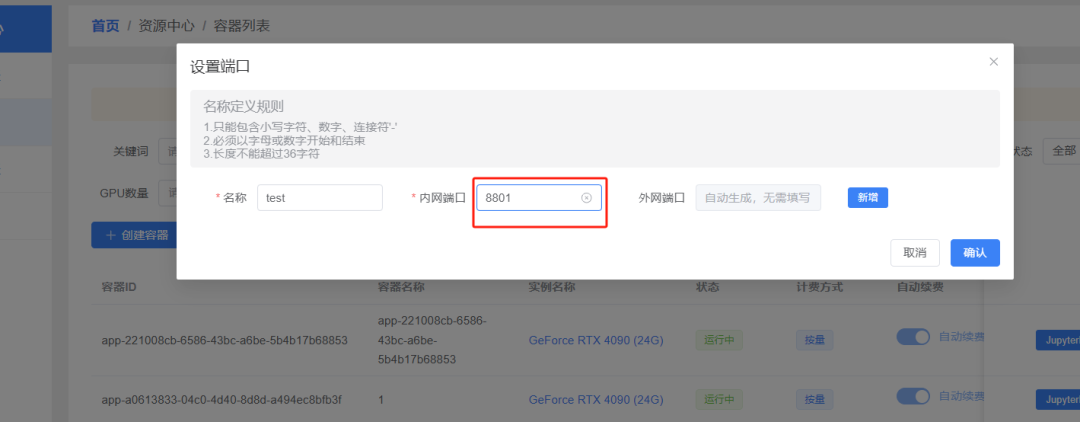

内网端口输入8801,点击【确认】,就会生成一个外网端口

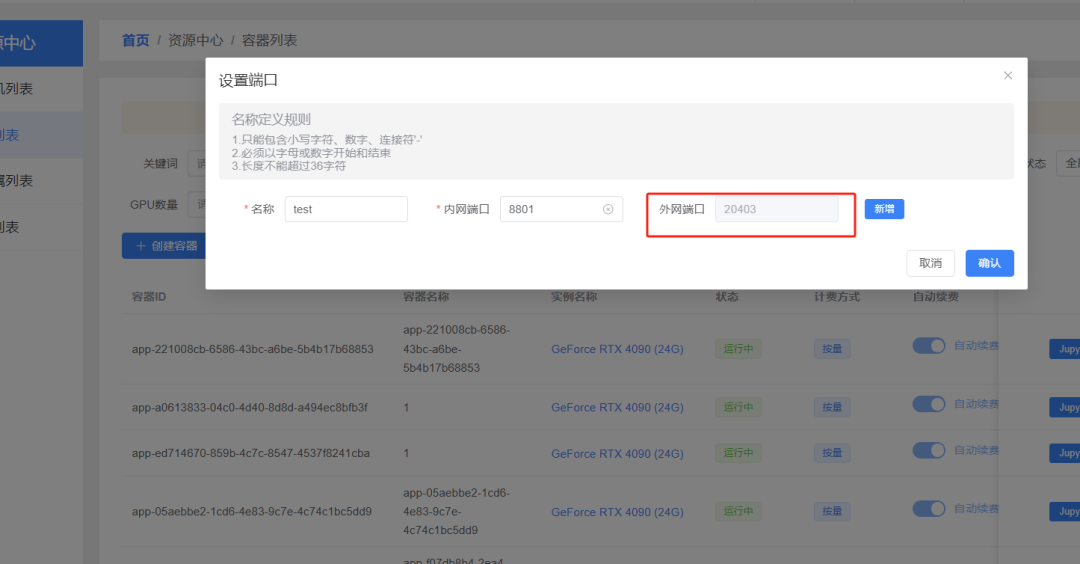

再次点击设置端口,就可以看到生成的外网端口,比如20403

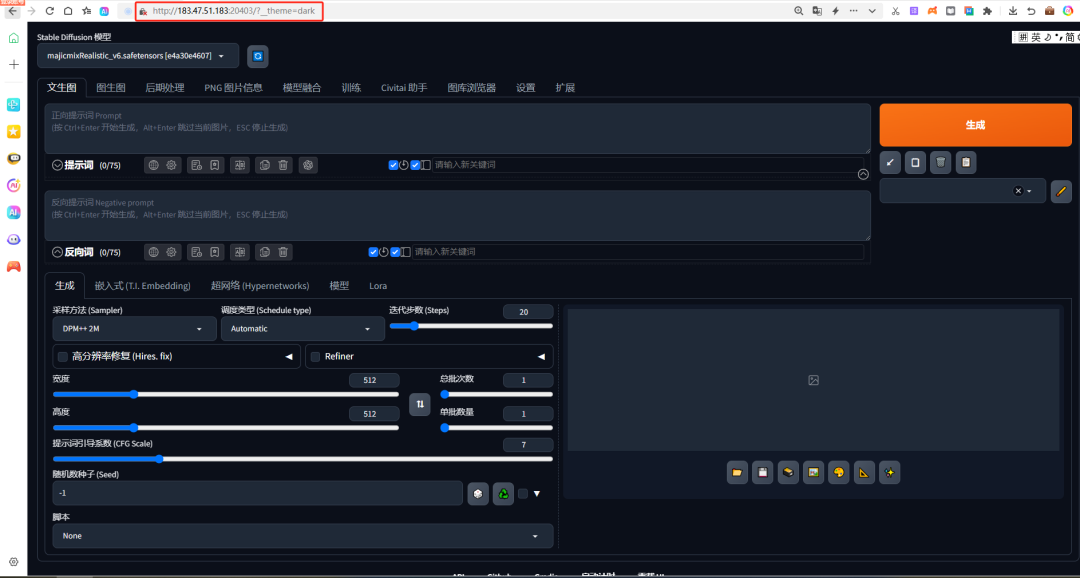

这样就可以在外网打开

如果看到远程地址是183.47.51.183,那你就可以在自己的电脑浏览器输入【183.47.51.183:20403】打开Web UI使用界面。

打开后,大家就可以在SD的世界里畅玩啦~记得先去找小助手薅羊毛,再来推理部署

-

AI

+关注

关注

89文章

38171浏览量

296893 -

人工智能

+关注

关注

1813文章

49752浏览量

261631 -

模型

+关注

关注

1文章

3649浏览量

51719

发布评论请先 登录

什么是AI模型的推理能力

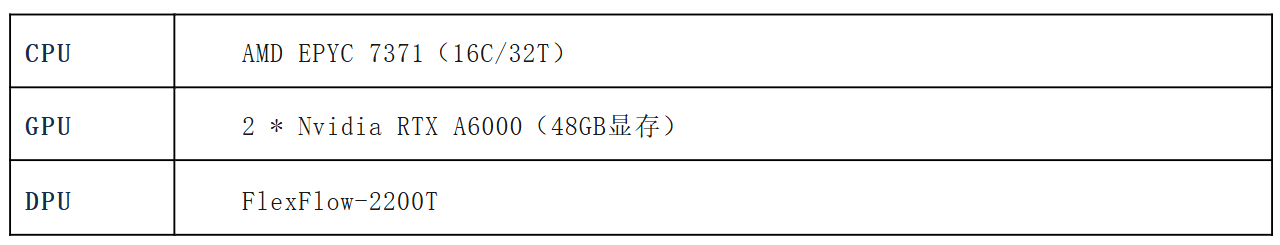

本地部署openWebUI + ollama+DeepSeek 打造智能知识库并实现远程访问

基于米尔瑞芯微RK3576开发板部署运行TinyMaix:超轻量级推理框架

【VisionFive 2单板计算机试用体验】3、开源大语言模型部署

如何在魔搭社区使用TensorRT-LLM加速优化Qwen3系列模型推理部署

大模型推理显存和计算量估计方法研究

边缘计算中的机器学习:基于 Linux 系统的实时推理模型部署与工业集成!

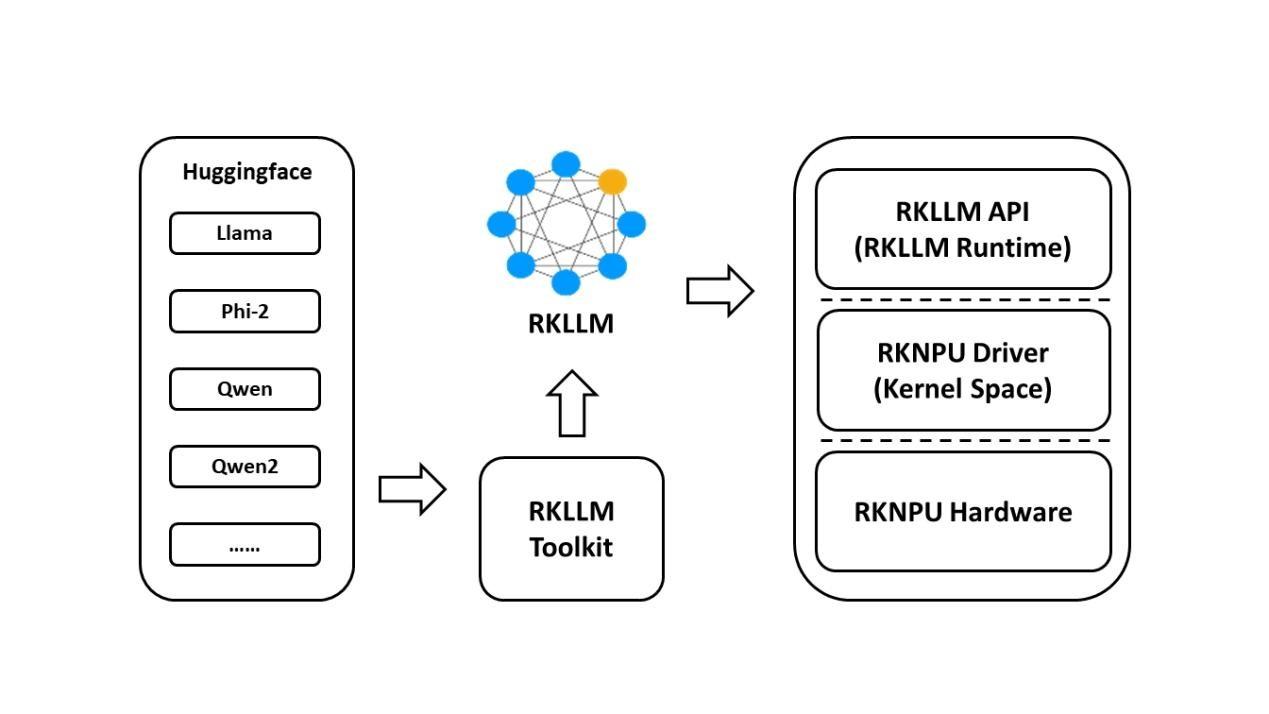

基于RK3576开发板的RKLLM大模型部署教程

详解 LLM 推理模型的现状

中科驭数高性能网卡产品 成就DeepSeek推理模型网络底座

如何开启Stable Diffusion WebUI模型推理部署

如何开启Stable Diffusion WebUI模型推理部署

评论