算能BM1684X上完成Qwen3-VL 4B/8B模型的适配,推理速度13.7/7.2 tokens/s,使其成为边缘部署多模态大模型的最佳选择。

近日,阿里千问正式开源Qwen3-VL系列的4B和8B版本模型,为边缘计算和端侧设备提供了更高效的多模态AI解决方案。算能BM1684X芯片已完成对该系列模型的适配,4B/8B模型在边缘端实现了13.7 /7.2 tokens/s的推理性能。

模型性能突破,小参数大能力

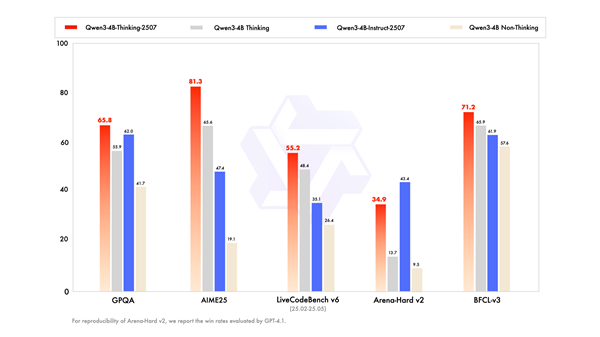

Qwen3-VL系列再添新成员——Dense架构的Qwen3-VL-8B、Qwen3-VL-4B 模型,本地部署友好,在MMMU、MathVista等基准测试中超越了同级别的其他模型,并在部分测试场景中展现出与更大规模模型相媲美的性能,通过架构优化,它有效解决了小模型中常见的视觉与文本能力不平衡问题,为边缘场景带来了更多解法。

Qwen3-VL 4B和8B模型在保持模型轻量化的同时,确保了多模态理解能力的完整性。这两个规模的模型均提供Instruct和Thinking两个版本,满足不同场景的应用需求。

Qwen3-VL模型能主动识别异常行为,自动调取多路摄像头追踪,并调用工具生成处置方案,实现从感知到决策的闭环;凭借增强的空间推理能力,系统可精准分析人员轨迹、识别异常聚集,构建动态安防态势图,预警潜在风险;进一步扩展了长上下文能力,支持对长视频的秒级精确定位,在文搜检索的基础上,提供有逻辑依据的事件分析,大幅提升调查效率。

另外,很多传统算法没有覆盖的corner case,不再需要人工标注训练,直接通过prompt调整即可实现,从"看得见"迈向"看得懂",Qwen3-VL将为各种端侧设备的智能化升级注入新动力。

BM1684x适配加速,推理性能一骑绝尘

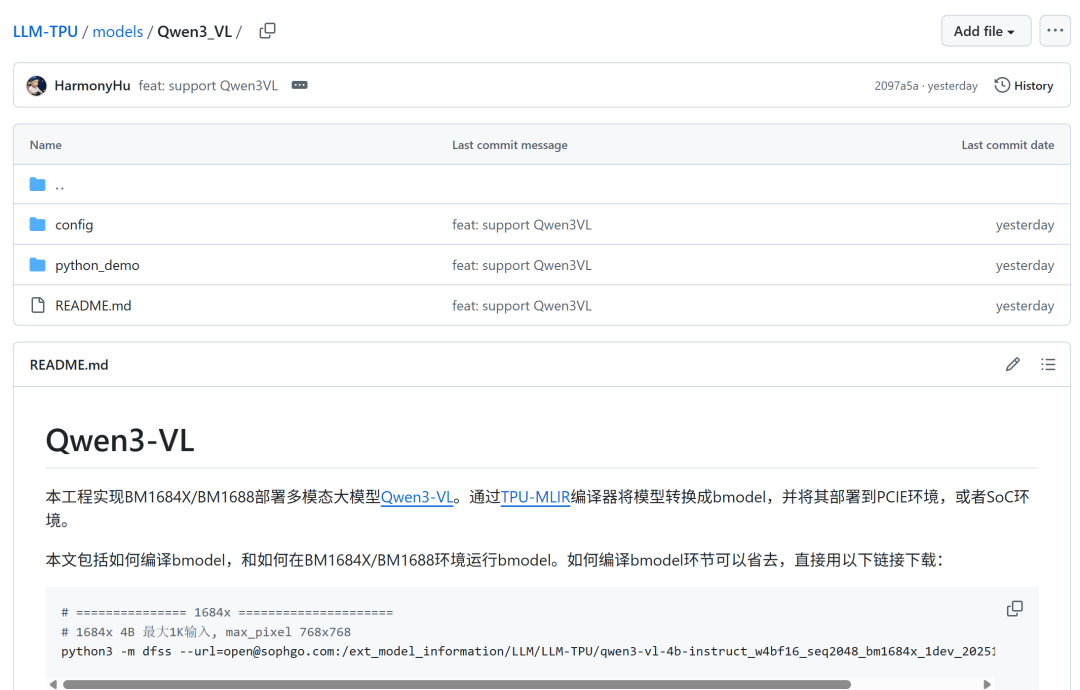

BM1684X芯片已完成对Qwen3-VL系列的适配工作,并开源在LLM-TPU仓库,所有基于BM1684X的盒子、计算卡、微服务器都可以稳定运行。

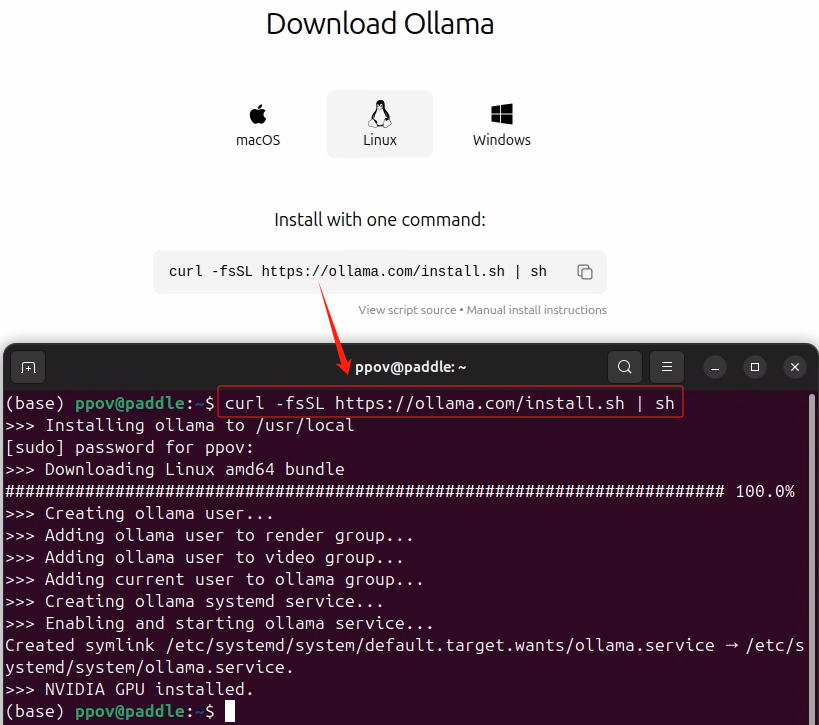

API一键部署:如果想将Qwen3-VL的多模态能力集成到其他系统中,通过AIGC-SDK封装好的标准API,只需要一行命令即可实现:

bash scripts/init_app.sh qwen3vl

测试数据显示,Qwen3-VL模型在BM1684X平台上的推理速度达到13.7 tokens/s,这一性能表现使得实时多模态理解在边缘端成为可能。同时,芯片的多路视频编解码能力使其能够同时处理32路1080p视频流,为大规模部署奠定基础。

Qwen3-VL系列模型与BM1684X的结合,为多个行业的智能化升级提供了新的技术路径,本地化部署能够有效降低云端传输延迟,提升系统响应速度。

开源开放的工具链给了用户更多的控制权,进一步降低了模型部署的难度,开发者可以便捷地将自己微调后的模型移植到边缘设备,加速应用落地。

-

芯片

+关注

关注

462文章

53552浏览量

459294 -

算能科技

+关注

关注

0文章

7浏览量

512

发布评论请先 登录

爱芯元智边缘AI芯片AX8850完成Qwen3-VL多模态大模型适配

NVIDIA ACE现已支持开源Qwen3-8B小语言模型

广和通成功部署DeepSeek-R1-0528-Qwen3-8B模型

基于米尔瑞芯微RK3576开发板的Qwen2-VL-3B模型NPU多模态部署评测

阿里通义千问发布小尺寸模型Qwen3-4B,手机也能跑

壁仞科技完成Qwen3旗舰模型适配

Arm CPU适配通义千问Qwen3系列模型

Intel OpenVINO™ Day0 实现阿里通义 Qwen3 快速部署

后摩智能NPU适配通义千问Qwen3系列模型

壁仞科技完成阿里巴巴通义千问Qwen3全系列模型支持

爱芯通元NPU适配Qwen2.5-VL-3B视觉多模态大模型

利用英特尔OpenVINO在本地运行Qwen2.5-VL系列模型

如何在边缘端获得GPT4-V的能力:算力魔方+MiniCPM-V 2.6

Qwen3-VL 4B/8B全面适配,BM1684X成边缘最佳部署平台!

Qwen3-VL 4B/8B全面适配,BM1684X成边缘最佳部署平台!

评论