作者:算力魔方创始人/英特尔边缘计算创新大使 刘力

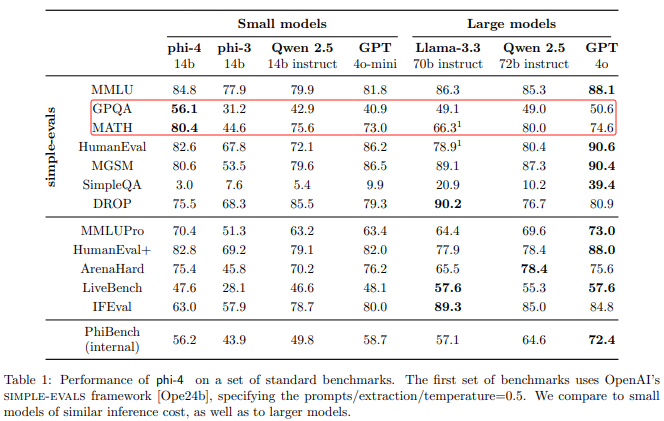

前面我们分享了《在算力魔方上本地部署Phi-4模型》,实现了在边缘端获得Llama 3.3 70B模型差不多的能力。本文将分享,在边缘端获得类似GPT4-V的能力:MiniCPM-V 2.6 。

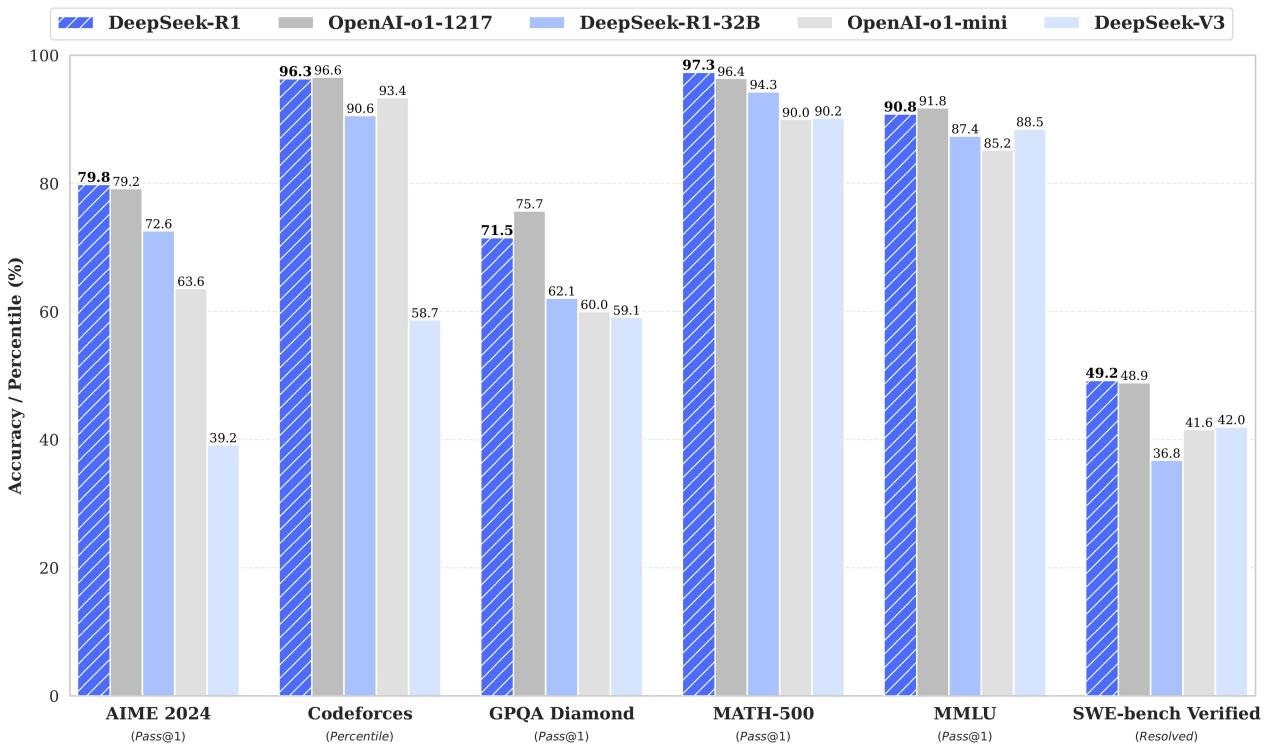

MiniCPM-V 2.6是MiniCPM-V系列最新、性能最佳的模型,基于SigLip-400M和Qwen2-7B构建,共8B参数。在最新版本 OpenCompass 榜单上(综合 8 个主流多模态评测基准)平均得分 65.2,以8B量级的大小在单图理解方面超越了 GPT-4o mini、GPT-4V、Gemini 1.5 Pro 和 Claude 3.5 Sonnet等主流商用闭源多模态大模型。

参考链接:OpenBMB/MiniCPM-o: MiniCPM-o 2.6: A GPT-4o Level MLLM for Vision, Speech and Multimodal Live Streaming on Your Phone

本文将分享MiniCPM-V 2.6 8B模型在算力魔方®4060版上的部署过程。

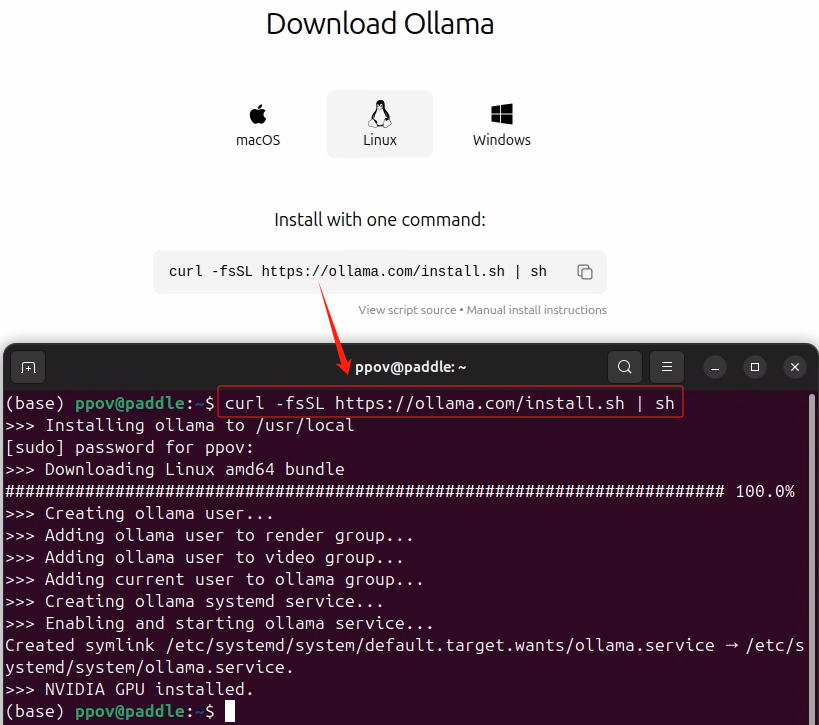

一,安装Ollama

请按照《Gemma 2+Ollama在算力魔方上帮你在LeetCode解题》安装Ollama。

二,运行MiniCPM-V 2.6

使用下面的命令完成运行MiniCPM-V 2.6:

ollamarunminicpm-v

三,体验MiniCPM-V 2.6 多模态能力

输入下面的提示词和测试图片,体验MiniCPM-V 2.6的多模态能力:

“请描述并总结图片中的内容,并提炼出该产品的卖点。”

运行视频链接

审核编辑 黄宇

-

GPT

+关注

关注

0文章

368浏览量

16715 -

边缘计算

+关注

关注

22文章

3472浏览量

52689

发布评论请先 登录

借势 RISC-V与 AI 浪潮,元石智算打造算力新范式

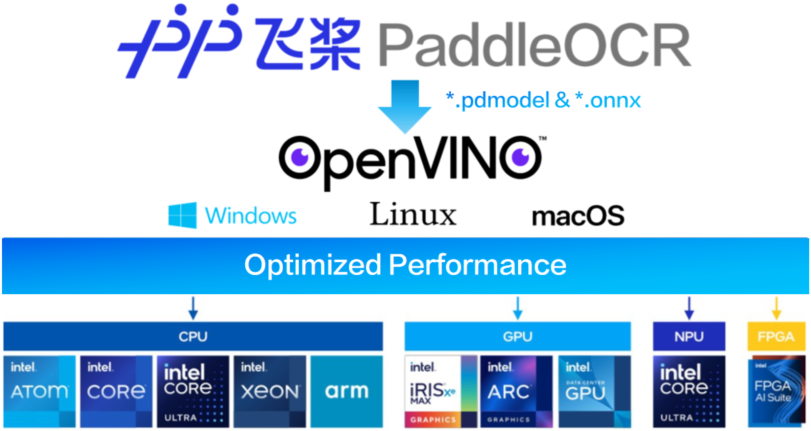

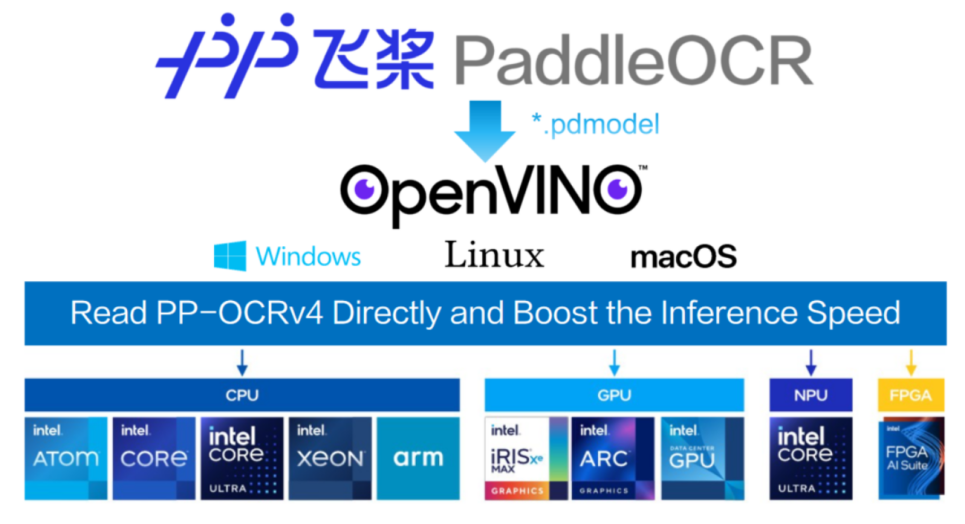

基于算力魔方与PP-OCRv5的OpenVINO智能文档识别方案

边缘计算时代,科通技术以端AI方案重构算力分配格局

基于算力魔方的智能文档信息提取方案

大算力芯片的生态突围与算力革命

如何在边缘端获得GPT4-V的能力:算力魔方+MiniCPM-V 2.6

如何在边缘端获得GPT4-V的能力:算力魔方+MiniCPM-V 2.6

评论