知存科技致力于开发的基于NOR Flash的存算一体化人工智能芯片,其芯片特点是能耗低、运算效率高、速度快和成本低,适用于终端设备的人工智能应用。

知存科技演讲实录

知存科技是一家刚刚成立半年的公司,今年3月份正式运营,专注于开发低功耗低成本的存算一体AI芯片。

人工智能目前还处于发展阶段,当前的落地的应用场景较少,没有达到社会的期望。随着人工智能算法的进步以及芯片算力的提升,未来人工智能将会出现一个更大的爆发点,会涌现更多的应用落地。

人工智能芯片作为人工智能的载体,被大家寄予厚望,在2020年,人工智能芯片市场预计达到千亿量级。传统芯片巨头比如arm、Intel、NVIDIA都通过自研和收购推出了数款芯片,互联网巨头比如Google、亚马逊和微软等也都正推出和开发的人工智能芯片。这个领域的创业公司就更多了,中国的几家头部公司就做得非常好。

人工智能依赖的算法有几大特点:这是一个很庞大和复杂的网络,有很多参数要存储,也需要完成大量的计算,这些计算当中又会产生大量数据。为了完成大量计算的过程当中,一般芯片的设计思路是将大量增加并行的运算单元,比如上千个卷积单元,需要调用的存储资源也在增大,然而存储资源一直是有限的。随着运算单元的增加,每个运算单元能够使用的存储器的带宽和大小在逐渐减小,存储器是人工智能芯片的瓶颈。

在很多人工智能推理运算中,90%以上的运算资源都消耗在数据搬运的过程。芯片内部到外部的带宽以及片上缓存空间限制了运算的效率。现在工业界和学术界很多人都认为存算一体化是未来的趋势。

存算一体化分为几种:DRAM和SSD中植入计算芯片或者逻辑计算单元,可以被叫做存内处理或者近数据计算,这种方式非常适合云端的大数据和神经网络训练等应用;另一种就是存储和计算完全结合在一起,使用存储的器件单元直接完成计算,比较适合神经网络推理类应用。我们研发的是后者这样的技术,将存储和计算结合到闪存单元中的存算一体。闪存技术已经非常成熟,商用几十年了,成本很低。

当前商用的神经网络非常庞大,拥有几百万到几千万的权重参数,或者推理过程中需要完成几百万到上千万个乘加法运算。传统的计算系统需要将网络权重参数存在片外的非易失性存储器中,比如NAND Flash或者NOR Flash。运算的过程中,需要把部分需要的权重参数搬运到DRAM,再把小部分参数传入到芯片中的SRAM和eDRAM中,之后导入寄存器和运算单元完成运算。神经网络运算需要大面积SRAM和eDRAM来减少片内外数据搬运和提高运算效率,但是由于片上存储成本的限制,也需要高成本高速度的DRAM来缓存片上无法容纳的权重参数和临时数据。

我们存算一体化的做法是这样的:我们的Flash存储单元本身就可以存储神经网络的权重参数,同时又可以完成和此权重相关的乘加法运算,就是将乘加法运算和存储全部融合到一个Flash单元里面。举个例子,只需要100万个Flash单元,就可以存储100万个权重参数同时并行完成100万次乘加法运算。我们做的是这样一款芯片,深度学习网络被映射到多个Flash阵列,这些Flash阵列不仅存储和深度学习网络同时完成网络的推理,这个过程不需要逻辑计算电路。这种方式的运算效率非常高,成本很低,单个Flash单元能够完成7、8 bit的乘加法运算。

之前我们说我们芯片有两个特点:一个是运算效率高,相比于现在基于冯诺依曼架构的深度学习芯片,大概能够提高运算效率10-50倍;另一个是产品成本低,节省了DRAM、SRAM、片上并行计算单元的面积消耗,简化了系统的设计,同时无需采用先进的芯片加工工艺,可以数倍地降低生产成本,几十倍地降低流片和研发成本。当前阶段,我们寻找的是对成本和运算效率(功耗)敏感的应用,比如终端的低功耗低成本的语音识别应用。未来,随着人工智能和物联网的发展,我们会拓展更多的应用场景,比如说低成本和低功耗的感知应用和人机交互。

2014年,我们开始在加州大学圣芭芭拉分校的实验室做这项技术的研发,完成过6次流片和技术验证。去年年末在北京注册的公司,今年3月份正式开始运营,仅仅5个月的时间我们就把设计送出去流片,顺利的话,过3-4个月就会完成芯片测试,争取明年量产。我们的团队毕业于北京大学、北京航空航天大学、美国加州大学洛杉矶分校,加州大学圣芭芭拉分校等学校。核心团队成员大部分都有十年以上的行业经验,团队目前有11个人,年末也会扩大团队规模。

乘法计算的方式是通过类似模拟电路的电流镜方式。输入电流转换成电压耦合到Flash晶体管的控制栅上,Flash晶体管的输出电流等于输入电流和存储的权重相乘。加法的计算方式类似于并联电路电流求和。

怎么看待Intel新的X Point技术?

这是一项很新的技术,目前主要问题是成本和系统支持度的问题,但随着产业链的发展,成本会越来越低,速度也会更快,系统也会更好的支持X-Point兼有的高速和非易失性的特性。这项技术的selector做得很好。作为存储器、内存或者他们的统一体这类应用来说,未来成本降低之后,会有非常大的优势。Intel在这个技术的市场推广上也投入很多精力,其他后来者可能会坐享其成。

北京知存科技有限公司成立于2017年10月,专注于开发基于存算一体的人工智能芯片和系统。公司通过自主研发的核心技术将计算和存储融合在NOR Flash存储芯片中,大幅度提高运算的并行读,提升人工智能核心运算效率多个数量级。该设计方法还简化了芯片设计架构,节省了内存、缓存和神将网络加速器模块的支出,显著地降低了芯片成本。当前公司正在流片的是面向终端设备的低功耗语音识别芯片。公司将长期致力于深入研发和优化存算一体化技术,将之应用于广阔的人工智能应用场景中。

-

芯片

+关注

关注

462文章

53581浏览量

459715 -

存储器

+关注

关注

39文章

7715浏览量

170916 -

人工智能

+关注

关注

1813文章

49775浏览量

261836 -

存算一体

+关注

关注

1文章

114浏览量

4979

原文标题:五期Demo Day路演回顾 | 知存科技:让AI设备无所不在

文章出处:【微信号:ARMaccelerator,微信公众号:安创空间ARMaccelerator】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

2025 CCF SYS知存科技专场论坛精彩回顾

存算一体AI芯片公司九天睿芯完成超亿元B轮融资

知存科技荣获2025半导体市场创新表现奖

芯动科技与知存科技达成深度合作

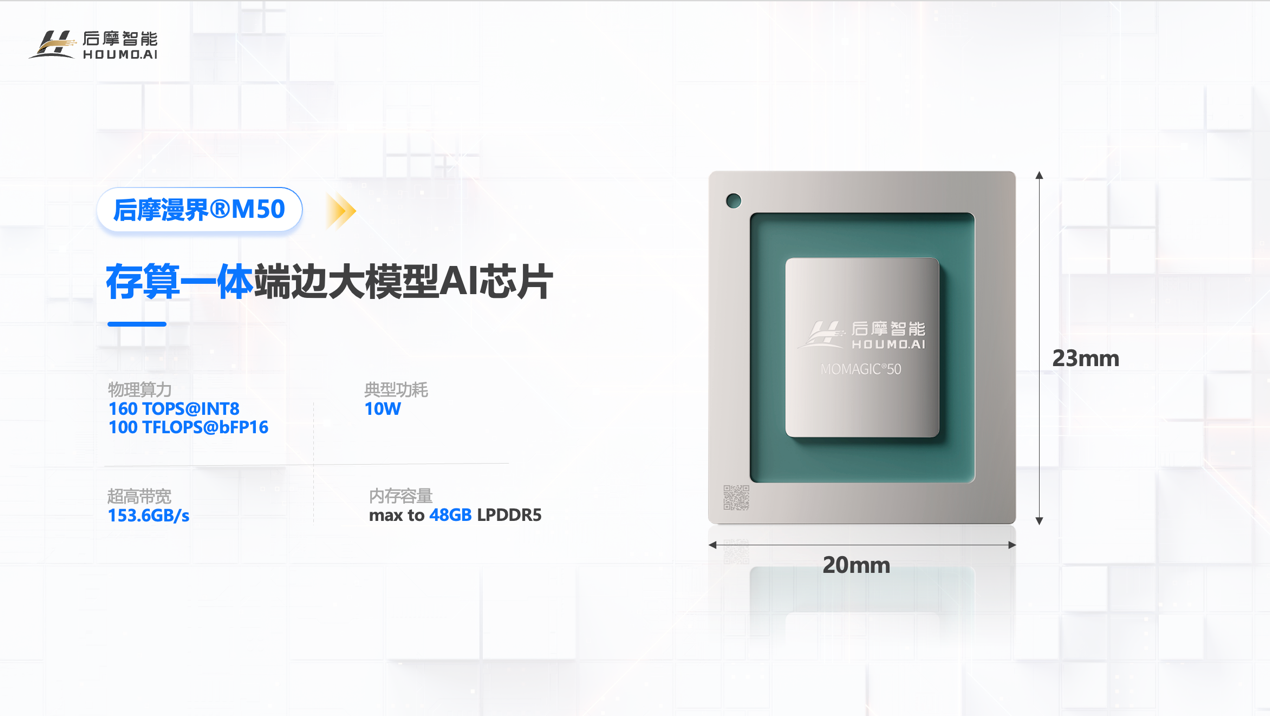

存算一体技术加持!后摩智能 160TOPS 端边大模型AI芯片正式发布

缓解高性能存算一体芯片IR-drop问题的软硬件协同设计

国际首创新突破!中国团队以存算一体排序架构攻克智能硬件加速难题

第二届知存科技杯华东高校存内计算创新应用大赛正式启动

苹芯科技 N300 存算一体 NPU,开启端侧 AI 新征程

知存科技致力于开发的基于NOR Flash的存算一体化人工智能芯片

知存科技致力于开发的基于NOR Flash的存算一体化人工智能芯片

评论