在第三届 NVIDIA DPU 中国黑客松竞赛中,我们见证了开发者与 NVIDIA 网络技术的深度碰撞。在 23 支参赛队伍中,有 5 支队伍脱颖而出,展现了在 AI 网络、存储和安全等领域的创新突破。

由刘瀚骋、刘崇鹏、刘阳组成的 SeekExpert 团队在本届黑客松中展现了卓越的技术实力,凭借其创新项目“利用 NVIDIA DOCA GPUNetIO 技术,加速 Expert-Kit 推理框架中的专家权重分发和通信传输部分,从而提升 MoE 模型推理的速度和效率”取得了第二名。该项目利用 NVIDIA DOCA GPUNetIO 技术,针对 Expert-Centric 架构的 Expert-Kit MoE 推理框架中的专家权重分发和通信传输关键环节进行了优化。

从网络瓶颈到 DPU 异构加速的实践突破

随着数据中心计算向异构模式深度演进,网络通信的控制和数据调度变得日益复杂,DPU 作为中间衔接的桥梁必将大有可为。在过去开发和使用 Expert-Kit 推理框架的过程中,SeekExpert 团队发现将传统开发模式运用到该框架存在较大的性能瓶颈。具体来说,框架采用 Expert-Centric 架构,该架构专注于快速专家调度和专家异构计算,但实际运行时网络性能成为了关键的制约因素——具体表现为专家权重分发及中间结果传输过程中的数据拷贝开销会导致推理延迟增加,同时网络数据路径处理占用大量 CPU 资源,与专家计算形成资源竞争,直接影响系统整体吞吐量。

基于这个痛点,SeekExpert 团队意识到NVIDIA BlueField DPU恰好能破解这一难题,通过 DPU 专门处理网络传输任务的技术特性,既能实现权重分发的加速,又能释放 CPU 资源,从而使 CPU 专注专家计算的核心功能,这就是参赛项目的由来。

双管齐下:攻克技术选型与协同开发难题

在开发过程中,团队面临的两大底层技术挑战,一个是来自于技术选型的难题,另一个是与 CUDA 协同开发的复杂性。首先,团队需要全面理解 GPUNetIO、DMA、RDMA 等不同网络加速方案的适用场景,并判断哪个最符合团队专家权重分发的需求,其次需要实现 DOCA 与 CUDA 的深度集成,这涉及到 GPU 内存管理、数据流同步等底层细节,调试复杂度极高。

为攻克这些难题,团队采取了双管齐下的策略:一方面充分利用 NVIDIA 的技术资源,通过DOCA 官方文档中完善的 API 说明和示例代码来获取关键技术指引;另一方面,当遇到技术瓶颈时,团队成员会从各自的技术视角开展讨论,分析问题根源并提出针对性解决方案。

为 DPU 在大模型推理加速领域铺路

该项目创新性地将 NVIDIA DOCA GPUNetIO 技术与 MoE 模型推理加速相结合,通过 Expert-Kit 推理框架实现异构硬件资源的协同优化,让 DPU 专门处理网络密集型的专家权重分发和通信任务,使 CPU 得以专注于专家计算,从而在云计算、数据中心的 AI 推理平台中有效缓解集群时间维度(动态负载)与空间维度(不同设备协同)的资源利用率难题,为 DPU 在大模型推理加速领域提供了优化方向。

DOCA 开发者快问快答

Q

您是从哪里了解到 NVIDIA DPU 黑客松竞赛的?参赛的目标是什么?

A

我们是通过老师的介绍了解到这次 NVIDIA DPU 中国黑客松竞赛的。由于我们之前在研究异构设备共享内存时就接触过 DOCA 软件框架,当我们的 Expert-Kit 推理框架遇到网络传输优化瓶颈时,自然联想到了 DPU 可能存在的机会。

Q

赛前举办的 DPU 线上技术训练营对您的备赛起到哪些帮助?

A

训练营对 DPU 在各个领域的解决方案进行了引领性讲解,涵盖了安全、网络卸载等多个方向,让我们对 DOCA 开发有了更为全面的认识。

Q

参与 NVIDIA DPU 黑客松竞赛有哪些收获?

A

除了技术能力的提升,我们还结识了很多其他参赛队伍的队员,了解了他们在相关研究方向上的探索,这拓宽了我们的技术视野。同时,通过比赛我们也深入了解了 NVIDIA 在各行各业的技术探索和应用,对整个 AI 和硬件加速生态有了更全面的认识。

Q

本次竞赛有没有难忘或有趣的经历?

A

最印象深刻的是最后前往 NVIDIA 北京办公室参观,整个参观让我们深刻感受到了 NVIDIA 的快速发展轨迹,以及 NVIDIA 在各行各业所做出的技术贡献。

Q

您是从什么渠道了解到 NVIDIA DOCA 的?什么契机使你成为 DOCA 开发者?

A

我们最初是在研究异构设备的共享内存接触到的 NVIDIA DOCA。DPU 作为 CPU、GPU 和网络之间的数据通信所需的核心部件,能够让整个数据和控制拓扑变得简洁与清晰,也能够很好地承担起异构计算中的协调和加速角色。

Q

最初从事 DOCA 开发时,有具体明确的目标吗?

A

目标是通过让 DPU 承担网络处理、数据移动等任务,使得 CPU 能够专注于计算密集型工作,同时 DPU 通过高速互联 GPU 协同工作。

Q

过往有其他成功的 DOCA 开发经历吗?

A

在异构设备分布式共享内存项目开发中,我们利用 DPU 实现了跨地址空间的高效数据传递,这些相关经验帮助我们后续在 Expert-Kit 推理框架中应用 DOCA 技术奠定了基础。

Q

您对 DOCA 的评价如何呢?DOCA 中国开发者社区对你有哪些帮助?

A

DOCA 提供了一个编程框架,相关文档也很齐全,对 AI 生态,包括 CUDA 等也有很好的包容性。

开发者寄语

“大语言模型的推理需求推动数据中心向异构计算演进,CPU、GPU、XPU 等不同类型设备需要协同工作才能发挥最大效能。DPU 和 DOCA 技术正是连接这些异构设备的关键,通过智能卸载和资源调度,能提升数据中心的整体利用率。期待更多开发者加入 DOCA 社区,共同探索 DPU 在异构计算方面的可能性。”

——SeekExpert 团队

-

NVIDIA

+关注

关注

14文章

5513浏览量

109179 -

gpu

+关注

关注

28文章

5115浏览量

134541 -

模型

+关注

关注

1文章

3656浏览量

51790

原文标题:开发者故事 | 基于 DOCA GPUNetIO 的 MoE 模型推理加速实践

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

通过NVIDIA Jetson AGX Thor实现7倍生成式AI性能

NVIDIA TensorRT LLM 1.0推理框架正式上线

什么是AI模型的推理能力

使用NVIDIA NVLink Fusion技术提升AI推理性能

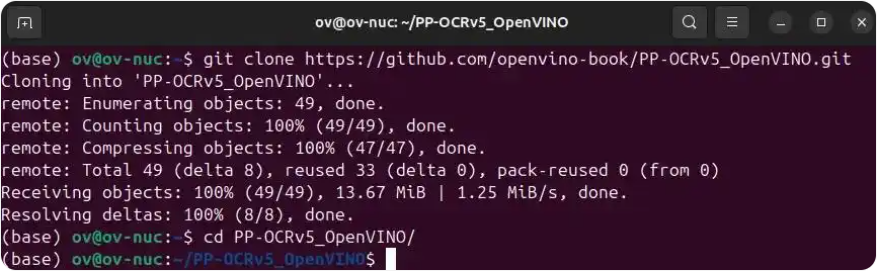

使用OpenVINO将PP-OCRv5模型部署在Intel显卡上

NVIDIA从云到边缘加速OpenAI gpt-oss模型部署,实现150万TPS推理

【「DeepSeek 核心技术揭秘」阅读体验】书籍介绍+第一章读后心得

NVIDIA DOCA 3.0版本的亮点解析

大模型推理显存和计算量估计方法研究

英伟达GTC25亮点:NVIDIA Dynamo开源库加速并扩展AI推理模型

NVIDIA Jetson Orin Nano开发者套件的新功能

利用Arm Kleidi技术实现PyTorch优化

利用NVIDIA DOCA GPUNetIO技术提升MoE模型推理性能

利用NVIDIA DOCA GPUNetIO技术提升MoE模型推理性能

评论