作者:英特尔创新大使刘力

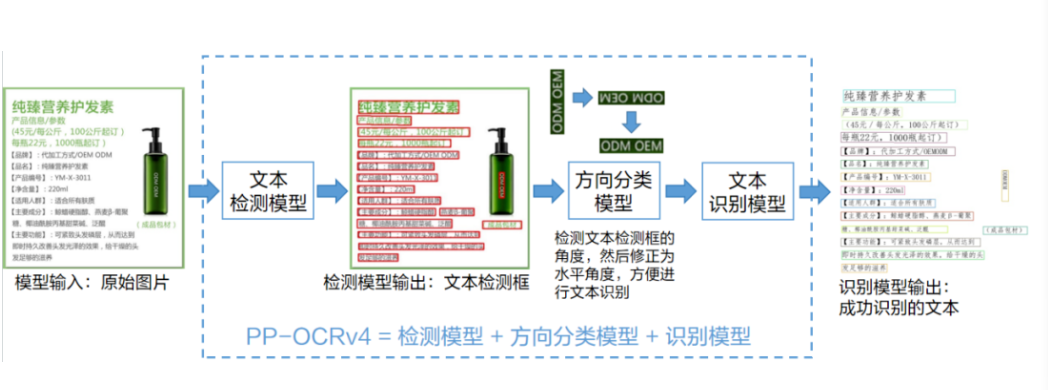

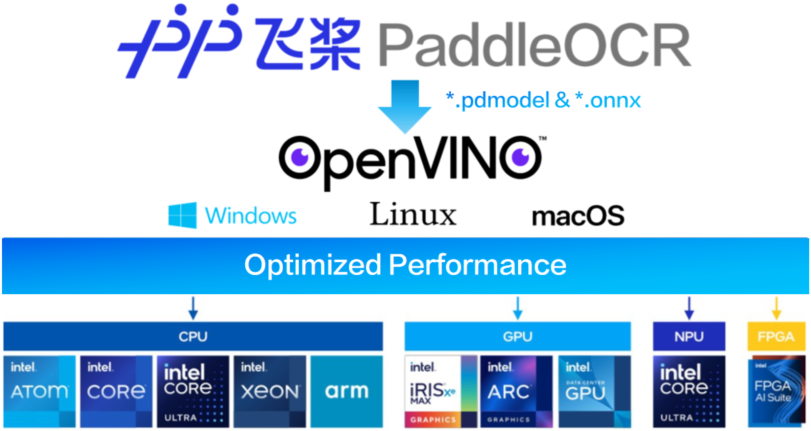

上文介绍了《一键搞定!PP-OCRv5模型转ONNX格式全攻略》,本文将使用OpenVINO™工具套件在Intel® CPU、独立显卡、集成显卡上优化并部署飞桨PP-OCRv5模型。

一,OpenVINO™工具套件简介

OpenVINO™工具套件

是一个用于优化和部署人工智能(AI)模型,提升AI推理性能的开源工具集合,不仅支持以卷积神经网络(CNN)为核心组件的预测式AI模型(Predictive AI),还支持以Transformer为核心组件的生成式AI模型(Generative AI)。

OpenVINO™工具套件支持直接读取并优化PaddlePaddle训练好的模型(*.pdmodel)或者ONNX格式模型(*.onnx),

提升其在英特尔® CPU、独立显卡、集成显卡、NPU等硬件上的AI推理计算性能。

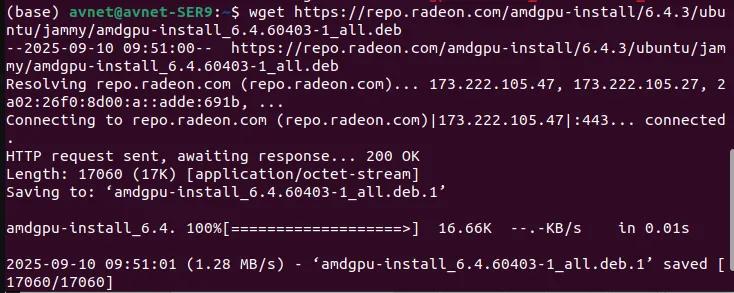

二,安装英特尔显卡驱动

参考链接:https://dgpu-docs.intel.com/driver/client/overview.html,在Ubuntu下完成英特尔显卡驱动安装。

三,搭建开发环境

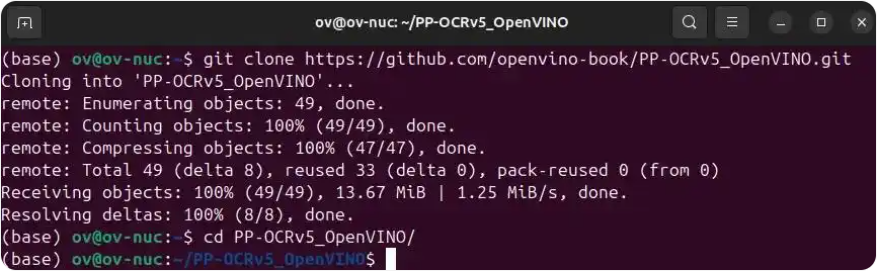

首先,请克隆PP-OCRv5_OpenVINO到本地:

git clone https://github.com/openvino-book/PP-OCRv5_OpenVINO.git cd PP-OCRv5_OpenVINO

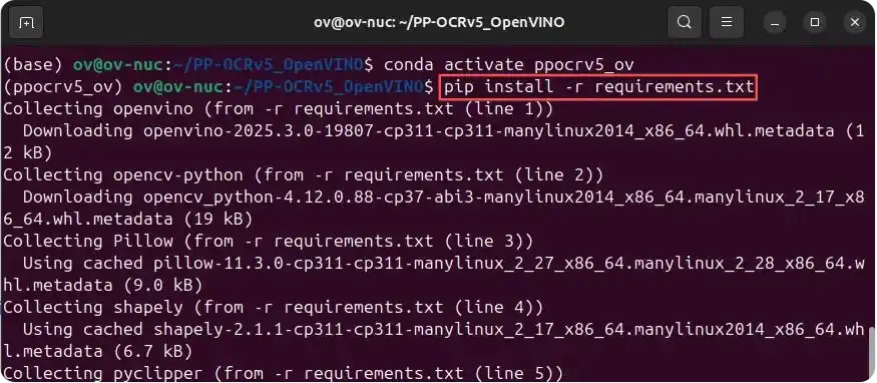

接着,创建并激活虚拟环境ppocrv5_ov,并安装所有依赖项。

conda create -n ppocrv5_ov python=3.11 conda activate ppocrv5_ov pip install -r requirements.txt

四,下载并导出PP-OCRv5 ONNX格式模型

请按《一键搞定!PP-OCRv5模型转ONNX格式全攻略》所示,下载并导出PP-OCRv5 ONNX格式模型到PP-OCRv5_OpenVINO文件夹。

五,编写PP-OCRv5推理程序

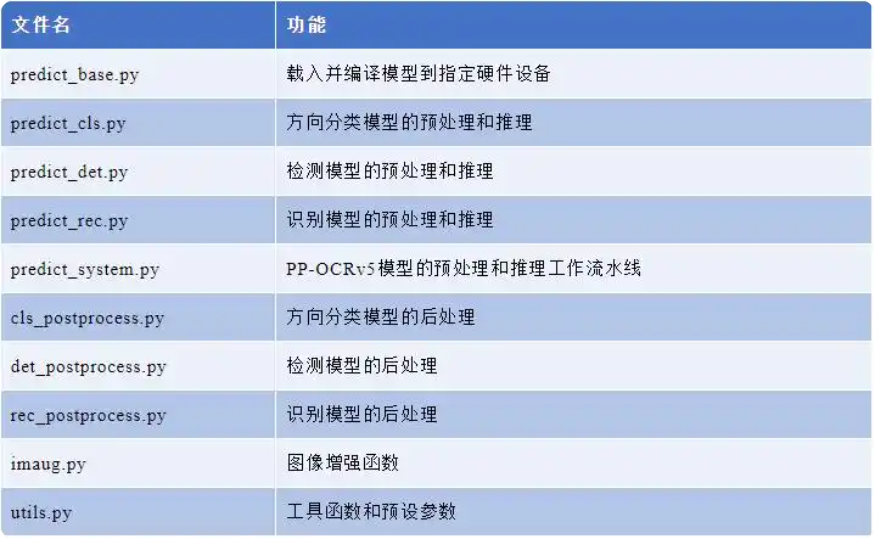

PP-OCRv5_OpenVINO项目已将推理程序编写完成,各文件功能如下:

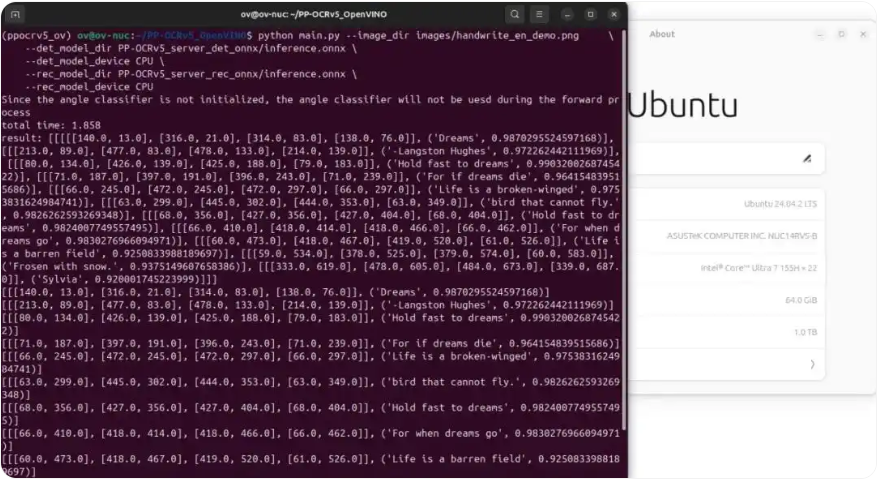

执行演示程序main.py,并指定模型路径和推理硬件设备:

python main.py --image_dir images/handwrite_en_demo.png --det_model_dir PP-OCRv5_server_det_onnx/inference.onnx --det_model_device CPU --rec_model_dir PP-OCRv5_server_rec_onnx/inference.onnx --rec_model_device CPU

运行结果,如下图所示:

六,总结

开发者可以通过OpenVINO™工具套件将PP-OCRv5模型部署到Intel的CPU、独立显卡或集成显卡上。

如果你有更好的文章,欢迎投稿!

稿件接收邮箱:nami.liu@pasuntech.com

更多精彩内容请关注“算力魔方®”!

-

英特尔

+关注

关注

61文章

10275浏览量

179247 -

显卡

+关注

关注

16文章

2517浏览量

71030 -

OpenVINO

+关注

关注

0文章

117浏览量

715

发布评论请先 登录

如何使用OpenVINO C++ API部署FastSAM模型

使用OpenVINO C# API轻松部署飞桨PP-OCRv4模型

如何在C#中部署飞桨PP-OCRv4模型

用ROCm部署PP-StructureV3到AMD GPU上

【EASY EAI Orin Nano开发板试用体验】PP-OCRV5文字识别实例搭建与移植

【大联大世平Intel®神经计算棒NCS2试用申请】在树莓派上联合调试Intel®神经计算棒NCS2部署OpenVINO

在Arm虚拟硬件上部署PP-PicoDet模型

使用OpenVINO™ 部署PaddleSeg模型库中的DeepLabV3+模型

在C++中使用OpenVINO工具包部署YOLOv5模型

一键搞定!PP-OCRv5模型转ONNX格式全攻略,解锁多平台无缝部署

使用OpenVINO将PP-OCRv5模型部署在Intel显卡上

使用OpenVINO将PP-OCRv5模型部署在Intel显卡上

评论