DeepSeek让各行业引入AI大模型的意识和积极性明显提高,已推动AI在政务、能源、制造等领域广泛铺展开来。

很多政企用户接入DeepSeek之后,感受到了AI大模型给业务带来了“旦用难回”的体验,很快就从试用的第一阶段,进入第二阶段——大模型推理集群的扩容升级。

当“有没有Deepseek用”不再成为问题,那么“Deepseek好不好用”的挑战就迎面而来。

一来,人多了,大量访问请求带来的高并发,就像春运高峰期涌入巨大的人流量,会出现请求积压,模型推理思考时间变长,token吞吐速度下降,用户的等待时延达到50-100毫秒,服务器繁忙和排队让人恼火。

二来,机器多了,增加更多服务器会遇到物理天花板,机器扩容并不会线性提升在线推理服务的体验,就像即使增加了更多车厢,但铁轨承载能力有限,也无法运送更多旅客(AI任务)了。

当行业智能化进入深度应用DeepSeek的第二阶段,不得不面临高并发推理的技术挑战。在堆算力的同时,也要同步优化性能体验,相当于想要运送更多乘客,不仅要增加车厢数量,还要同步改造轨道、站台和管理机制,将老式火车升级为高铁,才能综合提高运输效率。

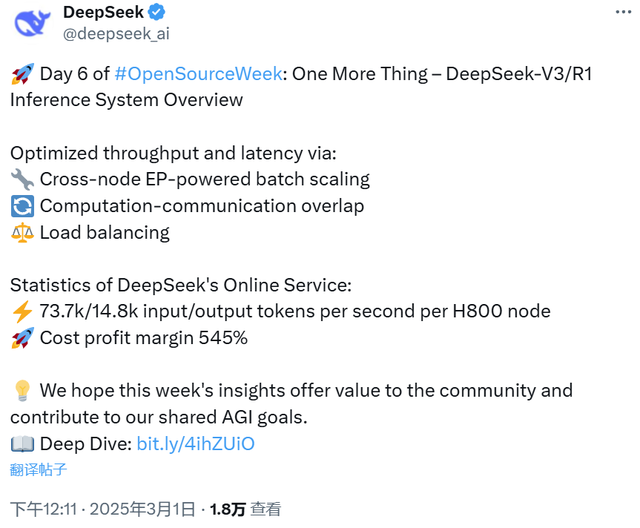

以DeepSeek为例,前不久公布了其利润率,高达545%,其中就涉及大量工程化能力,比如引入大EP推理集群,实现高并发推理吞吐量指数级增长。

对于更多行业和企业来说,没有DeepSeek那样的极客天才和顶尖技术团队,怎样用大EP来解决高并发推理挑战呢?当AI大模型开始进入千行万业的深水区,亟需一场大EP的“运力革命”。

很多政企客户在接入了Deepseek之后,使用量进一步增加,有了扩展推理集群规模的需求,推理资源需要从2台扩展到10台,从16卡扩展到千卡,但扩容升级并不是往机房一放、网络一连,就能高枕无忧了。

就像印度仍在使用的老式火车,仅靠增加车厢,还是无法提高运力,每个乘客能占用的火车空间极小,体验很差,火车不堪重负,延误晚点成了家常便饭。类似问题,在Deepseek和各种大模型与业务的结合中,高并发推理卡住了用户的体验瓶颈。

面对上述问题,大EP大规模专家并行的技术架构,成为趋势。

简单来说,大EP就是将MoE(混合专家)模型中数千个专家,分配到更多的卡(算力)上去。原本一张卡只能拉10个人,有了大EP,可以同时拉100个(高并发);原本只能跑一趟车,现在可以同时跑八趟车(提高专家计算路数batch size),那么乘客就不用长时间等待了。

所以,通过大EP可以提高高并发推理场景下的计算效率,实现更大的吞吐和更低的时延。用户体感上,比如一家银行的工作人员同时访问Deepseek,不会遇到排队、延迟、过长等待等情况。

大EP这么好,怎么才能部署到自己的一体机或推理资源池呢?不经过一番努力,确实很难吃到大EP的蛋糕。

一方面,推理场景的算力需求指数级扩展,而海外厂商的推理芯片如H20,虽然显存高,但算力不足,处理大EP场景时吞吐骤降。Deepseek公开的论文来看,仍然使用H800来进行推理。更强算力且供应链稳定的推理硬件,是大EP必不可少的。

另一方面,当请求总量猛增之后,会带来多种多样的负载,且极不均衡,相当于有的车厢坐的人多,有的车厢坐的人少,负载不均一样会导致体验不佳。

此外,大EP场景的All-to-All通信,导致卡间通信占比时间高,相当于每个车厢的专家都要通知到,这就会耽误进出站的效率。NVLink在大EP场景中,实际有效带宽利用率就不足。

由此可见,当行业使用Deepseek进入深水区,面对高并发推理场景,不能抱有“头疼医头脚疼医脚”的侥幸心理,而需要通盘思考和系统攻坚。

今天来看,各行各业拥抱Deepseek不是追逐一时风口,而是对智能化发展趋势的长期价值判断。普惠LLM进入千行万业,已经是大势所趋。

而大EP无法顺利被行业用起来,就意味着接入Deepseek始终存在时延高、体验差、成本难优化的问题,那么行业智能化也就无法顺利达成。

不过也不必过于担心,Deepseek、科大讯飞等模厂,与昇腾等算力厂商,以及政企行业用户,一直保持着紧密协作与沟通,自开年Deepseek热潮以来,从部署实践中沉淀了大量技术创新。

近期,昇腾推出了大EP解决方案,面向高并发推理场景,一站式升级为智能化“高铁”。

具体来说,昇腾大EP解决方案借助五大关键技术,与昇腾算力深度协同优化,成功突破了“专家负载均衡+通信优化”两大难题。

针对专家负载不均的难题:

昇腾大EP解决方案提出了MoE负载均衡技术,可以自动寻优,根据业务情况、集群规模,找到最优的专家,自动预测哪个专家更忙,自动配比,当一个专家负载过多时自动讲解,从而实现了备份节点和副本专家灵活可扩展、高可用和极致均衡,性能得到极大提升。

采用多种创新技术,做到自适应的autoPD分离部署。根据Prefill和Decode的动态负载,进行P、D实例的自动伸缩,无需人工介入,从而减少计算访存资源竞争。结合多级缓存内存资源池化,对冷热温数据进行区分,可以让系统的有效吞吐提升50%以上。

针对All-to-All通信优化的难题:

昇腾大EP解决方案提出了双流/多维混合并行,其中Prefill micro-batch双流并行,可以实现计算和通信的相互掩盖;MoE expert专家双流并行,实现两条数据流Stream的并行计算;Weight权重预取双流并行,可以把访存和通信并行起来,降低权重加载时间,提升效率。

MLA预处理阶段,昇腾大EP解决方案把大量的小算子,合成为大的融合算子,将计算耗时降低70%,让算力能力充分发挥出来。

如果你觉得上述技术创新多、不好记,那么只需要,借助昇腾大EP解决方案,行业应用Deepseek时,可以做到:

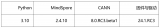

快。访问Deepseek无需等待。昇腾大EP可以将单卡并发提升3倍,Decode阶段响应速度稳定在50ms以内,支撑600+并发请求。

省。业务使用Deepseek上量之后,推理集群扩展的同时,性能也保持线性度,扩容综合成本更优。

正如高铁改变了中国人的出行,昇腾大EP为高并发推理铺设了一条“高速铁路”,改变了Deepseek上量扩容阶段的体验,为行业智能化提速增效。

仅用两个多月的时间,Deepseek就完成了从试用阶段到扩容阶段的进阶。高并发推理场景和大EP技术架构,成为应用Deepseek的新挑战。这也提醒我们,行业智能化是一个循序渐进的过程,不可能一蹴而就。

自主创新算力与国产模型如同高铁的双轨,成为支撑起智能中国的“新基建”。昇腾生态之所以与Deepseek等大模型更加适配,答案逐步清晰明确。

首先,昇腾有硬件,为行业智能化提供“永不沉降”的算力路基。昇腾硬件的FP16和INT8算力,可达到H20的2倍以上,且功耗更低,足以支撑各行业智能化的平稳前进。

此外,昇腾有软硬件的协同优化能力。随着行业智能化的不断深入,AI模型对算力需求不断扩张,但硬件的物理天花板和企业的投入产出比,都要求计算性能持续优化。昇腾的AI软硬件,提供从预训练到微调到强化学习,到推理集群、一体机,全流程全覆盖的方案,可以快速响应客户需求,高效支撑技术创新。目前,昇腾与DeepSeek最新技术已经实现了“day0”级别同步,确保企业智能化在昇腾软硬件基座上,始终行驶在技术最前沿。

更重要的是,昇腾有伙伴。行业智能化是一个体系化工程,不是单一硬件或软件厂商就能独自完成的。在自主创新算力生态中,昇腾一方面兼容主流生态与PyTorch等国内外框架,同时与ISV伙伴、各大模厂都保持着紧密共生与合作。这意味着,当行业用户基于昇腾底座开发AI应用,能得到生态的全方位助力,减少智能化升级的阻力,降低综合成本。

今天,智能化已经成为全球经济发展的主航道。在自主算力与国产模型所铸就的双轨上,行业智能化也将走深向远,向着智能时代飞驰。

审核编辑 黄宇

-

AI

+关注

关注

89文章

38171浏览量

296878 -

大模型

+关注

关注

2文章

3449浏览量

4974 -

DeepSeek

+关注

关注

2文章

824浏览量

2823

发布评论请先 登录

华为与全球开发者共赢昇腾生态

华为昇腾人工智能伙伴峰会成功举行

(原创)昇腾310B(8T/20T)算力主板定制方案

润和软件将持续深化“昇腾+DeepSeek”技术路线

聆思CSK6大模型语音开发板接入DeepSeek资料汇总(包含深度求索/火山引擎/硅基流动华为昇腾满血版)

昇腾推理服务器+DeepSeek大模型 技术培训在图为科技成功举办

研华发布昇腾AI Box及Deepseek R1模型部署流程

济南市中区存算一体化智算中心上线DeepSeek

DeepSeek V3昇思MindSpore版本上线开源社区

云轴科技ZStack智塔携手昇腾AI实现DeepSeek模型部署

华为推出昇腾DeepSeek大模型一体机

迅龙软件出席华为昇腾APN伙伴大会,获昇腾APN钻石伙伴授牌及两项大奖

Deepseek进入业务深水区,为什么需要昇腾大EP?

Deepseek进入业务深水区,为什么需要昇腾大EP?

评论