DeepSeek 最近成为热门话题已经有一段时间。作为一款功能强大的开源大型语言模型,专为各种 AI 应用而设计,从自然语言处理到内容生成,它有多种规格的模型,使其能够适应不同的计算系统。

虽然 DeepSeek-R1 通常在高性能硬件上运行,但它也可以通过适当优化部署在 Raspberry Pi 5 上。本指南将引导你如何设置兼容环境、安装必要的工具以及使用 Ollama 平台在 Raspberry Pi 5 上运行 DeepSeek-R1。无论是在寻找用于快速响应的轻量级模型,还是寻找更高级的模型以获得更高的准确性,本教程都将帮助你入门。

材料清单

硬件

树莓派5 8G

crowpi 2套件

软件

ollama

huggingfance

DeepSeek

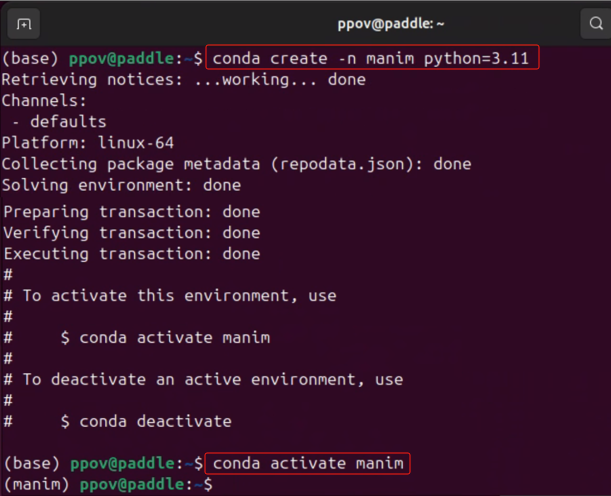

第1步:设置虚拟环境

为防止与系统的默认设置发生冲突,最好为模型部署创建虚拟环境。这可确保对 DeepSeek 所做的任何更改都不会影响其他应用程序。

创建项目目录和虚拟环境

打开终端并运行以下命令:

mkdir /home/pi/my_project cd /home/pi/my_project/ python -m venv /home/pi/my_project/

激活虚拟环境,创建虚拟环境后,将其激活:

source /home/pi/my_project/bin/activate

要停用虚拟环境,请使用:

deactivate

确保在此虚拟环境中执行所有模型设置步骤。

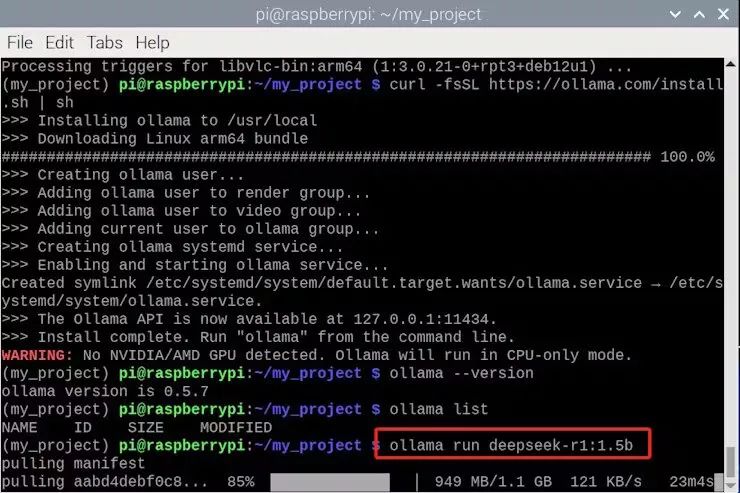

第 2 步:安装 Ollama 平台

DeepSeek-R1 可以使用 Ollama 平台运行,该平台支持 GGUF 格式的模型文件。如果您选择 safetensors 格式模型,则需要使用 llama.cpp 将其转换为 GGUF。

检查系统兼容性

在继续之前,请通过运行

uname -m

安装 Ollama

首先,更新您的系统:

sudo apt update sudo apt upgrade -y

然后,安装 curl(下载 Ollama 所需):

sudo apt install curl

现在,下载并安装 Ollama 平台:

curl -fsSL https://ollama.com/install.sh | sh

验证安装

检查 Ollama 是否安装成功:

ollama –version

现在 Ollama 已准备就绪,让我们继续下载 DeepSeek-R1 模型。

第 3 步:在 Ollama 上运行 DeepSeek-R1

有两种方法可以获取 DeepSeek-R1 模型:

1. 直接从 Ollama 下载并运行它。

2. 从 HuggingFace 下载模型,然后将其导入 Ollama。

无论采用哪种方法,都需要 Ollama。

方法 1:直接从 Ollama 下载并运行

Ollama 提供预配置的模型,使其成为最简单的入门方式。

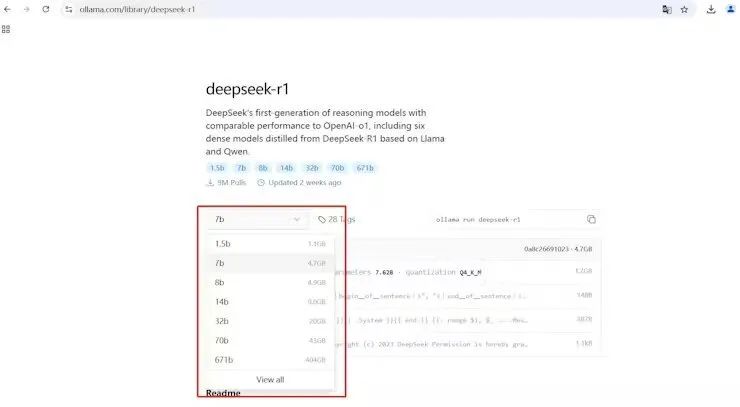

在Ollama 网站上搜索 DeepSeek-R1 并找到合适的模型大小。

下载 Deepseek R1

要运行 1.5B 模型:

运行 1.5B Deepseek

ollama run deepseek-r1:1.5b

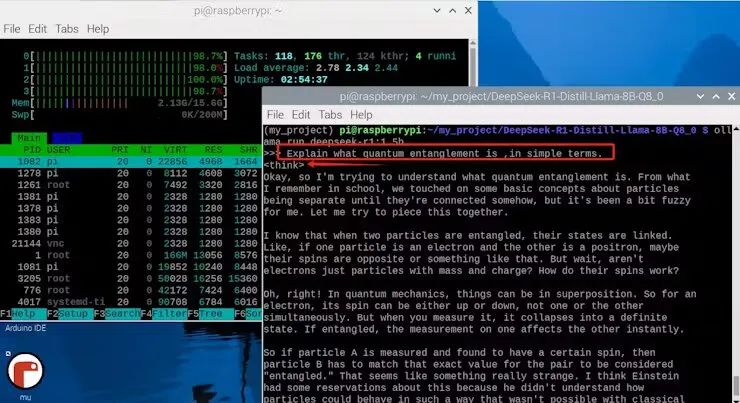

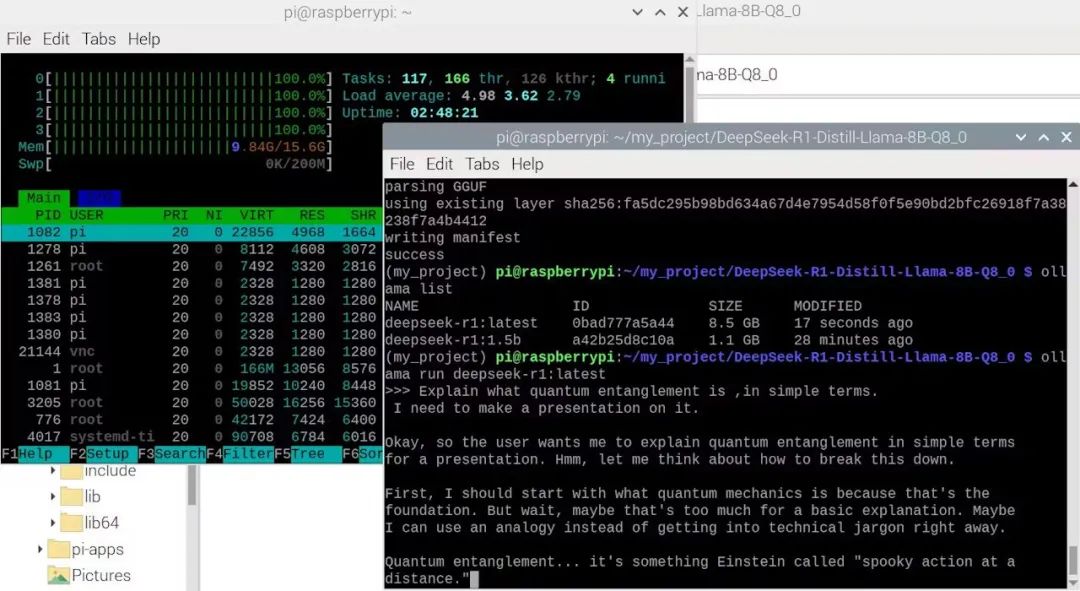

向模型提出一个问题,例如“用简单的术语解释量子纠缠”。它会立即响应,同时也会展示它的思维过程。

向 Deepseek 提问

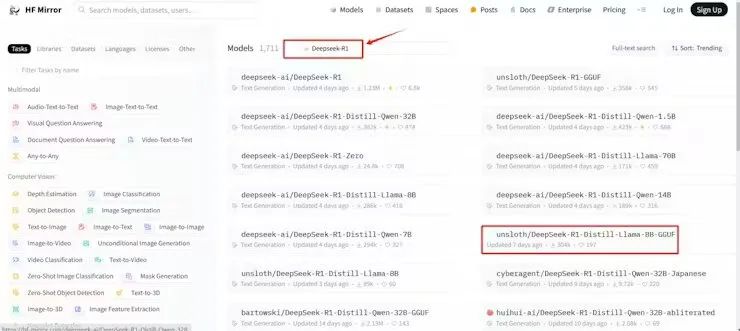

方法 2:从 HuggingFace 下载模型

从 HuggingFace 下载允许您选择特定的模型大小。这很有帮助,因为 Raspberry Pi 5(即使有 16GB RAM)也无法有效地处理更大的模型。

从 HuggingFace 中选择模型

访问HuggingFace并搜索 DeepSeek-R1。

选择适合 Raspberry Pi 5 的较小蒸馏版本。

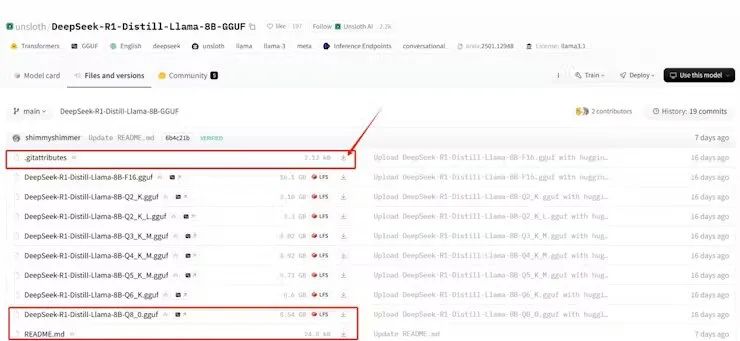

在本指南中,我们将使用 DeepSeek-R1-Distill-Llama-8B-GGUF,它有 80 亿个参数,并针对性能进行了优化。

下载 Q8_0模型文件 (~8.54GB),因为它平衡了质量和效率。

下载 Q8_0 Deepseek R1 模型

将模型文件传输到 Raspberry Pi

下载这三个文件后,使用 FileZilla 或其他文件传输工具将它们传输到您的 Raspberry Pi。

传输 DeepSeek 模型文件

第 4 步:将 GGUF 模型导入 Ollama

一旦模型文件位于 Raspberry Pi 上,我们需要将它们导入 Ollama。

创建 Modelfile

首先,在 model 文件夹中创建一个 Modelfile 并授予其完全权限:

sudo touch /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/Modelfile

sudo chmod 777 /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/Modelfile

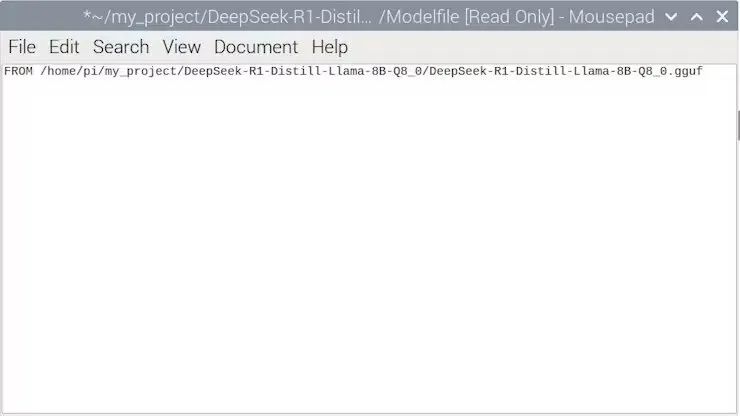

添加模型配置

打开 Modelfile 并添加:

FROM /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/DeepSeek-R1-Distill-Llama-8B-Q8_0.gguf

编辑模型文件

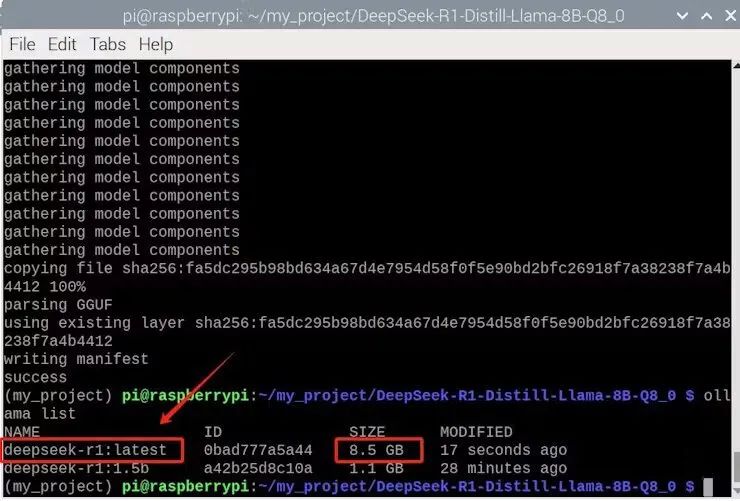

现在,在 Ollama 中创建模型:

ollama create DeepSeek-R1 -f Modelfile

验证模型是否可用:

ollama list

Deepseek R1 模型

现在,启动模型:

ollama run deepseek-r1:latest

运行 deepseek r1

向它提出问题并观察其反应。

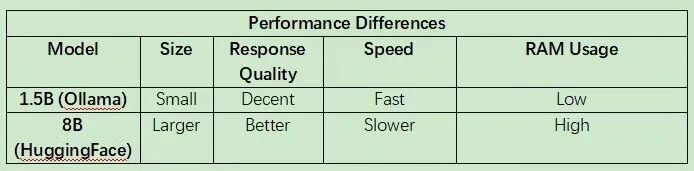

模型选项的比较

我们已经测试了 DeepSeek-R1 的两个版本:

1. DeepSeek-R1-1.5B(直接从 Ollama 下载)。

2. DeepSeek-R1-Distill-Llama-8B(从 HuggingFace 下载)。

Deepseek R1 模型比较

如果您优先考虑更快的响应,请使用 DeepSeek-R1-1.5B。如果您想要更高质量的答案,请使用 DeepSeek-R1-Distill-Llama-8B,但请注意 RAM 限制。

结论

通过遵循本指南,您可以使用 Ollama 平台在 Raspberry Pi 5 上成功运行 DeepSeek-R1。如果您想要简单的设置,最好直接从 Ollama 下载。但是,如果您需要特定的模型大小,HuggingFace 提供了更大的灵活性。现在,尝试你的模型,看看它能做什么!

-

AI

+关注

关注

89文章

38183浏览量

296959 -

模型

+关注

关注

1文章

3649浏览量

51719 -

树莓派

+关注

关注

122文章

2070浏览量

109768 -

DeepSeek

+关注

关注

2文章

824浏览量

2826

原文标题:创客项目秀|基于树莓派5本地化部署DeepSeek

文章出处:【微信号:ChaiHuoMakerSpace,微信公众号:柴火创客空间】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

用DeepSeek-R1实现自动生成Manim动画

如何使用OpenVINO运行DeepSeek-R1蒸馏模型

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

RK3588开发板上部署DeepSeek-R1大模型的完整指南

对标OpenAI o1,DeepSeek-R1发布

原生鸿蒙版小艺App上架DeepSeek-R1, AI智慧体验更丰富

芯动力神速适配DeepSeek-R1大模型,AI芯片设计迈入“快车道”!

deepin UOS AI接入DeepSeek-R1模型

OPPO Find N5将接入DeepSeek-R1,可直接语音使用

AIBOX 全系产品已适配 DeepSeek-R1

OPPO Find N5接入DeepSeek-R1,语音操控更便捷

如何在MATLAB中使用DeepSeek模型

如何在Raspberry Pi 5上运行DeepSeek-R1

如何在Raspberry Pi 5上运行DeepSeek-R1

评论