导读:没有足够的高性能GPU数量,或者性能欠佳,都将造成AI推理和模型训练的准确度不足,即使有类似的对话机器人, 它的“智商”也会远低于ChatGPT

国内云厂商高性能GPU芯片的短缺,正在成为限制生成式AI在中国诞生的最直接因素。

2022年12月,微软投资的AI创业公司OpenAI推出了聊天机器人ChatGPT。这是生成式人工智能在文本领域的实际应用。所谓生成式AI,是指依靠AI大模型和AI算力训练来生成内容。ChatGPT的本质是OpenAI自主研发的GPT-3.5语言大模型。大型模型包含近 1800 亿个参数。

微软的 Azure 云服务为 ChatGPT 构建了超过 10,000 个 Nvidia A100 GPU 芯片的 AI 计算集群。

美国市场研究公司TrendForce在3月1日的一份报告中计算得出,要处理1800亿参数的GPT-3.5大型模型,需要的GPU芯片数量高达2万颗。未来GPT大模型商业化所需的GPU芯片数量甚至会超过3万颗。此前在 2022 年 11 月,英伟达在其官网的公告中提到,数万颗 A100/H100 高性能芯片部署在微软 Azure 上。这是第一个使用 NVIDIA 高端 GPU 构建的大规模 AI 计算集群。

鉴于英伟达在高性能GPU方面的技术领先地位,国内云计算专业人士普遍认为,10000颗英伟达A100芯片是一个好的AI模型的算力门槛。

目前国内云厂商拥有的GPU主要是英伟达的中低端性能产品(如英伟达A10)。拥有超过 10,000 个 GPU 的公司不超过 5 家,而拥有 10,000 个 Nvidia A100 芯片的公司最多只有一家。也就是说,单从算力来看,短期内能够部署ChatGPT的国内玩家非常有限。

聊天GPT看似只是一个聊天机器人,但这却是微软AI算力、AI大模型和生成AI在云计算的实力展示。在企业市场,这是云计算新一轮的增长点。Microsoft Azure ML(深度学习服务)拥有 200 多家客户,其中包括制药公司拜耳和审计公司毕马威。Azure ML 连续四个季度收入增长超过 100%。这是微软云三大业务中增长最快的板块,即云、软件、AI。

今年2月,包括阿里巴巴和百度在内的中国企业宣布将开发类似ChatGPT的产品,或将投资研发生成式人工智能。在国内,AI算力、AI大模型、生成式AI被认为只有云厂商才有资格。华为、阿里、腾讯、字节跳动、百度都有云业务,理论上都有跑通AI算力、AI大模型、生成AI应用的能力。

但是有能力不代表可以跑到终点线。这需要长期的高成本投资。GPU芯片的价格是公开的,算力成本也很容易衡量。大型模型需要数据收集、手动标记和模型训练。这些软成本很难简单计算。生成式人工智能的投资规模通常高达数百亿。

多位云计算厂商和服务器厂商的技术人员表示,高性能GPU芯片短缺,硬件采购成本和运营成本高,国内市场短期商用困难。这三个问题才是真正的挑战。在他们看来,有资本储备、战略意愿和实践能力的公司不会超过3家。

GPU芯片数量决定了“智商”

决定AI大模型“智商”的核心因素有三个,计算能力的规模、算法模型的复杂程度、数据的质量和数量。

AI大模型的推理和训练高度依赖英伟达的GPU芯片。缺少芯片会导致算力不足。计算能力不足意味着无法处理庞大的模型和数据量。最终的结果是AI应用存在智商差距。

3月5日,十四届全国人大一次会议开幕式后,科技部部长王志刚在全国两会“部长通道”在接受媒体采访时表示,ChatGPT作为大模型,将大数据、大算力、强算法有效结合。其计算方法有所改进,特别是在保证算法的实时性和算法质量的有效性方面。“就像发动机一样,每个人都可以造发动机,只是质量不一样。踢球就是运球和射门,但要做到像梅西那么好并不容易。”

Nvidia是全球知名的半导体厂商,占据了数据中心GPU市场90%以上的份额。英伟达A100芯片在2020年推出,致力于自动驾驶、高端制造、医疗医药行业等AI推理或训练场景。2022年,英伟达推出了性能更强的新一代产品——H100。A100/H100是目前最强大的数据中心专用GPU,市场上几乎没有可扩展的替代品。包括特斯拉、Facebook在内的企业已经使用A100芯片搭建AI计算集群,采购规模超过7000颗。

多位云计算技术人员告诉记者,运行ChatGPT至少需要1万颗英伟达A100芯片。但是,拥有超过10,000颗GPU芯片的公司不超过5家。其中,最多只有一家公司拥有 10,000 个 Nvidia A100 GPU。

另一位大型服务器厂商人士表示,即使乐观估计,GPU储备最大的公司也不超过5万片,并以来自英伟达的中低端数据中心芯片(如英伟达A10) ) 为主。这些GPU芯片分散在不同的数据中心,一个数据中心通常只配备数千颗GPU芯片。

此外,由于去年8月美国政府开始实施贸易限制,中国企业长期无法获得NVIDIA A100芯片。现有A100芯片储备全部为存货,剩余使用寿命约4-6年。

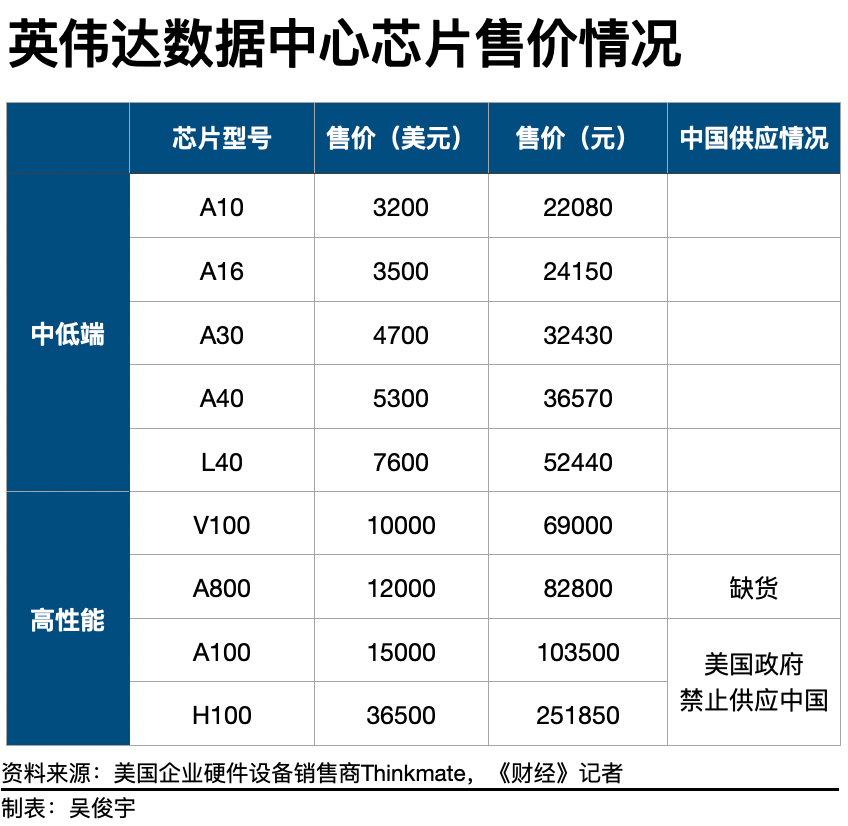

2022年8月31日,英伟达和AMD两家半导体公司生产的GPU产品被美国纳入限制范围。Nvidia 的受限产品包括 A100 和 H100,AMD受监管的 GPU 产品包括 MI250。根据美国政府的要求,未来峰值性能等于或超过A100的GPU产品也被限制销售。

中国企业目前可以获得的最佳替代品是英伟达的A800芯片。A800被认为是A100的“阉割版”。2022年8月,在A100被禁止在中国市场销售后,英伟达在当年第三季度推出了专供中国市场使用的A800芯片。这款产品的计算性能与A100基本持平,但数据传输速度降低了30%。这会直接影响AI集群的训练速度和效果。

不过目前A800芯片在中国市场严重缺货。虽然是A100的“阉割版”,但A800在京东官网的售价却超过了8万元/件,甚至超过了A100的官方售价(1万美元/件)。即便如此,A800在京东官网依然处于断货状态。

一位云厂商人士告诉记者,A800的实际售价甚至高于10万元/片,而且价格还在上涨。A800目前在浪潮、新华三等国内服务器厂商手中属于稀缺产品,一次只能采购数百枚。

GPU 数量或性能不足直接导致 AI 推理和模型训练的准确性不足。其结致使中国企业做出类似的对话机器人,机器人的“智商”也会远低于ChatGPT。国内云厂商高性能GPU芯片的短缺,正成为限制中国版ChatGPT诞生的最直接因素。

成本高企

AI算力和大模型是比云还烧钱的吞金猛兽。

即使有足够的高性能GPU,中国云厂商也将面临高昂的硬件采购成本、模型训练成本和日常运营成本。面对以上成本,有资本储备、战略选择和实际能力的企业不超过3家。

OpenAI 可以做 ChatGPT,背后微软提供资金和算力。2019 年,微软向 OpenAI 投资了 10 亿美元。2021年,微软又进行一轮新投资,金额不详。今年 1 月,微软宣布未来几年将向 OpenAI 投资 100 亿美元。

对于云厂商来说,AI算力和大模型需要面临高昂的硬件采购成本、模型训练成本和日常运营成本。

一是硬件采购成本和智能计算集群建设成本。如果以10000颗英伟达A800 GPU为标配打造智能算力集群,以10万元/颗的价格计算,光是GPU的采购成本就高达10亿元。一台服务器通常需要4-8颗GPU,一台搭载A800的服务器成本超过40万元。国产服务器均价在4万-5万元。GPU服务器的成本是普通服务器的10倍以上。服务器采购成本通常占数据中心建设成本的30%,一个智能计算集群的建设成本超过30亿元。

第二,模型训练的成本。如果算法模型要足够准确,则需要进行多轮算法模型训练。一家外资云厂商的资深技术人员告诉记者,ChatGPT一个完整的模型训练成本超过1200万美元(约合人民币8000万元)。如果进行10次完整的模型训练,成本将高达8亿元。GPU芯片的价格是公开的,算力成本相对容易衡量。但是,大型AI模型还需要进行数据采集、人工标注、模型训练等一系列工作。这些软成本很难简单计算。具有不同效果的模型具有不同的最终成本。

第三,日常运营成本。数据中心的模型训练会消耗网络带宽和电力资源。此外,模型训练还需要算法工程师负责调优。上述成本也以数十亿美元计算。

也就是说,进入AI算力和AI规模化赛道,前期的硬件采购和集群建设成本高达数十亿元。后期的模型训练、日常运营、产品研发等成本也高达数十亿元。某管理咨询公司的技术战略合作伙伴告诉记者,生成人工智能的投资规模高达百亿。

微软大规模采购GPU构建智能计算集群,在业务逻辑上是可行的。2022年,微软在云计算基础设施上的支出超过250亿美元。当年微软的营业利润达到828亿美元,而微软的云营业利润超过400亿美元。微软的云盈利超过支出,在AI算力和大规模模型业务上的大规模投入与微软的财务状况相匹配。

微软AI计算有产品、有客户、有收入,形成新的增长点。微软客户通常会在云上租用数千个高性能 GPU 进行语言模型学习,以此使用他们自己的生成 AI。

微软拥有 Azure ML 和 OpenAI。Azure ML 有 200 多家客户,包括制药公司拜耳和审计公司毕马威。Azure ML 连续四个季度收入增长超过 100%。微软云甚至形成了“云-企业软件-AI计算”三个旋转的增长曲线。其中,公有云Azure营收增速约为30%-40%,软件业务营收增速约为50%-60%,AI算力营收增速超过100%。

中国企业对云基础设施的资本支出有限,投资智能计算集群和AI大模型需要分流有限的预算支出。更大的挑战不仅是中短期内无法盈利,还会亏损更多。

科技公司的资本支出通常用于购买服务器、建设数据中心、购买园区用地等固定资产。以亚马逊为例,2022年的资本支出为580亿美元,其中超过50%用于投资云基础设施。阿里、腾讯、百度最近一个财年的资本支出情况,发现3家公司的数据分别为533亿元、622亿元、112亿元。

三家公司均未披露投资云基础设施的资本支出。假设这3家公司和亚马逊一样,50%的资本支出用于投资云基础设施,数据分别为266亿元、311亿元、56亿元。资本支出充裕的公司投资数十亿美元能负担得起,但对于资本支出不足的企业来说是一种负担。

国内已经宣布建设智能计算集群的企业有阿里云、华为、百度等,但智能计算集群的GPU芯片数量未知。2022年,各大云厂商都把增加毛利、减少亏损作为战略重点。现阶段购买高性能GPU和构建智能计算集群需要巨大的投资。不仅会加重损失,还需要依靠群体输血。这考验企业管理层的战略意志。

大模型高昂,先做小模型

华为、阿里、腾讯、字节跳动、百度都有云服务,理论上有中国版ChatGPT的实力。

云计算业内人士指出,几家有能力的公司也会有实际的战略考虑。比如腾讯、百度、字节跳动有云,数据量也很大,但云业务亏损,长期资金储备和战略意志存疑。华为依靠自研升腾芯片建立了大模型技术,但受“断供”影响,无法获得英伟达的GPU芯片,作为硬件厂商,缺乏互联网公司的数据积累。

由于以上限制,目前能够实现AI大模型商业化的公司寥寥无几。到最后,同时具备资本储备、战略意志和实践能力的企业将屈指可数。

目前,没有一家中国云厂商像微软那样拥有数万颗A100/H100芯片。目前中国云厂商的高性能GPU算力不足。更务实的观点是,即使中国云厂商真的获得了10000颗NVIDIA高性能GPU,也不应该简单地投入中国版ChatGPT这一热门应用场景。

在算力资源紧缺的情况下,可以优先投资行业市场,为企业客户提供服务。一位管理咨询公司的技术战略合作伙伴认为,ChatGPT只是一个对话机器人,商业应用场景的展示暂时有限。用户规模越大,成本越高,损失越大。如何在细分领域将AI算力和大模型商业化,是获得正现金流的关键。

中国市场AI算力规模化商业模式仍处于起步阶段。目前,国内已有少量自动驾驶、金融等领域客户开始使用AI算力。例如,小鹏汽车目前使用阿里云的智能计算中心进行自动驾驶模型训练。

一位数据中心产品经理认为,国内银行金融客户在反欺诈中大量使用模型训练技术,通常只需要租用数百个性能较低的GPU训练模型即可。也是AI计算和模型训练,是一种成本更低的方案。事实上,通用的大规模模型并不能解决特定行业的问题,金融、汽车、消费等各个领域都需要行业模型。

中国没有足够的高性能 GPU 来进行大规模 AI 模型训练,所以可以先在细分领域做小模型。人工智能技术的飞速发展已经超出了人们的认知。对于中国企业来说,根本之道还是要坚持持续布局从而达成战略性发力。

审核编辑 :李倩

-

芯片

+关注

关注

462文章

53608浏览量

460006 -

云计算

+关注

关注

39文章

8004浏览量

143295 -

ChatGPT

+关注

关注

31文章

1596浏览量

10115

原文标题:ChatGPT算力成本巨大,成为云厂商的一大门槛,大厂如何选择

文章出处:【微信号:WW_CGQJS,微信公众号:传感器技术】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

大模型应用成本与门槛成CES Asia 2025论坛热议焦点

云 GPU 加速计算:突破传统算力瓶颈的利刃

autodl算力云在.pt转换onnx文件时正常,但onnx转.kmodel文件时报错,为什么?

聚焦“一度算力”,九章云极DataCanvas公司推进算力标准化建设

ChatGPT算力成本巨大,成为云厂商的一大门槛,大厂如何选择

ChatGPT算力成本巨大,成为云厂商的一大门槛,大厂如何选择

评论