AMD发布了7nm CDNA架构的MI100加速卡,NVIDIA这边就推出了A100 80GB加速卡。虽然AMD把性能夺回去了,但是A100 80GB的HBM2e显存也是史无前例了。NVIDIA今年3月份发布了安培架构的A100加速卡(名字中没有Tesla了),升级了7nm工艺和Ampere安培架构,集成542亿晶体管,826mm2核心面积,使用了40GB HBM2显存,带宽1.6TB/s。

现在的A100 80GB加速卡在GPU芯片上没变化,依然是A100核心,6912个CUDA核心,加速频率1.41GHz,FP32性能19.5TFLOPS,FP64性能9.7TFLOPS,INT8性能624TOPS,TDP 400W。

变化的主要是显存,之前是40GB,HBM2规格的,带宽1.6TB/s,现在升级到了80GB,显存类型也变成了更先进的HBM2e,频率从2.4Gbps提升到3.2Gbps,使得带宽从1.6TB/s提升到2TB/s。

对游戏卡来说,这样的显存容量肯定是浪费了,但是在高性能计算、AI等领域,显存很容易成为瓶颈,所以翻倍到80GB之后,A100 80GB显卡可以提供更高的性能,NVIDIA官方信息称它的性能少则提升25%,多则提升200%,特别是在AI训练中,同时能效也提升了25%。

在A100 80GB加速卡发布之后,现在的A100 40GB版依然会继续销售。

责任编辑:haq

-

amd

+关注

关注

25文章

5650浏览量

139056 -

NVIDIA

+关注

关注

14文章

5496浏览量

109117

发布评论请先 登录

利用NVIDIA Cosmos开放世界基础模型加速物理AI开发

算力密度翻倍!江原D20加速卡发布,一卡双芯重构AI推理标杆

芯无址境 进阶启新——江原科技D20加速卡发布暨总部乔迁庆典圆满落幕

新手小白必看!关于A100云主机租用,你想知道的一切都在这!

虚拟电厂加速卡不是噱头!万点规模VPP的性能分水岭

新品 | LLM-8850 Card, AX8850边缘设备AI加速卡

25W 功耗稳跑 104TOPS!H2 加速卡:让智能医疗设备的 AI 分析 “快又稳”

智算加速卡是什么东西?它真能在AI战场上干掉GPU和TPU!

边缘AI运算革新 DeepX DX-M1 AI加速卡结合Rockchip RK3588多路物体检测解决方案

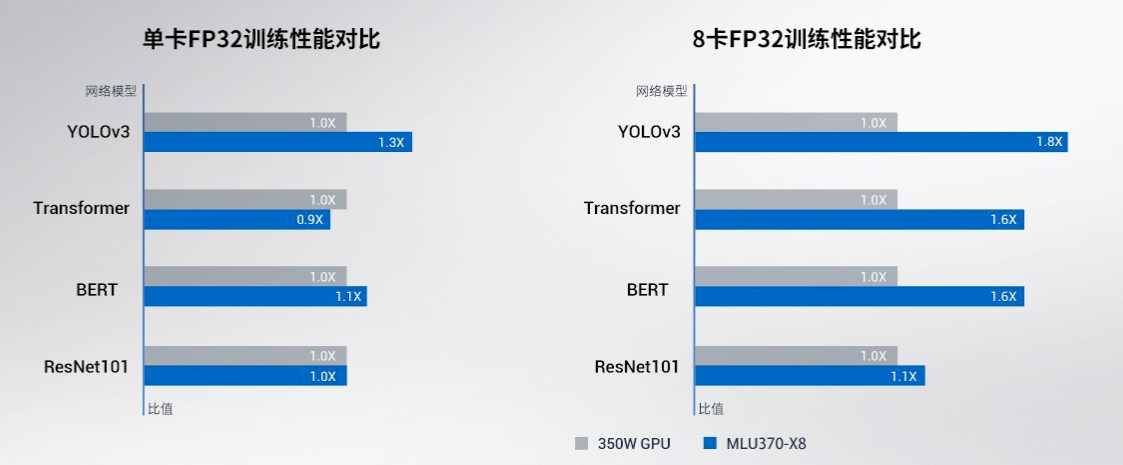

寒武纪基于思元370芯片的MLU370-X8 智能加速卡产品手册详解

边缘AI新突破:MemryX AI加速卡与RK3588打造高效多路物体检测方案

英伟达A100和H100比较

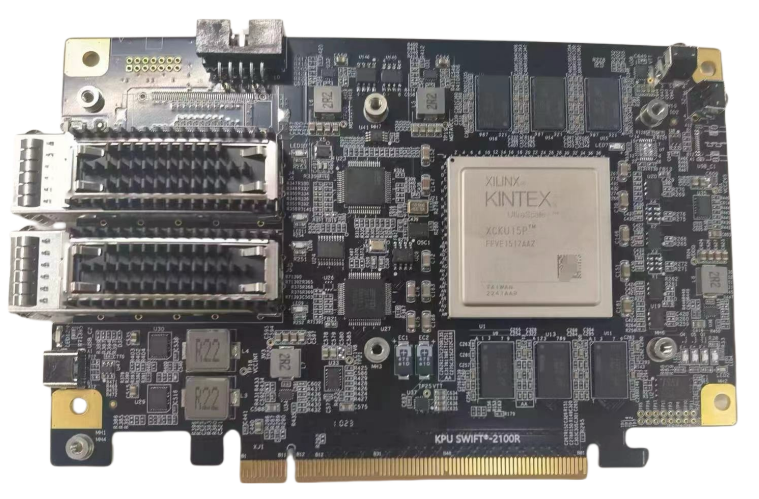

南京芯麒电子-基于KU15P的双路100G光纤加速卡

NVIDIA发布A100 80GB加速卡

NVIDIA发布A100 80GB加速卡

评论