随着物理 AI 系统的不断发展,对丰富标记数据集的需求正在急速增长,已经超出了在现实世界中通过人工采集所能满足的范围。世界基础模型(WFMs)是经过训练的生成式 AI 模型,能够根据现实世界环境的动态,对未来的世界状态进行仿真、预测和推理,这类模型有望帮助突破这一数据难题。

NVIDIA Cosmos是面向机器人及智能汽车等物理 AI 系统的世界基础模型开发平台。Cosmos 世界基础模型包含三种可针对特定应用进行后训练的模型类型:Cosmos Predict、Cosmos Transfer和Cosmos Reason。

Cosmos Predict 可根据图像、视频和文本提示生成关于“未来世界状态”的视频。Cosmos Transfer 使开发者能够根据 2D 输入和文本提示实现逼真的风格转换。Cosmos Reason 作为视觉语言推理模型,可以对生成的数据进行筛选和标注,也可以通过后训练,转化为机器人视觉-语言-动作(VLA)模型。这些生成数据可用于训练物理 AI 和工业视觉 AI,使其具备空间感知理解、运动轨迹规划以及执行复杂任务的能力。

本期 NVIDIA 机器人研究与开发摘要(R²D²)探讨了 NVIDIA 研究中心推出的 Cosmos 世界基础模型及工作流。本文将深入探讨以下模型在物理 AI 应用的合成数据生成(SDG)与数据管理过程中发挥的关键作用:

1. Cosmos Predict:

适用于辅助驾驶的 Single2MultiView

Cosmos-Drive-Dreams

NVIDIA Isaac GR00T-Dreams

DiffusionRenderder

加速视频生成

2. Cosmos Transfer:

适用于辅助驾驶的 Cosmos Transfer

边缘模型蒸馏

3. Cosmos Reason

Cosmos Predict:

NVIDIA 研究中心为机器人打造的未来仿真模型

Cosmos Predict 模型可以针对机器人和智能汽车等物理 AI 应用进行后训练。该模型以文本、图像或视频的形式输入,并生成连贯且物理准确的未来帧。这项技术显著加速了合成数据生成(SDG)的进程,为后训练 AI 模型执行复杂物理任务提供支持。下面分享后训练的应用实例。

Single2MultiView

适用于辅助驾驶的 Single2MultiView,经过 Cosmos Predict 模型的后训练,可从单一的前视辅助驾驶视频生成多个连贯的摄像头视角。该系统可为辅助驾驶开发提供同步的多视角摄像头影像数据。

单视角输入视频的推理示例:

CUDA_HOME=$CONDA_PREFIXPYTHONPATH=$(pwd) python cosmos_predict1/diffusion/inference/video2world_view_extend_multiview.py --checkpoint_dir checkpoints --diffusion_transformer_dir Cosmos-Predict1-7B-Video2World-Sample-AV-Single2MultiView/t2w_model.pt --view_condition_video assets/diffusion/sv2mv_input_view.mp4 --num_input_frames 1 --condition_location"first_cam" --prompt"${PROMPT}" --prompt_left"${PROMPT_LEFT}" --prompt_right"${PROMPT_RIGHT}" --prompt_back"${PROMPT_BACK}" --prompt_back_left"${PROMPT_BACK_LEFT}" --prompt_back_right"${PROMPT_BACK_RIGHT}" --video_save_name diffusion-single2multiview-text2world

Cosmos-Drive-Dreams

Cosmos-Drive-Dreams 为辅助驾驶生成复杂驾驶场景的工作流。Cosmos Drive 模型经过驾驶领域的后训练,可生成多视图、高保真、时空一致的驾驶数据。使用经过后训练的 Cosmos Transfer 模型对生成的多视角数据进行增强,以提高在低能见度条件下的泛化能力(如雾天、雨天),从而完成 3D 车道检测、3D 物体检测和驾驶策略学习等任务。

Isaac GR00T-Dreams

基于 DreamGen 的 Isaac GR00T-Dreams,是用于生成大规模人形机器人合成轨迹数据的蓝图,实现了从真实数据到真实数据的完整工作流。该架构使用 Cosmos Predict 技术,通过图像和文本提示生成多样化、逼真的机器人任务执行视频,并从中提取被称为“神经轨迹”的动作数据用于机器人策略训练。这种方法能够帮助机器人在最少人类参与的情况下学习新技能并适应不同环境。

在 GR1 数据集上对 GR00T 模型进行后训练的示例如下:

EXP=predict2_video2world_training_2b_groot_gr1_480

torchrun--nproc_per_node=8--master_port=12341-m scripts.train --config=cosmos_predict2/configs/base/config.py -- experiment=${EXP}

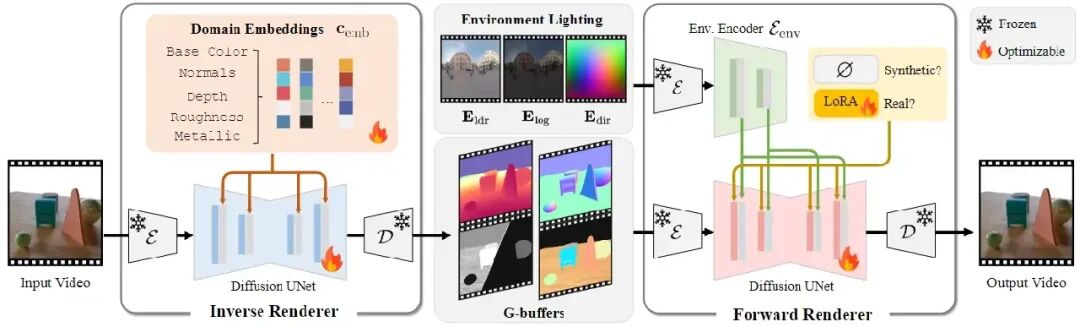

DiffusionRenderer

DiffusionRenderer 是一款神经渲染框架,仅需单段视频输入,无需依赖显式的 3D 几何结构或光照数据,就能实现逼真的重新打光、材质编辑与物体植入功能。该框架借助视频扩散模型估算场景属性,进而生成真实感极强的新图像。引入 Cosmos Predict 的扩散模型后,DiffusionRenderer 的光照处理能力得到显著提升,能够输出精度更高、时间维度上更连贯的渲染结果。这一技术对物理 AI 仿真具有重要价值,能够使场景编辑具备更高的效率与可控性。

图 . DiffusionRenderer 方法概述

以下是视频重新打光的示例命令。该命令通过逆向渲染器对帧序列应用新光照,并生成重新打光后的视频帧:

CUDA_HOME=$CONDA_PREFIX PYTHONPATH=$(pwd) python cosmos_predict1/diffusion/inference/inference_forward_renderer.py --checkpoint_dir checkpoints --diffusion_transformer_dir Diffusion_Renderer_Forward_Cosmos_7B --dataset_path=asset/example_results/video_delighting/gbuffer_frames --num_video_frames 57 --envlight_ind 0123 --use_custom_envmap=True --video_save_folder=asset/example_results/video_relighting/

加速视频生成

加速视频生成模型 Cosmos-Predict2 现在通过邻域注意力机制(NATTEN),提高了对相关视频区域的聚焦能力。该注意力系统具有层级自适应性,可动态平衡全局和局部上下文,以实现速度和质量的最佳平衡。通过在模型层中实现稀疏注意力,可以最大限度地减少视频生成过程中的冗余计算。邻域注意力机制通过针对 NVIDIA 硬件优化的后端代码进一步提升了效率。因此,在部分 NVIDIA GPU 上,视频推理速度可提升 2 到 2.5 倍。

Cosmos Transfer:

用于机器人和智能汽车的可控合成数据生成方案

Cosmos Transfer 模型基于多种控制输入生成世界仿真场景,包括分割图、深度图、边缘图、激光雷达扫描、关键点和高精地图等。这些多模态控制方式使用户在通过文本提示生成多样化视觉特征的同时,能够精准控制场景构成。该技术旨在增强合成数据集的视觉多样性,全面提升机器人与智能汽车应用中从仿真到现实的迁移效果。

Cosmos Transfer 应用

现在,让我们来看看使用 Cosmos Transfer 的一些工作流。

CosmosTransfer for AVs

Cosmos Transfer for AVs 能够通过多样化文本提示,从单一驾驶场景生成新的环境条件(如天气、光照和地形)。该技术采用多模态控制作为输入来增强数据多样性,例如在 Cosmos Drive Dreams 应用场景中所示。这项技术对创建辅助驾驶训练数据集具有重要意义,因为它能根据用户文本提示,基于单一视频实现大规模数据生成。

Cosmos Transfer 通过输入同一段视频并结合不同的文本提示(如“雪天”或“夜间场景”)生成各种条件和边缘情况。

基于文本提示和高精地图条件视频,使用 Cosmos Transfer 生成 RGB 视频的示例命令如下:

exportCUDA_VISIBLE_DEVICES="${CUDA_VISIBLE_DEVICES:=0}"

exportCHECKPOINT_DIR="${CHECKPOINT_DIR:=./checkpoints}"

exportNUM_GPU="${NUM_GPU:=1}"

PYTHONPATH=$(pwd) torchrun --nproc_per_node=$NUM_GPU--nnodes=1 --node_rank=0 cosmos_transfer1/diffusion/inference/transfer.py

--checkpoint_dir$CHECKPOINT_DIR

--video_save_folder outputs/example1_single_control_edge_distilled

--controlnet_specs assets/inference_cosmos_transfer1_single_control_edge.json

--offload_text_encoder_model

--offload_guardrail_models

--num_gpus$NUM_GPU

--use_distilled

边缘模型蒸馏

边缘模型蒸馏是 Cosmos Transfer 的改进版本。原始的 Cosmos Transfer 模型需要经过 70 次处理才能生成视频,计算成本高昂。针对边缘模式的模型蒸馏技术能够产出更轻量的学生模型,该模型能够在单一步骤中执行相同的任务,且生成质量与原始模型高度一致。其他控制模式(如深度图、分割图、高清地图和激光雷达)也可以通过类似的方式进行性能提升。通过减少视频生成所需的计算工作量,可实现更快、更经济的部署。可以通过--use_distilled 参数启用蒸馏版本。

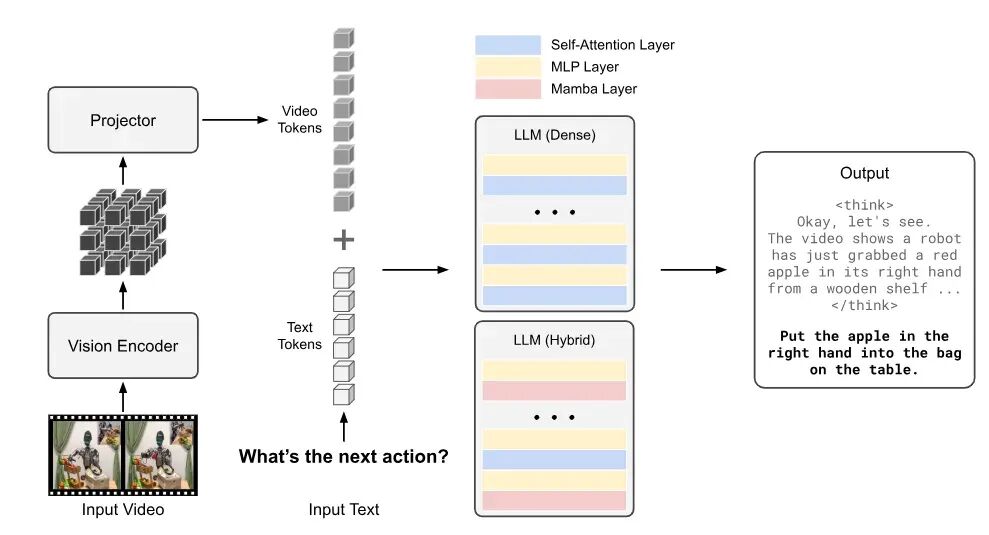

Cosmos Reason:

面向物理 AI 的长时推理框架

Cosmos Reason 是专注于物理 AI 推理的世界基础模型,能够理解物理常识,并通过长链式思维推理生成适当的具体决策。该模型能深度理解动作序列与现实世界约束,因此在合成数据生成(SDG)过程中可作为评估器来筛选高质量训练数据。该模型分两个阶段进行训练:监督式微调(SFT)和强化学习。

图 . Cosmos Reason 架构概述

监督微调(SFT)训练可以提高CosmosReason 模型在特定任务上的性能。例如,使用 robovqa 数据集进行训练可以提高机器人在视觉问答应用场景中的表现。以下是启动监督微调训练的示例命令:

cosmos-rl --config configs/cosmos-reason1-7b-fsdp2-sft.toml ./tools/dataset/cosmos_sft.py

本文是“NVIDIA 机器人研究与开发摘要(R²D²)”的一部分,旨在让开发者更深入地了解 NVIDIA 研究中心在物理 AI 和机器人应用方面的最新突破。

-

机器人

+关注

关注

213文章

30580浏览量

219577 -

NVIDIA

+关注

关注

14文章

5496浏览量

109091 -

模型

+关注

关注

1文章

3648浏览量

51712

原文标题:R²D²:利用 NVIDIA 研究中心的世界基础模型和工作流提升机器人训练效率

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

借助NVIDIA技术提升机器人的移动和全身控制能力

Al大模型机器人

【「具身智能机器人系统」阅读体验】2.具身智能机器人大模型

CES | 用 NVIDIA Isaac Sim 2022.2 模拟未来智能机器人

谷歌借助Gemini AI系统深化对机器人的训练

NVIDIA Cosmos世界基础模型平台发布

NVIDIA发布Cosmos™平台,助力物理AI系统发展

英伟达推出基石世界模型Cosmos,解决智驾与机器人具身智能训练数据问题

利用NVIDIA Cosmos模型训练通用机器人

NVIDIA通过全新 Omniverse库、Cosmos物理AI模型及AI计算基础设施,为机器人领域开启新篇章

NVIDIA三台计算机解决方案如何协同助力机器人技术

NVIDIA 利用全新开源模型与仿真库加速机器人研发进程

借助NVIDIA Cosmos模型提升机器人训练效率

借助NVIDIA Cosmos模型提升机器人训练效率

评论