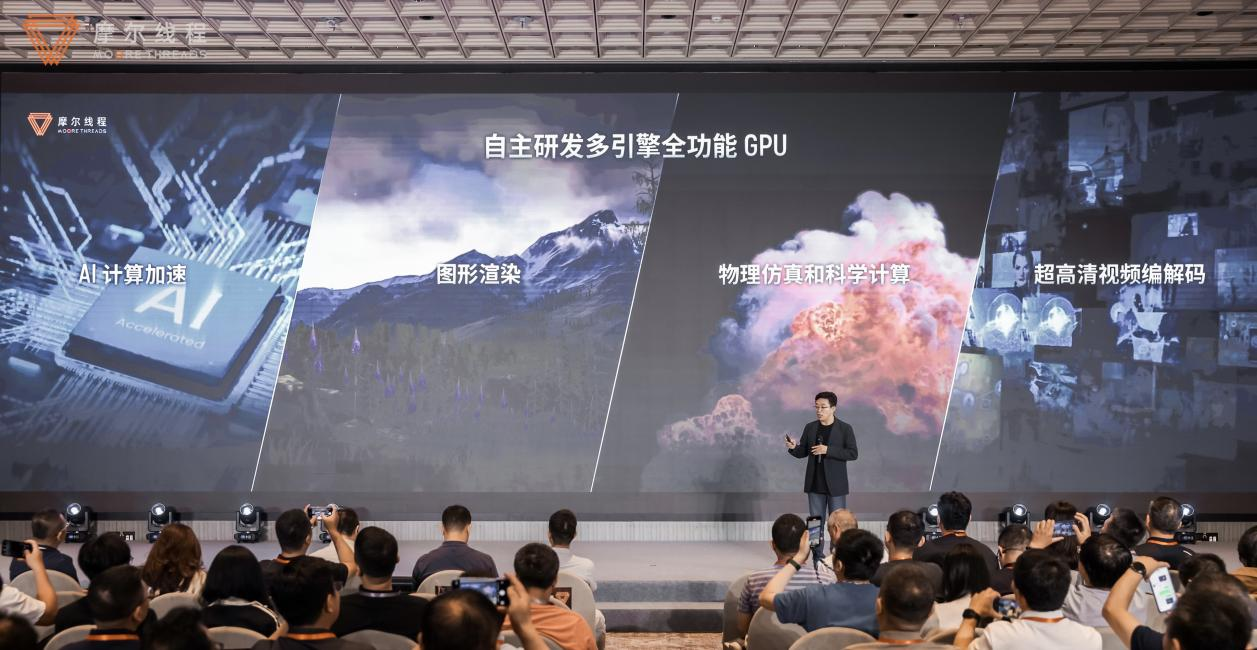

摩尔线程在世界人工智能大会(WAIC 2025)前夕举办以“算力进化,精度革命”为主题的技术分享会,创新性提出“AI工厂” 理念。这一系统性工程通过全功能GPU、自研架构、集群技术与软件生态的深度协同,重新定义了AI基础设施的生产力公式 ——AI工厂生产效率=加速计算通用性 × 单芯片有效算力 × 单节点效率 × 集群效率 × 集群稳定性。作为国内率先实现单芯片集成AI计算、图形渲染、物理仿真、超高清视频编解码四大引擎的GPU厂商,摩尔线程此次提出的 “AI工厂” 并非单纯的硬件升级,而是涵盖芯片架构、集群管理、算法优化、资源调度的全栈式创新。正如创始人张建中在主题演讲中所言:“我们正在建造的,是能够生产AGI时代先进模型的超级工厂。”

一、大模型算力需求呈指数级增长,参数量与数据量成核心驱动力

在WAIC 2025摩尔线程技术分享日上,副总裁王华首先聚焦大模型算力需求的发展趋势。他指出,2020年至2025年间,主流大模型的算力需求呈现出近乎指数级的增长态势,从单位为flops的数值来看,每一格代表10倍增长的纵轴上,模型所需算力持续攀升。

图:摩尔线程副总裁王华在大会上演讲分享他对大模型智算集群的看法(图片来源:电子发烧友网)

以具体模型为例,2020 年大模型算力需求 TOP 值为 10²³flops,而到 2025 年,Grok-3 的算力需求已达 10²⁶flops,短短五年间实现了约 1000 倍的增长;GPT-4 的训练量更是达到 10²⁵flops,较早期模型提升一个数量级。这种增长的核心驱动力来自参数量与数据量的双重扩张 —— 根据 Scaling Law,参数量和数据量的增大能显著降低模型 loss 值,提升模型效果,进而推动算力需求激增。

王华还通过不同规模集群的训练时间对比,直观展现了算力需求的规模。以英伟达H100 集群为例:DeepSeek 模型算力需求约 3.4×10²⁴flops,在千卡集群中需训练 97 天,五千卡集群需 22 天,万卡集群需 13 天;万亿参数的 Kimi K2 模型计算量为 2.98×10²⁴flops,对应训练时间分别为 85 天、19 天、11 天;而 GPT-4 因算力需求达 10²⁵flops,千卡集群需 602 天,五千卡集群需 137 天,万卡集群需 80 天。即便是早期的 GPT-3,虽参数量不小,但因数据量有限,训练效率相对更高。这些数据清晰表明,参数量与数据量的 “双增长” 正持续推高大模型训练的算力门槛。

二、FP8 成低精度训练 “甜点”,技术突破平衡效率与效果

在算力需求激增的背景下,低精度训练技术成为提升效率的关键。王华介绍,从FP32 到 FP16 再到 FP8,精度每下降一半,算力可提升一倍 —— 这源于显存占用减少、缓存速度提升,但同时也可能因数值损失导致模型效果下降。因此,如何在精度、参数量、数据量之间找到平衡,成为核心课题。

引入精度参数P 后的新 Scaling Law 显示,在固定计算量下,需合理配置参数量(N)、数据量(D)与精度(P):精度越高,loss 值(L)越小,但算力成本也越高。通过对比 FP32、FP16、FP8、FP6、FP4 的效果,发现 FP6 和 FP8 处于 loss 值最低的 “甜点区域”,而 FP4 因精度过低导致 loss 值回升。近期研究进一步验证,FP8 是当前兼顾效率与效果的最优选择,相比 FP16 训练有巨大提升空间。

不过,FP8 训练面临两大核心挑战:一是取值范围有限,易出现上溢(梯度爆炸)和下溢(梯度消失);二是不同操作对精度敏感度差异大 —— 矩阵乘等操作对精度不敏感,累加 / 归约类操作敏感度中等,非线性函数(如指数级增长的计算)则高度敏感。对此,行业普遍采用混合精度训练策略:对精度不敏感的部分(如矩阵乘)用 FP8 计算,敏感部分保留高精度。

王华强调,FP8 技术的落地离不开软硬件协同支撑。硬件上,新一代 Tensor Core(如英伟达产品)已支持 FP8 输入与高精度输出;软件层面,权重更新用 FP32 表达、Tensor Scaling 动态调整数值范围等技术,有效缓解了精度损失问题。以 DeepSeek 模型为例,其前向和反向传播中的 3 次矩阵乘均采用 FP8,激活值的缓存与传输也用 FP8,仅对精度敏感部分保留高精度,大幅提升了训练效率。

三、摩尔线程全栈支持FP8 训练,技术创新攻克落地难点

作为国内GPU 厂商代表,摩尔线程已构建起 FP8 训练的软硬件全栈支持能力。王华详细介绍了其技术布局:

在硬件层面,摩尔线程GPU 为全功能芯片,原生支持从 FP64、FP32 到 FP8 的全精度算力,为低精度训练提供基础支撑。

软件栈则包含三大开源框架:一是Torch-MUSA,作为 Torch 栈上的 MUSA 底层插件,已实现对 FP8 数据类型的完整支持,可在 MUSA 平台上顺畅运行整个 Torch 生态;二是 MT-MegatronLM,支持 Dense、多模态、MoE 等模型的高效训练,支持FP8 混合精度训练、高性能 muDNN 库与 MCCL 通信库;三是 MT-TransformerEngine,专注于 Transformer 模型的高效训练与推理优化,通过算子融合、并行加速等技术提升效率。

依托这套软件栈,摩尔线程成为行业内率先复现DeepSeek-V3 “满血版” 训练的厂商(其他厂商多聚焦推理复现)。其核心突破包括:通过 MT FlashMLA 和 DeepGEMM 库优化算子性能,精准复现了 DeepSeek 的训练逻辑。

针对FP8 训练的具体难点,摩尔线程还做了针对性创新:在 scaling factor 选择上,Per-Tensor 维度因数值范围稳定(最小值约 200,最大值约 2000),采用固定因子;Per-Block 维度因最小值可能为 0,易导致数值异常,故用 JIT 动态的scalingfactor的选择。在处理outlier(异常值)方面,通过 Smooth SwiGLU 技术,在量化后先乘缩放因子、第二次量化后再恢复,降低了 FP8 上溢风险,提升了训练稳定性。

四、大规模集群训练:模拟优化与可靠性保障并重

随着集群规模扩大(万卡、十万卡级),训练的效率与可靠性成为关键。王华指出,大规模训练无法全靠实验验证(资源消耗过大),需依赖模拟工具与可靠性技术。

在模拟优化方面,摩尔线程开源了Simumax 软件(GitHub 可下载),通过理论与仿真结合,估算训练中的资源开销。该工具支持多种并行策略、优化策略,可在主流模型上通过计算图仿真,收集各类开销数据,快速评估资源需求,并定位性能偏差原因。其核心逻辑是基于经验与理论数据,在计算图上模拟全流程,汇总开销后形成量化结果,为集群配置提供精准参考。

在可靠性保障上,摩尔线程建立了“全生命周期管理” 体系:一是 “起飞检查”,训练前对硬件、网络进行全面检测,跑小负载验证栈稳定性,自动剔除异常节点,降低人工排查带来的时间成本和人力成本;二是“飞行检查”,实时检测训练中的hang、异常退出、训练亚健康等问题并及时处理;三是“落地检查”,训练中断时自动抓取故障上下文,定位问题根源。

针对“慢节点” 拖累整体效率的问题,摩尔线程通过两方面检查解决:起飞阶段用小工作负载测试识别明显慢节点;训练中对比节点通信时间,挑出异常节点。此举常能带来10%-20% 的性能提升。

在容错训练上,针对万卡级集群的高故障率,采用“动态摘除” 策略:若某 DP(数据并行)节点故障,将其从通信组中摘除,剩余节点继续工作;若 DP 规模较大,可摘除单个节点,跳过该节点的参数计算与更新 —— 因数据量巨大,少量数据缺失对整体效果影响极小,但能避免集群重启的巨额开销。

王华总结,算力需求激增推动低精度训练技术崛起,FP8 成为当前最优解,而摩尔线程通过软硬件全栈创新与集群管理技术,正为大规模大模型训练提供高效、可靠的支撑。未来,其开发者大会将分享更多技术探索,持续推动 AI 算力基础设施的进化。

五、对未来趋势的总结

最后,王总特别总结指出现在的AI三个大趋势:第一、算力需求的发展趋势,使得大智算集群成为训练的刚需。第二,低精度的训练,会带来大规模训练效率的提升。第三,集群的可靠性对大规模训练至关重要。(完)

-

gpu

+关注

关注

28文章

5099浏览量

134455 -

摩尔线程

+关注

关注

2文章

256浏览量

6215

发布评论请先 登录

摩尔线程吴庆详解 MUSA 软件栈:以技术创新释放 KUAE 集群潜能,引领 GPU 计算新高度

摩尔线程亮相WAIC 2025:以“AI工厂”理念驱动算力进化,全栈AI应用赋能千行百业

摩尔线程“AI工厂”:五大核心技术支撑,打造大模型训练超级工厂

摩尔线程“AI工厂”:以系统级创新定义新一代AI基础设施

曙光数创亮相2025中国智算中心全栈技术大会

摩尔线程与AI算力平台AutoDL达成深度合作

摩尔线程加入中国移动AI能力联合舰队

智能算力基建:RAKsmart如何赋能下一代AI开发工具

摩尔线程与当虹科技达成深度合作

摩尔线程GPU原生FP8计算助力AI训练

国产化算力新标杆!卓怡恒通EPC-S4450边缘AI工控机开启工业智能新纪元

摩尔斯微电子任命安迪·麦克法兰为营销副总裁

摩尔线程副总裁王华:AI工厂全栈技术重构算力基建,开启国产 GPU 黄金时代

摩尔线程副总裁王华:AI工厂全栈技术重构算力基建,开启国产 GPU 黄金时代

评论