海光DCU实现文心4.5模型高效适配; FLOPs利用率突破47%。

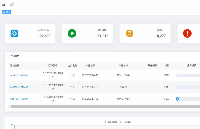

2025年6月30日,在百度文心4.5系列大模型正式开源当日,海光信息技术股份有限公司宣布其深度计算单元(DCU)率先完成对该系列模型的深度技术适配,预训练模型FLOPs利用率(MFU)达到47%,在多个文本与多模态基准测试中取得SOTA水平。此次合作标志着国产算力基础设施与大模型技术的协同创新进入新阶段。

技术突破:异构计算架构赋能MoE模型高效训练

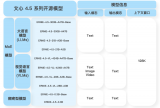

海光DCU基于GPGPU通用架构,通过飞桨深度学习框架对文心4.5系列模型实现全流程优化,涵盖47B/3B混合专家(MoE)模型及0.3B稠密参数模型的高效训练、推理与部署。其创新性体现在:

-

多模态异构计算:针对MoE架构设计动态负载均衡策略,显存带宽利用率提升30%

-

混合精度优化:采用FP8技术降低显存占用,使424B总参数量模型的训练效率接近国际一线水平

-

生态兼容性:依托DTK软件栈实现与文心模型的无缝对接,适配周期缩短50%

行业价值:自主可控技术体系加速AI落地

此次合作验证了国产DCU在高性能计算领域的三大优势:

-

效能领先:47%的MFU利用率较行业平均水平提升15%以上

-

多模态支持:文心4.5的跨模态理解能力在DCU平台上实现无损迁移

-

产业链安全:从芯片、框架到模型的完整技术自主权,为金融、制造等行业提供可靠算力选择

海光DCU与文心模型的深度适配,证明了国产算力支撑前沿AI创新的能力。未来将持续优化千亿级参数模型的训练效率,推动中国智能算力生态建设。

-

DCU

+关注

关注

0文章

16浏览量

3099 -

海光信息

+关注

关注

0文章

26浏览量

2563 -

文心一言

+关注

关注

0文章

134浏览量

2093 -

大模型

+关注

关注

2文章

3444浏览量

4970

发布评论请先 登录

华为发布AI容器技术Flex:ai,算力平均利用率提升30%

云天励飞与前海大数据公司、勤达睿达成战略合作

TDK公司与ASICS亚瑟士展开深度技术合作

睿海光电800G光模块助力全球AI基建升级

宁畅与与百度文心大模型展开深度技术合作

mes工厂管理系统:如何让设备利用率提升50%?

DeepSeek MoE架构下的网络负载如何优化?解锁90%网络利用率的关键策略

海光DCU率先展开文心系列模型的深度技术合作 FLOPs利用率(MFU)达47%

海光DCU率先展开文心系列模型的深度技术合作 FLOPs利用率(MFU)达47%

评论