芯原股份今日宣布其超低能耗且高性能的神经网络处理器(NPU)IP现已支持在移动端进行大语言模型(LLM)推理,AI算力可扩展至40 TOPS以上。该高能效NPU架构专为满足移动平台日益增长的生成式AI需求而设计,不仅能够为AI PC等终端设备提供强劲算力支持,而且能够应对智慧手机等移动终端对低能耗更为严苛的挑战。

芯原的超低能耗NPU IP具备高度可配置、可扩展的架构,支持混合精度计算、稀疏化优化和并行处理。其设计融合了高效的内存管理与稀疏感知加速技术,显著降低计算负载与延迟,确保AI处理流畅、响应迅速。该NPU支持数百种AI算法,如AI降噪(AI-NR)和AI超分(AI-SR)等,并兼容Stable Diffusion和LLaMA-7B等主流AI模型。同时,该NPU IP还可与芯原其他处理器IP无缝集成,实现异构计算,助力SoC设计者打造满足多元化应用需求的AI解决方案。

此外,芯原的超低能耗NPU IP还支持TensorFlow Lite、ONNX和PyTorch等主流AI框架,可加速客户在不同AI应用场景中的部署进程并简化集成工作。

“智能手机等移动设备正逐步演变为个人AI服务器。随着生成式AI(AIGC)和多模态大语言模型技术的快速发展,市场对AI算力的需求呈指数级增长,并已成为移动产品的关键差异化要素。”芯原首席战略官、执行副总裁、IP事业部总经理戴伟进表示,“在支持高强度AI计算负载的过程中,能耗控制是最关键的挑战之一。芯原持续深耕面向智慧手机和AI PC的超低能耗的NPU研发,并通过与主流SoC合作伙伴的紧密协作,见证了该技术在新一代智慧手机和AI PC中实现量产。”

审核编辑 黄宇

-

芯片

+关注

关注

462文章

53534浏览量

459021 -

低能耗

+关注

关注

0文章

27浏览量

11723 -

NPU

+关注

关注

2文章

358浏览量

20833 -

算力

+关注

关注

2文章

1385浏览量

16561

发布评论请先 登录

国产AI芯片真能扛住“算力内卷”?海思昇腾的这波操作藏了多少细节?

米尔RK3576部署端侧多模态多轮对话,6TOPS算力驱动30亿参数LLM

基于米尔瑞芯微RK3576开发板的Qwen2-VL-3B模型NPU多模态部署评测

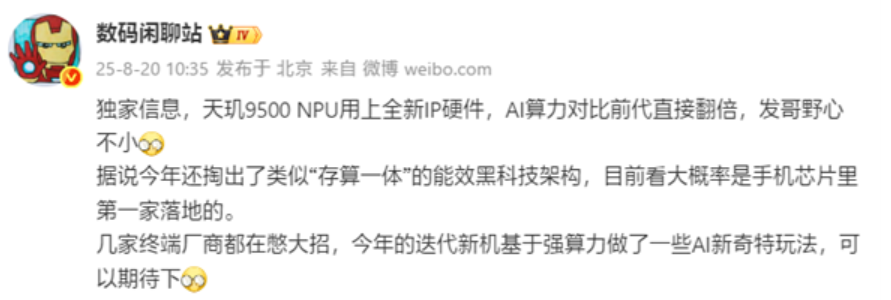

天玑9500 性能大爆发!NPU AI算力或达100TOPS

积算科技上线赤兔推理引擎服务,创新解锁FP8大模型算力

基于米尔瑞芯微RK3576开发板部署运行TinyMaix:超轻量级推理框架

揭秘瑞芯微算力协处理器,RK3576/RK3588强大算力搭档

超低延时重构AI推理体验!白山云发布“大模型API”产品

芯原超低能耗NPU可为移动端大语言模型推理提供超40 TOPS算力

芯原超低能耗NPU可为移动端大语言模型推理提供超40 TOPS算力

评论