【重点内容抢先看】

生成式 AI正在改变游戏规则,重新定义创造力、自动化,甚至是网络安全的未来。像 GPT-4和deepseek这样的模型能够生成类人文本、精美图片以及软件代码,为企业和个人打开了全新的可能性。然而,强大的能力伴随着巨大的风险。网络安全专家越来越关注生成式 AI,不仅因为其技术突破,还因为它带来的潜在安全隐患。在本文中,我们将探讨生成式 AI 的复杂性,包括其运作方式、安全风险,以及企业如何有效降低这些风险。

一、生成式 AI:创新与风险并存的前沿技术

生成式 AI是人工智能的一个重要分支,能够自动生成文本、图像、音频、视频乃至代码。不同于传统 AI侧重数据分析和分类,生成式 AI依托大规模训练数据和深度学习技术,可以创造全新内容,其核心技术包括:

大语言模型(LLMs):如 GPT-4、DeepSeek,具备强大的语言理解与生成能力。

强化学习与微调(Fine-Tuning):通过行业数据优化模型,使其更契合特定应用场景。

当前主流的生成式 AI技术涵盖多个领域:

GPT-4(OpenAI):擅长生成自然流畅的文本。

DeepSeek(深度求索):专注中文语境优化,提升 AI生成能力。

DALL-E:可根据文本描述生成精细图像。

MidJourney:以艺术风格图像创作见长。

这些技术已广泛应用于媒体、设计、医疗、内容创作和软件开发等领域,大幅提升生产效率。然而,生成式 AI的发展也带来了新的挑战和风险。

二、生成式 AI的安全风险

生成式 AI带来了巨大的机遇,但同时也引发了一系列网络安全威胁。从数据泄露到AI生成语音和深度伪造(Deepfake),这种技术对企业和政府机构构成了重大风险。以下是生成式 AI可能带来的主要安全隐患:

1.数据泄露与隐私侵犯

生成式 AI面临的最严重问题之一就是数据泄露。由于这些模型是在海量数据集上训练的,它们可能会无意中复现训练数据中的敏感信息,从而侵犯用户隐私。例如,OpenAI曾表示,大型语言模型可能会在 1-2%的情况下无意暴露输入数据,其中可能包含个人身份信息(PII)。对于受严格数据监管的行业(如医疗或金融领域),数据泄露可能会导致巨大的财务损失或声誉损害。

2.恶意代码生成

网络犯罪分子可以利用生成式 AI创建恶意文本,包括恶意软件(Malware)和勒索软件(Ransomware)脚本。一些攻击者已经开始使用 GPT生成复杂的网络钓鱼(Phishing)邮件,甚至直接编写攻击代码,降低了黑客入侵的技术门槛。根据 CheckPoint的报告,高级持续性威胁(APT)组织已开始使用AI生成的网络钓鱼脚本来规避传统安全工具的检测。

3.模型反演攻击(Model Inversion Attacks)

在模型反演攻击中,攻击者可以通过访问 AI模型,推测或恢复模型的训练数据。这可能导致敏感数据(甚至是匿名数据)被泄露,而一旦这些数据落入网络犯罪分子手中,他们可能获取专有算法或用户个人信息。例如,Securiti研究人员曾演示过,在缺乏安全保护的情况下,攻击者可以通过生成式 AI模型提取私人信息。

4.深度伪造(Deepfake)与欺诈

深度伪造(Deepfake)技术的精度正在不断提高,并被用于身份冒充、虚假信息传播和社交工程攻击。

AI 语音克隆可以让黑客模仿公司高管或知名人士的声音,从而进行诈骗。

伪造视频可能用于虚假新闻、欺诈性广告或政治操纵。

根据普华永道(PWC)的一项研究,到 2026年,深度伪造技术可能每年造成高达 2.5亿美元的损失,主要来自欺诈和错误信息传播。

5.偏见与伦理问题

生成式 AI依赖于已有数据进行训练,因此可能会固化社会偏见。如果训练数据中存在歧视性内容,模型生成的结果可能会不公平或带有歧视性,从而影响决策的公正性。

企业层面,这种偏见可能会带来品牌风险、法律诉讼和合规问题。

在受监管行业,如招聘、金融和医疗,AI生成的不公平决策可能会触犯法律,导致企业面临法律和伦理责任。

尽管生成式 AI提供了巨大的创新潜力,但同时也带来了严重的数据安全、网络攻击、伦理偏见和社会工程攻击风险。因此,企业和政府机构在应用生成式 AI时,必须采取适当的安全措施,以降低这些潜在威胁。

三、如何降低生成式 AI的安全风险

面对当前及未来的 AI安全挑战,企业和机构必须采取全面的安全策略来应对生成式 AI可能带来的风险。以下是一些关键的缓解措施:

1.数据隐私保护与差分隐私(Differential Privacy)

数据清理是减少 AI训练数据泄露风险的最佳方法之一。企业应在使用数据之前,对数据集进行清理,去除所有可识别的个人信息,以防止 AI模型无意中泄露敏感数据。

此外,差分隐私技术(Differential Privacy)可以进一步增强数据保护,它能够确保模型在生成内容时不会暴露单个用户的数据。目前,Google和 Apple等公司已经在其大规模 AI模型中采用了差分隐私来保护用户信息。

2. AI审计与持续监控

定期审核 AI模型,并持续监测其输出,有助于发现潜在的攻击或安全风险。例如,AI可能会产生偏见内容或无意中泄露敏感信息,企业需要建立AI监管体系,以确保 AI技术的合理应用。

第三方 AI审计(如 PWC建议的外部评估)可以帮助组织符合隐私法规和安全要求,并确保 AI系统的公平性和透明度。

AI 监测系统可以实时检测异常行为,防止 AI生成误导性或有害内容。

3.加密与访问控制

限制对 AI模型的访问权限至关重要,企业可以采用基于角色的访问控制(RBAC),确保只有授权用户才能使用 AI系统。

此外,AI生成的输出数据和训练数据在传输过程中应进行加密,防止数据在传输过程中被窃取或篡改。

4.引入“人类监督”(Human-in-the-Loop)机制

在 AI生成内容的关键环节加入人工审核,可以有效减少偏见、不当或恶意内容的产生。

通过人类监督(Human-in-the-Loop),企业可以确保 AI生成的内容符合道德标准,并避免错误信息的传播。

人工审核机制还可以提高 AI 系统的可信度,减少 AI自动化带来的潜在风险。

生成式 AI的强大能力给企业和社会带来了无限可能,同时也伴随着数据隐私、网络安全、伦理偏见等风险。只有通过隐私保护、持续监控、访问控制和人工监督等多层次的安全措施,才能确保 AI的安全应用,防止其被恶意利用。

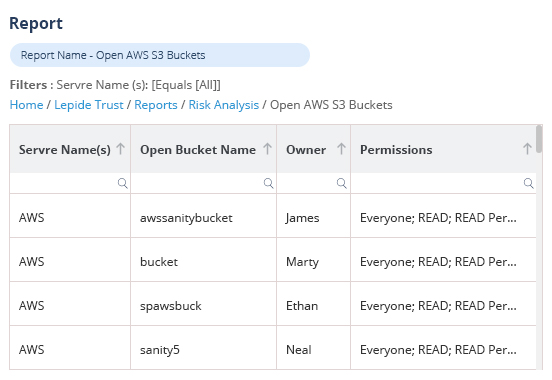

四、使用 Lepide保障生成式 AI的安全性

面对生成式 AI带来的安全挑战,Lepide数据安全平台提供了一套全面且主动的解决方案,有效降低相关风险。Lepide能够实时监控数据交互、用户权限及访问活动,帮助企业在安全威胁发生之前及时检测并响应可疑行为,防止安全事件升级为严重的数据泄露。

Lepide的核心优势之一在于其能够防止未经授权的访问,最大程度地降低 AI驱动环境中的数据泄露风险。通过详细的审计日志,企业可以追踪敏感数据的所有变更,确保对 AI相关数据使用的可视化管理和全面掌控。

除了安全监控,Lepide还在合规性管理方面发挥着关键作用。它能够自动化合规报告,并提供自定义安全警报,帮助企业遵守 GDPR、CCPA、HIPAA等严格的数据隐私法规,降低因违规导致的法律和经济风险,确保敏感数据始终受到严格保护。

此外,Lepide采用 AI驱动的异常检测技术,可以识别并响应异常的数据访问模式。这种主动防御策略有助于及时发现内部威胁、AI滥用或潜在的网络攻击,确保企业能够在安全事件发生前采取应对措施。

通过集成自动化风险评估、精细化访问控制和先进的威胁情报,Lepide使企业能够在确保数据安全和合规性的前提下,放心采用生成式 AI技术。

结论

生成式 AI正在重塑未来科技的发展,但它带来的安全风险不容忽视。从数据泄露到 AI生成的恶意软件,这些威胁都是真实存在且不断演变的。然而,解决方案并不是回避 AI,而是通过加密、监控和道德治理等积极措施,确保 AI的安全使用。

通过结合强大的安全实践与人工监督,企业可以在保证安全性的同时,充分释放生成式 AI的潜力。关键在于在创新与责任之间找到平衡,确保 AI在推动技术进步的同时,始终遵循安全和伦理标准。

审核编辑 黄宇

-

数据安全

+关注

关注

2文章

755浏览量

30744

发布评论请先 登录

艾体宝方案 | 安全不止是“加密”:企业如何真正做到数据可控?

攻击逃逸测试:深度验证网络安全设备的真实防护能力

微软Microsoft Sentinel升级为智能体化AI技术安全平台

信而泰×DeepSeek:AI推理引擎驱动网络智能诊断迈向 “自愈”时代

IBM发布业界首个AI智能体治理与安全软件

威盛电子推出AI工业车辆安全方案

锂电池热失控原理及安全检测技术解析

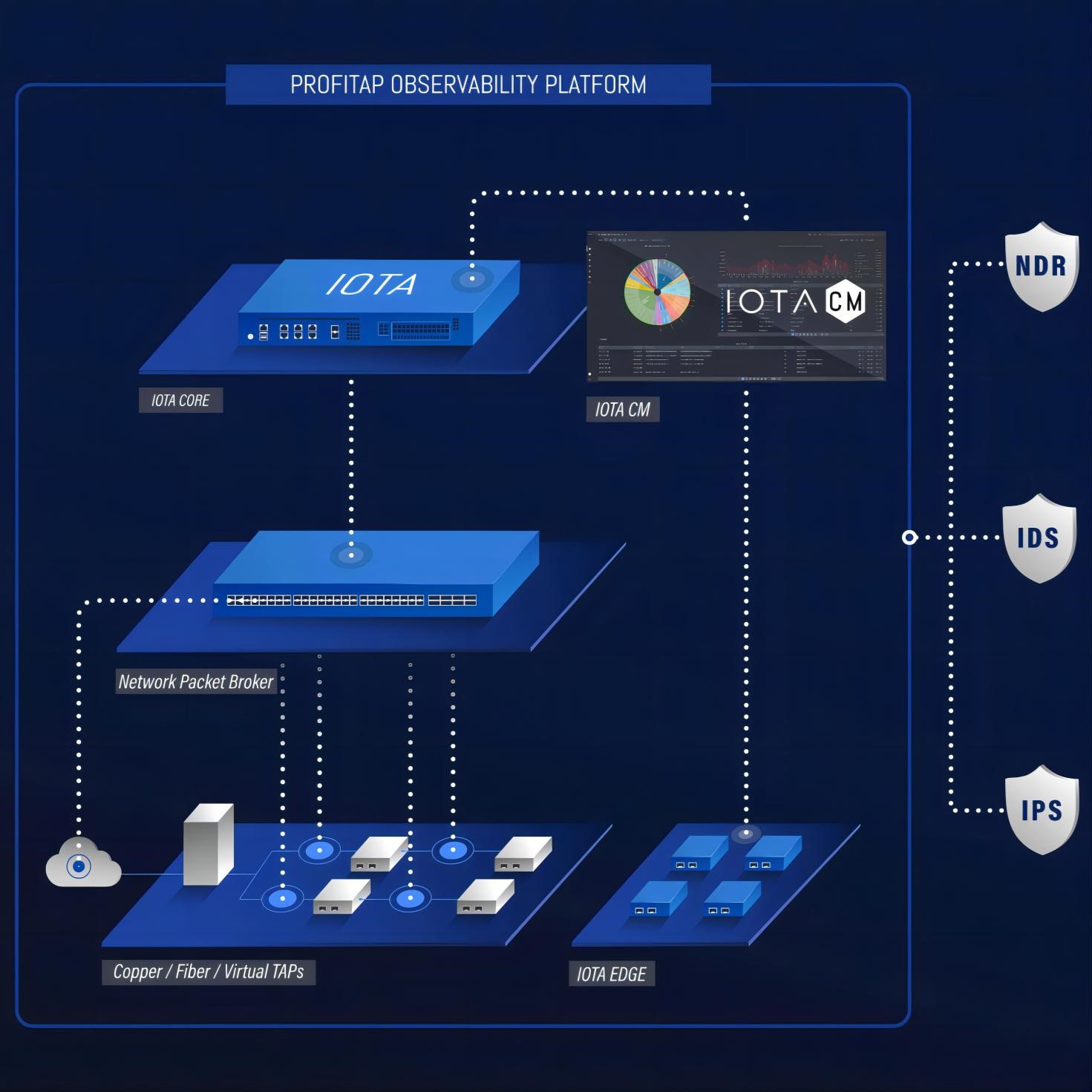

艾体宝干货 IOTA实战:如何精准识别网络风险

艾体宝干货 深度防御策略:构建USB安全防线的五大核心层次

艾体宝方案 全面提升API安全:AccuKnox 接口漏洞预防与修复

艾体宝方案 深度解析生成式 AI 安全风险,Lepide 为数据安全护航

艾体宝方案 深度解析生成式 AI 安全风险,Lepide 为数据安全护航

评论