作者:京东零售 姜海

DeepSeek无疑是春节档最火爆的话题,上线不足一月,其全球累计下载量已达4000万,反超ChatGPT成为全球增长最快的AI应用,并且完全开源。那么究竟DeepSeek有什么魔力,能够让大家趋之若鹜,他又将怎样改变世界AI格局和我们的生活,本篇文章将进行简要解析。

DeepSeek与ChatGPT对比

说到人工智能就不得不提OpenAI和ChatGPT,这是绕不开的话题,要分析DeepSeek的实力,最简单的方式就是跟ChatGPT进行对比。

模型分类

ChatGPT目前有两种大模型,分别是面向普通用户,解决日常应用问题的4-OMNI,以及面向专业用户,处理深度思考问题的O1,DeepSeek与之对标的分别是V3模型以及R1模型。

实用效果

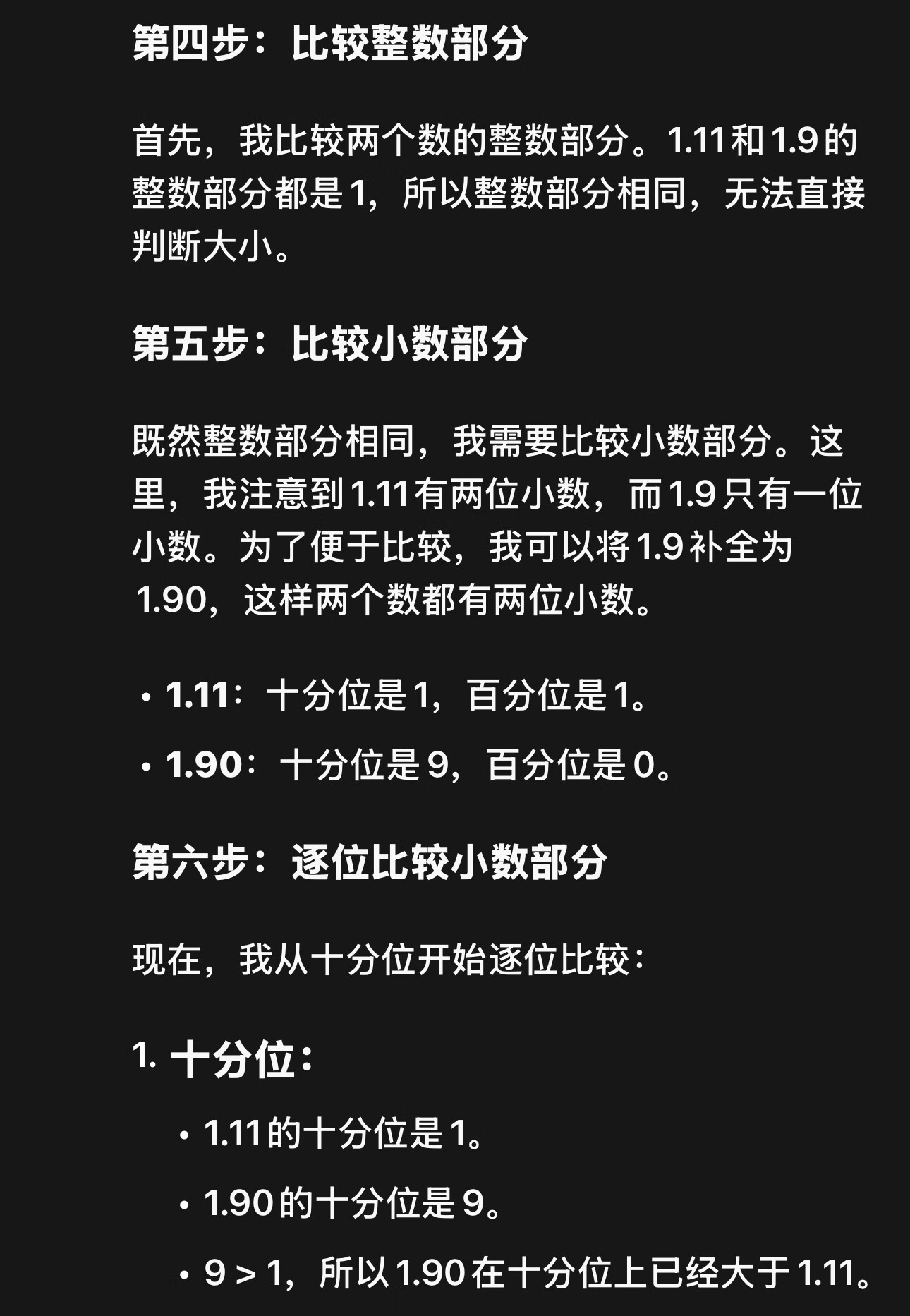

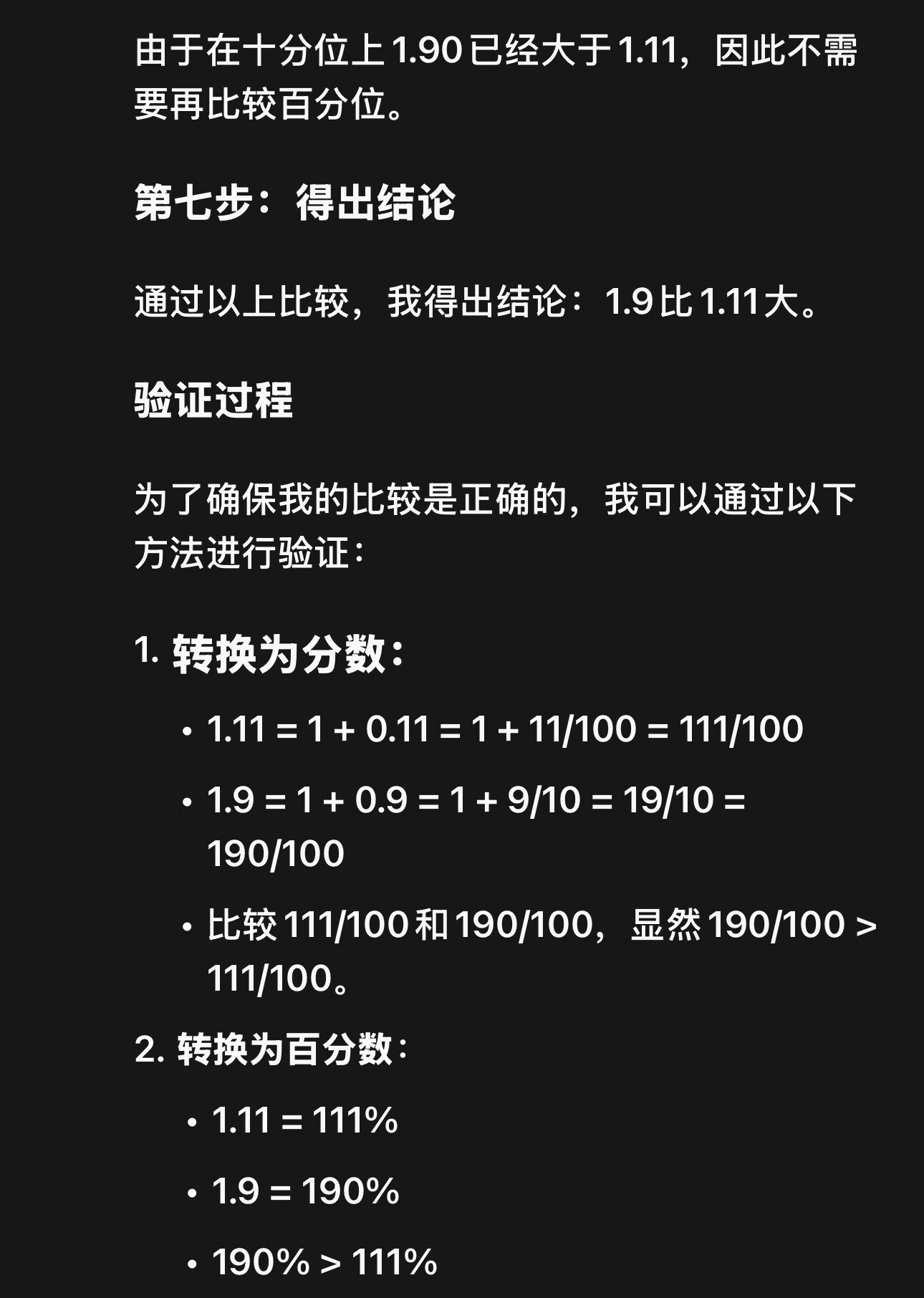

据我目前的使用体验下来,DeepSeek的实际体验效果完全不输ChatGPT,甚至在解决数学、物理和推理问题方面表现出色,响应速度比ChatGPT还要快,且能够完整地展示其思考和给出答案的过程,例如最经典的,让绝大多数AI翻车的“1.11和1.9谁大?”的问题,ChatGPT给出的回答是:

前言不搭后语,而反观DeepSeek:

可以看到DeepSeek不仅给出了正确答案,而且展示了详细的解题思路,甚至有最后的验证。我也测试了许多其他的问题,DeepSeek完全不拉垮,相对于ChatGPT,他在中文领域的问题理解和处理更加到位,使用体验非常好。

这无疑也使得苹果公司柳暗花明又一村,为弥补apple intelligence上在中国区无法使用ChatGPT提供了完美的解决方案。

成本

成本分为两部分:硬件成本和训练成本。AI大模型构建算法绝大部分都是基于公开的论文,所以市场上的大模型,底层逻辑都大同小异,训练数据也来自于互联网,所以主要的成本体现在硬件上,也就是提供AI算力的芯片,自从AI大爆发以来,大家的共识就是堆砌的芯片越多,大模型的表现就越优秀。我先简单介绍一下为什么提升AI的性能就要堆砌大量的芯片。

AI算力的芯片领域是英伟达(Nvidia)一家独大,芯片价格非常昂贵,目前该公司最先进的B200芯片单张的价格就高达4万美金,而且对于AI公司来说你还必须买,因为芯片的产能有限,如果你不抢就会被竞争对手买走,导致你的大模型算力不如他的。

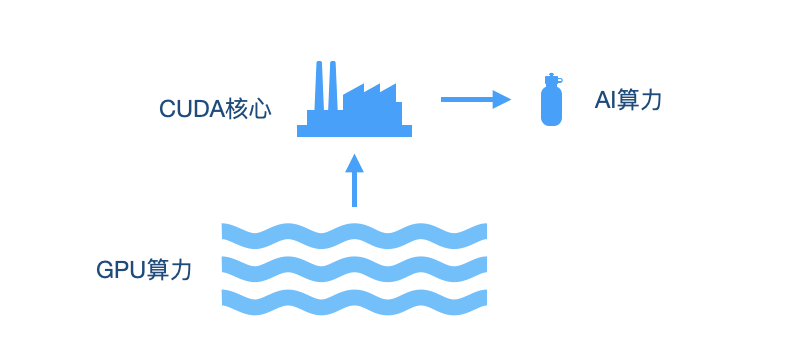

英伟达公司为自家的芯片研发了一种叫CUDA的核心的技术,其全名叫做Compute Unified Device Architecture(统一计算设备架构)。

这是一种并行计算平台和编程模型。开发者通过它,可以间接利用GPU的处理能力,大幅提升计算性能。简单的说,CUDA核心就像是一间间的海水提纯工厂,它可以把如海洋般的GPU算力转换成AI开发者可以直接使用的AI算力,越多的CUDA核心数量就意味着更大的AI算力。

这也就是为什么AI行业越发展,芯片的需求量越大,英伟达的市值就越高。美国也多次通过英伟达“锁算力”以及限制芯片出口,阻碍中国的AI发展。AI行业的发展被一家公司扼住喉咙的现象显然极度不合理,英伟达可谓是真正的万恶之源。

OpenAI不受限制,所以囤积了大量的英伟达芯片,训练ChatGPT据传用到了5万张英伟达的芯片,而DeepSeek作为中国公司,在这方面相比自然相去甚远。

DeepSeek冲击

由于CUDA技术被英伟达牢牢掌握,所以间接提高了所有AI大模型的使用成本,阻碍了AI的发展。以ChatGPT为例,4-OMNI和O1两个大模型的研发成本高达数十亿美金,免费用户使用有诸多限制,付费用户每月20美金,专业用户每月200美金,如果企业想要接入OpenAI的人工智能服务,调用API做客服等用途,则更是按字符收费,虽然比人工客服省钱,但也是一笔不小的开销。这些收入中,绝大多数都是用来平衡购买芯片带来的巨大成本。

DeepSeek之所以引起全球瞩目,就是因为他在“芯片”受限的前提下,达到了与ChatGPT近似的使用体验,甚至在某些领域还远远超过了。OpenAI和它的母公司微软囤积了大量的高端芯片,而DeepSeek手里的芯片,不论从数量还是质量上都不占优势,甚至可以说远远落后。

在深度解析DeepSeek开源的模型代码之后,研究人员发现,DeepSeek之所以能够绝地反击,秘诀就在于他绕过了CUDA核心的限制,使用了完全创新的技术训练大模型,直接利用英伟达的底层技术调用了GPU的算力,相当于能直接使用如大海般的GPU资源,所以才能使用低端的芯片,在极短的时间内完成了模型的训练,达到了与ChatGPT近似的效果。

而且此技术成功解除了AI模型对英伟达芯片的依赖,使DeepSeek可以使用华为的芯片进行训练。DeepSeek服务调用的费用只有ChatGPT的十分之一,具有非常高的性价比和广阔的应用前景。

整体来说,DeepSeek用了很少的钱,很低端的工具,就把美国投入上百亿美元的事给办了。自从DeepSeek爆火之后,市场普遍认为英伟达的芯片估值过高,要实现高性能的AI并不需要如此之贵的芯片,最高端的芯片也并不值那个价钱,这直接导致英伟达的股价当天就暴跌17%,创造了美国股市历史上单日最大跌幅,截至目前英伟达市值蒸发近6000亿美元。

技术曝光的第二天,英伟达,微软和亚马逊的计算平台都宣布接入DeepSeek模型,堪称AI界的“斯普特尼克时刻”,就如同当年苏联率先成功发射人造卫星时一样,让一直以为自己在技术上遥遥领先的西方世界陷入了一片混乱,世界AI市场的格局就此改变。

本地化部署R1模型

DeepSeek虽然好,但是用过的同学都知道他有个致命的问题,就是万恶的资本主义经常组织针对DeepSeek的网络攻击,导致使用时出现“服务器繁忙的问题”。

为了避免被攻击,降低延迟和卡顿,规避共享敏感信息的风险,同时更灵活的进行微调和实验,我们可以把R1模型部署到本地。

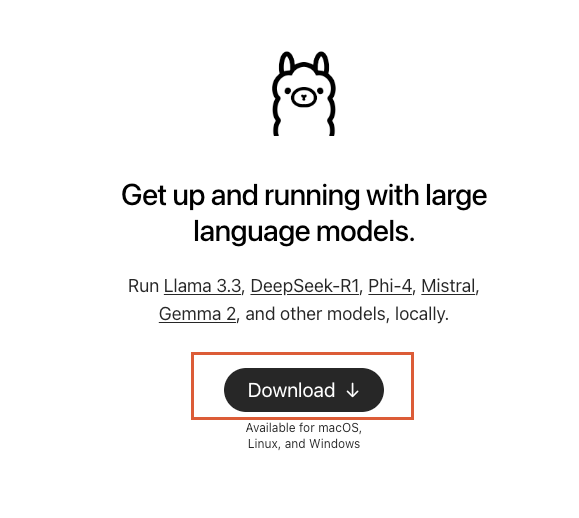

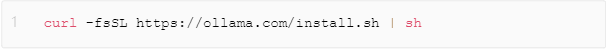

安装Ollama

首先登陆Ollama官网:https://ollama.com/。打开官网,然后点击下载,之后安装到本地。

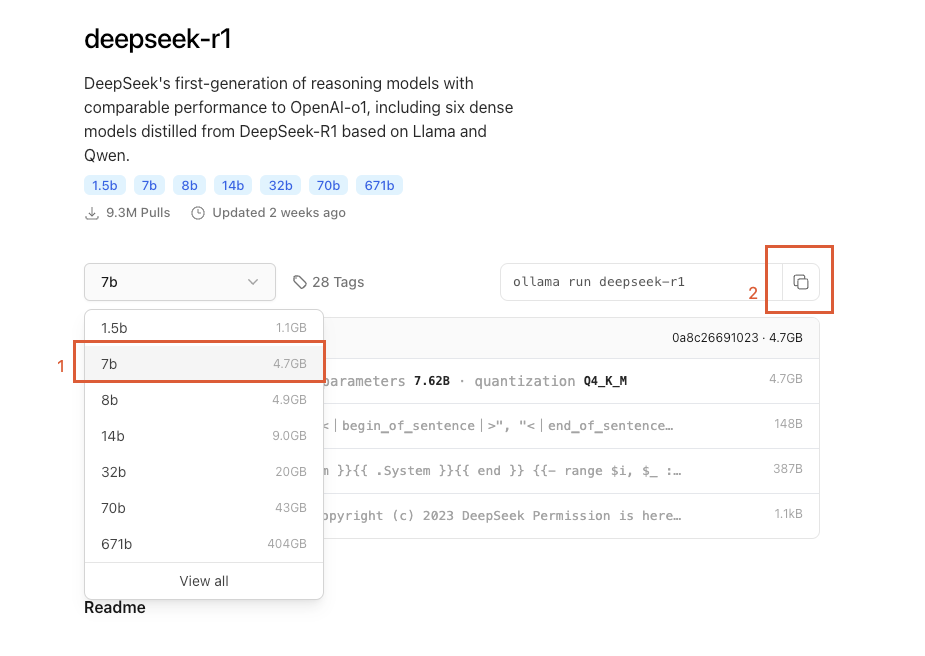

拉取 DeepSeek R1 模型

然后打开Ollama 的模型列表: https://ollama.com/library/deepseek-r1 ,搜索到DeepSeek R1:

显卡需求

各个模型版本需求的显卡档次大致如下表:

| 模型(DeepSeek-R1) | 显卡档次 | 显存需求 |

|---|---|---|

| 1.5b | GTX1050以上 | 1GB |

| 7b | RTX2050、RTX3060以上 | 4GB |

| 8b | RTX2060、RTX3070以上 | 5GB |

| 14b | RTX3080、RTX4070以上 | 8GB |

| 32b | RTX4080以上 | 18GB |

| 70b | RTX4090、RTX5080以上 | 36GB以上 |

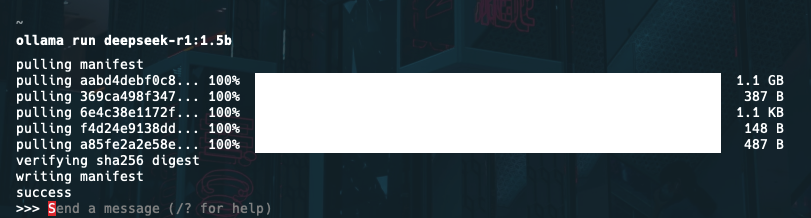

我们普通的电脑安装1.5B,7B就可以使用,然后在【右上角的的代码】复制,打开终端,输入上述下载命令回车后,会出现模型下载进度,当进度为100%就说明该模型已经下载到本地了。

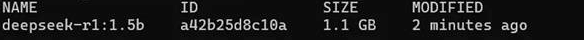

输入ollama list可以查看安装的模型。

此时已经可以在控制台使用R1模型进行问答了。

包装GUI

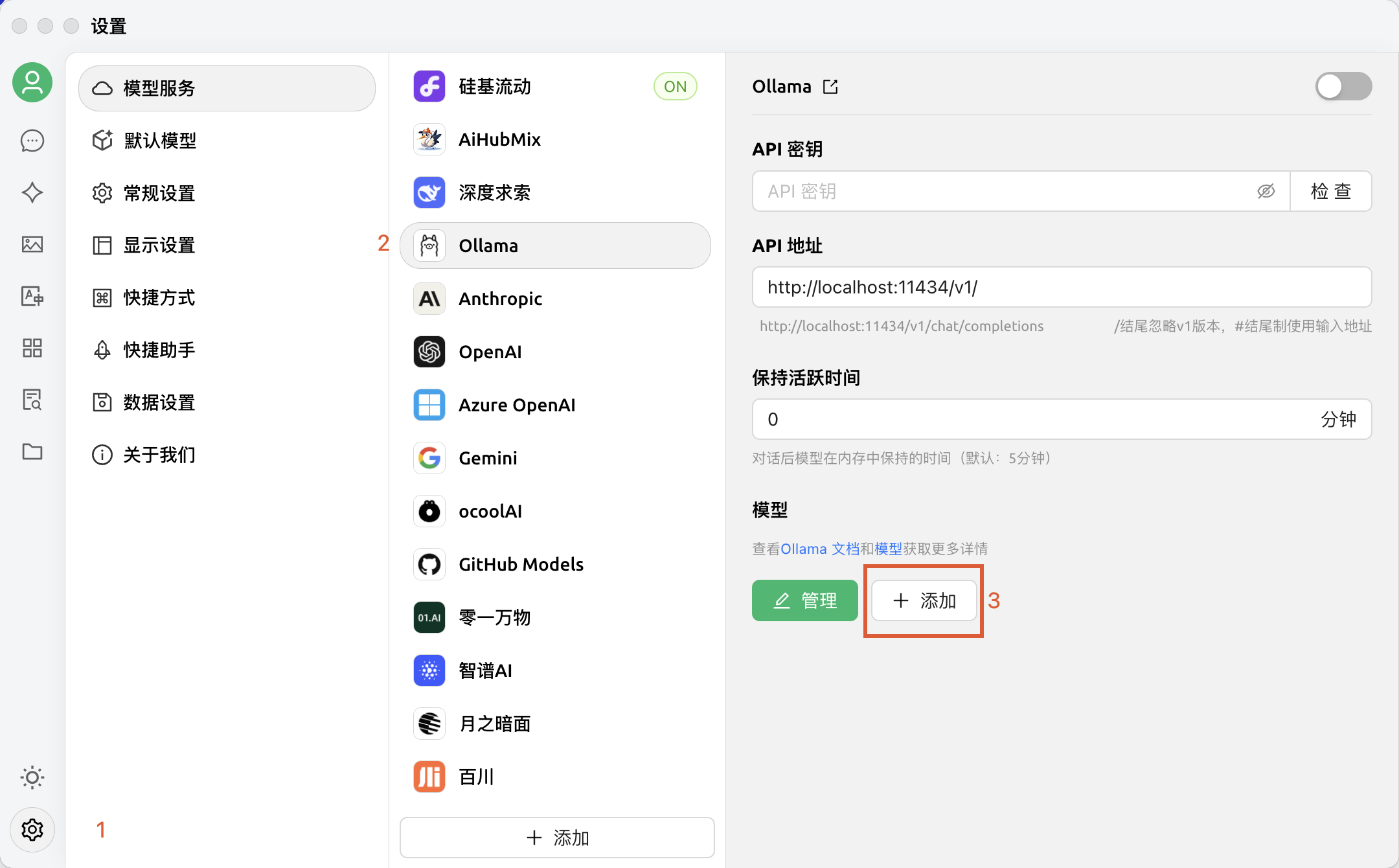

只能在命令行中使用既不美观也特别的不方便,所以我们可以使用现成的GUI进行包装,相当于包上图形用户界面。这里以Cherry Studio为例,下载对应版本后打开。

在设置中选择模型服务,选中Ollama

填入对应的本地模型信息:

然后就可以使用了!希望本篇文章能够帮到大家!

审核编辑 黄宇

-

大模型

+关注

关注

2文章

3460浏览量

4975 -

DeepSeek

+关注

关注

2文章

824浏览量

2830

发布评论请先 登录

发布元服务配置本地化基础信息(应用名称、图标)

本地部署openWebUI + ollama+DeepSeek 打造智能知识库并实现远程访问

软通动力助力黑龙江大学完成DeepSeek大模型本地化部署

AI筑基,智领未来 | DeepSeek-R1本地大模型赋能迈威通信智能化转型

DeepSeek冲击(含本地化部署实践)

DeepSeek冲击(含本地化部署实践)

评论