科技云报道原创。

AI大模型正在倒逼数字基础设施产业加速升级。

过去一年半,AI大模型标志性的应用相继出现,从ChatGPT到Sora一次次刷新人们的认知。震撼的背后,是大模型参数指数级的增长。

这种数据暴涨的压力,快速传导到了大模型的底层基础设施。作为支撑大模型的底座“三大件”——算力、网络、存储,都在快速的迭代。

算力方面,英伟达用了两年的时间就将GPU从H100升级到了H200,让模型的训练性能提升了5倍。

网络方面,从之前的25G升级到现在的200G,网络带宽提升了6倍。随着RDMA大规模的应用,网络延迟也降低了60%。

存储方面,华为、阿里云、百度智能云、腾讯云等大厂,都相继推出了面向AI大模型的存储方案。

那么作为基础设施的三大件之一的存储,在AI大模型的场景下到底发生了哪些变化?又有哪些新的技术挑战?

AI大模型带来的 存储挑战

算力、算法、数据,在发展AI过程中的重要性早已为人所熟知,但是作为数据的承载,存储却往往被忽略。

在训练AI大模型的过程中,需要大量数据的交换,存储作为数据的基础硬件,并非仅仅只是简单地记录数据,而是深刻参与到了数据归集、流转、利用等大模型训练的全流程。

如果存储性能不强,那么可能需要耗费大量时间才能完成一次训练,这就会严重制约大模型的发展迭代。

事实上,不少企业在开发及实施大模型应用过程中,已经开始意识到存储系统所面临的巨大挑战。

从AI大模型的研发生产流程看,可分为数据采集、清洗、训练和应用四个阶段,各阶段都对存储提出了新的要求,比如:

在数据采集环节,由于原始训练数据规模海量,且来源多样,企业希望能够有一个大容量、低成本、高可靠的数据存储底座。

在数据清洗阶段,网络上收集的原始数据是不能直接用于AI模型训练的,需要将多格式、多协议的数据进行清洗、去重、过滤、加工,行业内称其为“数据预处理”。

与传统单模态小模型训练相比,多模态大模型所需的训练数据量是其1000倍以上,一个典型的百TB级大模型数据集,预处理时长超过10天,占比AI数据挖掘全流程的30%。

同时,数据预处理伴随高并发处理,对算力消耗巨大。这就要求存储能够提供多协议、高性能的支持,用标准文件的方式完成海量数据的清洗和转换,以缩短数据预处理的时长。

在模型训练环节,通常会出现训练集加载慢、易中断、数据恢复时间长等问题。

相较于传统学习模型,大模型训练参数、训练数据集指数级增加,如何实现海量小文件数据集快速加载,降低 GPU等待时间是关键。

目前,主流预训练模型已经有千亿级参数,而频繁的参数调优、网络不稳定、服务器故障等多种因素带来训练过程不稳定,易中断返工,需要Checkpoints机制来确保训练回退到还原点,而不是初始点。

当前,由于Checkpoints需要天级的恢复时长,导致大模型整体训练周期陡增,而面对单次超大的数据量和未来小时级的频度要求,需要认真考虑如何降低Checkpoints恢复时长。

因此,存储能否快速地读写checkpoint(检查点)文件,也成了能否高效利用算力资源、提高训练效率的关键。

在应用阶段,存储需要提供比较丰富的数据审核的能力,来满足鉴黄鉴暴安全合规的诉求,保证大模型生成的内容是合法、合规的方式去使用。

总的来说,AI大模型训练的效率要达到极致,减少不必要的浪费,必须在数据上下功夫。准确地说,必须要在数据存储技术上进行创新。

AI倒逼存储技术创新

根据投资机构ARK Invest预算,到2030年,产业有望训练出比GPT-3多57倍参数、多720倍Token的AI模型,成本将从今天的170亿美元降至60万美元。随着计算价格降低,数据将成为大模型生产的主要限制因素。

面对数据桎梏问题,不少企业已经开始进行前瞻性布局。

比如百川智能、智谱、元象等大模型企业,都已采用腾讯云AIGC云存储解决方案来提升效率。

数据显示,腾讯云AIGC云存储解决方案,可将大模型的数据清洗和训练效率均提升一倍,需要的时间缩短一半。

科大讯飞、中科院等大模型企业和机构,则采用了华为AI存储相关产品。

数据显示,华为OceanStor A310可实现从数据归集、预处理到模型训练、推理应用的AI全流程海量数据管理,简化数据归集流程,减少数据搬移,预处理效率提升30%。

目前,国内各大厂商也相继发布了面向AI大模型场景的存储方案。

2023年7月,华为发布两款面向AI大模型的存储产品——OceanStor A310深度学习数据湖存储和FusionCube A3000训/推超融合一体机。

2023年11月云栖大会上,阿里云推出一系列针对大模型场景的存储产品创新,用AI技术赋能AI业务,帮助用户更轻松地管理大规模多模态数据集,提高模型训练、推理的效率和准确性。

2023年12月,百度智能云发布了“百度沧海·存储”统一技术底座,同时面向数据湖存储和AI存储能力进行了全面增强。

2024年4月,腾讯云宣布云存储解决方案面向AIGC场景全面升级,针对AI大模型数据采集清洗、训练、推理、数据治理全流程提供全面、高效的云存储支持。

综合各大厂商的存储技术创新,可以发现技术方向较为统一,都是基于AI大模型生产研发的全流程,对存储产品进行有针对性的性能优化。

以腾讯云为例,在数据采集与清洗环节,首先需要存储能够支持多协议、高性能、大带宽。

因此,腾讯云对象存储COS能够支持单集群管理百 EB 级别存储规模,提供便捷、高效的数据公网接入能力,并支持多种协议,充分支持大模型PB级别的海量数据采集。

同时,数据清洗时,大数据引擎需要快速地读取并过滤出有效数据。腾讯云对象存储COS通过自研数据加速器GooseFS提升数据访问性能,实现了高达数TBps的读取带宽,支撑计算高速运行,大大提升数据清洗效率。

在模型训练环节,通常需要每2-4小时保存一次训练成果,以便能在GPU故障时时能回滚。

腾讯云自主研发并行文件存储CFS Turbo ,面向AIGC训练场景的进行了专门优化,每秒总读写吞吐达到TiB/s级别,每秒元数据性能高达百万OPS,均为业界第一。3TB checkpoint 写入时间从10分钟,缩短至10秒内,使大模型训练效率大幅提升。

大模型推理场景对数据安全与可追溯性提出更高要求。

腾讯云数据万象CI为此提供图片隐式水印、AIGC内容审核、智能数据检索MetaInsight等能力,为数据生产从“用户输入——预处理——内容审核——版权保护——安全分发——信息检索”业务全流程提供有力支撑,优化AIGC内容生产与管理模式,顺应监管导向,拓宽存储边界。

同时,随着训练数据和推理数据的增长,需要提供低成本的存储能力,减少存储开销。腾讯云对象存储服务提供了高达12个9的数据持久性和99.995%的数据可用性,能够为业务提供持续可用的存储服务。

总的来说,随着AI大模型的推进,数据存储出现了新的趋势。市场渴望更高性能、大容量、低成本的存储产品,并加速大模型各个环节的融合和效率提升。

而各大厂商也在通过技术创新不断满足大模型各环节的需求,为企业实施大模型降低门槛。

在AI大模型的倒逼下,存储创新已在路上。

【关于科技云报道】

专注于原创的企业级内容行家——科技云报道。成立于2015年,是前沿企业级IT领域Top10媒体。获工信部权威认可,可信云、全球云计算大会官方指定传播媒体之一。深入原创报道云计算、大数据、人工智能、区块链等领域。

审核编辑 黄宇

-

存储

+关注

关注

13文章

4701浏览量

89582 -

AI

+关注

关注

89文章

38184浏览量

296972 -

腾讯云

+关注

关注

0文章

224浏览量

17383 -

AIGC

+关注

关注

1文章

391浏览量

3153 -

大模型

+关注

关注

2文章

3454浏览量

4974

发布评论请先 登录

国产AI芯片真能扛住“算力内卷”?海思昇腾的这波操作藏了多少细节?

霄云科技银河存储:重构AI时代的存储新范式

ai_cube训练模型最后部署失败是什么原因?

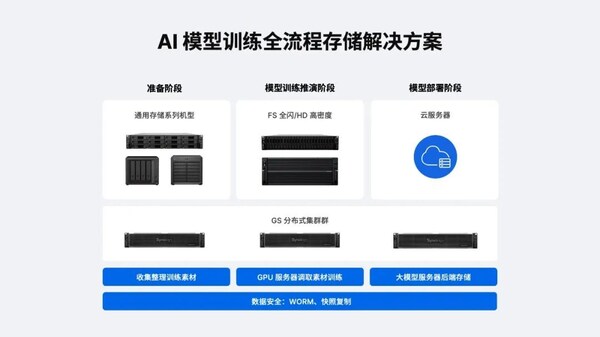

群晖发布AI模型全流程存储解决方案,破局训练效率与数据孤岛难题

AI大模型疯长,存储扛住了吗?

AI大模型疯长,存储扛住了吗?

评论