论文标题:

DropPos: Pre-Training Vision Transformers by Reconstructing Dropped Positions

论文链接:https://arxiv.org/pdf/2309.03576

代码链接:https://github.com/Haochen-Wang409/DropPos

今天介绍我们在自监督视觉预训练领域的一篇原创工作,目前 DropPos 已被 NeurIPS 2023 接收,相关代码已开源,有任何问题欢迎在 GitHub 提出。

TL;DR

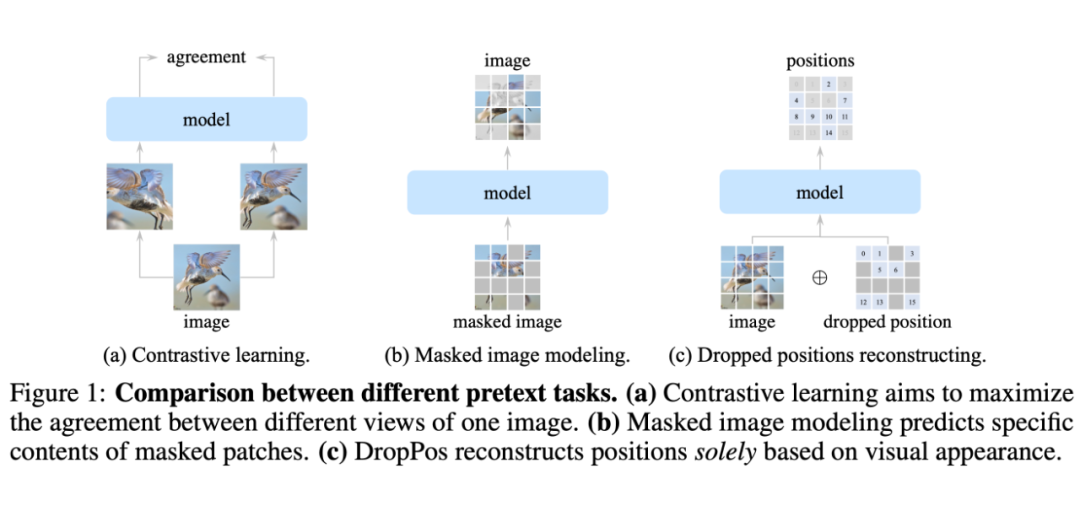

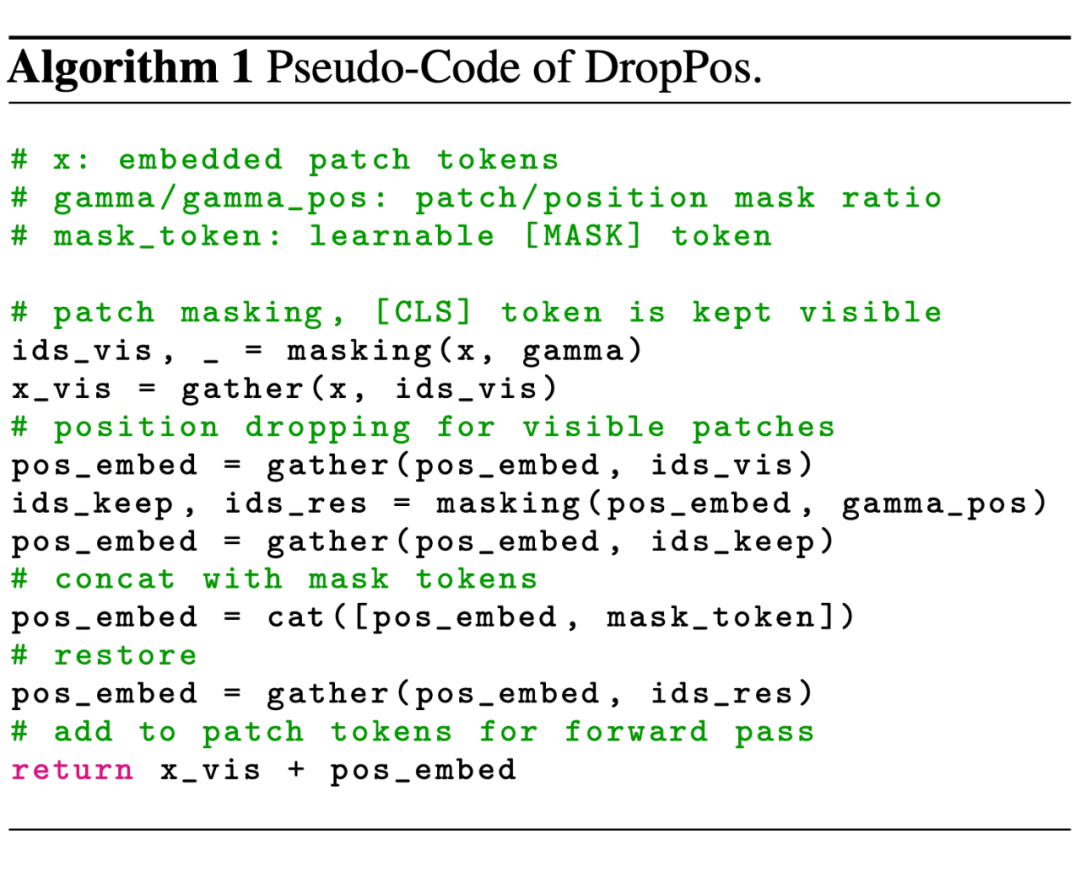

我们提出了一种全新的自监督代理任务 DropPos,首先在 ViT 前向过程中屏蔽掉大量的 position embeddings(PE),然后利用简单的 cross-entropy loss 训练模型,让模型重建那些无 PE token 的位置信息。这个及其简单的代理任务就能在多种下游任务上取得有竞争力的性能。

Motivation

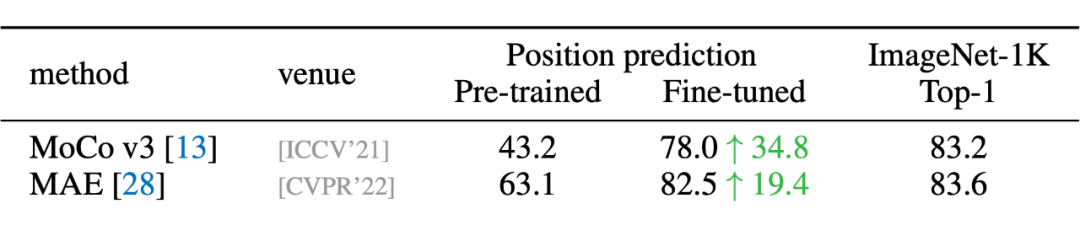

在 MoCo v3 的论文中有一个很有趣的现象:ViT 带与不带 position embedding,在 ImageNet 上的分类精度相差无几。

- 对比 CL,DropPos 不需要精心设计的数据增强(例如 multi-crop)。

- 对比 MIM,DropPos 不需要精心设计的掩码策略和重建目标。

Method

- 如果简单地把所有 PE 丢弃,让模型直接重建每个 patch 的位置,会导致上下游的 discrepency。因为下游任务需要 PE,而上游预训练的模型又完全没见过 PE。

- ViT 对于 long-range 的建模能力很强,这个简单的位置重建任务可能没办法让模型学到非常 high-level 的语义特征。

-

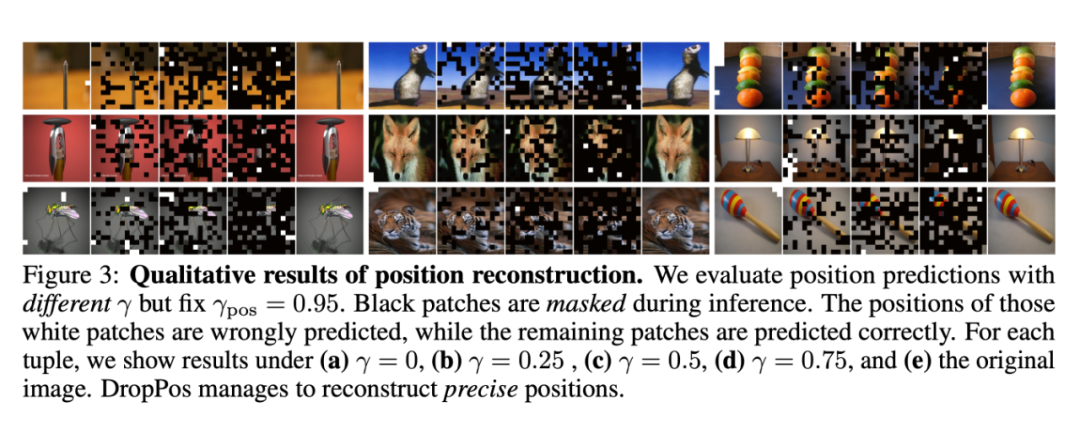

看上去相似的不同 patch(例如纯色的背景)的位置无需被精准重建,因此决定哪些 patch 的位置需要被重建非常关键。

- 针对问题一,我们采用了一个简单的随机丢弃策略。每次训练过程中丢弃 75% 的 PE,保留 25% 的 PE。

- 针对问题二,我们采取了高比例的 patch mask,既能提高代理任务的难度,又能加快训练的速度。

- 针对问题三,我们提出了 position smoothing 和 attentive reconstruction 的策略。

3.1 DropPos 前向过程

3.2 Objective

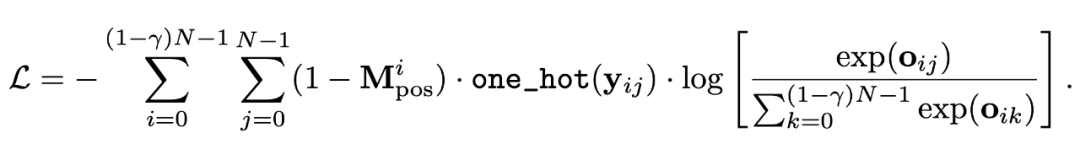

我们使用了一个最简单的 cross-entropy loss 作为预训练的目标函数:

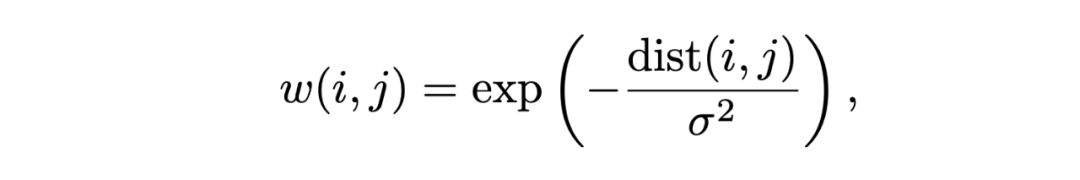

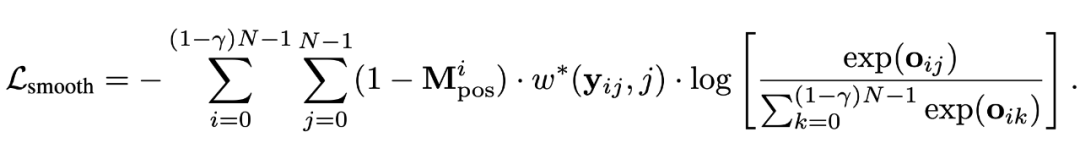

此处,w(i, j) 表示当真实位置为 i,而预测位置为 j 时,平滑后的 position target。

此外,我们还让 sigma 自大变小,让模型一开始不要过分关注精确的位置重建,而训练后期则越来越关注于精准的位置重建。

3.2.2 Attentive Reconstruction

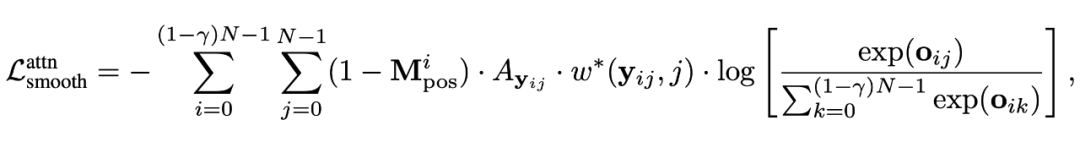

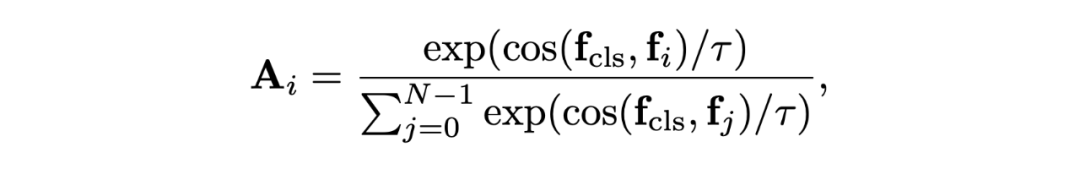

我们采用 [CLS] token 和其他 patch 的相似度作为亲和力矩阵,作为目标函数的额外权重。

此处,w(i, j) 表示当真实位置为 i,而预测位置为 j 时,平滑后的 position target。

此外,我们还让 sigma 自大变小,让模型一开始不要过分关注精确的位置重建,而训练后期则越来越关注于精准的位置重建。

3.2.2 Attentive Reconstruction

我们采用 [CLS] token 和其他 patch 的相似度作为亲和力矩阵,作为目标函数的额外权重。

其中 f 为不同 token 的特征,tau 为超参数,控制了 affinity 的平滑程度。

其中 f 为不同 token 的特征,tau 为超参数,控制了 affinity 的平滑程度。

Experiments

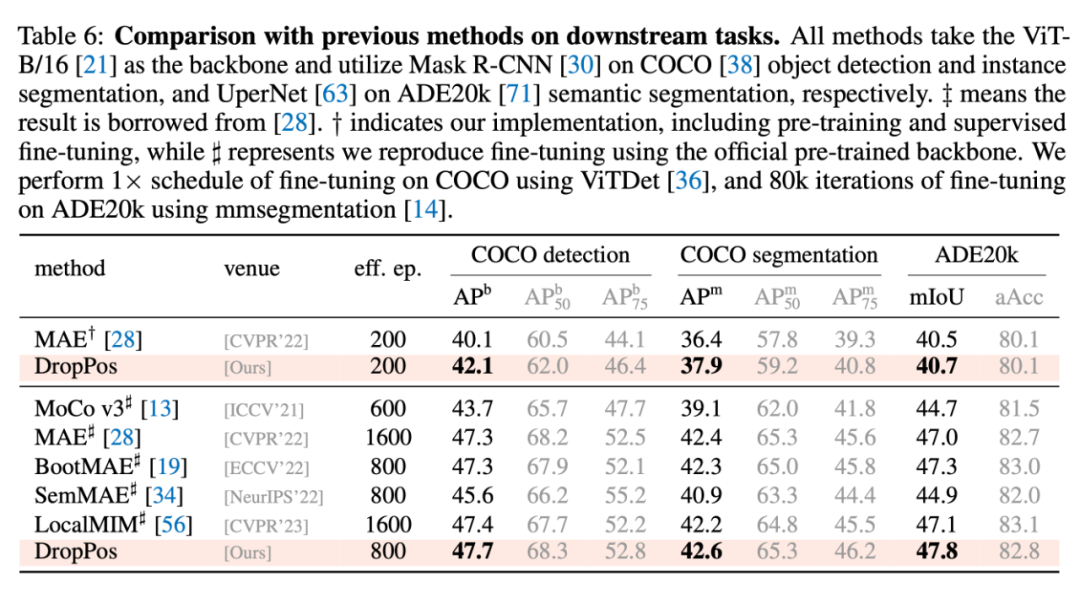

4.1 与其他方法的对比

4.2 消融实验

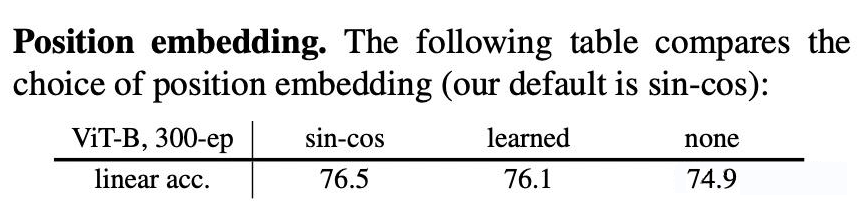

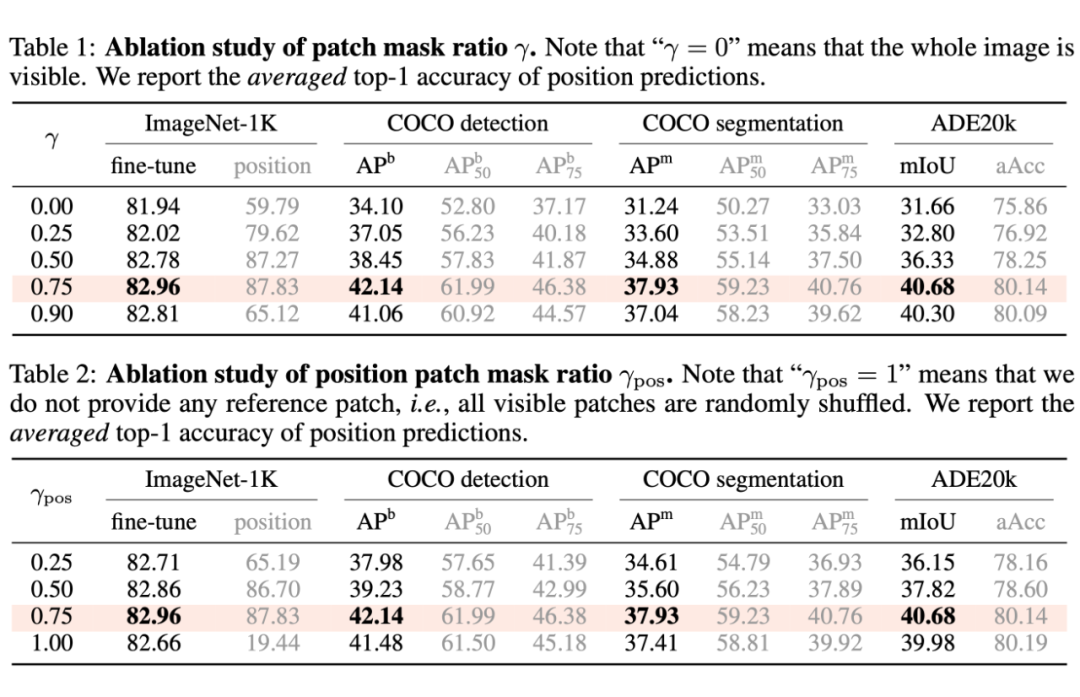

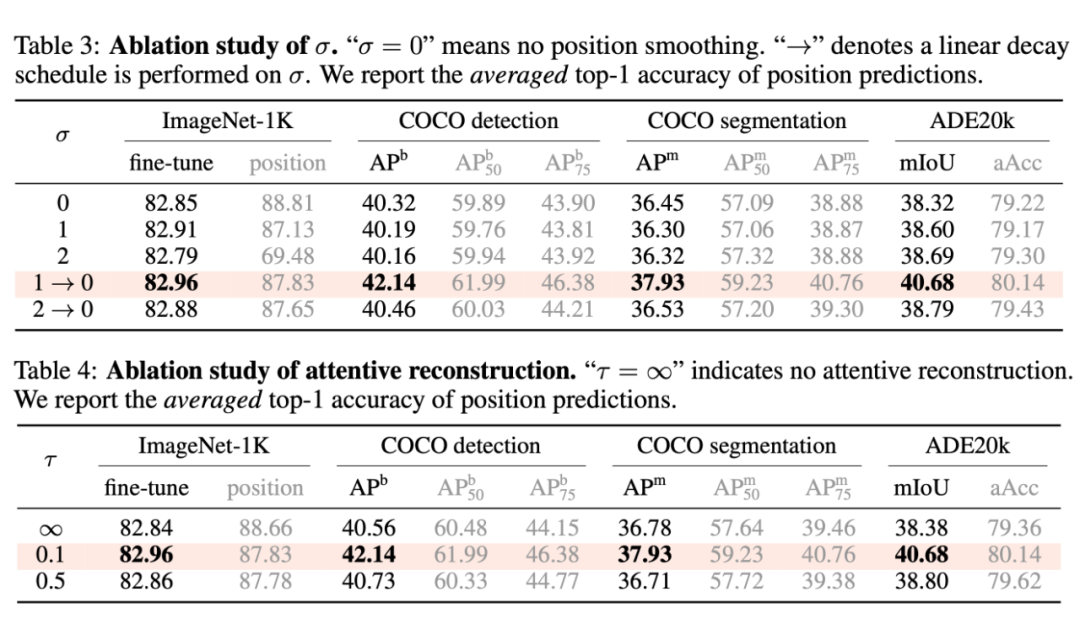

本文主要有四个超参:patch mask ratio(gamma),position mask ratio(gamma_pos),sigma,和 tau。

由表,我们可以得出一些比较有趣的结论:

由表,我们可以得出一些比较有趣的结论:

- 一般来说,更高的 position 重建精度会带来更高的下游任务性能。

- 上述结论存在例外:当 sigma = 0 时,即不做位置平滑时,位置预测精度高,而下游任务表现反而低;当 tau = inf 时,即不做 attentive reconstruction 时,位置预测精度高,而下游表现反而低。

-

因此,过分关注于预测每一个 patch 的精确的位置,会导致局部最优,对于下游任务不利。

原文标题:NeurIPS 2023 | 全新的自监督视觉预训练代理任务:DropPos

文章出处:【微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

-

物联网

+关注

关注

2939文章

47319浏览量

407881

原文标题:NeurIPS 2023 | 全新的自监督视觉预训练代理任务:DropPos

文章出处:【微信号:tyutcsplab,微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

【团购】独家全套珍藏!龙哥LabVIEW视觉深度学习实战课(11大系列课程,共5000+分钟)

【团购】独家全套珍藏!龙哥LabVIEW视觉深度学习实战可(11大系列课程,共5000+分钟)

基于大规模人类操作数据预训练的VLA模型H-RDT

信捷视觉平台全新升级

科通技术与RealSense签署代理协议

用PaddleNLP为GPT-2模型制作FineWeb二进制预训练数据集

从Open Model Zoo下载的FastSeg大型公共预训练模型,无法导入名称是怎么回事?

用PaddleNLP在4060单卡上实践大模型预训练技术

DeepSeek推出NSA机制,加速长上下文训练与推理

【「基于大模型的RAG应用开发与优化」阅读体验】+大模型微调技术解读

基于移动自回归的时序扩散预测模型

知行科技大模型研发体系初见效果

NeurIPS 2023 | 全新的自监督视觉预训练代理任务:DropPos

NeurIPS 2023 | 全新的自监督视觉预训练代理任务:DropPos

评论