扩散模型(diffusion model)在 CV 领域甚至 NLP 领域都已经有了令人印象深刻的表现。最近的一些工作开始将 diffusion model 用于强化学习(RL)中来解决序列决策问题,它们主要利用 diffusion model 来建模分布复杂的轨迹或提高策略的表达性。

但是, 这些工作仍然局限于单一任务单一数据集,无法得到能同时解决多种任务的通用智能体。那么,diffusion model 能否解决多任务强化学习问题呢?我们最近提出的一篇新工作——“Diffusion Model is an Effective Planner and Data Synthesizer for Multi-Task Reinforcement Learning”,旨在解决这个问题并希望启发后续通用决策智能的研究:

论文链接:

https://arxiv.org/abs/2305.18459

背景

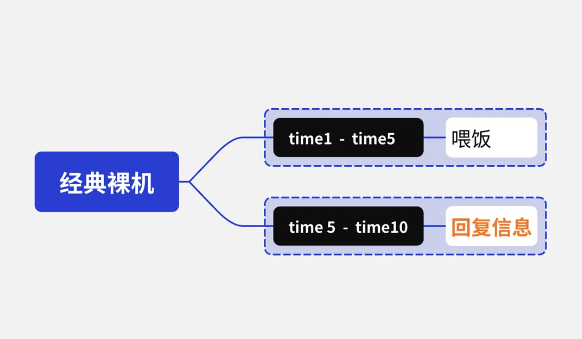

数据驱动的大模型在 CV 和 NLP 领域已经获得巨大成功,我们认为这背后源于模型的强表达性和数据集的多样性和广泛性。基于此,我们将最近出圈的生成式扩散模型(diffusion model)扩展到多任务强化学习领域(multi-task reinforcement learning),利用 large-scale 的离线多任务数据集训练得到通用智能体。 目前解决多任务强化学习的工作大多基于 Transformer 架构,它们通常对模型的规模,数据集的质量都有很高的要求,这对于实际训练来说是代价高昂的。基于 TD-learning 的强化学习方法则常常面临 distribution-shift 的挑战,在多任务数据集下这个问题尤甚,而我们将序列决策过程建模成条件式生成问题(conditional generative process),通过最大化 likelihood 来学习,有效避免了 distribution shift 的问题。

方法

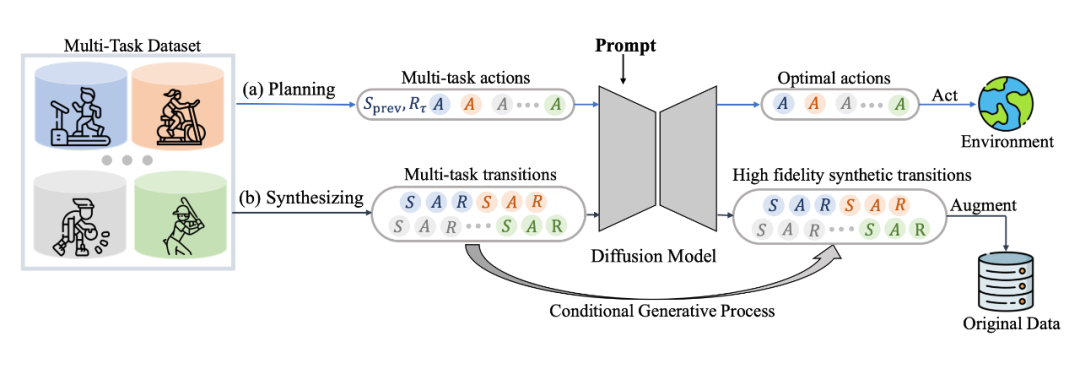

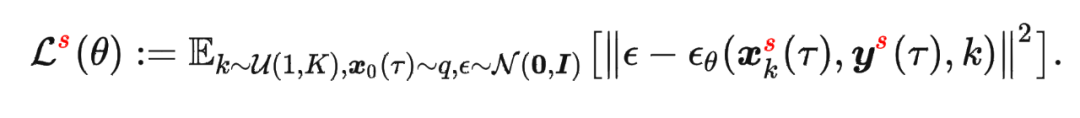

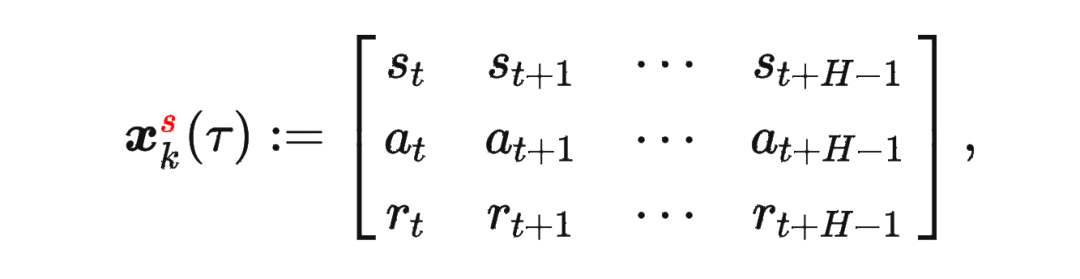

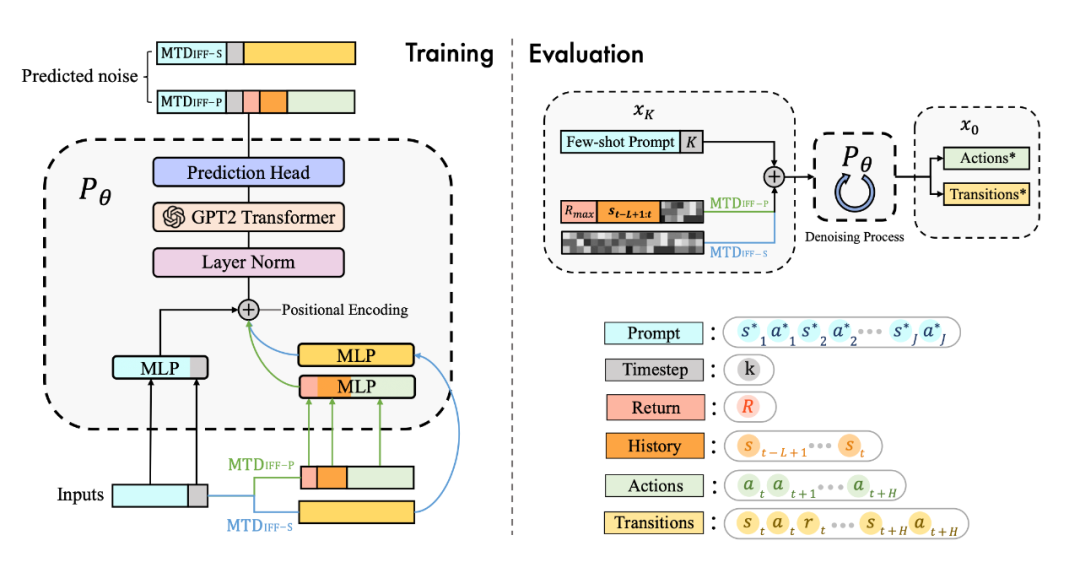

具体来说,我们发现 diffusion model 不仅能很好地输出 action 进行实时决策,同样能够建模完整的(s,a,r,s')的 transition 来生成数据进行数据增强提升强化学习策略的性能,具体框架如图所示:

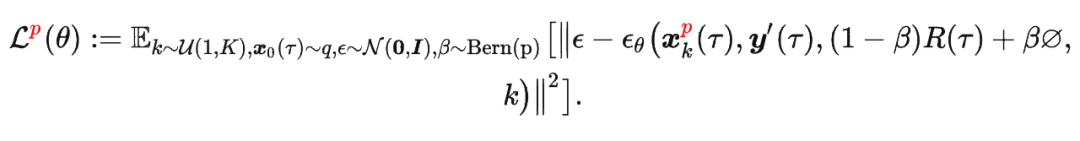

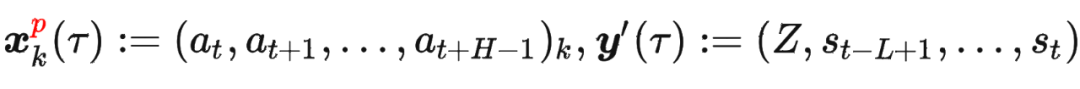

其中

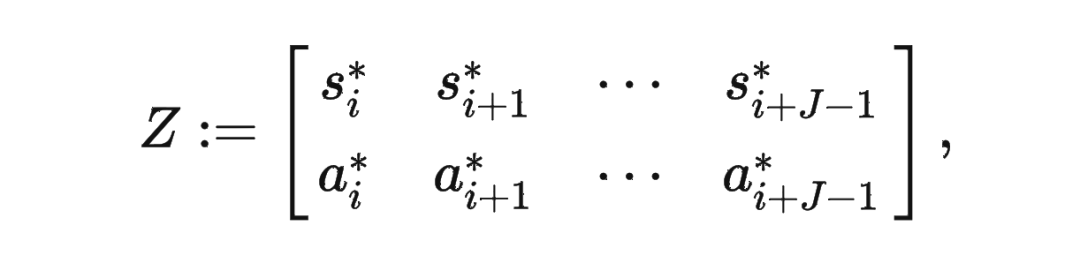

其中 是轨迹的标准化累积回报, 是 Demonstration Prompt,可以表示为:

是轨迹的标准化累积回报, 是 Demonstration Prompt,可以表示为:

其中

其中

模型结构

为了更好地建模多任务数据,并且统一多样化的输入数据,我们用 transformer 架构替换了传统的 U-Net 网络,网络结构图如下:

实验

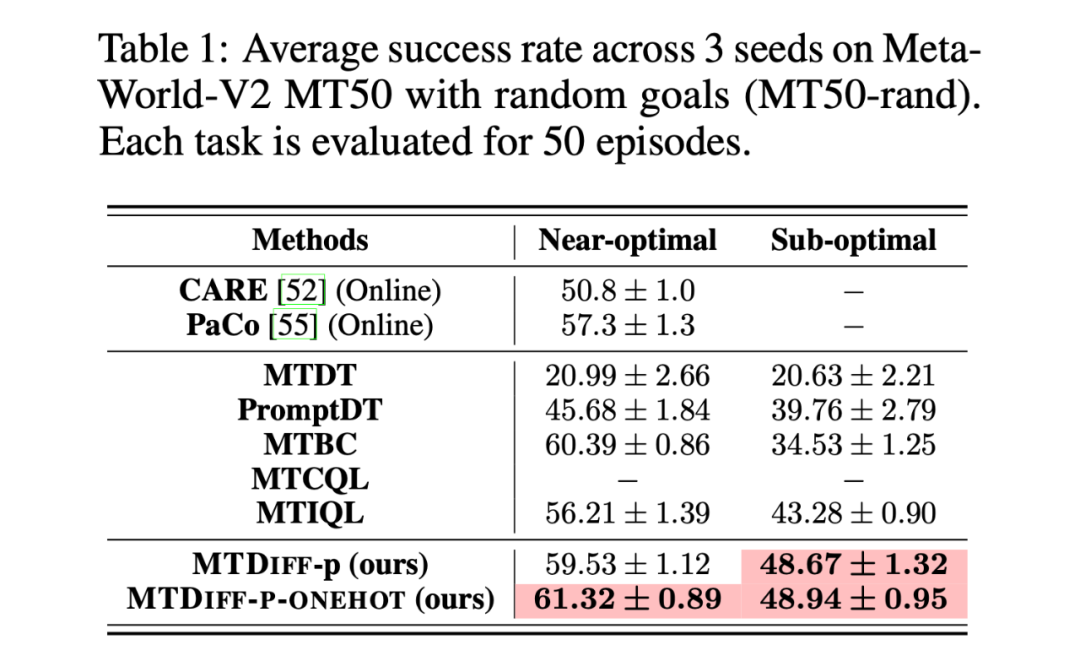

我们首先在 Meta-World MT50 上开展实验并与 baselines 进行比较,我们在两种数据集上进行实验,分别是包含大量专家数据,从 SAC-single-agent 中的 replay buffer 中收集到的 Near-optimal data(100M);以及从 Near-optimal data 中降采样得到基本不包含专家数据的 Sub-optimal data(50M)。实验结果如下:

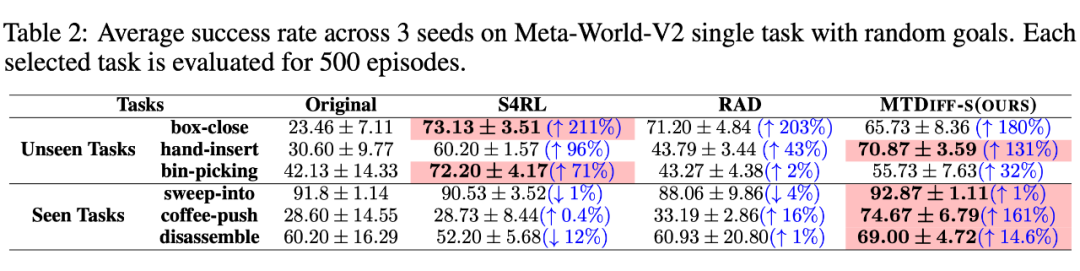

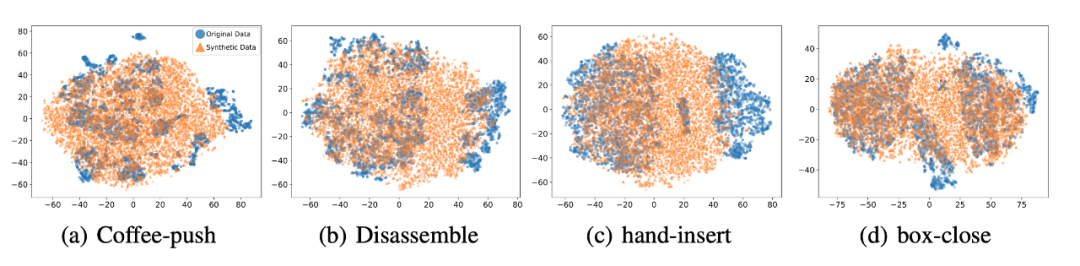

我们选取 45 个任务的 Near-optimal data 训练 ,从表中我们可以观察到在 见过的任务上,我们的方法均取得了最好的性能。甚至给定一段 demonstration prompt, 能泛化到没见过的任务上并取得较好的表现。我们选取四个任务对原数据和 生成的数据做 T-SNE 可视化分析,发现我们生成的数据的分布基本匹配原数据分布,并且在不偏离的基础上扩展了分布,使数据覆盖更加全面。

我们选取 45 个任务的 Near-optimal data 训练 ,从表中我们可以观察到在 见过的任务上,我们的方法均取得了最好的性能。甚至给定一段 demonstration prompt, 能泛化到没见过的任务上并取得较好的表现。我们选取四个任务对原数据和 生成的数据做 T-SNE 可视化分析,发现我们生成的数据的分布基本匹配原数据分布,并且在不偏离的基础上扩展了分布,使数据覆盖更加全面。

总结

我们提出了一种基于扩散模型(diffusion model)的一种新的、通用性强的多任务强化学习解决方案,它不仅可以通过单个模型高效完成多任务决策,而且可以对原数据集进行增强,从而提升各种离线算法的性能。我们未来将把 迁移到更加多样、更加通用的场景,旨在深入挖掘其出色的生成能力和数据建模能力,解决更加困难的任务。同时,我们会将 迁移到真实控制场景,并尝试优化其推理速度以适应某些需要高频控制的任务。

原文标题:NeurIPS 2023 | 扩散模型解决多任务强化学习问题

文章出处:【微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

物联网

+关注

关注

2939文章

47324浏览量

407924

原文标题:NeurIPS 2023 | 扩散模型解决多任务强化学习问题

文章出处:【微信号:tyutcsplab,微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

热点推荐

如何训练好自动驾驶端到端模型?

[首发于智驾最前沿微信公众号]最近有位小伙伴在后台留言提问:端到端算法是怎样训练的?是模仿学习、强化学习和离线强化学习这三类吗?其实端到端(end-to-end)算法在自动驾驶、智能体决策系统里

今日看点:智元推出真机强化学习;美国软件公司SAS退出中国市场

智元推出真机强化学习,机器人训练周期从“数周”减至“数十分钟” 近日,智元机器人宣布其研发的真机强化学习技术,已在与龙旗科技合作的验证产线中成功落地。据介绍,此次落地的真机强化学习方案,机器人

发表于 11-05 09:44

•897次阅读

自动驾驶中常提的“强化学习”是个啥?

[首发于智驾最前沿微信公众号]在谈及自动驾驶时,有些方案中会提到“强化学习(Reinforcement Learning,简称RL)”,强化学习是一类让机器通过试错来学会做决策的技术。简单理解

爱普科技PSRAM加速wisun无线模块多任务处理

爱普科技256Mb PSRAM(如APS256XXN-OBR-BG)为WiSUN无线模块提供高速数据缓存与临时存储解决方案,其166MHz速率、1.8V低功耗及小尺寸封装显著提升模块在智能电网、工业自动化中的多任务处理能力和稳定性。

速看!EASY-EAI教你离线部署Deepseek R1大模型

1.Deepseek简介DeepSeek-R1,是幻方量化旗下AI公司深度求索(DeepSeek)研发的推理模型。DeepSeek-R1采用强化学习进行后训练,旨在提升推理能力,尤其擅长数学、代码

NVIDIA Isaac Lab可用环境与强化学习脚本使用指南

Lab 是一个适用于机器人学习的开源模块化框架,其模块化高保真仿真适用于各种训练环境,Isaac Lab 同时支持模仿学习(模仿人类)和强化学习(在尝试和错误中进行学习),为所有机器

快速入门——LuatOS:sys库多任务管理实战攻略!

在嵌入式开发中,多任务管理是提升系统效率的关键。本教程专为快速入门设计,聚焦LuatOS的sys库,通过实战案例带你快速掌握多任务创建、调度与同步技巧。无论你是零基础新手还是希望快速提升开发效率

18个常用的强化学习算法整理:从基础方法到高级模型的理论技术与代码实现

本来转自:DeepHubIMBA本文系统讲解从基本强化学习方法到高级技术(如PPO、A3C、PlaNet等)的实现原理与编码过程,旨在通过理论结合代码的方式,构建对强化学习算法的全面理解。为确保内容

详解RAD端到端强化学习后训练范式

受限于算力和数据,大语言模型预训练的 scalinglaw 已经趋近于极限。DeepSeekR1/OpenAl01通过强化学习后训练涌现了强大的推理能力,掀起新一轮技术革新。

了解DeepSeek-V3 和 DeepSeek-R1两个大模型的不同定位和应用选择

专业数据

注入大量数学/科学文献与合成推理数据

微调策略

多任务联合训练

推理链强化学习(RLCF)+ 符号蒸馏

推理效率

均衡优化(适合常规任务)

针对长逻辑链的并行加速技术

4. 典型应用场

发表于 02-14 02:08

【「基于大模型的RAG应用开发与优化」阅读体验】+大模型微调技术解读

Tuning)和Prompt-Tuning:通过在输入序列中添加特定提示来引导模型生成期望的输出,简单有效,适用于多种任务。P-Tuning v1和P-Tuning v2:基于多任务学习

发表于 01-14 16:51

基于移动自回归的时序扩散预测模型

回归取得了比传统基于噪声的扩散模型更好的生成效果,并且获得了人工智能顶级会议 NeurIPS 2024 的 best paper。 然而在时间序列预测领域,当前主流的扩散方法还是传统的

智谱推出深度推理模型GLM-Zero预览版

近日,智谱公司正式发布了其深度推理模型GLM-Zero的预览版——GLM-Zero-Preview。这款模型标志着智谱在扩展强化学习技术训练推理模型方面的重大突破,成为其首个专注于增强

智谱GLM-Zero深度推理模型预览版正式上线

近日,智谱公司宣布其深度推理模型GLM-Zero的初代版本——GLM-Zero-Preview已正式上线。这款模型是智谱首个基于扩展强化学习技术训练的推理模型,标志着智谱在AI推理领域

NeurIPS 2023 | 扩散模型解决多任务强化学习问题

NeurIPS 2023 | 扩散模型解决多任务强化学习问题

评论