Google DeepMind 和 Meta 的研究人员发表论文《Language Modeling Is Compression》,他们发现 DeepMind 的大语言模型 Chinchilla 70B 在图像和音频的无损压缩上超过了 PNG 和 FLAC。

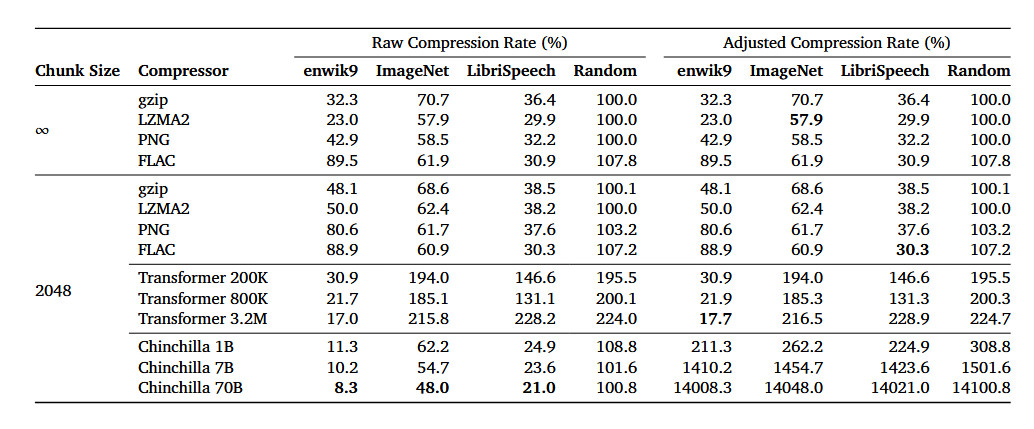

论文提到,Chinchilla 70B 能将 ImageNet 图像数据库中的图像无损压缩到原始大小 43.4%,超过了 PNG 算法的 58.5%。

Chinchilla 能将 LibriSpeech 音频数据集中的样本无损压缩到原始大小 16.4%,超过 FLAC 算法的 30.3%。

据介绍,Chinchilla 70B 主要是训练用于处理文本,但它在压缩其它类型的数据集上的效果也表现优异,甚至优于专门的算法。

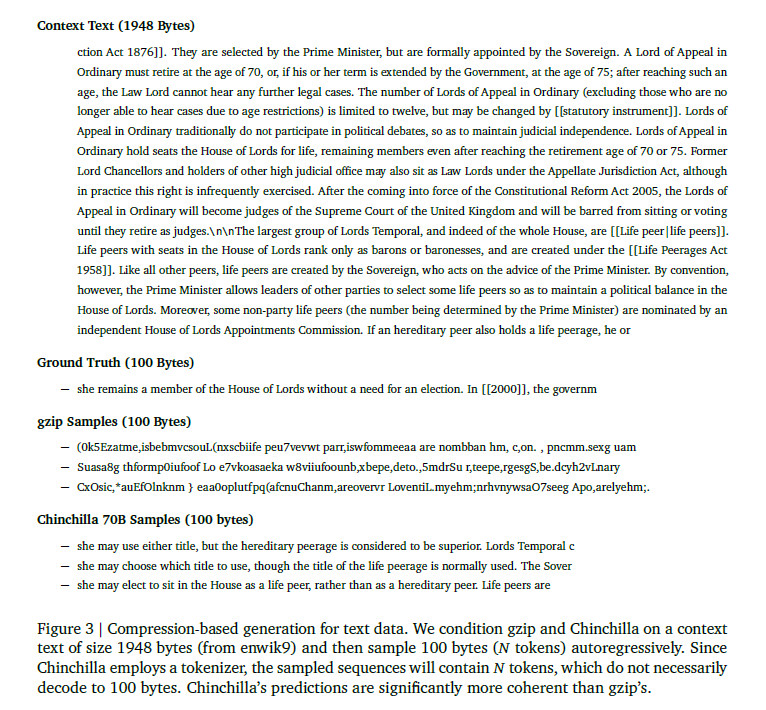

下面的例子比较了 gzip 和 Chinchilla 在示例文本上的压缩效果。可以看到,gzip 的输出没有可读性。

编辑:黄飞

-

无损压缩

+关注

关注

0文章

12浏览量

8586 -

FLAC

+关注

关注

0文章

4浏览量

8730 -

png

+关注

关注

0文章

14浏览量

4675 -

大模型

+关注

关注

2文章

3440浏览量

4967

原文标题:大模型在无损压缩方面超越PNG和FLAC

文章出处:【微信号:OSC开源社区,微信公众号:OSC开源社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

3万字长文!深度解析大语言模型LLM原理

利用自压缩实现大型语言模型高效缩减

小白学大模型:从零实现 LLM语言模型

VLM(视觉语言模型)详细解析

Optimum Intel / NNCF在重量压缩中选择FP16模型的原因?

小白学大模型:训练大语言模型的深度指南

大语言模型的解码策略与关键优化总结

腾讯公布大语言模型训练新专利

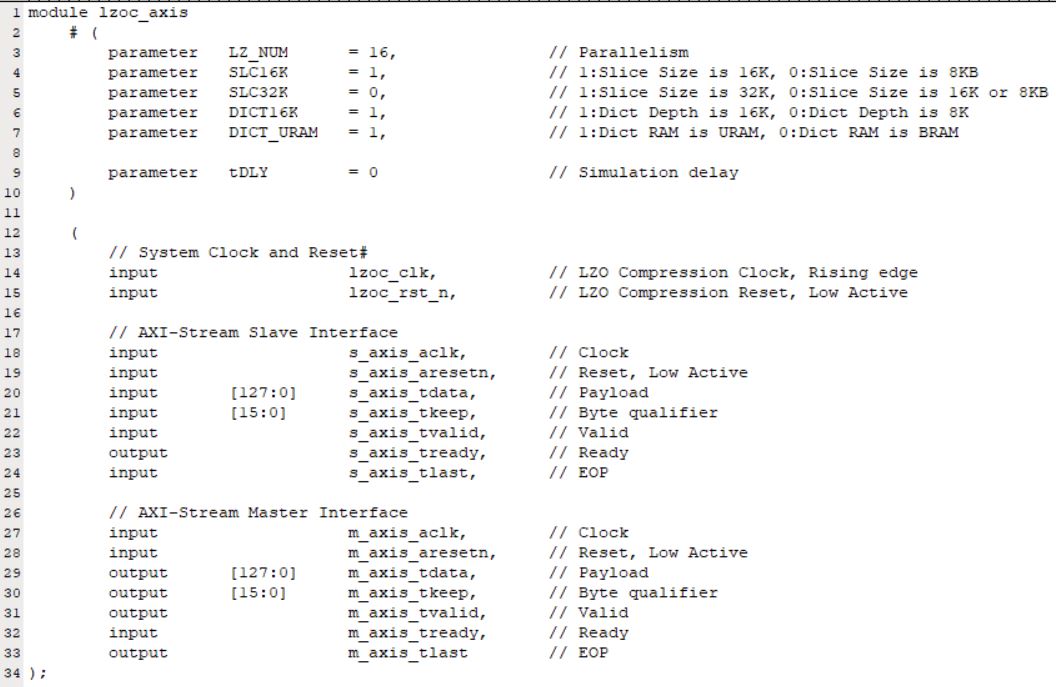

LZO Data Compression,高性能LZO无损数据压缩加速器介绍,FPGA&ASIC

2025年:大模型Scaling Law还能继续吗

LZO Data Compression,高性能LZO无损数据压缩加速器介绍,FPGA&ASIC

大语言模型无损压缩方面超越PNG和FLAC

大语言模型无损压缩方面超越PNG和FLAC

评论