TLDR: 视频分割一直是重标注的一个task,这篇CVPR 2023文章研究了完全不需要标注的视频物体分割。仅使用ResNet,RCF模型在DAVIS16/STv2/FBMS59上提升了7/9/5%。文章里还提出了不需要标注的调参方法。代码已公开可用。

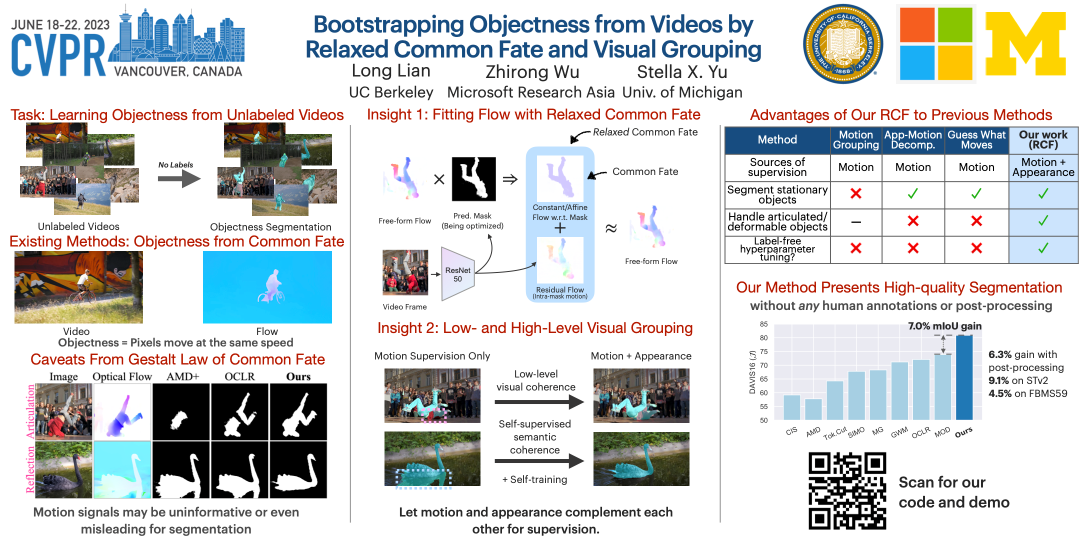

Paper title: Bootstrapping Objectness from Videos by Relaxed Common Fate and Visual Grouping

arXiv: https://arxiv.org/abs/2304.08025

作者机构:UC Berkeley, MSRA, UMich

Project page: https://rcf-video.github.io/

Code and models: https://github.com/TonyLianLong/RCF-UnsupVideoSeg

视频物体分割真的可以不需要人类监督吗?

视频分割一直是重标注的一个task,可是要标出每一帧上的物体是非常耗时费力的。然而人类可以轻松地分割移动的物体,而不需要知道它们是什么类别。为什么呢?

Gestalt定律尝试解释人类是怎么分割一个场景的,其中有一条定律叫做Common Fate,即移动速度相同的物体属于同一类别。比如一个箱子从左边被拖到右边,箱子上的点是均匀运动的,人就会把这个部分给分割出来理解。然而人并不需要理解这是个箱子来做这个事情,而且就算是婴儿之前没有见过箱子也能知道这是一个物体。

运用Common Fate来分割视频

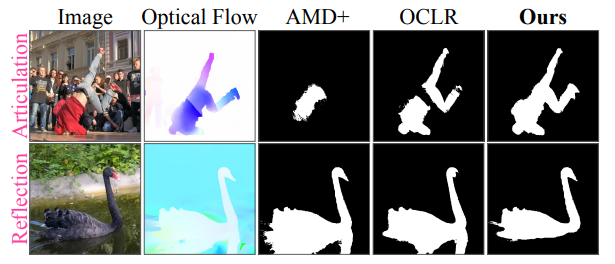

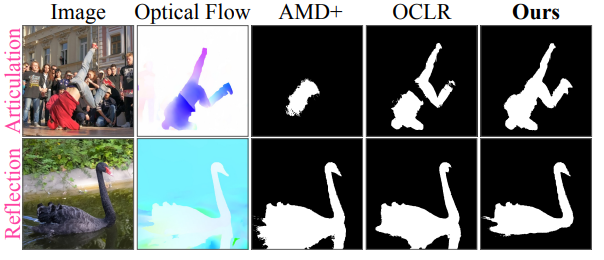

这个定律启发了基于运动的无监督分割。然而,Common Fate并不是物体性质的可靠指标:关节可动 (articulated) /可变形物体 (deformable objects) 的一些part可能不以相同速度移动,而物体的阴影/反射 (shadows/reflections) 始终随物体移动,但并非其组成部分。

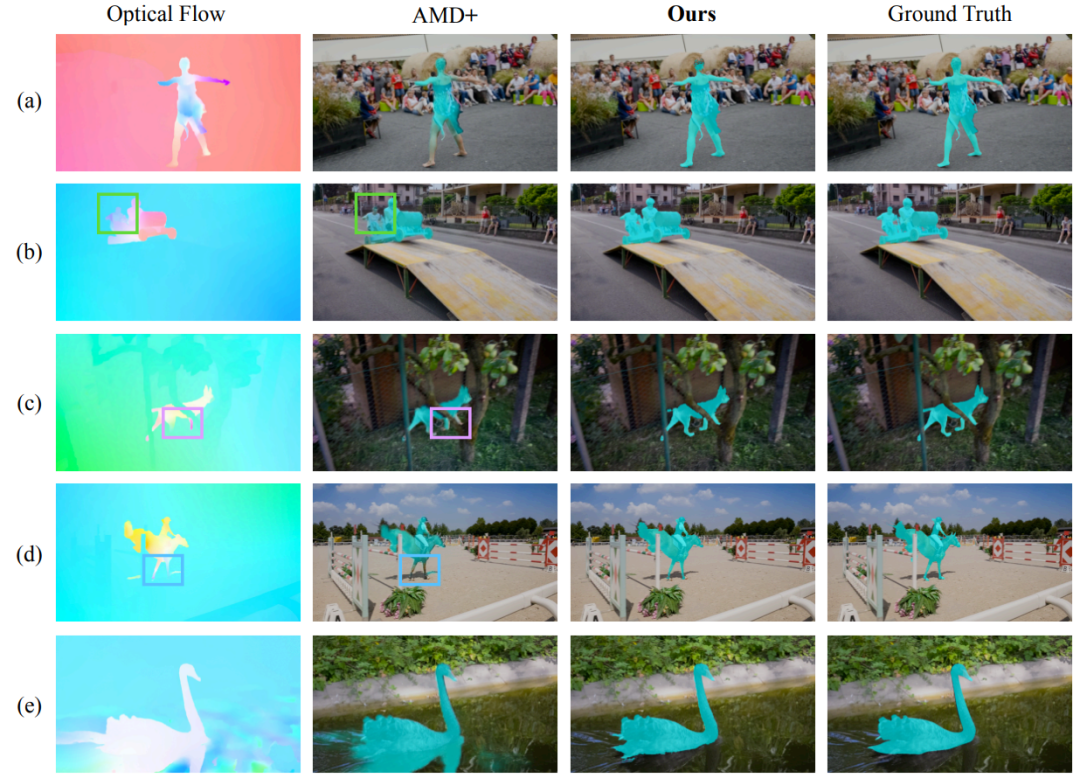

举个例子,下面这个人的腿和身子的运动是不同的(Optical Flow可视化出来颜色不同)。这很常见,毕竟人有关节嘛 (articulated),要是这个处理不了的话,很多视频都不能分割了。然而很多baseline是处理不了这点的(例如AMD+和OCLR),他们把人分割成了几个部分。

还有就是影子和反射,比如上面这只天鹅,它的倒影跟它的运动是一致的(Optical Flow可视化颜色一样),所以之前的方法认为天鹅跟倒影是一个物体。很多视频里是有这类现象的(毕竟大太阳下物体都有个影子嘛),如果这个处理不了的话,很多视频也不能分割了。

那怎么解决?放松。Relax.

长话短说,那我们的方法是怎么解决这个问题的呢?无监督学习的一个特性是利用神经网络自己内部的泛化和拟合能力进行学习。既然Common Fate有自己的问题,那么我们没有必要强制神经网络去拟合Common Fate。于是我们提出了Relaxed Common Fate,通过一个比较弱的学习方式让神经网络真正学到物体的特性而不是noise。

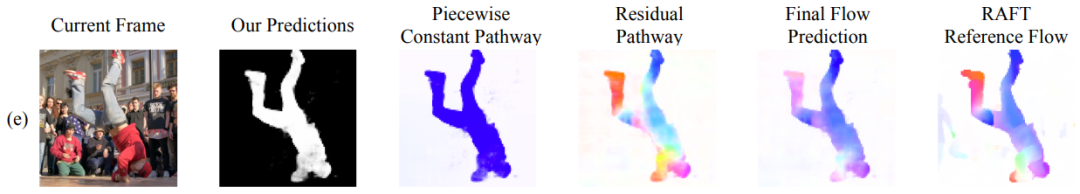

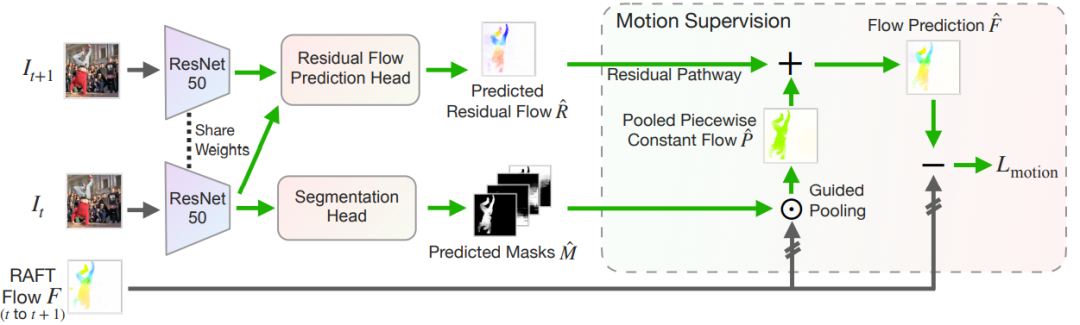

具体来说,我们的方法认为物体运动由两部分组成:物体总体的piecewise-constant motion (也就是Common Fate)和物体内部的segment motion。比如你看下图这个舞者,他全身的运动就可以被理解成piecewise-constant motion来建模,手部腿部这些运动就可以作为residual motion进行拟合,最后合并成一个完整的flow,跟RAFT生成的flow进行比较来算loss。我们用的RAFT是用合成数据(FlyingChairs和FlyingThings)进行训练的,不需要人工标注。

Relaxed Common Fate

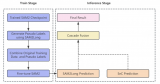

首先我们使用一个backbone来进行特征提取,然后通过一个简单的full-convolutional network获得Predicted Masks $hat{M}$(下图里的下半部分),和一般的分割框架是一样的,也可以切换成别的框架。

那我们怎么优化这些Masks呢?我们先提取、合并两帧的特征,放入一个residual flow prediction head来获得Residual Flow $hat{R}$ (下图里的上半部分)。

然后我们对RAFT获得的Flow用Predicted Masks $hat{M}$进行Guided Pooling,获得一个piecewise-constant flow,再加上预测的residual flow,就是我们的flow prediction了。最后把flow prediction和RAFT获得的Flow的差算一个L1 norm Loss进行优化,以此来学习segmentation。

在测试的时候,只有Predicted Masks $hat{M}$ 是有用的,其他部分是不用的。

这里的Residual Flow会尽量初始化得小一些,来鼓励先学piecewise-constant的部分(有点类似ControlNet),再慢慢学习residual部分。

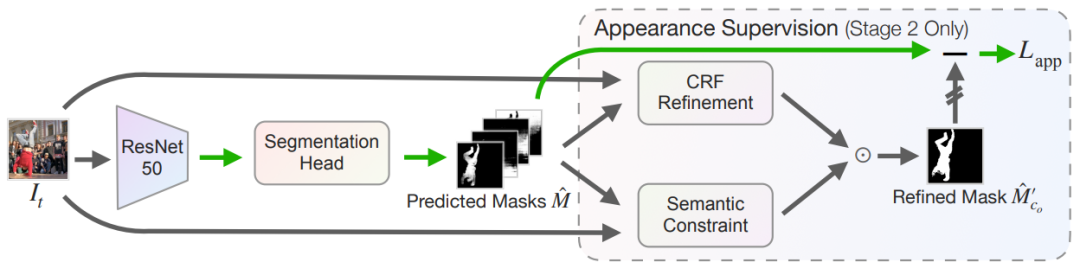

引入Appearance信息来帮助无监督视频分割

光是Relaxed Common Fate就能在DAVIS上相对baseline提5%了,但这还不够。前面说Relaxed Common Fate的只用了motion而没有使用appearance信息。

让我们再次回到上面这个例子。这个舞者的手和身子是一个颜色,然而AMD+直接把舞者的手忽略了。下面这只天鹅和倒影明明在appearance上差别这么大,却在motion上没什么差别。如果整合appearance和motion,是不是能提升分割质量呢?

因此我们引入了Appearance 来进行进一步的监督。在学习完motion信息之后,我们直接把取得的Mask进行两步优化:一个是low-level的CRF refinement,强调颜色等细节一致的地方应该属于同一个mask(或背景),一个是semantic constraint,强调Unsupervised Feature一直的地方应该属于同一个mask。

把优化完的mask再和原mask进行比较,计算L2 Loss,再更新神经网络。这样训练的模型的无监督分割能力可以进一步提升。具体细节欢迎阅读原文。

无监督调参

很多无监督方法都需要使用有标注的数据集来调参,而我们的方法提出可以利用前面说的motion和appearance的一致性来进行调参。简单地说,motion学习出的mask在appearance上不一致代表这个参数可能不是最优的。具体方法是在Unsupervised Feature上计算Normalized Cuts (但是不用算出最优值),Normalized Cuts越小越代表分割效果好。原文里面对此有详细描述。

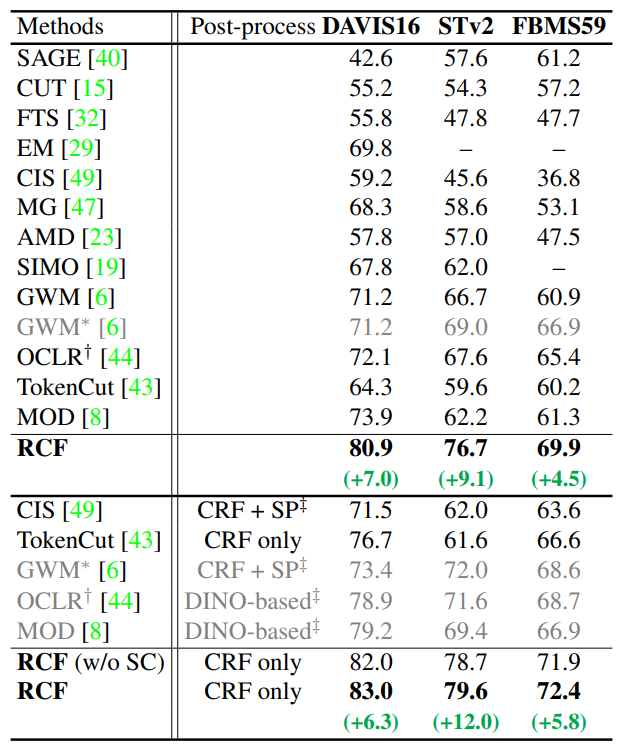

方法效果

无论是否有Post-processing,我们的方法在三个视频分割数据集上都有很大提升,在STv2上更是提升了12%。

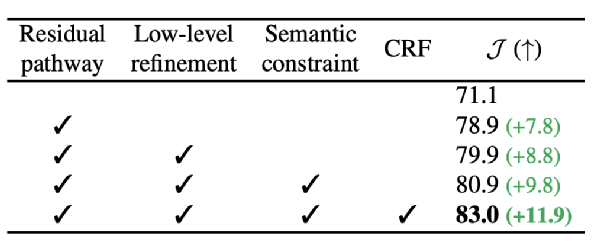

Ablation可以看出Residual pathway (Relaxed Common Fate)的贡献是最大的,其他部分总计贡献了11.9%的增长。

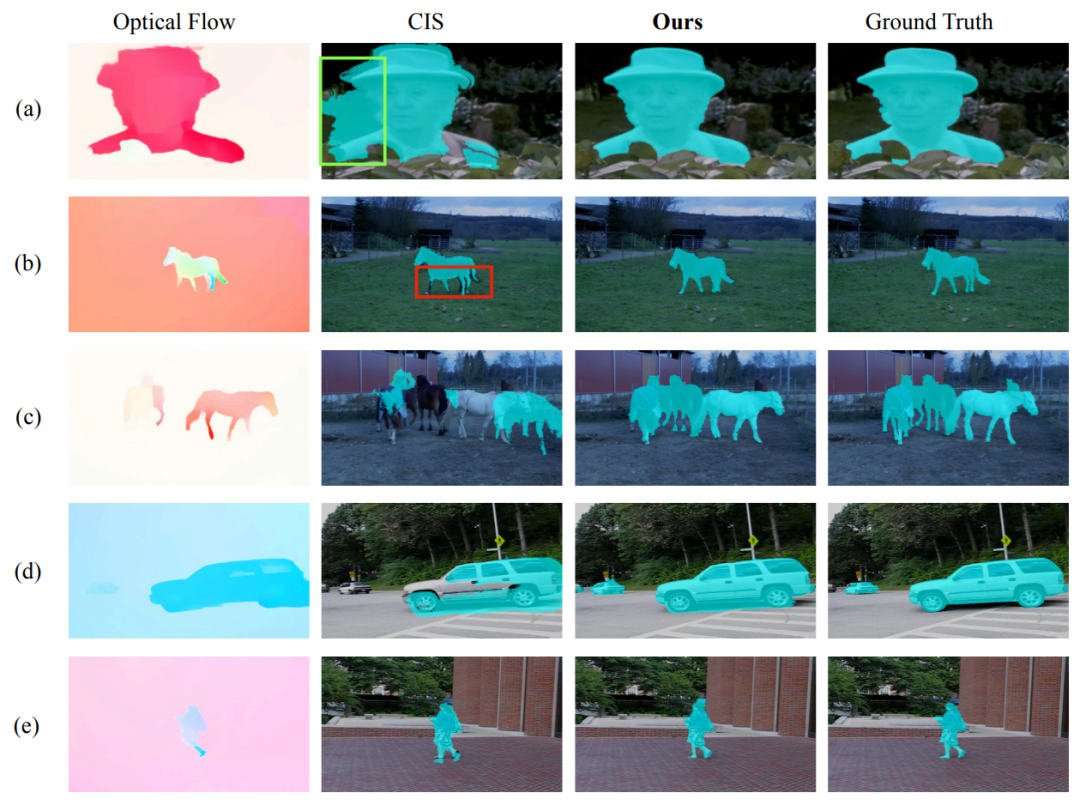

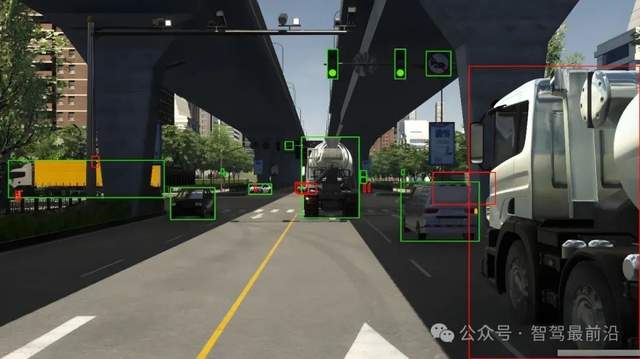

Visualizations

总结

这篇CVPR 2023文章研究了完全不需要标注的视频物体分割。通过Relaxed Common Fate来利用motion信息,再通过改进和利用appearance信息来进一步优化,RCF模型在DAVIS16/STv2/FBMS59上提升了7/9/5%。文章里还提出了不需要标注的调参方法。代码和模型已公开可用。

-

神经网络

+关注

关注

42文章

4829浏览量

106810 -

视频分割

+关注

关注

0文章

4浏览量

5877

原文标题:TLDR: 视频分割一直是重标注的一个task,这篇CVPR 2023文章研究了完全不需要标注的视频物体分割。

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

自动驾驶数据标注是所有信息都要标注吗?

浅析多模态标注对大模型应用落地的重要性与标注实例

请问AICube所需的目标检测数据集标注可以使用什么工具?

自动驾驶数据标注主要是标注什么?

什么是自动驾驶数据标注?如何好做数据标注?

东软集团入选国家数据局数据标注优秀案例

自动化标注技术推动AI数据训练革新

AI自动图像标注工具SpeedDP将是数据标注行业发展的重要引擎

ads1220 DRDY信号一直是高,怎么解决?

标贝数据标注在智能驾驶训练中的落地案例

TLDR: 视频分割一直是重标注的一个task,这篇CVPR 2023文章研究了完全不需要标注的视频物体分割。

TLDR: 视频分割一直是重标注的一个task,这篇CVPR 2023文章研究了完全不需要标注的视频物体分割。

评论