近几年,因应AI与ML应用趋势浪潮,越来越多企业开始尝试将这样的能力带到靠近数据源的边缘设备或IoT装置,来发展各种Edge AI或AIoT应用。例如结合语音指令来控制机器人作业,或是透过AI边缘摄影机来侦测机台设备有无故障。但受限于CPU效能、数据吞吐量、内存及数据储存的影响,想要在资源有限的IoT或嵌入式装置跑AI或ML推论模型,现在仍然不是一件容易的事。

近年来,一种微型机器学习新技术TinyML顺势而起,试图从优化硬件或模型来实现装置上的AI或ML应用,让ML的推论功能能够在资源有限的终端装置上来实现,可说是加速实现Edge AI或AIoT应用的重要关键。

TinyML是什么?引用GoogleTensorflow 行动部门负责人Pete Warden的定义,指的是每次执行ML模型推论时,其功耗必须小于1毫瓦(1mW)。

除了考虑到功耗,运算力不足也是实现Edge AI或AIoT应用的关键问题。以Inception v4深度学习模型为例,硬件能力需要的运算量就有240个GOPS(每秒执行10亿次运算) 但一般singleissue处理器,仅提供个位数的GOPS,甚至不只运算能力,连在内存中存取数据也会影响功耗,例如要从SRAM高速缓存来存取1TB的数据,一颗16奈米CPU每秒所消耗的功耗就超过1瓦。这些都是TinyML的挑战。

现阶段TinyML技术发展,主要是从ML模型与硬件优化来实现低功耗装置上的ML应用。归纳起来实现TinyML的5种常见ML模型架构和优化的方法,包括降低精度(Reduce Precision)、数据重复利用(Data re-use)、权重压缩(Weight compression)、转换(Transforms)、稀疏运算(Sparse computation)。

第一种作法是转换ML模型及权重的数据单元格式,来降低推论执行所需的运算量,例如将模型的权重从高精度FP32转成较低精度的FP16或INT8格式。因ML模型需要很多乘加法运算,而高精度ML模型又比低精度ML模型需要的运算量更高,也因此,改用较低精度的ML模型来执行运算,能大幅降低功耗,甚至因运算数据变少,也能因应更高的吞吐量需求。这是第一个可以运用到TinyML的方法。

除了从数据单元格式着手,减少数据重复使用是另一个可行方法。例如可以将CNN神经网络模型中经常重复使用的权重参数的数值,暂时集中存放到一处,不用每次都从内存来捞取数据,减少不必要任务处理,也能达到降低功耗的作用。

由于现在神经网络模型体积越来越大,结构越来越复杂,因推论执行需处理的模型参数数量也就越多,大量使用内存来存放这些庞大数据,也造成了不少功耗的损失,也因此有了第3种作法是,透过权重压缩技术,对于存入内存前的权重参数先进行压缩,需要时再解压缩拿来使用,,这样做好处是,一来可以减少内存的用量,二来能获得更高的带宽和更低功耗。

第4种作法则是采用转换矩阵运算domain的方式,来降低乘法运算的复杂度。一般AI或ML模型运算过程有6成以上都是矩阵的乘法运算,所以只要让乘法运算变少,就能减少运算量,这是能够降低运算和功耗的另一种方式。例如将复杂的矩阵运算domain转换到较简易Winograd卷积算法的domain做运算,就能降低乘法运算的复杂度。

最后一种方法是稀疏运算,像是运用Relu的激励函数,在CNN模型运算过程中,使其部分神经元的输出为零,可以让神经网络变得稀疏,在运算时只针对激励函数输入数值非零部分做运算,不处理数值为零的部分,透过这样的处理方式,同样能达到运算量与功耗降低的效果。

除了优化ML模型和架构外,现在硬件设计过程中,也有一些新作法,来因应TinyML需求。常见3种TinyML硬件平台,前两种是以低功耗和AI加速或优化的硬件设计为主,包括有低功耗通用SoC、低功耗micro-NPU,可分别对应到Arm Cortex-M55与Arm Ethos-U55系列IP产品。Arm Cortex-M55最大特色是支持最新的向量扩充指令,与Cortex-M44相比,在语音模型处理性能表现高出8倍之多。Arm Ethos-U55是ARM推出的另一款神经网络处理器IP产品,不仅省电,在AI处理效能获得百倍提升,甚至最新一款Arm Ethos-U6产品中,其运算能力可达到1 TOPS。

其中第3种硬件平台是采取内存运算的硬件架构平台,如Mythic IPU处理器等,就是采用闪存内运算来执行ML推论,足以支撑113M (百万)权重数量和每瓦4 TOPs运算能力。

目前TinyML技术上遇到的挑战,越来越多AI与ML应用,开始追求更高准确度,需要使用资源越来越多,包括运算、内存、功耗等,「但TinyML却又是要在有限资源下来实现或执行不同的模型或神经网络,这就是最大的Gap。」

举例来说,想要提高神经网络模型准确度,除了需要有大量的数据做训练,数据量越大需要做的矩阵运算就更多,还有大量的参数需要调整,而且随着架构越复杂,需要做很多层神经网络计算,使用海量存储器存取数据、参数和每一层计算结果。

尽管TinyML发展才刚起步,随着AIoT或Edge AI应用越来越火红,未来将会有越来越多嵌入式装置结合AI或ML功能,想要真正实现TinyML,这些装置硬件必须具备每秒兆次(trillions)的乘加法运算能力,而且这样的运算能力须考虑到硬件空间设计,还有兼顾功耗才行。

审核编辑:汤梓红

-

ARM

+关注

关注

135文章

9507浏览量

389040 -

ML

+关注

关注

0文章

154浏览量

35402 -

机器学习

+关注

关注

66文章

8541浏览量

136271 -

TinyML

+关注

关注

0文章

44浏览量

1783

原文标题:如何优化ML模型与硬件实现TinyML?Arm归纳出5种作法

文章出处:【微信号:易心Microbit编程,微信公众号:易心Microbit编程】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

构建CNN网络模型并优化的一般化建议

脉冲神经元模型的硬件实现

【技术讨论】智能戒指手势交互:如何优化PCBA成本与实现<20ms低延迟?

利用超微型 Neuton ML 模型解锁 SoC 边缘人工智能

Arm KleidiAI与XNNPack集成实现AI性能提升

基于米尔瑞芯微RK3576开发板部署运行TinyMaix:超轻量级推理框架

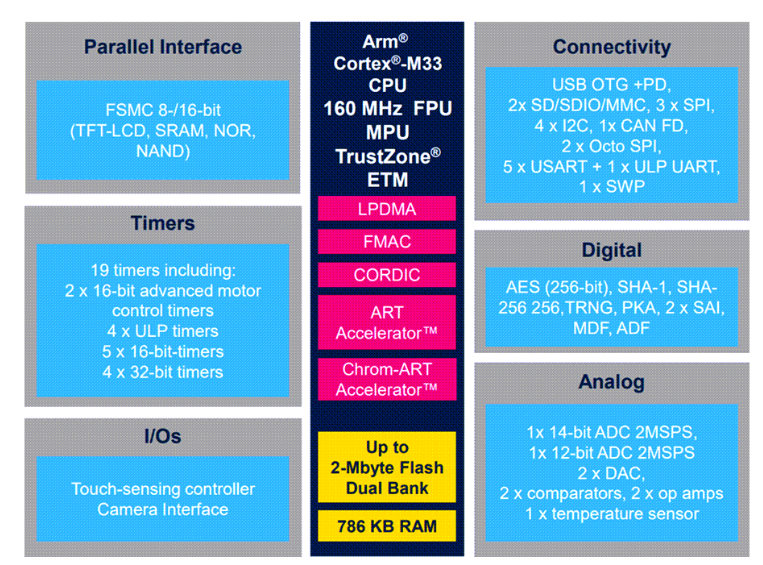

STM32U5(超低功耗MCU,支持TinyML)全面解析

Raspberry Pi Pico 2 上实现:实时机器学习(ML)音频噪音抑制功能

使用OpenVINO™进行优化后,为什么DETR模型在不同的硬件上测试时显示不同的结果?

熵基科技实现BioCV TinyML与DeepSeek大模型融合

【「基于大模型的RAG应用开发与优化」阅读体验】+Embedding技术解读

【「基于大模型的RAG应用开发与优化」阅读体验】+大模型微调技术解读

Arm Corstone-320 FVP仿真平台介绍

利用Arm Kleidi技术实现PyTorch优化

如何优化ML模型与硬件实现TinyML?Arm归纳出5种作法

如何优化ML模型与硬件实现TinyML?Arm归纳出5种作法

评论