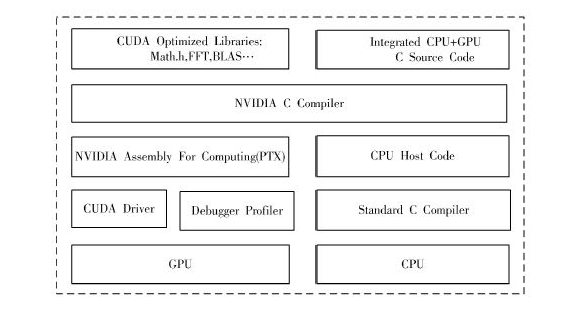

NVIDIA 推出的CUDA(计算统一设备架构)是基于GPU 进行通用计算的开发平台,非常适合大规模的并行数据计算。在GPU 流处理器架构下用CUDA 技术实现编码并行化,并针对流处理器架构特点进行

2018-01-18 07:30:00 5394

5394

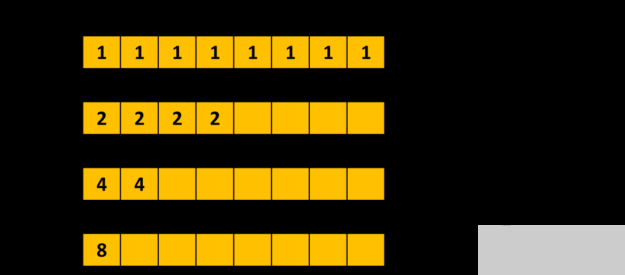

具有许多小 CUDA 内核的应用程序通常可以使用 CUDA 图进行加速,即使内核启动模式在整个应用程序中发生变化。鉴于这种动态环境,最佳方法取决于应用程序的具体情况。希望您能发现本文中描述的两个示例易于理解和实现。

2022-04-01 16:39:15 3370

3370

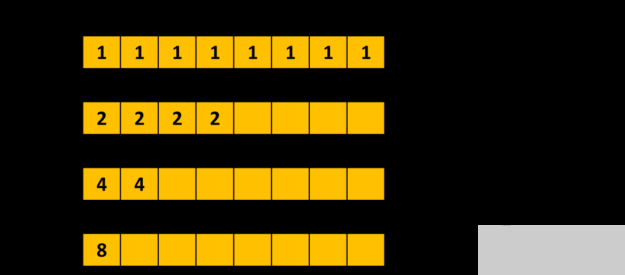

这篇文章描述了两种不同的加速矩阵乘法的方法。第一种方法使用 Numba 编译器来减少 Python 代码中与循环相关的开销。第二种方法使用 CUDA 并行化矩阵乘法。速度比较证明了 CUDA 在加速矩阵乘法方面的有效性。

2022-04-24 17:04:51 4949

4949

的梯度上,所有这些都在一个操作中完成,可以避免多次访问global memory提升算子的带宽。下面解析一下这个优化的调度逻辑和cuda实现。 https://github.com/BBuf

2023-08-24 11:15:25 643

643 OpenCV4支持通过GPU实现CUDA加速执行,实现对OpenCV图像处理程序的加速运行,当前支持加速的模块包括如下。

2023-12-05 09:56:35 364

364

是否有关于GRID vGPU的CUDA / OpenCL支持的更新信息?以上来自于谷歌翻译以下为原文Is there any updated information about CUDA/OpenCL support for GRID vGPU ?

2018-09-07 16:42:47

CUDA教程之1:Linux系统下CUDA安装教程

2020-06-02 16:53:31

Nvidia CUDA 2.0编程教程

2019-03-05 07:30:00

/m60-can-it-be-used-for-deep-learning-/我遇到了类似的问题,但它是关于M10的。我用GRID M10-8Q创建了一个虚拟机,我想在进行深度学习时使用cuda加速计算。但是,我在这里找不到特斯拉M10

2018-09-26 15:30:23

GPU 加速的 L0 范数图像平滑(L0 Smooth)【CUDA】

2020-07-08 12:10:13

我们有一个使用Grid K2机器的系统。我试图在一个vm的侧面设置cuda。当我使用驱动程序下载页面时,它指向NVIDIA-Linux-x86_64-367.57版本的驱动程序似乎工作(它们安装

2018-10-10 17:02:15

调节输出电能的形式,从而驱动电机,进而驱动车辆。这就是IGBT作为核心部件的工作原理。IGBT 功率模块是逆变器的核心功率器件。逆变器用于驱动电机,为汽车运行提供动力。当电驱动系统工作时,逆变器从电池组

2022-05-10 09:54:36

1.安装toolkit(1)cd /home/CUDA_train/software/cuda4.1(2)./cudatoolkit_4.1.28_linux_64_rhel6.x.run

2019-07-24 06:11:31

NVIDIA CUDA参考文件

2019-03-05 08:00:00

``运算卡 价格表 更新日期2014.9型号参数 价格质保备注备货情况Nvidia Tesla C2050CUDA核心频率:1.15 GHz CUDA核心数量:448双精度浮点性能(峰值):515

2014-09-09 11:38:06

你好我有一个裸机Windows 2002 RC 2 x64bit服务器,带有物理NVIDIA Grid SERIES K2卡(不是vGPU vGRID)。这张卡与CUDA兼容吗?我使用的软件没有将其

2018-09-10 17:18:51

``运算卡 价格表 更新日期2014.9型号参数 价格质保备注备货情况Nvidia Tesla C2050CUDA核心频率:1.15 GHz CUDA核心数量:448双精度浮点性能(峰值):515

2014-10-10 14:56:27

```Nvidia Tesla C2050 CUDA核心频率:1.15 GHz CUDA核心数量:448双精度浮点性能(峰值):515 Gflops单精度浮点性能(峰值):1.03 Tflops专用

2014-08-21 11:18:27

``提供个人超级计算机解决方案 高性能GPU运算服务器解决方案/集群解决方案 Nvidia Tesla C2050 CUDA核心频率:1.15 GHz CUDA核心数量:448 双精度浮点性能

2014-08-03 18:09:13

``运算卡 价格表 更新日期2014.9型号参数 价格质保备注备货情况Nvidia Tesla C2050CUDA核心频率:1.15 GHz CUDA核心数量:448双精度浮点性能(峰值):515

2014-09-09 11:31:44

``提供个人超级计算机解决方案 高性能GPU运算服务器解决方案/集群解决方案 Nvidia Tesla C2050 CUDA核心频率:1.15 GHz CUDA核心数量:448 双精度浮点性能

2014-08-26 16:36:28

`运算卡 价格表 更新日期2014.9型号参数 价格质保备注备货情况Nvidia Tesla C2050CUDA核心频率:1.15 GHz CUDA核心数量:448双精度浮点性能(峰值):515

2014-09-15 16:15:00

`运算卡 价格表 更新日期2014.9型号参数 价格质保备注备货情况Nvidia Tesla C2050CUDA核心频率:1.15 GHz CUDA核心数量:448双精度浮点性能(峰值):515

2014-09-11 12:48:26

``Nvidia Tesla C2050 "CUDA核心频率:1.15 GHz CUDA核心数量:448 双精度浮点性能(峰值):515 Gflops 单精度浮点性能(峰值

2014-09-02 21:17:41

Py之TFCudaCudnn:Win10下安装深度学习框架Tensorflow+Cuda+Cudnn最简单最快捷最详细攻略

2018-12-20 10:35:16

STM32F103C8T6核心板 ARM 32位 Cortex-M3 CPU 22.62X53.34MM

2023-06-13 18:18:05

原装正品ARM 核心板 STM32F103C8T6开发板 最小系统板 STM32

2023-06-13 16:25:30

ZYNQ核心板 DEVB_45X60MM 5V

2023-03-28 13:06:25

安装即可,之后就能用nvidia-smi命令了

5、安装CUDA库

进入 https://developer.nvidia.com/cuda-downloads,依次选择 CUDA 类型然后

2019-07-09 07:45:08

什么是CUDA?

2021-09-28 07:37:20

在大家开始深度学习时,几乎所有的入门教程都会提到CUDA这个词。那么什么是CUDA?她和我们进行深度学习的环境部署等有什么关系?通过查阅资料,我整理了这份简洁版CUDA入门文档,希望能帮助大家用最快

2021-07-26 06:28:15

工作。对于Premiere Pro的使用,我们需要CUDA强制渲染GPU而不是使用CPU来渲染视频。是否支持使用NVIDIA GRID K2卡?以上来自于谷歌翻译以下为原文We have

2018-09-10 17:18:49

北极星STM32核心板 DEVB_52X42MM 5V

2023-03-28 13:06:24

单片机应用的核心技术是什么?单片机神奇的工作原理是什么?汇编语言很难学怎么办?

2021-11-02 06:17:40

如果没有其他用户共享K520,您是否可以抓取两个GPU进行CUDA计算作业?我们的应用程序使用GPU进行显示和计算。当我们在AWS K520实例上运行时,CUDA只能看到K520上的一个GPU。我们

2018-09-26 15:23:49

[cuda] Linux系统多版本cuda环境下的cuda-90安装

2019-06-19 17:04:45

企业培训公司面向单位员工培训,长期招CUDA兼职老师,一般三天左右的短周期培训,周末为主,有2人左右的小辅导,也有30人左右的培训大班,待遇优,北京,上海,成都,广州,深圳等,如您想挣点外块,积累

2017-09-22 10:31:38

和Horizon 7.1。我能够在C ++中编译示例CUDA代码(Windows 10. Visual Studio 2015),但在运行时,我得到了一个

2018-09-11 16:33:56

解决Ubuntu下的includedarkneth1414 fatal error cuda_runtimeh No such file or directory#incl

2018-12-24 11:46:26

请推荐一个能开发OPenCL 或CuDA以学习GPGPU的嵌入式板子,真的很急!谢谢

2015-09-04 21:29:44

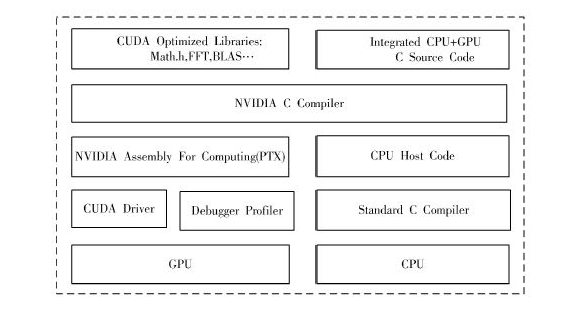

全面介绍使用CUDA进行通用计算所需

要的语法、硬件架构、程序优化技巧等知识,是进行GPU通用计算程序开发的入门教材和参考书。

本书共分5章。第1章

2010-08-16 16:21:32 0

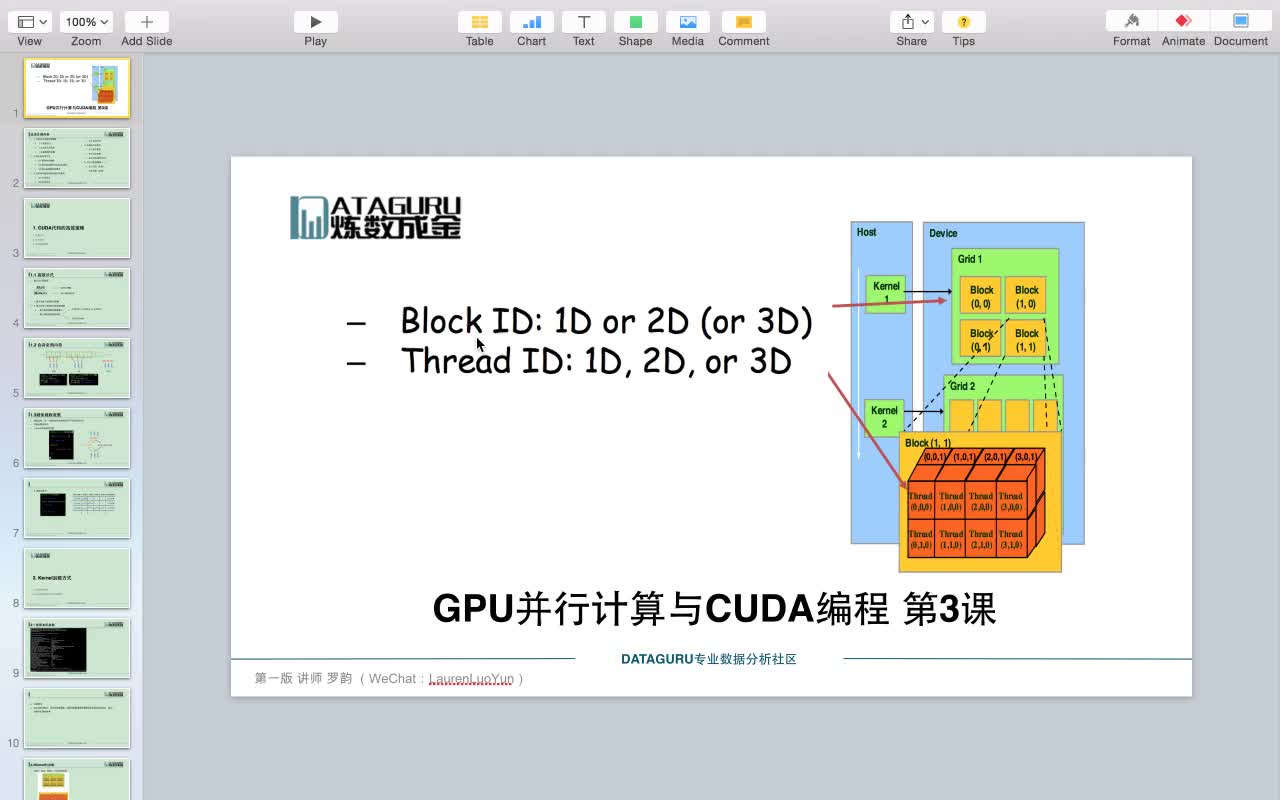

0 •GPGPU及CUDA介绍

•CUDA编程模型

•多线程及存储器硬件

2010-11-12 16:12:10 0

0 The CUDA Toolkit targets a class of applications whose control part runs as a process on a general

2010-11-12 16:20:01 0

0 Portland Group宣布PGI CUDA C和C++编译器已正式出货,针对基于产业标准的通用64位和32位x86架构的处理器系统。

2011-06-30 08:54:09 968

968 本文来自于Toradex长期合作伙伴Antmicro公司,在本文中他们会着重介绍基于核心SoC来自NVIDIA 强大的Tegra K1的Toradex Apalis TK1 计算机模块,来实现CUDA和视觉处理相关应用。

2017-09-18 16:51:43 4

4 根据2ICMA相关器的算法特点,在对比基于CPU并行的MPI集群、MPI+CUDA异构并行集群和Hadoop+ CUDA异构并行集群的架构特点的基础上,提出了一种基于Hadoop+ CUDA平台实现

2017-12-06 10:12:26 0

0 Nvidia今天公布了CUDA并行计算开发平台的更新规划说明,其中特别提到,CUDA 10.2(包括工具包和驱动)将是最后一个支持苹果macOS系统开发、运行CUDA程序的版本,未来CUDA将与苹果平台无关。

2019-11-26 15:48:56 3050

3050 NVIDIA在CUDA 6中引入了统一内存模型 ( Unified Memory ),这是CUDA历史上最重要的编程模型改进之一。在当今典型的PC或群集节点中,CPU和GPU的内存在物理上是独立

2020-07-02 14:08:23 2384

2384 搭载了 9984 个 CUDA 内核,比 RTX 3080 多 1280 个,显存配置也将从 RTX 3080 的 320bit 升级至 384 bit,这也意味其显存容量可能为 12 GB。在此之前

2020-10-27 17:08:41 2393

2393 与 RTX 3090 相同的 CUDA 核心数,即 10496 个核心,配备了 20GB GDDR6X 显存,功耗与 RTX 3080 相同,不支持 NVLINK。 IT之家了解到,AMD 现已发布

2020-11-04 16:06:19 2707

2707 将配备 GA102-250-KD-A1 GPU,拥有 10496 个 CUDA 核心,具有 320 bit 位宽的 20GB GDDR6X 显存。 RTX 3080 Ti 的 TGP 估计为 320W

2020-11-11 16:23:15 1379

1379 最近,RTX3060 Ti显卡开始登场,这款被叫作甜品的产品,具有4864个CUDA 核心,比RTX 3070少1024个核心,后者是5888个。其显存为8GB GDDR6 256 bit 14 Gbps,单卡价格在3000元左右,综合性价比极高。

2020-12-04 15:33:34 5220

5220 1、CUDA的简介 2、GPU架构和CUDA介绍3、CUDA架构4、开发环境说明和配置5、开始第一个Hello CUDA程序 5.1、VS2017创建NVIDIA CUDA项目...

2020-12-14 23:40:27 659

659 蔚来 ET7 搭载四颗英伟达 Orin 芯片:8096CUDA 核心,cuda,芯片,英伟达,nvidia,蔚来,显卡

2021-02-20 14:33:37 4664

4664 NVIDIA CUDA鼎鼎大名,不过,从一开始,该技术就为N卡独享。

2021-03-01 09:43:34 5044

5044 尽管已经有一些工具能让CUDA为OpenCL环境所用,但即便先进如HIPCL也还是一款半自动化工具,需要开发者手动干预。

2021-03-01 10:36:36 6407

6407 最近因为工作需要,学习了一波CUDA。这里简单记录一下PyTorch自定义CUDA算子的方法,写了一个非常简单的example,再介绍一下正确的PyTorch中CUDA运行时间分析方法。

2021-03-30 15:58:58 3772

3772

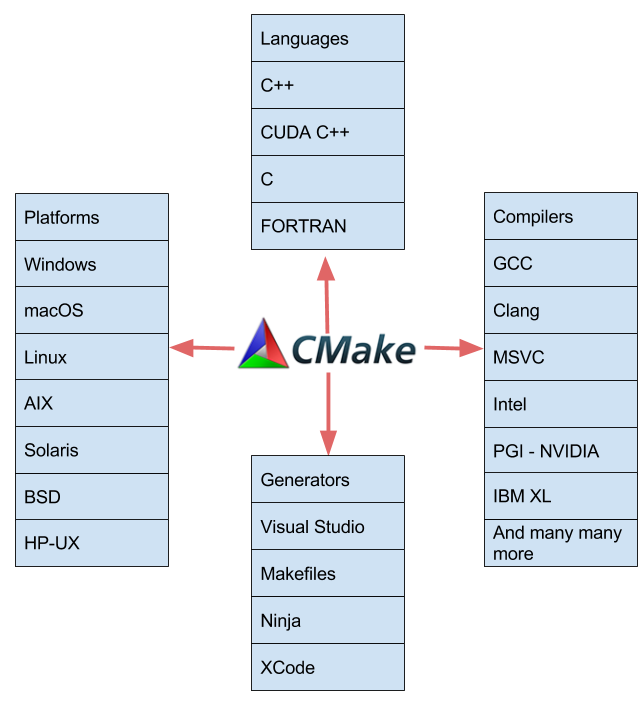

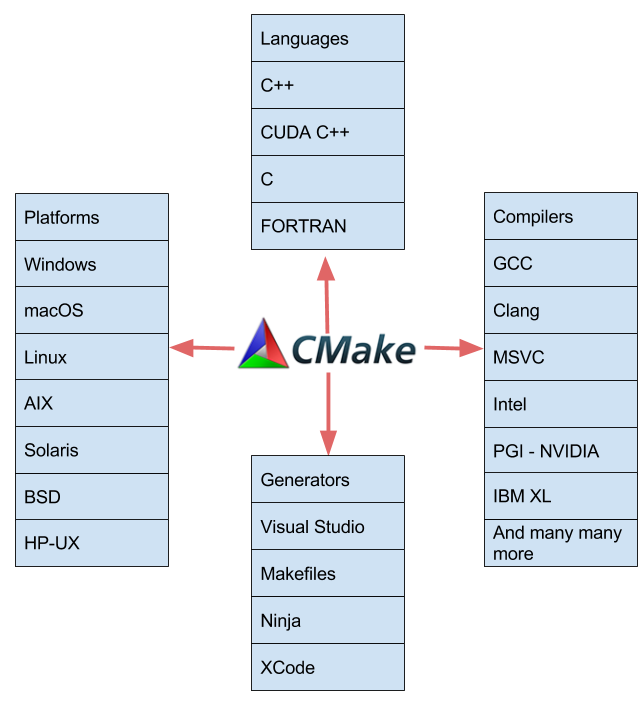

我希望这篇文章向您展示了 CMake 如何自然地支持构建 CUDA 应用程序。如果您是 CMake 的现有用户,请试用 CMake 3 . 9 并利用改进的 CUDA 支持。如果您不是 CMake 的现有用户,请试用 CMake 3 . 9 ,亲身体验一下它对于构建使用 CUDA 的跨平台项目有多好。

2022-04-01 17:42:27 3806

3806

通常,实时物理模拟代码是用低级 CUDA C ++编写的,以获得最佳性能。在这篇文章中,我们将介绍 NVIDIA Warp ,这是一个新的 Python 框架,可以轻松地用 Python 编写

2022-04-02 16:15:29 2260

2260 NVIDIA 发布的 CUDA 开发环境 CUDA 11.6 的最新版本。本版本的重点是增强 CUDA 应用程序的编程模型和性能。 CUDA 继续推动 GPU 加速度的边界,并为 HPC 、可视化、 AI 、 ML 和 DL 和数据科学中的新应用奠定基础。

2022-04-02 16:43:34 3996

3996 NVIDIA 宣布 CUDA 开发环境的最新版本 CUDA 11 . 5 。 CUDA 11 . 5 专注于增强您的 CUDA 应用程序的编程模型和性能。 CUDA 继续推动 GPU 加速的边界,并为 HPC 、可视化、 AI 、 ML 和 DL 中的新应用打下基础,和数据科学。

2022-04-02 16:48:47 2603

2603

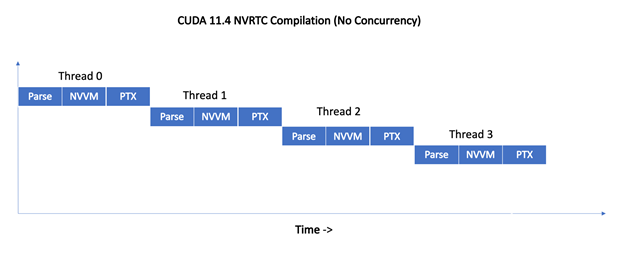

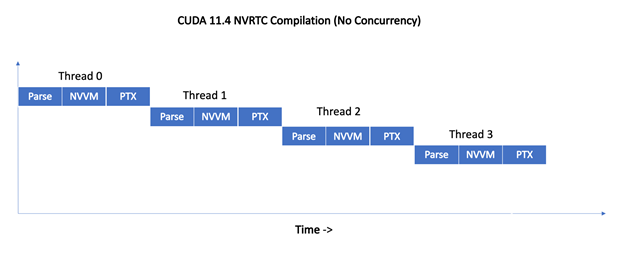

CUDA 11 . 5 C ++编译器解决了不断增长的客户请求。具体来说,如何减少 CUDA 应用程序构建时间。除了消除未使用的内核外, NVRTC 和 PTX 并发编译有助于解决这个关键问题 CUDA C ++应用程序开发的关注点。

2022-04-06 11:59:23 1889

1889

在 NVIDIA CUDA 11.5 中, NVCC 离线编译器在主机编译器支持的平台上为有符号和无符号__int128数据类型添加了预览支持。

2022-04-11 09:16:19 1214

1214

在不指定流的情况下执行异步 CUDA 命令时,运行时使用默认流。在 CUDA 7 之前,默认流是一个特殊流,它隐式地与设备上的所有其他流同步。

2022-04-11 09:26:25 767

767

这篇文章是对 CUDA 的一个超级简单的介绍,这是一个流行的并行计算平台和 NVIDIA 的编程模型。我在 2013 年给 CUDA 写了一篇前一篇 “简单介绍” ,这几年来非常流行。但是 CUDA 编程变得越来越简单, GPUs 也变得更快了,所以是时候更新(甚至更容易)介绍了。

2022-04-11 09:46:26 1098

1098

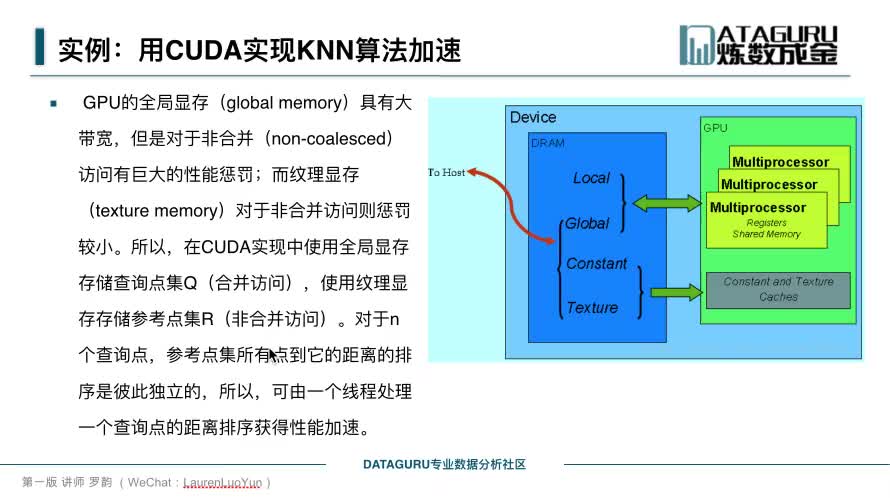

共享内存是编写优化良好的 CUDA 代码的一个强大功能。共享内存的访问比全局内存访问快得多,因为它位于芯片上。

2022-04-11 10:03:45 6774

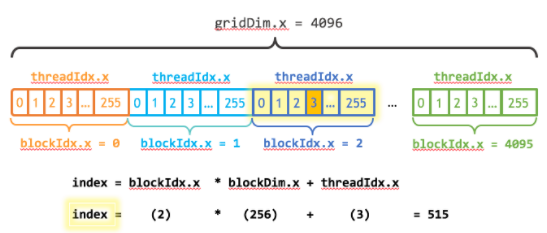

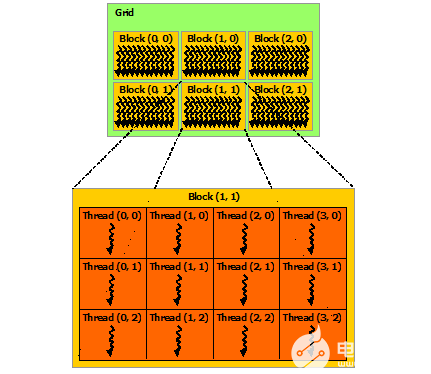

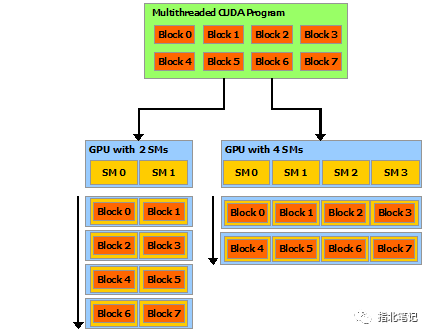

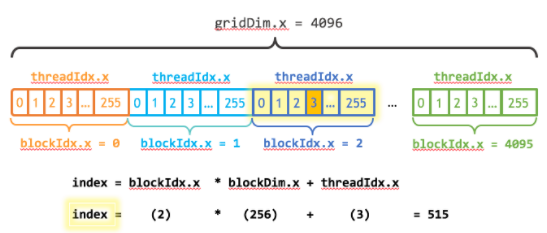

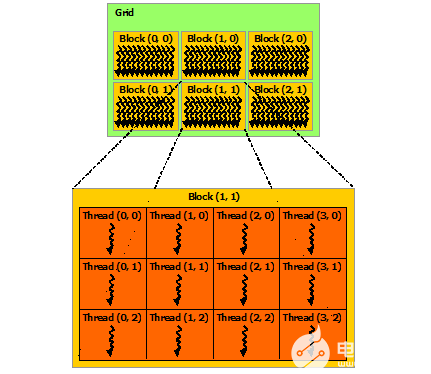

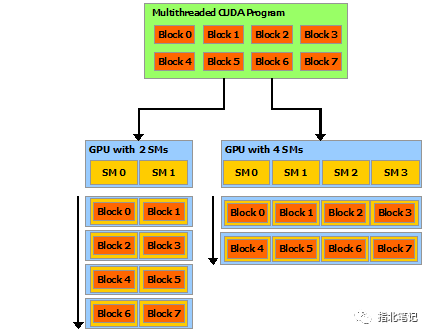

6774 CUDA 编程模型是一个异构模型,其中使用了 CPU 和 GPU 。在 CUDA 中, host 指的是 CPU 及其存储器, device 是指 GPU 及其存储器。在主机上运行的代码可以管理主机和设备上的内存,还可以启动在设备上执行的函数 kernels 。这些内核由许多 GPU 线程并行执行。

2022-04-11 10:13:12 1192

1192 在 CUDA 编程模型中,线程是进行计算或内存操作的最低抽象级别。 从基于 NVIDIA Ampere GPU 架构的设备开始,CUDA 编程模型通过异步编程模型为内存操作提供加速。 异步编程模型定义了与 CUDA 线程相关的异步操作的行为。

2022-04-20 17:16:03 2410

2410

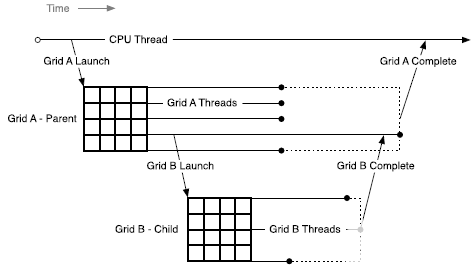

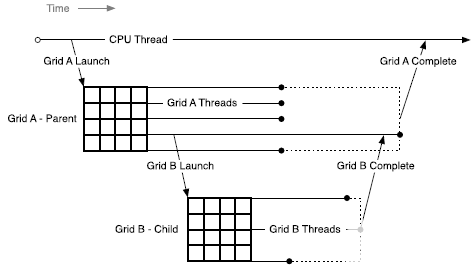

本文档描述了支持动态并行的 CUDA 的扩展功能,包括为利用这些功能而对 CUDA 编程模型进行必要的修改和添加,以及利用此附加功能的指南和最佳实践。

2022-04-28 09:31:12 941

941

NVIDIA GPUs 以 SIMT (单指令,多线程)方式执行称为 warps 的线程组。许多 CUDA 程序通过利用 warp 执行来获得高性能。在这个博客中,我们将展示如何使用 CUDA 9 中引入的原语,使您的 warp 级编程安全有效。

2022-04-28 16:09:05 2323

2323

在 CUDA 上下文中,内核作为 PTX 或二进制对象由主机代码显式加载,如模块中所述。 因此,用 C++ 编写的内核必须单独编译成 PTX 或二进制对象。 内核使用 API 入口点启动,如内核执行中所述。

2022-05-07 15:07:08 1297

1297

NVIDIA CUDA 工具包提供了开发环境,可供开发、优化和部署经 GPU 加速的高性能应用。

2022-06-10 12:03:42 2964

2964 OpenCV4.x中关于CUDA加速的内容主要有两个部分,第一部分是之前OpenCV支持的图像处理与对象检测传统算法的CUDA加速;第二部分是OpenCV4.2版本之后开始支持的针对深度学习卷积神经网络模型的CUDA加速。

2022-09-05 10:03:00 4415

4415 单精度矩阵乘法(SGEMM)几乎是每一位学习 CUDA 的同学绕不开的案例,这个经典的计算密集型案例可以很好地展示 GPU 编程中常用的优化技巧。本文将详细介绍 CUDA SGEMM 的优化手段

2022-09-28 09:46:54 1511

1511 通过这种构建CUDA图的方法,由CUDA内核和CUDA内存操作形成的图节点通过调用cudaGraphAdd*节点API添加到图中,其中*被替换为节点类型。节点之间的依赖关系是用API显式设置的。

2022-10-11 09:43:40 553

553

CUDA(Compute Unified Device Architecture,统一计算架构)是由英伟达所推出的一种集成技术,是该公司对于GPGPU的正式名称。通过这个技术,用户可利用NVIDIA的GPU进行图像处理之外的运算,CUDA也是首次可以利用GPU作为C-编译器的开发环境。

2022-11-29 09:36:55 2464

2464 CV-CUDA (Computer Vision – Compute Unified Device Architecture)高性能图像处理加速库,近日发布 Alpha 版本,正式向全球开发者开源

2022-12-21 20:45:02 732

732 CUDA是NVIDIA的一种用于GPU编程的技术,CUDA核心是GPU上的一组小型计算单元,它们可以同时执行大量的计算任务。

2023-01-08 09:20:14 1874

1874 CUDA 除了是并行计算架构外,还是 CPU 和 GPU 协调工作的通用语言。在CUDA 编程模型中,主要有 Host(主机)和 Device(设备)两个概念,Host 包含 CPU 和主机内存,Device 包含 GPU 和显存

2023-05-18 09:57:54 1576

1576

CUDA 编程模型主要有三个关键抽象:层级的线程组,共享内存和栅同步(barrier synchronization)。

2023-05-19 11:32:54 1017

1017

的 CUDA (Compute Unified Device Architecture)编程模型 ,利用 GPU 强大的并行计算能力,为计算机视觉任务带来了前所未有的加速效果。 为了能让 CV

2023-06-13 20:55:03 259

259

电子发烧友网站提供《CUDA与Jetson Nano:并行Pollard Rho测试.zip》资料免费下载

2023-06-15 09:30:08 0

0 CUDA之所以会成为算力芯片硬件厂商必须要认真考虑的一个选择,最直接的原因,是其已经实现了与算法客户的强绑定。众多算法工程师已经习惯了CUDA提供的工具库及其编程语言,向外迁移总是会存在不习惯的问题。

2023-08-16 12:35:45 480

480

基于 NVIDIA CUDA 架构师 Stephen Jones 近期的 CUDA 技术简报(Accelerated Computing / CUDA Technical Briefing),开发者

2023-09-22 18:45:02 300

300

OpenCV4.8+CUDA+扩展模块支持编译指南

2023-11-30 16:45:00 314

314

在最近的一场“AI Everywhere”发布会上,Intel的CEO Pat Gelsinger炮轰Nvidia的CUDA生态护城河并不深,而且已经成为行业的众矢之的。

2023-12-28 10:26:20 458

458

vLLM 中,LLM 推理的 prefill 阶段 attention 计算使用第三方库 xformers 的优化实现,decoding 阶段 attention 计算则使用项目编译 CUDA 代码实现。

2024-01-09 11:43:21 414

414

电子发烧友App

电子发烧友App

评论