电子发烧友网报道(文/莫婷婷)随着生成式AI应用的爆发式增长,数据中心对高效、低成本、低功耗AI推理能力的需求急剧上升。高通凭借其在移动计算和通信领域的技术积累,正试图通过差异化战略,在价值数千亿美元的数据中心市场中抢占一席之地。

就在10月28日,高通面向数据中心连发两款AI芯片,AI200 和 AI250 芯片,打造下一代 AI 推理优化解决方案。这一举措不仅标志着高通在AI基础设施领域的拓展,也被业内视为其对英伟达在AI数据中心市场发起挑战的关键一步。

支持768 GB LPDDR,高通AI芯片性能、架构与能效全面突破

此次发布的AI200和AI250基于高通的Hexagon神经处理单元(NPU)技术,并针对大型语言模型(LLM)、多模态模型(LMM)及实时AI推理任务进行了深度优化,可实现快速数据中心生成式 AI 推理,预计分别将于2026年和2027年上市。

高通介绍,AI200 是机架级AI推理解决方案,主打高内存带宽与低总拥有成本(TCO),旨在为大型语言和多模态模型(LLM、LMM)、推理和其他 AI 工作负载提供较低的TCO和优化的性能。

该芯片单卡支持高达768GB的LPDDR内存,远超当前市场上主流竞品。作为对比,英伟达H100 GPU单卡最大显存为80GB HBM3,GB300每个GPU配备288GB HBM3e内存,不到AI200的一半;AMD MI300X也仅提供192GB HBM3内存。这意味着在处理超大规模模型时,AI200无需频繁进行数据交换或模型切分,显著提升了推理效率。

另一个值得关注的数据是,相较于HBM,LPDDR在制造成本上带来的优势。目前来看HBM的生产成本大约是LPDDR的2-3倍,这使得AI200能够在保持高性能的同时,大幅降低单位算力的成本支出,适合需要长期运行、高吞吐量的云服务提供商和企业客户。

在AI200是对现有市场精准打击的同时,高通AI250则是一次颠覆性的技术创新。

AI250 引入了基于近内存计算的创新内存架构,这一设计提供超过 10 倍的有效内存带宽和更低的功耗,对于AI推理这类高度依赖数据流动的任务而言,这意味着更低的延迟和更高的能效比。此外,AI250支持分解式AI推理,实现更灵活的资源调度与利用率优化,同时满足客户的性能和成本要求。

基于AI200 和 AI250 芯片的机架解决方案均具有直接液体冷却以提高热效率、用于纵向扩展的 PCIe、用于横向扩展的以太网,支持160kW机架级功耗管理,满足现代数据中心对可扩展性与热管理的严苛要求。此外,二者均支持机密计算,确保敏感AI工作负载在执行过程中的数据安全。

高通在官方通告中,特别指出两款产品都支持较低的总体拥有成本(TCO)。TCO指的是在设备采购、运维等整个生命周期需要投入的成本,已经成为客户决策的关键指标之一,直面初创企业或新兴市场等对预算敏感型客户群体。

此外,AI数据中心产业对绿色AI和可持续算力的需求。在TCO中,电力成本占一半左右,已成为云服务商的支出大项。而高通强调“每瓦每美元”的性能指标,正好直击产业痛点。

“借助高通 AI200 和 AI250,我们正在重新定义机架级 AI 推理的可能性。这些创新的新型人工智能基础设施解决方案使客户能够以前所未有的总体拥有成本部署生成式人工智能,同时保持现代数据中心所需的灵活性和安全性”,高通技术公司边缘解决方案和数据中心技术规划高级副总裁兼总经理 Durga Malladi表示。

高通的战略升级:以AI推理为核心向数据中心扩张

长期以来,高通被视为“智能手机芯片之王”,骁龙系列处理器几乎定义了安卓旗舰手机的标准。然而,随着智能手机市场趋于饱和,高通开始加速多元化布局,先后进入PC、汽车、工业等领域,就在今年2月,高通正式推出“跃龙”品牌,面向工业场景。如今,AI数据中心成为其下一个战略高地。

从高通的通告中可以看到,面向AI数据中心,高通已经有着清晰的技术路线图与商业化落地计划。

高通已明确宣布,将每年推进一次数据中心AI芯片路线图更新,持续迭代性能与能效。AI200计划于2026年上市,AI250将于2027年量产,形成稳定的产品节奏。

在商业化进展方面,今年5月,高通宣布与沙特阿拉伯的Humain公司合作,为其新建的区域性AI数据中心提供AI推理芯片,该项目预计将部署最多可使用200兆瓦电力的系统,相当于一座中等城市全年数据中心的用电总量,能够支撑数十万台服务器的AI运算能力。此次合作成为高通在国家级AI基建项目中获得大规模订单,具有象征意义。

在开发者生态方面,为了打破生态的壁垒,高通在软件层面也下足功夫。高通表示AI200和AI250配备了完整的高通AI软件栈,兼容主流AI框架,并支持一键式模型部署。开发者无需重写代码即可将已训练好的模型迁移至高通平台,极大降低了采用门槛专为无摩擦采用和快速创新而设计。

高通AI芯片的发布,被视为其正式向英伟达所在的AI数据中心领域的统治地位发起挑战的标志性开端。英伟达凭借其强大的CUDA生态、领先的GPU架构,且在AI训练领域的先发优势,在数据中心市场占据了超过90%的绝对主导地位,已成为全球主流云服务商和AI企业构建大模型训练平台的“标配”。

而生成式AI从训练阶段大规模转向部署和推理应用,云天励飞副总裁罗忆预计,国产大模型推理算力需求将在2026年超越训练需求。因此AI推理芯片正逐渐成为AI领域的关键,这为后来者提供了错位竞争的战略窗口,而高通正是抓住了这一关键转折点。

与英伟达以通用GPU为核心、兼顾训练与推理的路线不同,高通选择了专注AI推理赛道的差异化战略,并非在英伟达最擅长的训练战场上正面硬刚,而是精准切入更具规模潜力的推理环节,基于高通在高吞吐、低延迟等技术的优势,通过专用架构、能效优化和成本控制,构建起一条竞争路径。

未来,在AI数据中心这片充满机遇与挑战的市场中,高通会有哪些表现,AI200与AI250芯片能否在2026年如期量产并顺利导入主流企业中,又能否在软件生态上赢得开发者的广泛支持,都将成为关键。

发布评论请先 登录

数据中心缺电,英伟达又有新动作!

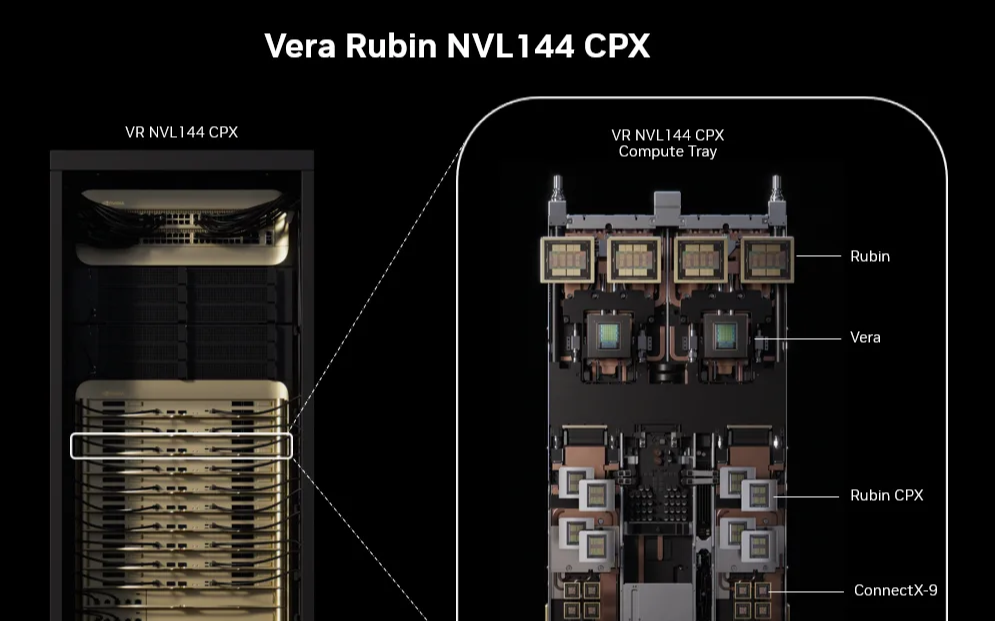

堪称史上最强推理芯片!英伟达发布 Rubin CPX,实现50倍ROI

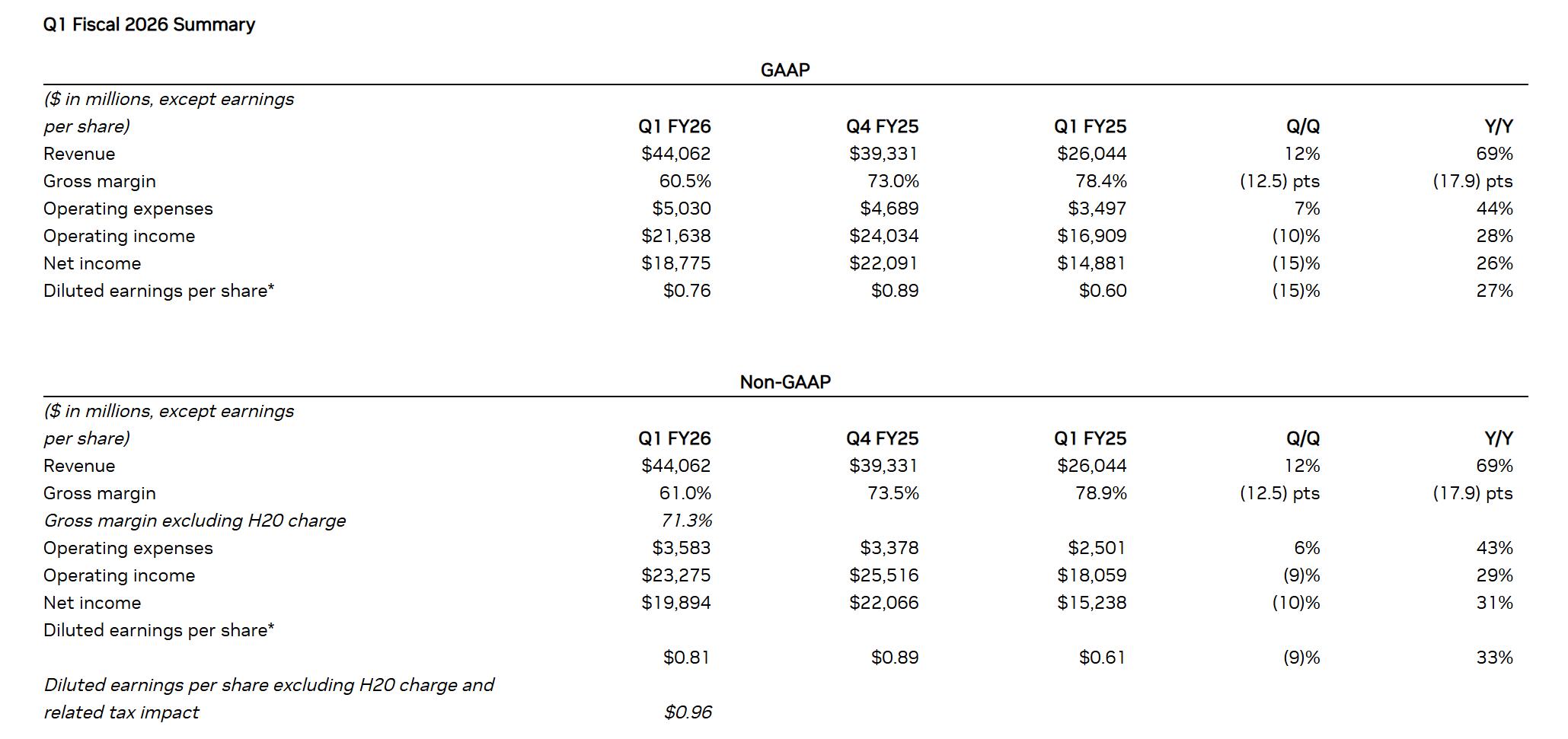

AI推理需求井喷!英伟达Q1营收大涨,H20禁售难挡增长步伐

高通挑战英伟达,发布768GB内存AI推理芯片,“出征”AI数据中心

高通挑战英伟达,发布768GB内存AI推理芯片,“出征”AI数据中心

评论