在全球人工智能技术飞速发展的今天,模型的快速迭代与高效部署成为各大科技企业竞相追逐的焦点。华为DCS AI全栈解决方案中的重要产品—ModelEngine AI平台,全面支持DeepSeek大模型R1&V3和蒸馏系列模型的本地部署与优化,加速客户AI应用快速落地。

ModelEngine作为大模型训练、推理和应用开发的AI平台,提供从数据预处理到模型训练、优化及部署的一站式服务。此次ModelEngine基于昇腾AI芯片,通过推理框架优化和MoE存算协同,提供动态换入换出和全局统一缓存,实现推理高并发和低时延,用户通过ModelEngine体验DeepSeek更加快速高效的推理能力。

灵活部署:ModelEngine全面支持DeepSeek系列模型R1&V3 671B以及蒸馏系列模型,开发者可通过ModelEngine实现“一键部署”,省去硬件选型、兼容性验证和环境配置等繁琐步骤,大幅降低企业AI应用门槛。此外,ModelEngine通过其高度的开放性和模块化设计,极大地缩短了DeepSeek的本地部署时间。

企业级稳定性:ModelEngine提供负载均衡、模型安全接入、多用户配额管理等高阶特性,支持大规模生产环境下的稳定运行。某证券公司引入DCS AI全栈解决方案后,运维成本降低42%。

DCS AI全栈解决方案近期将上线DeepSeek体验环境,敬请期待。

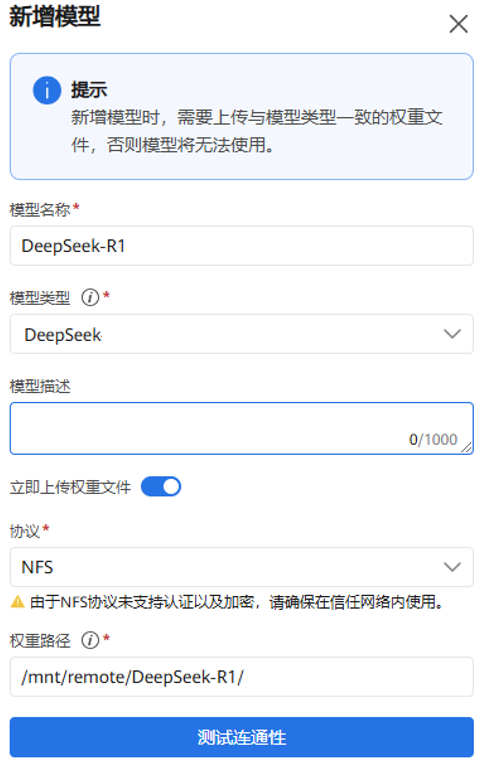

下面以DeepSeek-R1为例,基于ModelEngine 3步快速完成部署模型

1. 登录ModelEngine模型管理页面,上传DeepSeek-R1 FP8权重,然后进行模型权重格式转换,将FP8精度模型权重转换为BF16精度模型权重;

2. 在模型服务页面,选择BF16精度的模型权重版本,下发推理服务,启动任务部署;

3. ModelEngine使用MindIE推理框架启动DeepSeek-R1推理服务后,支持OpenAI API 调用风格的推理服务接口和访问方式;

4. ModelEngine 启动 DeepSeek-R1 推理服务后,平台支持 OpenAI API 调用风格的推理服务接口和访问方式,用户可以将该 API 集成到对话、RAG 以及 Agent 应用。

到这里,基于ModelEngine私有化本地部署的DeepSeek-R1完整版推理服务API已经就绪了,可以将推理服务API集成到对话应用、RAG或者Agent应用中,在保证数据安全的前提下,让DeepSeek-R1媲美世界头部顶流闭源大模型服务智能的能力,助力客户AI业务升级。

-

华为

+关注

关注

218文章

35803浏览量

260795 -

大模型

+关注

关注

2文章

3458浏览量

4974 -

DeepSeek

+关注

关注

2文章

824浏览量

2830

原文标题:华为ModelEngine支持DeepSeek全系列本地部署!

文章出处:【微信号:HWS_yunfuwu,微信公众号:华为数字中国】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

曙光AI超集群系统全面支持DeepSeek-V3.2-Exp

信而泰×DeepSeek:AI推理引擎驱动网络智能诊断迈向 “自愈”时代

DeepSeek推动AI算力需求:800G光模块的关键作用

HarmonyOS NEXT开发实战:DevEco Studio中DeepSeek的使用

中软国际Lumi智能体开发平台支持DeepSeek

鸿蒙原生应用开发也可以使用DeepSeek了

黑芝麻智能芯片全面兼容DeepSeek模型推理

曙光云全面支持DeepSeek大模型

端侧AI元年爆发!广和通AI模组及解决方案全面支持DeepSeek-R1蒸馏模型

华为ModelEngine AI平台全面支持DeepSeek

华为ModelEngine AI平台全面支持DeepSeek

评论