随着算力产业及通信网络的快速发展,硬件不断更新升级,设备集成度及单机柜功率密度显著提高,在当前算力需求急剧增长和能效要求日益严苛的背景下,三大运营商积极响应国家绿色、节能、低碳政策要求,推动建立并完善数据中心液冷技术生态系统,通过寻找高效的液冷解决方案,以应对数据中心日益严峻的能耗和散热问题。

以位于河北石家庄的联通浸没式液冷可移动集装箱式高密度绿色数据中心为例,联通在推动液冷行业业内实践及应用落地的过程中,与兰洋科技进行了深入的技术交流与合作探讨。基于对液冷技术的共同理解和认可,兰洋科技团队在针对项目应用场景及应用需求的深入评估后,为联通提供了一个创新且高效的解决方案:远程部署浸没式液冷可移动集装箱式高密度绿色数据中心。

浸没式液冷可移动集装箱式高密度绿色数据中心

为联通使用场景量身打造的浸没式液冷可移动集装箱式高密度绿色数据中心,在灵活扩容、安全可靠的前提下,由专业的结构、热控、材料、电子工程师团队主导,采用了兰洋科技自主研发的液冷材料和浸没式液冷散热系统。结合成熟的系统设计和管路布局,有效解决了高密度散热难题。此项目方案突破了液冷材料、复杂密封结构设计、系统集成与模块化设计上的诸多挑战与难点,在确保整体散热效率和系统可靠性、扩展性的同时,为迫切需要高效散热解决方案且空间有限的应用环境实现了液冷应用示范。

浸没式液冷集装箱项目亮点及创新点

(1)BO系列冷却液,安全可靠

在冷却液的选择上,该项目采用了兰洋科技自研BO系列导热液,具有更高的热交换效率,拥有8—10年使用寿命,原料已完全国产化,为散热系统长期稳定运行提供保障,在核心攻关技术问题上完成了国产化替代的同时,也为行业输送了不同应用场景下的一系列优秀液冷工质。液冷材料和浸没式液冷散热系统不仅有效解决了高密度散热难题,还通过成熟的散热系统设计,确保了整体散热效率和可靠性。

服务器浸没在兰洋科技BO系列导热液中稳定运行

(2)多项关键核心零部件及创新设计

该解决方案整体设计中,包含了多项关键核心零部件及创新设计,其代表了领先的整体散热解决方案设计能力,及产业化能力。这些关键核心零部件及产业链上游设计能力对于未来几年算力产业和高效绿色液冷数据中心的发展都将起到关键的推动作用。

(3)自主研发技术,散热精准高效

采用自主研发生产的浸没式卧柜设计,具有可靠良好的换热性能和创新的密封结构,可以兼容90%以上服务器;

包含了多项关键核心零部件及创新设计,其代表了兰洋科技领先的整体散热解决方案设计能力,及产业化能力。这些关键核心零部件及产业链上游设计能力对于未来几年算力产业和高效绿色液冷数据中心的发展都将起到关键的推动作用;

作为应用示范案例的关键设计之一,领先的CDU设计思路也是整套设计方案的亮点之一:CDU采用自主设计,并配备有1+1冗余动力泵,精准控制,可对超多散热节点联合部署。

(4)系统集成密度高,模块化部署

项目采用一体式设计的集装箱模块化部署方式,显著缩短了部署周期,可实现8-10天快速部署。同时具备优异的可扩展性和灵活性,可根据实际需求在室外部署并实现快速扩容,安装方便快捷,配合性高。

在设备部署密度提升上,液冷技术使得数据中心内部的设备可以更加紧凑地排列,实现了服务器部署数量的增加。这种密集部署可以提高数据中心的总体计算能力,进而提高资源利用率和经济效益。

浸没式液冷可移动高密度绿色数据中心吊装

(5)降低能耗及成本,提高经济效益

在能源效率提升方面,浸没式液冷散热大幅减少了数据中心运行能耗;在节能减排方面,通过减少能源消耗,绿色高密度液冷数据中心可以显著降低碳排放量。

以联通此次液冷集装箱部署地河北为例,本次通过整体的换热系统设计,全年有2个月以上无须依靠一次侧冷源,极大地降低全年综合能耗及数据中心运营成本。

目前联通液冷集装箱项目已部署完成40英尺集装箱内320U的高密度容量并投入使用,80台服务器支持最大550 kW的计算功耗。项目运行稳定,各项数据表现良好。

252U服务器部署后30天内,中央处理器平均温度基本稳定在62±2℃以内,GPU平均温度基本稳定在61±2℃以内,两种硬件之间的平均温差约为4℃,进一步体现了设备运行的稳定性和温度控制的有效性。本项目采用兰洋科技浸没式单相液冷技术,能源使用效率指标实现全年运行PUE值1.1,pPUE值低至1.03,每年节电600万kW·h。

通过兰洋科技针对此项目的方案设计和技术应用,不仅在高效散热和能效利用方面达到了行业领先水平,也在系统可靠性、安全性和扩展性方面建立了新的标准。不仅为中国联通强大的数据处理能力提供了支撑,也为整个行业展示了如何在满足日益增长的数据处理需求的同时,实现能源使用的优化和环境影响的最小化。

浸没式液冷可移动高密度绿色数据中心内部

兰洋科技的液冷散热解决方案可够针对不同散热场景进行定制化调整,有较强的可复制性,现已在全国多个城市落地,并广泛应用于教育、云游戏、通信基站、人工智能等领域。未来兰洋科技将依托“液冷集装箱数据中心”等液冷产品,以创新为驱动力,携手行业伙伴共谋绿色发展之路,为行业数字化转型奠定基础。

-

数据中心

+关注

关注

16文章

5515浏览量

74649 -

散热系统

+关注

关注

0文章

69浏览量

10794 -

液冷

+关注

关注

5文章

146浏览量

5682

发布评论请先 登录

高密度光纤布线:未来的数据通信解决方案

MMC光纤连接系统:推动AI数据中心高密度互联的技术解析

曙光数创液冷方案助力数据中心绿色发展

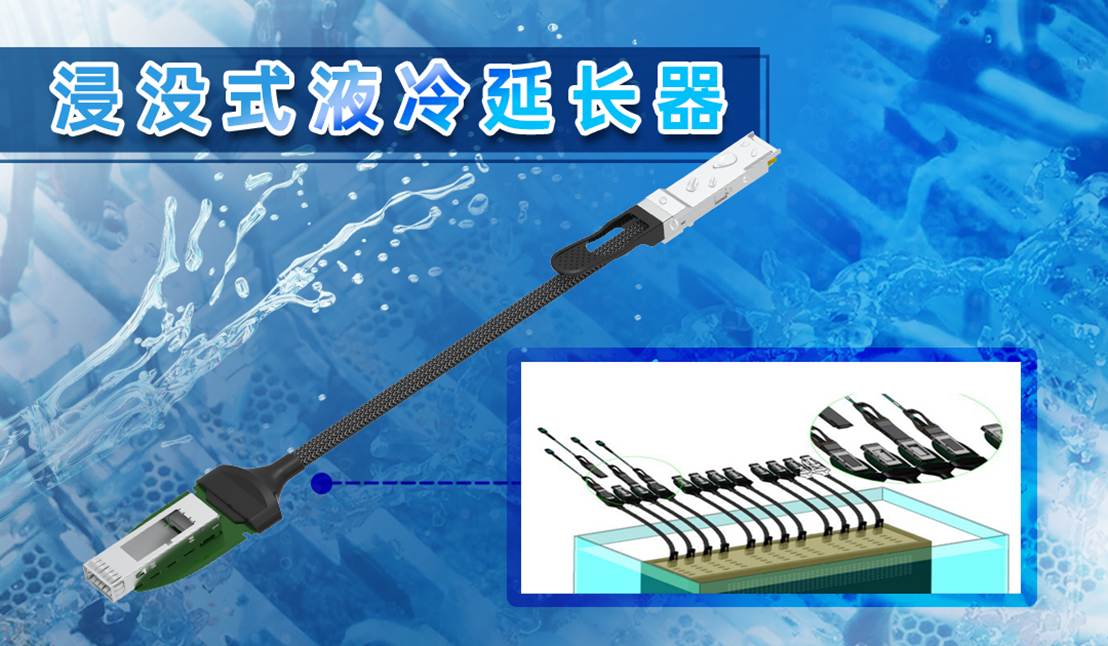

易飞扬浸没液冷延长器与硅光液冷光模块主题研究 ——液冷光互连技术的数据中心革命

浸没式液冷在数据中心的发展历程与应用现状

曙光数创推出液冷数据中心全生命周期定制新服务

高密度配线架和中密度的区别

RAKsmart液冷技术如何实现PUE<1.2的绿色数据中心

流量与压力传感:数据中心液冷的″智慧之眼″

兰洋科技为联通部署浸没式液冷可移动高密度绿色数据中心投入使用,运行稳定

兰洋科技为联通部署浸没式液冷可移动高密度绿色数据中心投入使用,运行稳定

评论