液冷

作为一种更高效的热管理方案,正在成为AI时代数据中心的关键“降温武器”。

本文将带你走进液冷世界,探索浸没式液冷在数据中心的发展,以及是德科技如何用测量科技,为这场“冷静革命”提供坚实支撑。

浸没式液冷发展历程与应用现状

浸没式液冷是最彻底的液冷方案,将整台服务器乃至整个机柜完全浸泡在绝缘冷却液中,实现所有元件同时冷却。浸没冷却因其极高的传热效率和对超高功率密度的支撑能力,近年来受到了极大关注。

进入2020年代,随着AI算力激增,浸没液冷开始在超算中心和云计算数据中心试点部署。据统计,中国已有多个浸没液冷项目落地,包括国家超算深圳中心二期;互联网公司等均建设了浸没液冷机柜集群。微软曾试验将双相浸没冷却应用于其Azure服务器,Meta和谷歌也投资相关研发。随着标准化推进和成本下降,浸没液冷正迎来加速增长拐点。

冷却液类型

冷却液是浸没式液冷的核心。单相浸没液体主要分为四大类:

烃类:如矿物油、合成烃等。

氟化液:含氟有机液体,介电性能极佳且不燃。

天然酯类:由植物油提炼的酯类,如菜籽油基绝缘液。

合成酯类:人工合成的酯类冷却液。

双相浸没目前主要使用氟化液工质,因为需要低沸点且绝缘的液体。

冷却液关键电气特性

根据OCP《浸没式冷却液体基础规范》(2022),对用于浸没液冷的液体提出了关键参数要求:

•介电强度 > 6 kV/mm(保障绝缘性)

•介电常数 (Dk) ≤ 2.3(20MHz–40GHz频段)

•介质损耗因子 (Df) ≤ 0.05(20MHz–40GHz频段)

•体积电阻率 > 1×10^11 Ω·cm

(注:Dk越接近1越接近空气,Df越低电介质损耗越小。上述要求旨在减小液体对高速信号的电气影响。)

浸没式液冷挑战与问题

尽管前景诱人,浸没式液冷的大规模应用仍面临诸多挑战:

1技术工程挑战:

相比传统方案,浸没液冷在工程实施上要克服很多新问题。例如,液槽密封与防漏设计、液体蒸发损耗控制、服务器插拔和维护便利性、液体老化和更换周期等。

2材料和化学兼容性:

绝大多数现有服务器元件(PCB板材、芯片封装、接插件、胶黏剂等)最初并非针对长期泡在化学液体中设计。即使液体不导电,其对材料的相容性仍是隐患。例如某些塑料、密封胶可能被液体溶胀或析出物质污染液体;接插件长时间浸液也可能加速腐蚀或老化。这需要对服务器选材进行调整,并建立行业标准测试(OCP规范中要求检验液体对典型材料的影响)。

3电气兼容性与信号完整性:

这是浸没液冷区别于风冷的最大挑战之一。液体介质的介电常数εr约在1.8~2.2,比空气的~1.0高出近一倍。电子元件工作在介电环境改变后,其高频电气特性会发生明显变化。例如PCB走线和连接器原本按空气介电常数设计,浸入液体后特征阻抗会降低(约降10Ω以上),导致信号反射增大、带宽下降。这在高速数字信号(如PCIe Gen5/6、112G PAM4链路)上表现为回波损耗变差、串扰和插损增加,信号眼图裕度缩小。研究表明,PCIe 5.0(32Gbps NRZ)在空气和液体中基本性能相当,而PCIe 6.0(64Gbps PAM4)在液体中误码率可能相比空气增高两个数量级!这意味着在浸没环境下高速链路更容易出现误码,需要额外的均衡(DFE/FFE)和信号优化设计。

4安全与政策:

液冷引入新材料和安全考虑。例如一些液体可燃或具温室气体属性,造成消防和环保顾虑。法规标准需更新以覆盖液冷设施的消防规范、泄漏应急、废液处理等。

5液体管理与维护:

5.1 过滤与纯化

冷却液长期循环会夹带铜屑、焊料微粒与塑化剂;必须配置 1–5 µm 线绕滤芯或离心分离器,并定期监测水分(<50 ppm)与酸值 (TAN) 以延缓老化。

5.2 电性参数漂移

随着温度-氧化-污染累积,液体 DK/DF 会偏离初值并影响高速链路,需要在线采样或使用射频探头校验,并在阈值外及时更换。

标准化与测试方法(DK/DF电性参数及标定)

行业正在制定相应标准和测试方法来保障互操作性和性能。一大重点是冷却液的关键电气参数(介电常数DK、介质损耗DF)的测试与标定方法。

OCP在《浸没式液体基础规范白皮书》中提到了是德科技的射频探头法:

是德科技Keysight N1501A介电探头套件和N1500A材料测试软件,配合矢量网络分析仪测量材料在高频下的复介电常数。

该测试方法是将探头浸入被测液体,由网络分析仪测量液体的S参数并计算DK和DF,频率范围覆盖200MHz至50GHz。这是一种宽频测试方法,也是OCP推荐用于液冷液体介电测量的方法。其优点是频带宽,适用产品全生命周期,包括设计、质检等。

提到是德科技射频探头法方案

为应对这些挑战,ODCC在《浸没式冷却液关键电性参数标定方法研究》提出使用Keysight高端矢量网络分析仪(如N1501A)精确测量冷却液的介电常数与介质损耗,以确保数据中心浸没式液冷技术的可靠性与互操作性。

针对浸没式冷却液 DF 数值在 0.01以下的超低损耗测量,业界已开始引入两种补充测试方案,是德科技正与合作伙伴保持密切协同,并已借助仪器做测试验证。

使用是德科技的材料测试仪器测试材料性能和测量介电特性

是德科技提供丰富的材料能测试解决方案,包括测试方法和建议、仪器、夹具以及软件,它们能够帮助高效、有效地表征被测材料的电气和电磁(EM)特性。通过准确表征材料特性,为研究人员提供关键信号,帮助打造下一代技术和产品。

相较于风冷,液冷对材料相容性、电气性能和系统可靠提出了更高的技术挑战,特别是浸没式液冷,虽具强大散热潜力,但在液体介电特性、电气兼容性等方面仍需持续攻关。

是德科技凭借在高频信号测试、材料介电测量、电气可靠性验等方面的领先技术,构建了完整的液冷测试方案,已被 OCP、ODCC 等国际和国内标准组织推荐,成为推动液冷产业标准化的力量之一。

Keysight AI(KAI)整体解决方案

除了电源能效这块,是德科技今年推出了Keysight AI(简称 KAI),是面向 AI 数据中心推出的端到端测试与验证架构,覆盖从预研、设计、测试到部署运营的全生命周期。通过 KAI,用户可以在部署前对 AI 集群进行全栈验证,优化硬件设计与网络拓扑,提高系统性能,并显著缩短上线周期。

KAI 包括四大模块:

1Compute:验证 DDR、PCIe、CXL等高速数字接口设计,确保物理层信号完整性与合规性,辅以误码率测试、示波器分析等工具支持高速AI芯片开发。

2Interconnect:针对高达1.6 Tbps速率的光/电互联通道执行全面测试,包括224 Gb/s通道级别验证,以保障信号质量和网络稳定性。

3Network:基于真实AI训练(LLM)流量执行 workload emulation,通过 AresONE 等流量生成仪模拟 RoCEv2/RDMA,评估网络延迟、尾部时延和拥塞瓶颈,提高集群 job completion time 性能。

4Power:分析功耗效率与电源完整性,帮助优化数据中心能源管理与热稳定性。

是德科技致力于推动数据中心从风冷迈向液冷、从传统走向智能,协助行业客户构建更高效、更安全、更环保的算力基础设施。从冷却液介电性能测试到系统信号完整性验证,再到全面的AI数据中心测试架构——KAI平台,是德科技正在以专业力量,守护每一瓦能耗、每一个比特的数据流动。

随着产业链协同推进和测试体系逐步完善,液冷将在未来 5–10 年加速进入数据中心与边缘算力中心。届时,“服务器泡在液体里”将不再是科幻场景,而是绿色高效计算的新常态。

关于是德科技

是德科技(NYSE:KEYS)启迪并赋能创新者,助力他们将改变世界的技术带入生活。作为一家标准普尔 500 指数公司,我们提供先进的设计、仿真和测试解决方案,旨在帮助工程师在整个产品生命周期中更快地完成开发和部署,同时控制好风险。我们的客户遍及全球通信、工业自动化、航空航天与国防、汽车、半导体和通用电子等市场。我们与客户携手,加速创新,创造一个安全互联的世界。

-

数据中心

+关注

关注

16文章

5515浏览量

74627 -

液冷

+关注

关注

5文章

146浏览量

5678 -

算力

+关注

关注

2文章

1384浏览量

16554

原文标题:从风冷到液冷,AI时代数据中心算力的“降温”秘诀

文章出处:【微信号:是德科技KEYSIGHT,微信公众号:是德科技KEYSIGHT】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

曙光数创液冷方案助力数据中心绿色发展

聚焦液冷痛点:英特尔UQD互换性认证助力数据中心高效发展

曙光数创亮相2025亚洲数据中心峰会暨展览会

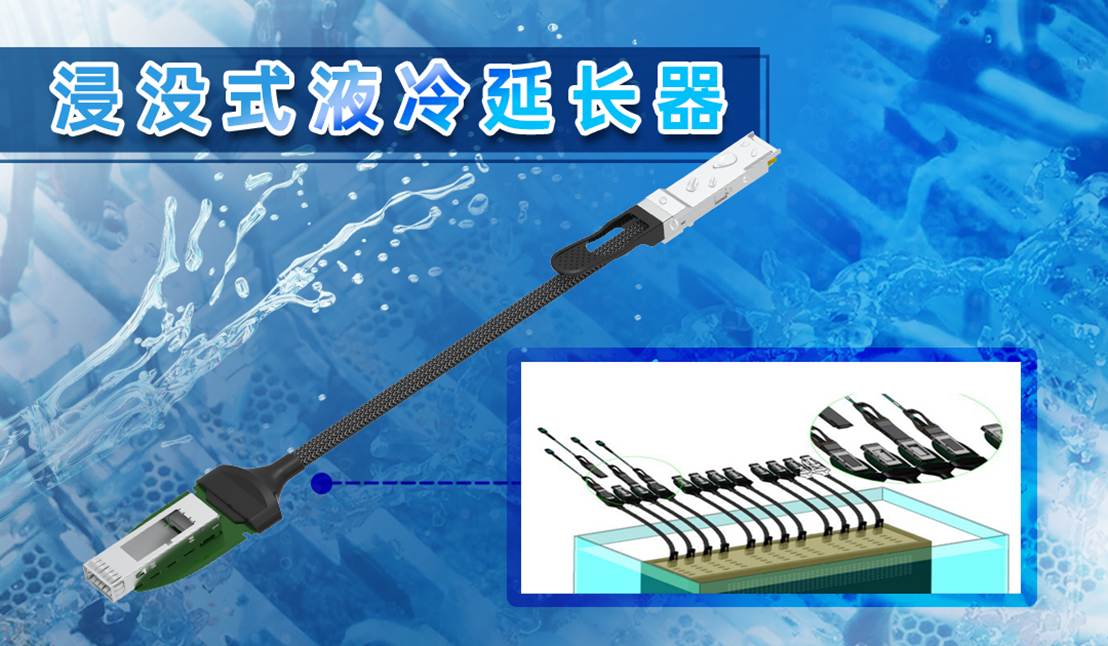

易飞扬浸没液冷延长器与硅光液冷光模块主题研究 ——液冷光互连技术的数据中心革命

曙光数创推出液冷数据中心全生命周期定制新服务

RAKsmart液冷技术如何实现PUE<1.2的绿色数据中心

流量与压力传感:数据中心液冷的″智慧之眼″

数据中心液冷技术和风冷技术的比较

宁畅亮相2025中国数据中心液冷技术大会

施耐德电气即将亮相2025中国数据中心液冷技术大会

Molex莫仕助力数据中心浸没式冷却系统未来发展

数据中心发展与改造

浸没式液冷在数据中心的发展历程与应用现状

浸没式液冷在数据中心的发展历程与应用现状

评论