众所周知,环境因素会严重影响数据中心设备。过多的热量积聚会损坏服务器,可能导致其自动关闭。经常在高于可接受的温度下运行服务器会缩短其使用寿命,并导致更频繁的设备更换。

不过,危险不仅仅在于高温。高湿度也会导致冷凝、腐蚀和灰尘等污染物堆积在数据中心的设备上。同时,低湿度会导致两个物体之间发生静电放电,从而损坏设备。

而经过适当校准的冷却系统可以防止这些问题,并让数据中心全天候保持正确的温度和湿度,从而最终会降低设备损坏造成的运营风险。因此,数据中心运营商可以通过一些方法确定数据中心所需的冷却标准。

数据中心冷却标准

例如,ASHRAE(美国采暖、制冷与空调工程师学会)制定并发布了数据中心的温度和湿度指南。最新版本根据设备分类概述了可以可靠运行数据中心的温度和湿度水平。

在最新的指南中,ASHRAE 建议 IT 设备应遵循以下使用方式:

温度在 18 至 27 摄氏度之间。

露点为 -9 至 15 C摄氏度。

相对湿度为60%。

确定 IT 设备的适当环境取决于其分类(A1 至 A4),该分类基于设备的类型及其运行方式,按敏感度降序排列。A1 设备是指需要最严格环境控制的企业服务器和其他存储设备。A4 级适用于 PC、存储产品、工作站和大容量服务器,允许的温度和湿度范围最广。

这些指南的先前版本侧重于可靠性和正常运行时间,而不是能源成本。为了与数据中心对节能技术和效率的日益关注保持一致,ASHRAE 开发了更好地概述环境和能源影响的课程。

审核编辑 黄宇

-

数据中心

+关注

关注

16文章

5518浏览量

74651

发布评论请先 登录

技术资讯 I 数据中心能否承受高温运行?

华为液冷热管理控制器TMU荣获“数据中心冷却创新奖”

Kao Data与Cadence合作验证数据中心间接蒸发冷却设计

易华录参编的绿色数据中心评价国家标准发布

数据中心冷却技术的发展趋势

尼得科从5月开始量产AI数据中心新型冷却系统产品——行间式(In Row式)大型CDU

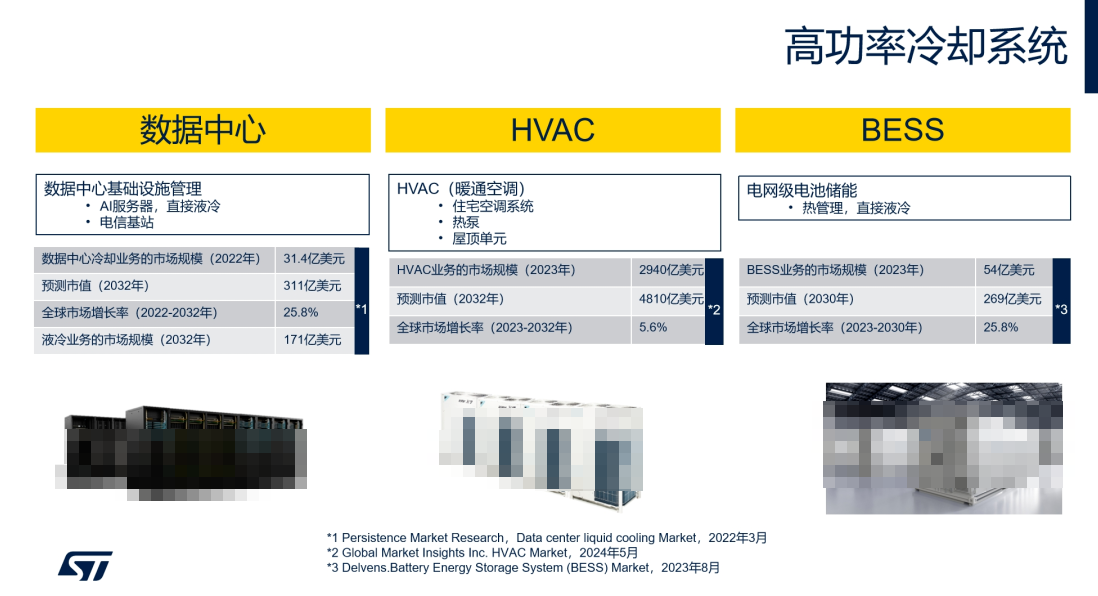

ST电机控制方案如何为数据中心等高功率冷却系统“降温增效”

华为亮相2025数据中心冷却高峰论坛(长三角)

适用于数据中心和AI时代的800G网络

优化800G数据中心:高速线缆、有源光缆和光纤跳线解决方案

Molex莫仕助力数据中心浸没式冷却系统未来发展

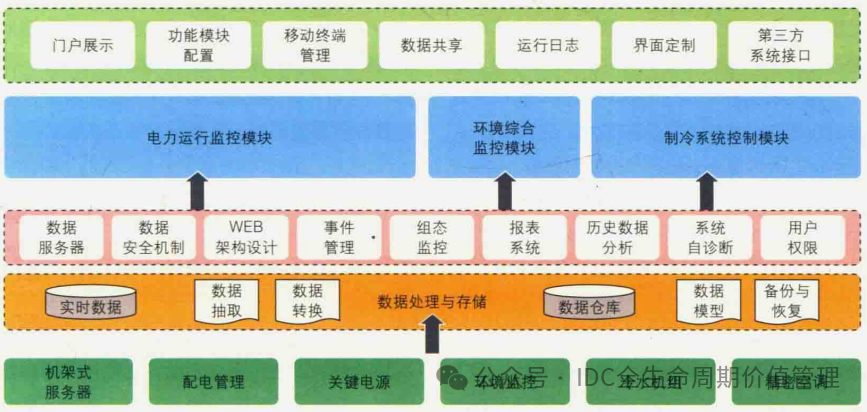

数据中心中温冷源供应系统

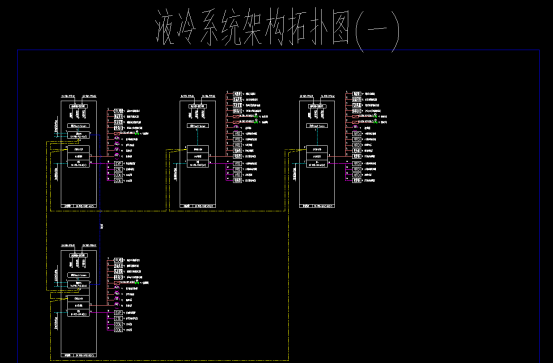

数据中心机房冷水系统

数据中心冷却标准

数据中心冷却标准

评论