作者:一号

编辑:美美

大模型不是AI的唯一出路,把模型做小也是本事。

这段时间,AI模型界是真的热闹,新的模型不断涌现,不管是开源还是闭源,都在刷新成绩。就在前几天,Meta就上演了一出“重夺开源铁王座”的好戏。发布了Llama 3 8B和70B两个版本,在多项指标上都超越了此前开源的Grok-1和DBRX,成为了新的开源大模型王者。

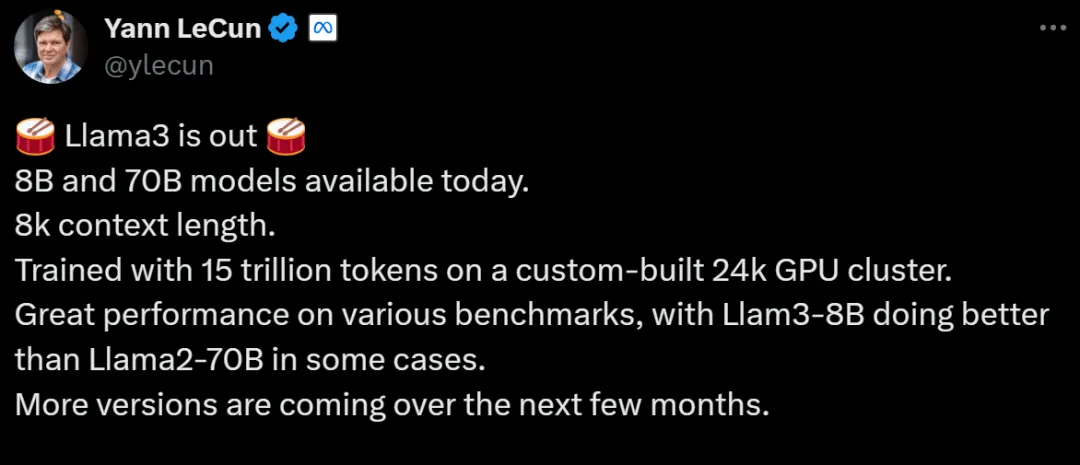

并且Meta还透露,之后还将推出400B版本的Llama 3,它的测试成绩可是在很多方面上都追上了OpenAI闭源的GPT-4,让很多人都直呼,开源版的GPT-4就要来了。尽管在参数量上来看,相比Llama 2,Llama 3并没有特别大的提升,但是在某些表现上,Llama 3最小的8B版本都比Llama 2 70B要好。可见,模型性能的提升,并非只有堆参数这一种做法。

Llama 3重回开源之王

当地时间4月18日,“真·OpenAI”——Meta跑出了目前最强的开源大模型Llama 3。本次Meta共发布了两款开源的Llama 3 8B和Llama 3 70B模型。根据Meta的说法,这两个版本的Llama 3是目前同体量下,性能最好的开源模型。并且在某些数据集上,Llama 3 8B的性能比Llama 2 70B还要强,要知道,这两者的参数可是相差了一个数量级。

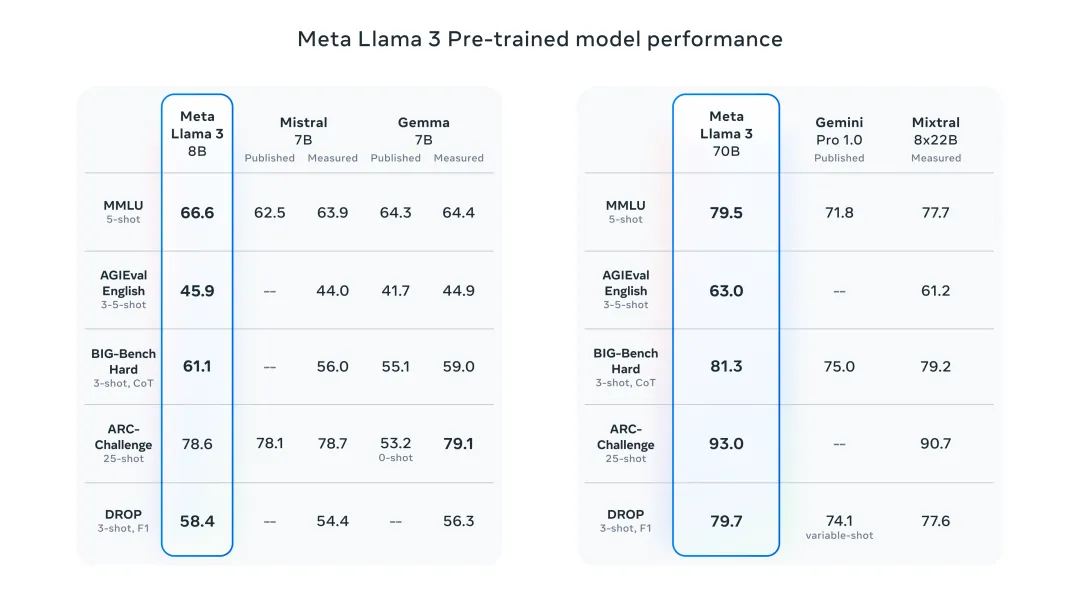

能够做到这点,可能是因为Llama 3的训练效率要高3倍,它基于超过15T token训练,这比Llama 2数据集的7倍还多。在MMLU、ARC、DROP等基准测试中,Llama 3 8B在九项测试中领先于同行,Llama 3 70B也同样击败了Gemini 1.5 Pro和Claude 3 Sonnet。

尽管在参数量上并没有特别大的提升,但毫无疑问,Llama 3的性能已经得到了很大的进步,可以说是用相近的参数量获得了更好的性能,这可能是在算力资源短期内无法满足更大规模运算的情况下所作出的选择,但这体现了AI模型的研发并非只有堆砌参数这一条“大力出奇迹”的道路。

把大模型做小正成业内共识

实际上,在Llama 3之间的两位开源王者,Grok-1和DBRX也致力于把模型做小。和以往的大模型,使用一个模型解决一切问题的方式不同,Grok-1和DBRX都采用了MoE架构(专家模型架构),在面对不同问题的时候,调用不同的小模型来解决,实现在节省算力的情况下,保证回答的质量。

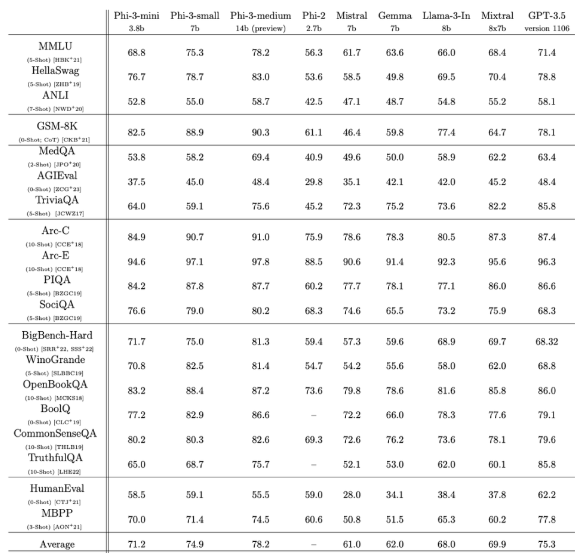

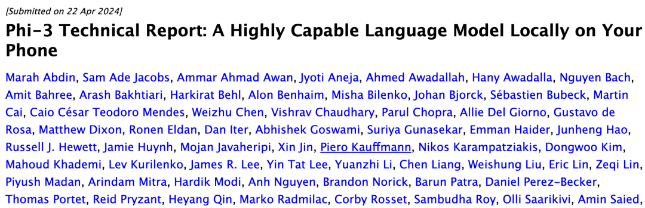

而微软也在Llama 3发布后没几天,就出手截胡,展示了Phi-3系列小模型的技术报告。在这份报告中,仅3.8B参数的Phi-3-mini在多项基准测试中都超过了Llama 3 8B,并且为了方便开源社区使用,还特意把它设计成了与Llama系列兼容的结构。更夸张的是,微软的这个模型,在手机上也能直接跑,经4bit量化后的phi-3-mini在iPhone 14 pro和iPhone 15使用的苹果A16芯片上能够跑到每秒12 token,这也就意味着,现在手机上能本地运行的最佳开源模型,已经做到了ChatGPT水平。

而除了mini杯外,微软也一并发布了小杯和中杯,7B参数的Phi-3-small和14B参数的Phi-3-medium。在技术报告中,微软也说了,去年研究团队就发现,单纯堆砌参数量并非提升模型性能的唯一路径,反而是精心设计训练的数据,尤其是利用大模型本身去生成合成数据,并配合严格过滤的高质量数据,能够让中小模型的能力大幅跃升,所以他们也说,Textbooks are all you need,教科书级别的高质量数据才是重要的。

AI模型发展正着力于摆脱限制

自英伟达乘着AI的东风,成为行业内说一不二,当之无愧的“卖铲子的人”,各家AI公司都将英伟达的GPU视为“硬通货”,以致于谁囤有更多的英伟达的GPU,谁的AI实力就强。但英伟达的GPU的交付并未能始终跟上市场的需求。

因此,很多AI公司开始另谋出路,要么找其他的GPU生产商,要么决定自己研发AI芯片。即使你囤够了英伟达的GPU,也还有其他限制,OpenAI在前段时间就被爆出,因为训练GPT-6,差点把微软的电网搞瘫痪。马斯克也曾说过,当前限制AI发展的主要因素是算力资源,但在未来,电力会成为限制AI发展的另一阻碍。

显然,如果持续“大力出奇迹”,通过堆砌参数量来实现AI性能的提升,那么以上这些问题迟早会遇到,但是如果把大模型做小,使用较小的参数量,实现同样或者更好的性能,那么将可以显著减少对算力资源的需求,进而减少对电力资源的消耗,从而让AI在有限资源的情况下,得到更好的发展。

因此,接下来,谁能在将模型做小的同时,还能实现性能的增长,也是实力的体现。

审核编辑 黄宇

-

AI

+关注

关注

90文章

38303浏览量

297397 -

算力

+关注

关注

2文章

1400浏览量

16588

发布评论请先 登录

新火种AI|算力不足,小模型成AI模型发展下个方向?

新火种AI|算力不足,小模型成AI模型发展下个方向?

评论