我们知道,大模型会编造不正确的答案,产生“幻觉”。

其实,在应用层面,还存在一个更隐蔽的“幻觉”,就是创业公司忽略了大模型落地所需要的长周期、重基建和工程化难度,带来的“速成幻觉”。

随着“百模大战”拉开序幕,大模型过剩带来的市场挤压,也给整个大模型生态带来了行业洗牌的风险。

越来越多的人有了共识,基础通用大模型竞争激烈,注定是少数人的游戏。创业公司随时可能倒掉,造成项目烂尾。

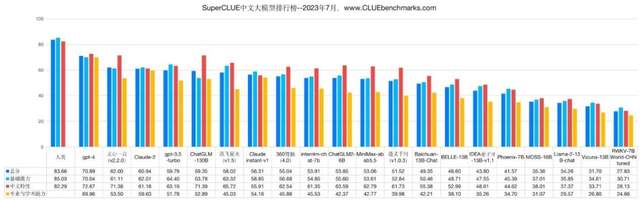

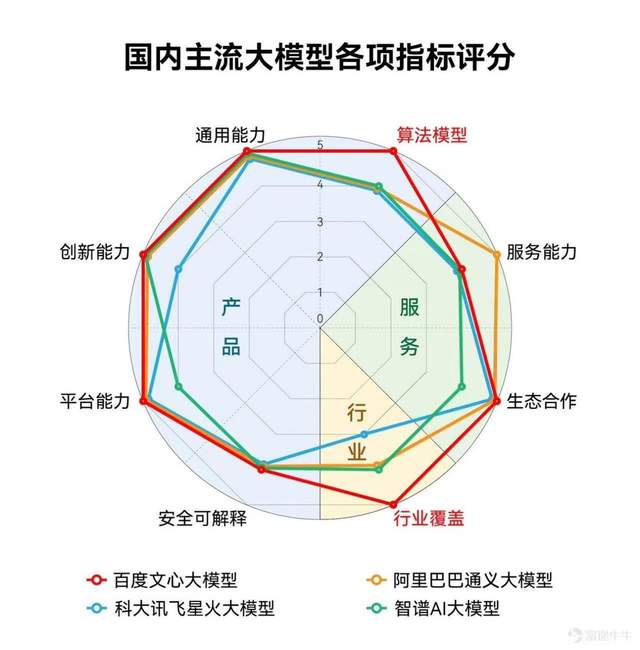

具备技术、产品和行业优势的“第一梯队”大厂,比如百度的文心大模型3.5,已经跟国内其他模型拉开了差距,具有了一定的先发优势和市场打开度,更容易在这场白热化竞争中生存下来。

既然大模型很难“速成”,那么创业公司的“幻觉”,又是从何而来的呢?

第一种“幻觉”:开源干翻闭源

创业公司纷纷入局大模型,给它们勇气的,不是梁静茹,而是开源。

以Meta的Llama 2、智谱AI的ChatGLM为代表的开源大模型,陆续免费并支持授权商用,这无疑是一件好事,让创业公司不用重复造轮子,可以用开源大模型作为基座模型,快速开发出相应的商用版本大模型或大模型应用。

开源的低门槛、低成本,带来了“开源干翻闭源”的幻觉。

为什么说是幻觉?我们可以从企业视角为出发点——即使有了开源模型,想要落地应用大模型,还有哪些必要条件?

一是云基础设施。

大模型落地需要进一步微调、训练、运行,要在云平台上运行。而创业公司跟OpenAI 、百度等闭源头部公司的一大差距,就在于缺少跟云平台的“紧耦合”。

众所周知,OpenAI有微软的大力支持,百度文心大模型背后是百度智能云,这些大厂自研大模型,都对云基础设施的计算硬件集群、资源调度等,进行针对性的协调优化,大模型+AI云的紧密配合,可以更高效地利用计算资源,降低大模型的边际成本。

海外大模型开源社区的“明星”如Together会为企业客户提供开源模型及配套的云平台,MosaicML也提供Mosaic Cloud 和多云混合服务,国內的开源项目如ChatGLM,也选择与多家云厂商合作。

可以看到,开源项目跟云平台的“松耦合”,会受到云平台的配合度、商业政策等的影响,一旦后期出现资源涨价、利益分成、研发意向变化,都会给基于开源的大模型项目带来商业化风险。

其次,是二次开发。

基于开源模型的创业公司,往往是在底座模型的基础上做一些微调,灵活有余,但开源模型的分支多、变异快、创新迭代速度快,不承诺任何确定性,一般由程序员自组织来完成开发,这就导致基于开源的大模型稳定性不足,对客户技术团队二次开发能力要求很高,选型难度也很大。

目前看,第一梯队的大厂推出的基础大模型,更能满足企业对大模型稳定性、可靠性的需求。

因为闭源大模型,遵循的不是开源范式,而是工程范式,所以,会以保证开发质量为前提,对用户需求进行明确的描述,组织工程师按照规范的开发流程和周期,以确定的时间和预算,更好的控制开发质量,保证开发效率。

开源是一件好事,但开源并不是一把万能钥匙。如果不解决基础设施、二次开发等瓶颈,创业公司也无法靠开源,快速取得成功。

第二个“幻觉”:三五个人干翻大厂

因为开源,创业公司和互联网企业都可以叫卖大模型,这就产生了第二个“幻觉”:三五个人的创业团队,就能干翻AI大厂。

需要注意的是,“百模大战”带来了白热化的淘汰赛,同时,大模型还在以周为单位进行迭代。

在激荡的市场竞争中,具有长期研发能力和投入意愿的大厂,更容易保持动态的生长力和持久的话语权,体现在几个方面:

一是模型本身的技术城池。

谷歌研发人员此前曾发文称,因为开源,谷歌和OpenAI都没有护城河。这在长期看是对的,但大厂在大模型技术上的领先性,也是现实存在的优势,这个技术代差,足以在大模型的商用周期中,为大厂带来显著的竞争优势。

而且,大模型具有数据上的“飞轮效应”,更早应用、更多用户的大厂大模型,会不断拉大效果差距。比如国內最早推向大众的文心大模型,其3.5版本已经在一些基准测试中,超过了GPT3.5的表现,而宣称达到GPT-3.5的Llama 2刚开源不久,因此目前国产开源大模型最多也就达到GPT-3的水平。

二是持续迭代的成长能力。

大模型落地不是一蹴而就的,企业应用大模型也不能上马后很快不了了之,后续的算力成本、数据工程负担、每一次迭代的资金压力,很快就成为困扰很多大模型公司的头疼问题。

目前,已经有不少曾经想走商业闭源路线的大模型创业公司,直接宣布退出竞争。光年之外中途离场,被美团接手;Hugging Face专注卖算力资源和咨询业务,做大模型更多是“面子工程”。部分企业的表现,也会直接影响到市场对其“是否有钱继续做大模型”的信心。

从成长性看,有资金实力、基础设施完整、商业表现良好的大厂,才能陪企业用户走得更远。

比如“文心一言”3月16日推出以来,在一个月内完成4次迭代,将推理成本降为原来的十分之一,离不开百度在大模型上的长期投入,以及人、钱、卡、基建等多种方面的储备,才让文心一言可以持续进化,在高速迭代的大模型竞争中保持领先。

三是完善的工具链。

没有人会否认,大模型是拿来用的,不是为了当摆设或“公关效应”的。

要用,就要考虑到技术和场景的适配。不同行业和企业对于大模型落地的需求,可能是完全不同的,这种差异化,需要更完善、全面的配套工具,来降低应用门槛。举个例子,行业+大模型需要进行专有数据的清洗、标注、向量化等工作,这个过程是非常复杂的。

三五人的创业团队,很难将主要研发力量,放在开发这些看上去技术含量不高、但对用户十分重要的工具上。

这时候,百度等大厂长期押注AI的优势就凸显出来了,已经沉淀了从数据集、模型训练、开发部署等整套流程的工具,并且开箱即用,把大模型到产业落地的门槛不断降低,从而开启增长飞轮。

四是长期积累的行业Knowhow。

大模型产业化,走向ToB和ToG是大势所趋,要求对行业Knowhow有深层次的理解。因此,政企客户在大模型选型时,非常看重厂商的成功案例和行业服务经验。

AI大厂在产业已经深耕多年,因此大模型的商业开发度更高。目前,百度“文心大模型+飞桨深度学习框架”的组合已与300多家客户合作,在400多个企业场景中取得良好测试效果,并打造了10多个行业大模型。

与之相比,还没有走通产业场景的创业公司,在技术体验、功能创新、工程能力等细节上,可能还需要花费更多时间去摸索。

从这些角度看,头部大模型已经建立起了较为明显的优势,并且还在持续进化。三五人的创业公司,想要在高速迭代的大模型竞争中干翻大厂,需要补的课有点多。

第三个“幻觉”:大模型能“赚快钱”

创业公司通过“资金换规模”的短平快战略,上市融资再套现离场,来兑现投资回报,已经越来越难了,在大模型领域并不现实。那么,另一条路就是通过ToB客户付费,来完成大模型的商业化。

众所周知,ToB行业要干苦活累活。

企业客户在业务场景中接入大模型,可能带来一系列复杂的整合动作,是一个体系化工程,这就要求大模型厂商不能单一快节奏地交付,而要提供解决方案式的整体能力,以及长时间的更新运维服务。

一个项目的交付、运维、迭代、回款等,可能以年计,是无法快进快出的。所以,大模型下沉到行业,必须打消“赚快钱”的念头,以长期主义的心态来做生意。

构建服务团队、形成服务基因,对创业公司及其背后的投资机构的耐心和定力来说,是不小的考验。

与之相比,大厂在长期走向ToB/ToG市场的过程中,已经经历了客户的捶打,锻炼出了更加成熟的服务铁军,也证明了自身的定力。

以百度为例,对于不同行业,有深入了解客户的交付、运维和保障专属团队,在大模型落地应用时,能够给予更具针对性的方案,从而减少无效支出,让大模型更好地帮助企业提质增效。

大模型厂商不能一心只想“赚快钱”,要沉下心来走向产业深处。同样的,企业引入大模型也不能一心只“图便宜”,要从智能化转型升级的这个生命周期出发算总账,综合考虑改造、交付、运维等多项成本。

大模型强大的理解能力和泛化能力,会加速产业智能化的进程,也让AI企业和创业公司发现了新的机会。

就像啤酒总是伴随着泡沫,在一拥而上的大模型创投热潮中,创业公司和企业客户也很容易陷入“速成幻觉”。

大模型走向产业的长路,更需保持冷静和理性,警惕“烂尾”风险。希望大家真正饮下的,是用时间和技术沉淀的精酿,而非随时可能消失的“泡沫”。

-

AI

+关注

关注

89文章

38120浏览量

296661 -

ChatGPT

+关注

关注

31文章

1596浏览量

10074 -

文心一言

+关注

关注

0文章

134浏览量

2091 -

大模型

+关注

关注

2文章

3442浏览量

4967

发布评论请先 登录

PREEvision EXPRESS速成系列全新上线

AI智能体+AIoT:智能时代的关键联结,还是又一场幻觉与泡沫?

开普云「开悟智核」:极致性价比的智能体一体机,破局大模型应用难题

如何高效训练AI模型?这些常用工具你必须知道!

浅谈华为通信大模型的关键技术

请问如何获得AD8000的IBIS模型?

利用腾讯ima收藏公众号推文构建个人知识库,拒绝AI幻觉

百度发布文心大模型4.5和文心大模型X1

维智科技时空大模型助力城市治理智能化转型

DeepSeek大模型如何推动“AI+物流”融合创新

如何在英特尔平台上高效部署DeepSeek模型

广和通支持DeepSeek-R1蒸馏模型

大模型遭遇算力墙,探索超级应用的发展路径

大模型应用,必须警惕“速成幻觉”

大模型应用,必须警惕“速成幻觉”

评论