随着人工智能技术的迅猛发展,大规模语言模型(LLMs)在自然语言处理、内容生成和智能对话等领域的应用日益广泛。国产 AI 大模型 DeepSeek 凭借其强大的生成能力和广泛的应用场景,迅速成为业界焦点。

目前,我们已经在英特尔 酷睿 处理器与英特尔锐炫 显卡组成的硬件配置上,完成对大模型推理的验证,为 AI 模型的部署和推理提供了强有力的支持。

本文将带您深入了解如何在英特尔平台上高效部署 DeepSeek 模型,充分发挥其潜力,助力 AI 应用的快速落地。

1硬件配置

GPU: 英特尔锐炫 B580 12G

2BIOS 配置

安装英特尔锐炫显卡后,必须在 BIOS 中启用 PCIe 可重设 BAR(Base Address Register)。

3操作系统和驱动程序安装

3.1Ubuntu* 24.10 操作系统安装

以下是下载和安装 Ubuntu 24.10 的步骤:

1)下载并安装Ubuntu 24.10

wget https://releases.ubuntu.com/24.10/ubuntu-24.10-desktop-amd64.iso

2)关闭 Ubuntu 无人值守升级,以避免未经验证的内核更新。

登录 Ubuntu 后,设置屏幕永不锁定并启用自动登录。

Setting->Power->Power Saving->Screen Blank->Never

设置 -> 电源 -> 节能 -> 屏幕空白 -> 从不

System->Users->Automatic Login

系统 -> 用户 -> 自动登录

sudo systemctl disable --now unattended-upgrades

然后编辑/etc/apt/apt.conf.d/20auto-upgrades,将Unattended-Upgrade设置为 “0”。

3)检查内核版本是否为6.11.

$ uname -a Linux benchmark-Z590-VISION-D 6.11.0-8-generic #8-Ubuntu SMP PREEMPT_DYNAMIC Mon Sep 16 1320 UTC 2024 x86_64 x86_64 x86_64 GNU/Linux

4)重新启动设备,查看显示是否正常工作。

3.2 英特尔客户端 GPU

驱动程序安装(ARC B 系列)

参考:

https://dgpu-docs.intel.com/driver/client/overview.html#installing-client-gpus-on-ubuntu-desktop-24-10

3.2.1在 Ubuntu Desktop 24.10 上

安装客户端 GPU

使用以下命令安装 intel-graphics PPA 和必要的计算与媒体包:

sudo apt-get update sudo apt-get install -y software-properties-common # Add the intel-graphics PPA for 24.10 sudo add-apt-repository -y ppa:kobuk-team/intel-graphics # Install the compute-related packages sudo apt-get install -y libze-intel-gpu1 libze1 intel-ocloc intel-opencl-icd clinfo intel-gsc hwinfo # Install the media-related packages sudo apt-get install -y intel-media-va-driver-non-free libmfx1 libmfx-gen1 libvpl2 libvpl-tools libva-glx2 va-driver-all vainfo

上述命令安装了大多数用户所需的所有基本包,旨在尽量减少不必要的包安装。

请注意,不同版本的 intel-opencl-icd 可能会有不同的性能表现。

3.2.2 配置渲染组成员资格

要访问 GPU 功能,当前用户必须能够访问/dev/dri 中的 DRM 渲染节点。

如果当前用户不是 DRM 渲染节点(通常为 'render')组的成员,请将用户添加到渲染节点组。

sudo gpasswd -a ${USER} render

这对更新后创建的 shell 就足够了。要更改当前 shell 的组 ID:

newgrp render

3.3 验证英特尔锐炫 B580 PCIe 配置空间

确保英特尔锐炫 B580 PCIe 配置空间具有 12GB 的 BAR2。以下是检查 GPU PCIe 配置空间的指南:

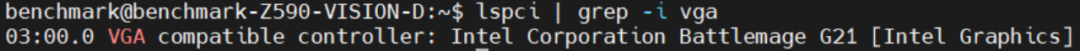

步骤 1:列出 VGA 设备的 PCIe 总线地址。

lspci | grep -i vga

您将在屏幕上看到这些消息:

步骤 2:检查英特尔锐炫 B580 的 PCIe 功能。

sudo lspci -s 03:00 -vvv | grep BAR

您将看到英特尔锐炫 B580 的 PCIe 功能,并检查 PCIe 配置空间。

4OpenVINO 和基准测试工具安装

OpenVINO 是一个开源工具包,用于优化和部署从云到边缘的深度学习模型。它加速了各种用例的深度学习推理,如生成式 AI、视频、音频和语言,支持来自流行框架(如 PyTorch、TensorFlow、ONNX 等)的模型。转换和优化模型,并部署在混合的英特尔 硬件和环境中,无论是在本地、设备上、浏览器中还是云端。

OpenVINO GenAI 是 OpenVINO 的一个变体,旨在简化生成式 AI 模型的推理运行。它隐藏了生成过程的复杂性,并最大限度地减少了所需的代码量。

使用以下命令快速安装 OpenVINO 和工具。

git clone https://github.com/openvinotoolkit/openvino.genai.git cd ./tools/llm_bench python3 -m venv python-env source python-env/bin/activate pip install --upgrade pip pip install -r requirements.txt

更多详情请参考openvino.genai/tools/llm_bench at master · openvinotoolkit/openvino.genai · GitHub

https://github.com/openvinotoolkit/openvino.genai/tree/master/tools/llm_bench

5运行 DeepSeek蒸馏模型的基准测试

5.1 下载预训练的 LLM 模型

访问:

https://huggingface.co或https://www.modelscope.cn

下载 deepseek 蒸馏模型,并将下载的模型保存在~/models 文件夹中。

5.2将模型转换为 OpenVINO IR

运行以下命令将 DeepSeek-R1-Distill-Qwen-7B 转换为 IR 格式并将权重压缩为 INT4。您的系统必须至少具有 64GB 内存才能进行转换。

optimum-cli export openvino --framework pt -m ./DeepSeek-R1-Distill-Qwen-7B --weight-format int4 –sym --trust-remote-code --task text-generation-with-past ./DeepSeek-R1-Distill-Qwen-7B-IR

5.3 使用 OpenVINO 启动 LLM 基准测试

要在 B580 上启动 LLM 模型 DeepSeek-R1-Distill-Qwen-7B 的基准测试,请运行以下命令:

python3 benchmark.py -m DeepSeek-R1-Distill-Qwen-7B-IR -n 1 -d GPU python benchmark.py -m DeepSeek-R1-Distill-Qwen-7B-IR -p "What is openvino?" -n 1 -d GPU

测试结果将显示在屏幕上。请注意,结果可能因平台和软件版本而异。

通过本文的详细步骤和配置指南,我们成功在英特尔平台上验证了 DeepSeek 蒸馏模型的推理性能。从硬件配置、BIOS 设置、操作系统安装到驱动程序和 OpenVINO 工具的部署,每一步都确保了系统发挥更卓越的性能。

通过基准测试,我们展示了 DeepSeek-R1-Distill-Qwen 系列模型在 INT4 精度下的高效推理能力,尤其是在首个 token 和后续 token 的延迟表现上,展现了英特尔锐炫 显卡在处理大模型推理任务时的强大潜力。英特尔锐炫 B580能够为AI工作负载提供加速,其配备的英特尔Xe矩阵计算引擎(XMX),为新推出的XeSS 2提供强大支持。OpenVINO 工具套件可以缩短延迟,提高吞吐量,加速 AI 推理过程,同时保持精度,缩小模型占用空间,优化硬件使用。

未来,随着硬件和软件的进一步优化,我们期待在更多复杂场景中,特别是在生成式 AI 和大规模语言模型的应用中,验证和英特尔锐炫 显卡的性能,通过英特尔丰富的软硬件产品协同,为 DeepSeek 及各种 AI 大模型的应用提供更强大的算力,让边缘侧部署 AI 的使用场景有更多可能。

-

英特尔

+关注

关注

61文章

10275浏览量

179320 -

显卡

+关注

关注

16文章

2517浏览量

71063 -

人工智能

+关注

关注

1813文章

49741浏览量

261566 -

DeepSeek

+关注

关注

2文章

824浏览量

2812

原文标题:DeepSeek 模型在英特尔锐炫™ 显卡上的高效推理实践

文章出处:【微信号:英特尔物联网,微信公众号:英特尔物联网】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

MWC上海2018:英特尔助力合作伙伴加速5G部署

英特尔CPU部署Qwen 1.8B模型的过程

英特尔Gaudi 2E AI加速器为DeepSeek-V3.1提供加速支持

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略

OpenCL平台和英特尔Stratix 10 FPGA的结合使用

为什么选择加入英特尔?

介绍英特尔®分布式OpenVINO™工具包

英特尔Context Sensing SDK跨平台上下文感知体验

由Gayathri Murali设计英特尔平台上的Android

如何在英特尔® 平台上实现高效的大语言模型训练后量化

英特尔酷睿Ultra处理器支持DeepSeek运行

探索座舱“未至之境”:英特尔支持DeepSeek车内本地运行

英特尔赋能DeepSeek本地运行,助力汽车升级“最强大脑”

硬件与应用同频共振,英特尔Day 0适配腾讯开源混元大模型

如何在英特尔平台上高效部署DeepSeek模型

如何在英特尔平台上高效部署DeepSeek模型

评论