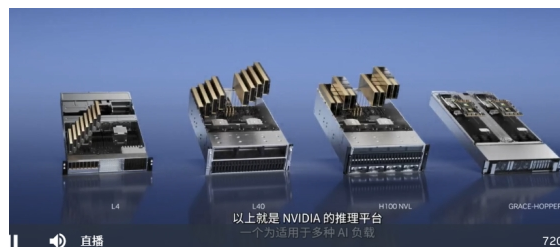

针对ChatGPT等大型语言模型的推理,我们宣布推出一款新的Hopper GPU配备双GPU NVLINK的PCIE H100

同时还可支持商用PCIE服务器轻松扩展

目前在云上唯一可以实际处理ChatGPT的GPU是HGX A100与适用于GPT-3处理的HGX A100相比,一台搭载四对H100及双GPU NVLINK的标准服务器的速度

H100可将大型语言模型的处理成本,降低一个数量级

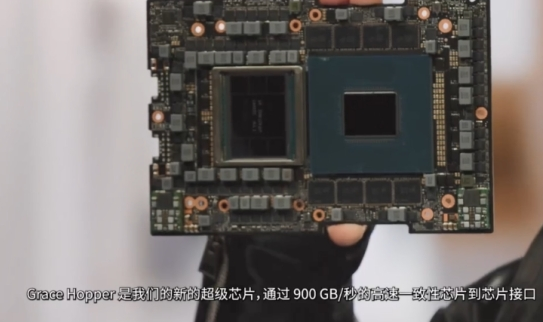

Grace Hopper非常适合处理大型数据集,例如适用于推荐系统和大型语言模型的AI数据库。

如今,利用大容量内存,CPU会存储和查询巨型嵌入表,然后将结果传输到GPU进行推理,借助Grace-Hopper, Grace可以查询嵌入表,并将结果直接传输到Hopper速度比PCIE快7倍

GTC 2023主题直播地址:https://t.elecfans.com/live/2302.html

-

cpu

+关注

关注

68文章

11216浏览量

222912 -

服务器

+关注

关注

13文章

10094浏览量

90873 -

gtc

+关注

关注

0文章

73浏览量

4719 -

ChatGPT

+关注

关注

31文章

1596浏览量

10071

发布评论请先 登录

NVIDIA新闻:英伟达10亿美元入股诺基亚 英伟达推出全新量子设备

今日看点:苹果认证中国快充品牌遭美调查;英伟达拟向OpenAI投资最高1000亿美元

传英伟达自研HBM基础裸片

aicube的n卡gpu索引该如何添加?

英伟达获美批准恢复H20在华销售,同步推出全新兼容GPU

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】+NVlink技术从应用到原理

英伟达拟再推中国特供GPU,今年6月量产!

GPU 维修干货 | 英伟达 GPU H100 常见故障有哪些?

立讯技术亮相英伟达GTC 2025大会

GTC 2023直播:英伟达推出Hopper GPU,速度比PCIE快7倍

GTC 2023直播:英伟达推出Hopper GPU,速度比PCIE快7倍

评论