YOLOX目标检测模型

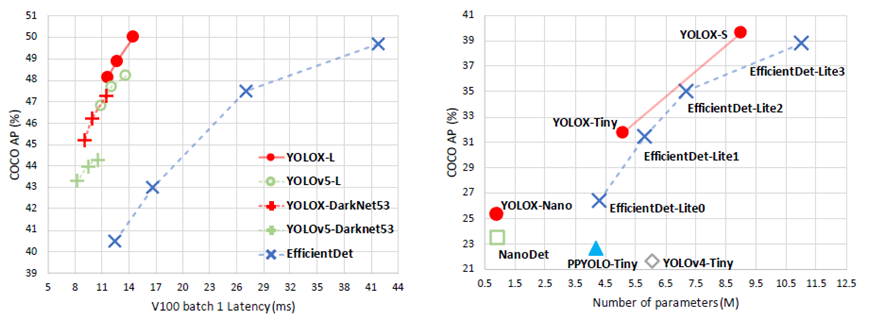

旷视科技开源了内部目标检测模型-YOLOX,性能与速度全面超越YOLOv5早期版本!

https://arxiv.org/pdf/2107.08430.pdfhttps://github.com/Megvii-BaseDetection/YOLOX

ONNX格式模型转与部署

下载YOLOX的ONNX格式模型(github上可以下载)https://github.com/Megvii-BaseDetection/YOLOX/tree/main/demo/ONNXRuntimehttps://github.com/Megvii-BaseDetection/YOLOX/releases/download/0.1.1rc0/yolox_s.onnx

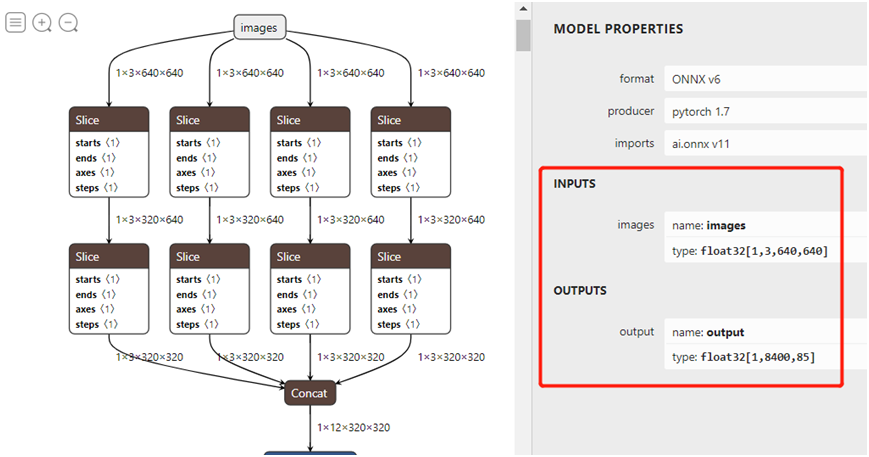

下载ONNX格式模型,打开之后如图:

官方说明ONNX格式支持OpenVINO、ONNXRUNTIME、TensorRT三种方式,而且都提供源码,官方提供的源码参考如下:输入格式:1x3x640x640,默认BGR,无需归一化。输出格式:1x8400x85

https://github.com/Megvii-BaseDetection/YOLOX/tree/main/demo

本人就是参考上述的代码然后一通猛改,分别封装成三个类,完成了统一接口,公用了后处理部分的代码,基于本人笔记本的硬件资源与软件版本:

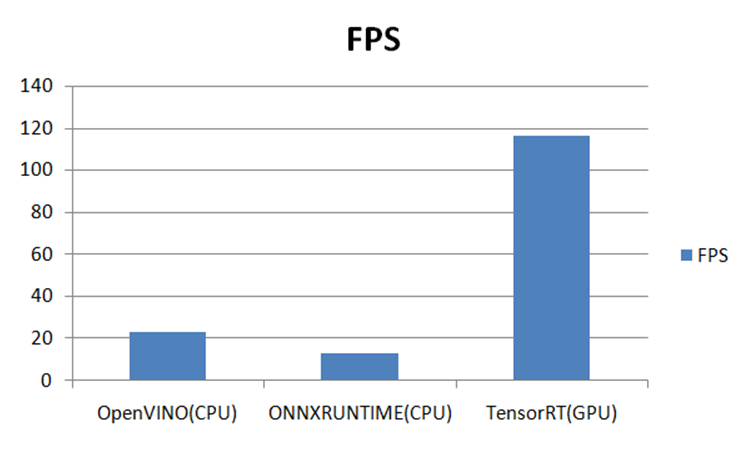

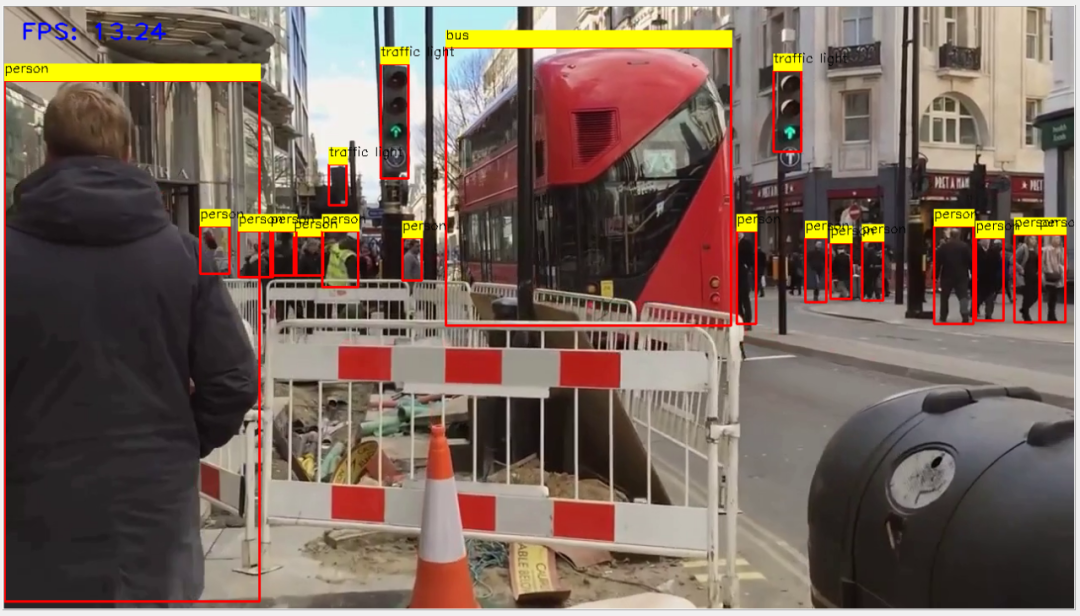

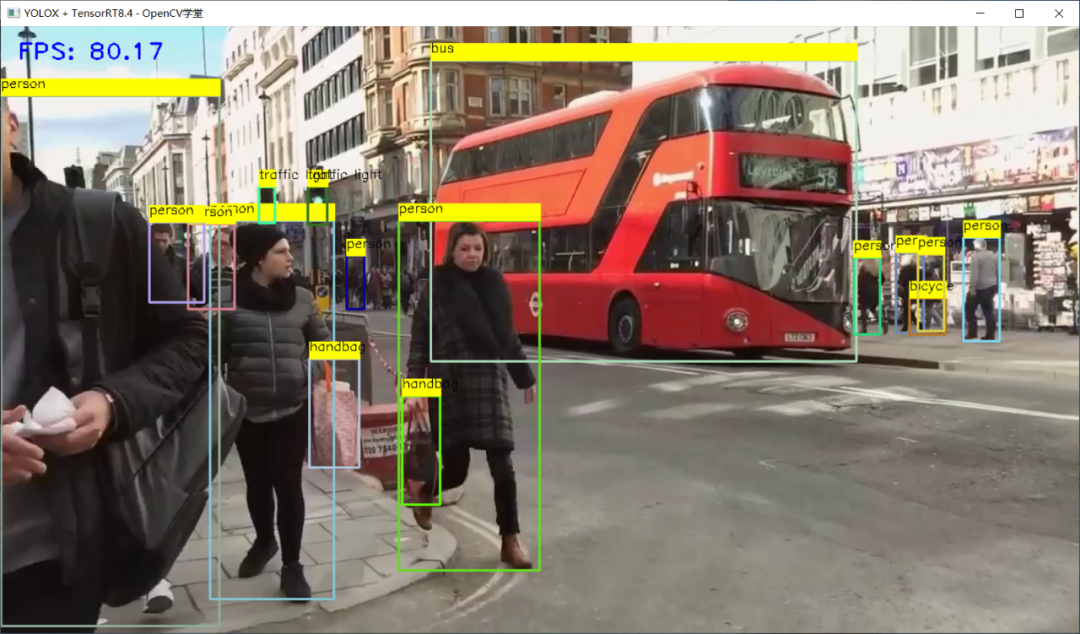

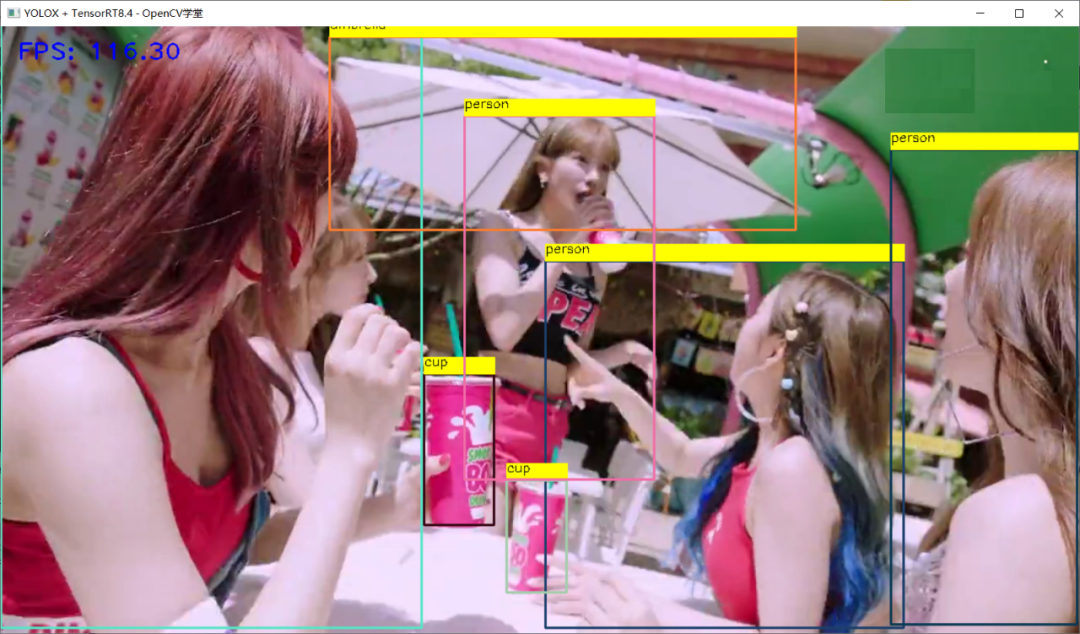

在三个推理平台上测试结果如下:-GPU 3050Ti-CPU i7 11代-OS:Win10 64位-OpenVINO2021.4-ONNXRUNTIME:1.7-CPU-OpenCV4.5.4-Python3.6.5-YOLOX-TensorRT8.4.x

OpenVINO推理

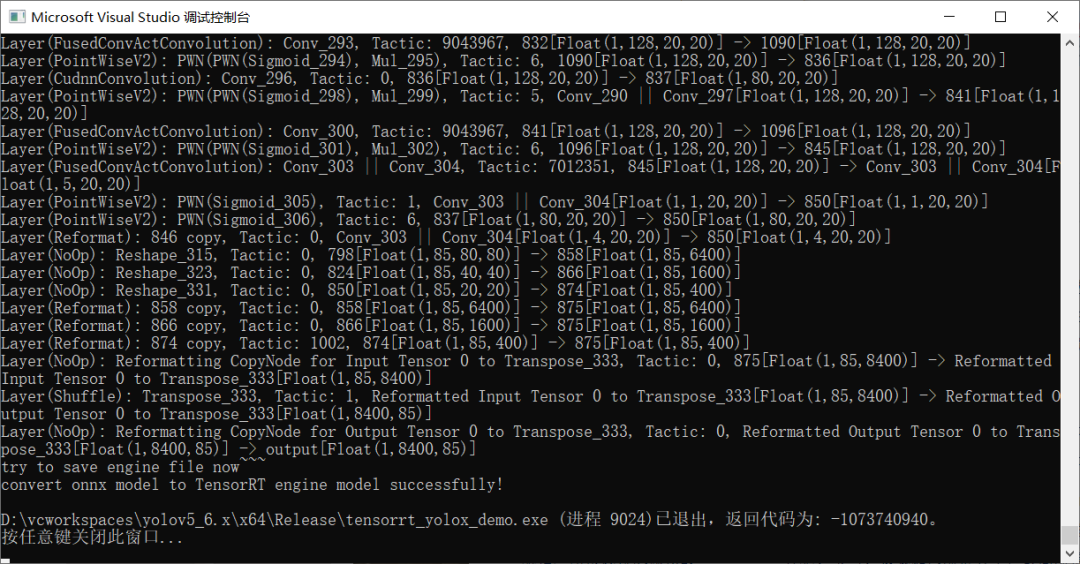

TensorRT推理 - FP32

转威FP16

TensorRT推理 - FP16

总结

之前我写过一篇文章比较了YOLOv5最新版本在OpenVINO、ONNXRUNTIME、OpenCV DNN上的速度比较,现在加上本篇比较了YOLOX在TensorRT、OpenVINO、ONNXRUNTIME上推理部署速度比较,得到的结论就是:能不改代码,同时支持CPU跟GPU推理是ONNXRUNTIMEOpenCV DNN毫无意外的速度最慢(CPU/GPU)CPU上速度最快的是OpenVINOGPU上速度最快的是TensorRT

原文标题:YOLOX在OpenVINO、ONNXRUNTIME、TensorRT上面推理部署与速度比较

文章出处:【微信公众号:OpenCV学堂】欢迎添加关注!文章转载请注明出处。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

模型

+关注

关注

1文章

3648浏览量

51710 -

目标检测

+关注

关注

0文章

230浏览量

16378 -

OpenCV

+关注

关注

33文章

651浏览量

44411

原文标题:YOLOX在OpenVINO、ONNXRUNTIME、TensorRT上面推理部署与速度比较

文章出处:【微信号:CVSCHOOL,微信公众号:OpenCV学堂】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

热点推荐

NVIDIA TensorRT LLM 1.0推理框架正式上线

TensorRT LLM 作为 NVIDIA 为大规模 LLM 推理打造的推理框架,核心目标是突破 NVIDIA 平台上的推理性能瓶颈。为实现这一目

什么是AI模型的推理能力

NVIDIA 的数据工厂团队为 NVIDIA Cosmos Reason 等 AI 模型奠定了基础,该模型近日在 Hugging Face 的物理推理模型排行榜中位列榜首。

使用aicube进行目标检测识别数字项目的时候,在评估环节卡住了,怎么解决?

使用aicube进行目标检测识别数字项目的时候,前面一切正常

但是在评估环节卡住了,一直显示正在测试,但是完全没有测试结果,

在部署完模型后在k230上运行也没有任何识别结果

期

发表于 08-13 06:45

基于米尔瑞芯微RK3576开发板部署运行TinyMaix:超轻量级推理框架

本文将介绍基于米尔电子MYD-LR3576开发平台部署超轻量级推理框架方案:TinyMaix

摘自优秀创作者-短笛君

TinyMaix 是面向单片机的超轻量级的神经网络推理库,即 TinyML

发表于 07-25 16:35

如何在魔搭社区使用TensorRT-LLM加速优化Qwen3系列模型推理部署

TensorRT-LLM 作为 NVIDIA 专为 LLM 推理部署加速优化的开源库,可帮助开发者快速利用最新 LLM 完成应用原型验证与产品部署。

大模型推理显存和计算量估计方法研究

随着人工智能技术的飞速发展,深度学习大模型在各个领域得到了广泛应用。然而,大模型的推理过程对显存和计算资源的需求较高,给实际应用带来了挑战。为了解决这一问题,本文将探讨大模型

发表于 07-03 19:43

基于LockAI视觉识别模块:C++目标检测

快速部署高性能的目标检测应用。

特点:

高性能:优化了推理速度,在保持高精度的同时实现了快速响应。

灵活性:支持多种预训练模型,可以根据具体

发表于 06-06 14:43

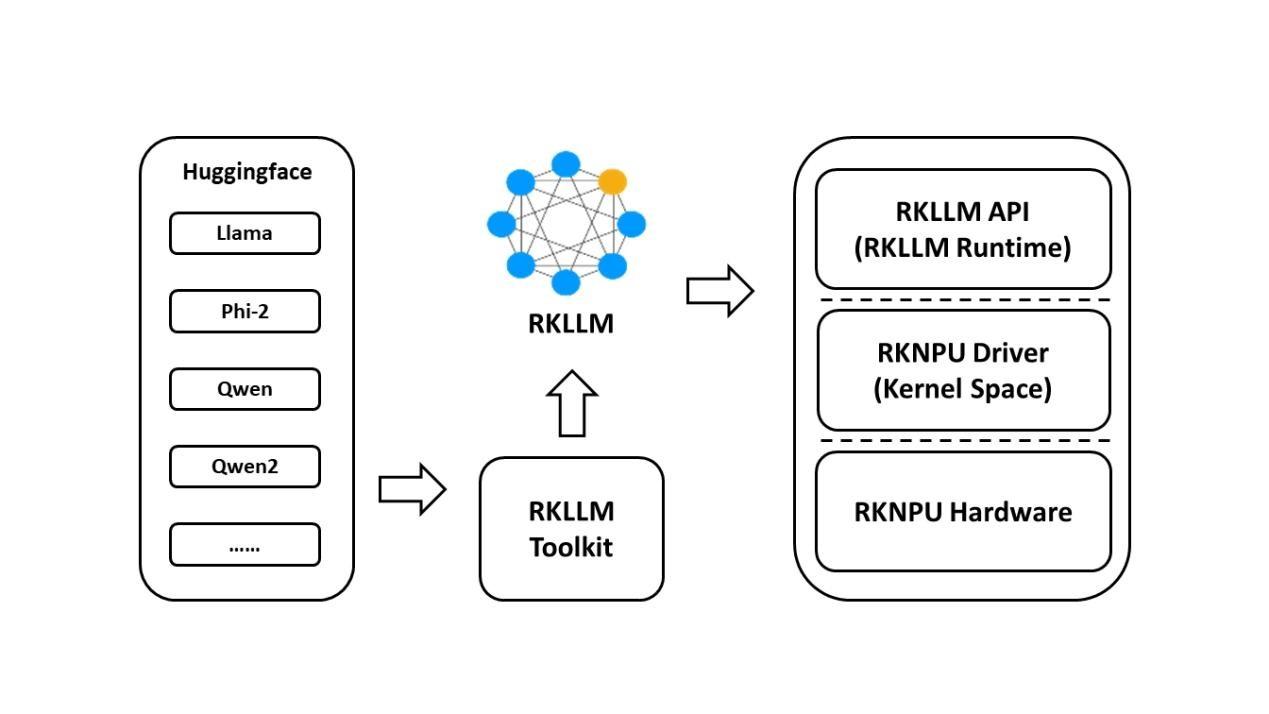

基于RK3576开发板的RKLLM大模型部署教程

Runtime则负责加载转换后的模型,并在Rockchip NPU上进行推理,用户可以通过自定义回调函数实时获取推理结果。

开发流程分为模型转换和板端

labview调用yolo目标检测、分割、分类、obb

labview调用yolo目标检测、分割、分类、obb、pose深度学习,支持CPU和GPU推理,32/64位labview均可使用。

(yolov5~yolov12)

发表于 03-31 16:28

【幸狐Omni3576边缘计算套件试用体验】RKNN 推理测试与图像识别

本节介绍了 RKNN 推理测试的相关流程,包括 rknn_model_zoo 模型部署、编译及板端测试。

rknn_model_zoo

rknn_model_zoo 是瑞芯微官方提供的 RKNPU 支持

发表于 03-20 16:14

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略

这也会带来新问题,随着模型参数增加,回复速度会明显下降,实际应用中需根据需求权衡。使用 Ollama 工具部署的推理模型运行时主要依赖 CPU 运算。从运行监测数据能看到,模型回复时

发表于 02-14 17:42

摩尔线程宣布成功部署DeepSeek蒸馏模型推理服务

近日,摩尔线程智能科技(北京)有限责任公司在其官方渠道发布了一则重要消息,宣布公司已经成功实现了对DeepSeek蒸馏模型推理服务的部署。这一技术突破,标志着摩尔线程在人工智能领域迈出了坚实的一步

采用华为云 Flexus 云服务器 X 实例部署 YOLOv3 算法完成目标检测

一、前言 1.1 开发需求 这篇文章讲解: 采用华为云最新推出的 Flexus 云服务器 X 实例部署 YOLOv3 算法,完成图像分析、目标检测。 随着计算机视觉技术的飞速发展,深度学习模型

AI模型部署边缘设备的奇妙之旅:目标检测模型

以及边缘计算能力的增强,越来越多的目标检测应用开始直接在靠近数据源的边缘设备上运行。这不仅减少了数据传输延迟,保护了用户隐私,同时也减轻了云端服务器的压力。然而,在边缘端部署高效且准确的目标

发表于 12-19 14:33

YOLOX目标检测模型的推理部署

YOLOX目标检测模型的推理部署

评论