本教程的目标:

了解什么是音高 (Pitch) 以及历史上机器学习如何检测歌曲中的音高

对歌曲数据以及执行模型的结果进行可视化

编写通过手机麦克风收集声音的代码

在 Android 应用程序内部部署 ML 模型

对歌曲的数据进行转换并使用 SPICE 模型进行推断

在 Android 手机屏幕上呈现最终结果

介绍

音高是声音的一种感知属性,可以按相应的频率对其进行排序。换句话说,音高在音乐旋律中是用来判断声音听起来“高”和“低”的一种属性。音高是音调的主要听觉属性之一,其余为音长 (Duration),音强 (Loudness),以及音色 (Timbre)。音高通过频率进行量化,并以赫兹 (Hz) 为单位进行测量,其中 1Hz 表示每秒一个周期。

音高检测 (Pitch detection) 一个有趣的挑战。历史上,对音高和音高感知的研究一直是心理声学的核心问题,并且在音频表征的形成与测试理论、 信号处理算法 (Signal-Processing Algorithms) 以及听觉系统中的感知等方面起到重要作用。研究人员为此开发并应用了许多技术 ,还努力将相近频率的背景噪声与背景音乐进行分离。

技术

https://www.cs.uregina.ca/Research/Techreports/2003-06.pdf

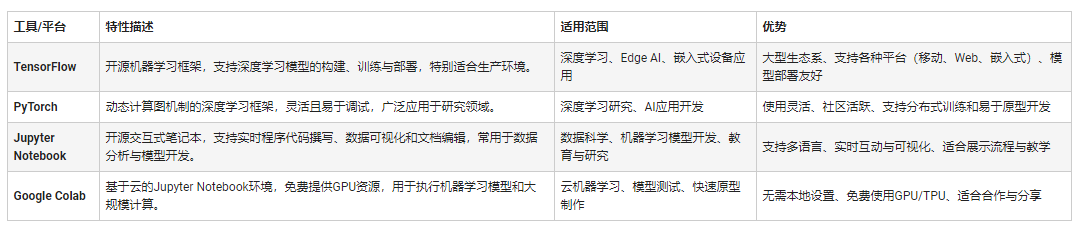

今天,我们可以通过机器学习来实现这一目标,更具体地说,可以使用 SPICE 模型。这是一个经过预训练的模型,可以识别混合录制的音频中的基本音高(包括噪音和背景音乐),您可以在 TensorFlow Hub 获取 SPICE 模型,包括适用于 Web 端的 TensorFlow.js 以及适用于移动端的 TensorFlow Lite。

TensorFlow Hub

https://tfhub.dev/

TensorFlow.js

https://tfhub.dev/google/tfjs-model/spice/1/default/1

TensorFlow Lite

https://tfhub.dev/google/lite-model/spice/1

开始

音频以单声道 16khz 采样率记录并保存为 .wav 格式。让我们用一个具有该格式的简单音频文件为例。如果使用对数频率坐标图(以使歌声更清晰可见),加载它并可视化输出,我们将获得一个频谱图,该频谱图显示随时间变化的频率:

音频文件

https://storage.googleapis.com/download.tensorflow.org/data/c-scale-metronome.wav

在执行带有歌曲数据的模型后,我们将打印模型的输出。蓝色表示模型预测的音高值,橙色表示这些音高值的置信度:

如果仅保留置信度大于 90% 的结果,并将其与灰度图重叠,我们将获得下图:

在所有长度的歌曲上准确性都很高!!

需要指出的是,虽然对于上述示例,基于频谱图的启发式音高提取方法可能也起作用。但是通常情况下,基于机器学习的模型会优于手工提取的信号处理方法,特别是当音频中存在背景噪声和背景音乐时。关于 SPICE 与 SWIPE(基于频谱图的算法)的比较,请参见此文。

若在 Android 应用程序内部运行 SPICE 模型,必须使用麦克风收集声音。首先,我们设置变量:

private val AUDIO_SOURCE = MediaRecorder.AudioSource.VOICE_RECOGNITION private val SAMPLE_RATE = 16000 private val CHANNEL_MASK = AudioFormat.CHANNEL_IN_MONO private val ENCODING = AudioFormat.ENCODING_PCM_16BIT private val BUFFER_SIZE = AudioRecord.getMinBufferSize(SAMPLE_RATE, CHANNEL_MASK, ENCODING) private val AUDIO_FORMAT = AudioFormat.Builder().setEncoding(ENCODING) .setSampleRate(SAMPLE_RATE) .setChannelMask(CHANNEL_MASK) .build()

然后,选择 MediaRecorder.AudioSource.VOICE_RECOGNITION 以将麦克风声源导入至语音识别并应用噪声消除。音频格式是 16位,单声道,16KHz 采样率的理想格式。最后,我们开始录音进程:

/** * Start the recording process. */ mRecorder = AudioRecord.Builder().setAudioSource(AUDIO_SOURCE) .setAudioFormat(AUDIO_FORMAT) .setBufferSizeInBytes(BUFFER_SIZE) .build() mRecorder?.startRecording()

停止录音进程 mRecorder.stopRecording() ,随后我们从录音机流中读取音频:

private val readAudio = Runnable { var readBytes: Int buffer = ShortArray(BUFFER_SIZE) while (mRecording) { readBytes = mRecorder!!.read(buffer, 0, BUFFER_SIZE) //Higher volume of microphone //https://stackoverflow.com/questions/25441166/how-to-adjust-microphone-sensitivity-while-recording-audio-in-android if (readBytes > 0) { for (i in 0 until readBytes) { buffer[i] = Math.min( (buffer[i] * 6.7).toInt(), Short.MAX_VALUE.toInt() ).toShort() } } if (readBytes != AudioRecord.ERROR_INVALID_OPERATION) { for (s in buffer) { // Add all values to arraylist bufferForInference.add(s) writeShort(mPcmStream, s) } } } }

注意此处的乘法 buffer[i] * 6.7。这个参数用于控制麦克风增益并提高灵敏度(您可以使用其他值代替 6.7 来满足需要)!

在此类内,还有一个将字节数组转换为.wav文件的函数。该文件存储在手机内部存储器的Pitch Detector文件夹中,可用于与原始版本对比验证移动端模型输出的准确性。

原始版本

https://colab.sandbox.google.com/github/tensorflow/hub/blob/master/examples/colab/spice.ipynb

部署 SPICE 模型的第一步是复制位于 Assets 文件夹中的 .tflite 文件。我们将这些依赖包含在 app build.gradle 文件中:

implementation 'org.tensorflow0.0.0-nightly' implementation 'org.tensorflow0.0.0-nightly' implementation 'org.tensorflow0.0.0-nightly'

.tflite 文件

https://tfhub.dev/google/lite-model/spice/1

最后一个依赖项含有额外的算子——这是该项目不可或缺的依赖项,但会显著增大最终 .apk 文件的体积,因为该模型使用了一些在第一个 tflite 依赖项中没有的算子。如需进一步了解,您可以阅读此文。

此文

https://tensorflow.google.cn/lite/guide/ops_select#android_aar

初始化解释器,从文件夹加载模型文件:

// load tflite file from assets folder @Throws(IOException::class) private fun loadModelFile(context: Context, modelFile: String): MappedByteBuffer { val fileDescriptor = context.assets.openFd(modelFile) val inputStream = FileInputStream(fileDescriptor.fileDescriptor) val fileChannel = inputStream.channel val startOffset = fileDescriptor.startOffset val declaredLength = fileDescriptor.declaredLength val retFile = fileChannel.map(FileChannel.MapMode.READ_ONLY, startOffset, declaredLength) fileDescriptor.close() return retFile } @Throws(IOException::class) private fun getInterpreter( context: Context, modelName: String, useGpu: Boolean ): Interpreter { val tfliteOptions = Interpreter.Options() if (useGpu) { gpuDelegate = GpuDelegate() tfliteOptions.addDelegate(gpuDelegate) } tfliteOptions.setNumThreads(numberThreads) return Interpreter(loadModelFile(context, modelName), tfliteOptions) }

我们准备好了,使用音频流进行推理!

音频流采用 ArrayList

fun execute(floatsInput: FloatArray): ArrayList

当我们获得结果后,我们接下来要做的是:

筛选输出置信度超过 90% 的结果

将绝对音高转换为赫兹 (Hz)

计算唱歌期间的偏移量

使用一些启发式算法尝试预测并输出最可能的演唱乐谱。

上述步骤中,计算出理想的偏移量是重要的一步,因为通常人们哼唱的旋律与可以记谱的绝对音高值之间存在偏移。为此,我们还需要知道歌曲的速度(这样才能确定采用的音符长度,比如八分音符)以及开始量化产生音符的时间偏移量。为简单起见,我们将尝试使用不同的速度和时间偏移并测量量化误差,最后采用该误差最小的组合。您可以在 PitchModelExecutor.kt 的源代码中继续深入了解。

PitchModelExecutor.kt 的源代码

https://github.com/farmaker47/Pitch_Estimator/blob/master/app/src/main/java/com/george/pitch_estimator/PitchModelExecutor.kt

通过上述过程,我们获得了含有音符字符串的 ArrayList,例如 [A2,F2,G#2,C3],这些结果显示在屏幕上。

TensorFlow Hub 的 SPICE 模型示例页面有一个出色的可视化工具,可以在静态的五线谱上显示不断流入的音符。因此,是时候在我们的移动应用程序去中复制此实时效果了!

可视化工具

https://tfhub.dev/google/lite-model/spice/1

Android webview 用于处理一些自定义 html 代码。我们将此代码加载到绑定适配器中:

// this binding adapter helps load custom html from assets folder @BindingAdapter("htmlToScreen") fun bindTextViewHtml(webView: WebView, htmlValue: String) { webView.settings.javaScriptEnabled = true webView.loadDataWithBaseURL("fake://not/needed", htmlValue, "text/html", "UTF-8", "") }

您可以在 这个 GitHub Gist 找到提供给 Webview 的 html 源代码!

GitHub Gist

https://gist.github.com/farmaker47/8e3b6a5af795f32459d35d2198f07d1c

当屏幕上显示如 [A2,F2] 这样的文字音符时,我们执行:

// Observe notes as they come out of model and update webview respectively viewModel.noteValuesToDisplay.observe(viewLifecycleOwner, androidx.lifecycle.Observer { list -> if (list.size > 0) { var i = 0 val handler = Handler() handler.post(object : Runnable { override fun run() { when (list[i]) { "C2" -> binding.webView.loadUrl("javascript:myMove('125')") "C#2" -> binding.webView.loadUrl("javascript:myMoveSharp('125')") "D2" -> binding.webView.loadUrl("javascript:myMove('130')") "D#2" -> binding.webView.loadUrl("javascript:myMoveSharp('130')") "E2" -> binding.webView.loadUrl("javascript:myMove('135')") "F2" -> binding.webView.loadUrl("javascript:myMove('140')") "F#2" -> binding.webView.loadUrl("javascript:myMoveSharp('140')") "G2" -> binding.webView.loadUrl("javascript:myMove('145')") "G#2" -> binding.webView.loadUrl("javascript:myMoveSharp('145')") "A2" -> binding.webView.loadUrl("javascript:myMove('150')") "A#2" -> binding.webView.loadUrl("javascript:myMoveSharp('150')") "B2" -> binding.webView.loadUrl("javascript:myMove('155')") ........................... } i++ if (i < list.size) { handler.postDelayed(this, 555L) } } }) } })

在这里,我们每两秒钟观察一次音符变化,对于列表中的每个音符,我们执行 javascript 函数。myMove 函数内部的值是注释的垂直偏移量。

此项目的 GitHub 地址(https//github.com/farmaker47/Pitch_Estimator)。

此项目使用 Kotlin 语言,并且包括:

使用 Webview 和自定义 HTML 加载。

使用 TensorFlow 的 .tflite 模型文件:

数据绑定

MVVM 模式下的协程

Koin DI

改进计划

在应用程序的 build.gradle 文件中,我们添加了特殊算子的依赖项:

implementation ‘org.tensorflow0.0.0-nightly’

此依赖项导致最终的 .apk 文件体积膨胀。我们计划通过仅选择模型所需的算子,以此减少最终 .apk 的大小。

通过改进算法,我们将能够查看全音符,二分音符,休止符和其他音符。

责任编辑:lq

-

音频

+关注

关注

31文章

3137浏览量

84977 -

机器学习

+关注

关注

66文章

8541浏览量

136271 -

tensorflow

+关注

关注

13文章

332浏览量

61869

原文标题:学习教程 | 用 TensorFlow Lite 和 SPICE 模型打造听歌识谱 App

文章出处:【微信号:tensorflowers,微信公众号:Tensorflowers】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

Linux历史上10件最有意义的大事,你知道几件?

机器视觉检测PIN针

创造历史,芯和半导体成为首家获得工博会CIIF大奖的国产EDA

博世80亿美元收购美国江森自控(Johnson Controls)暖通空调(HVAC)业务!博世历史上最大收购

机器学习异常检测实战:用Isolation Forest快速构建无标签异常检测系统

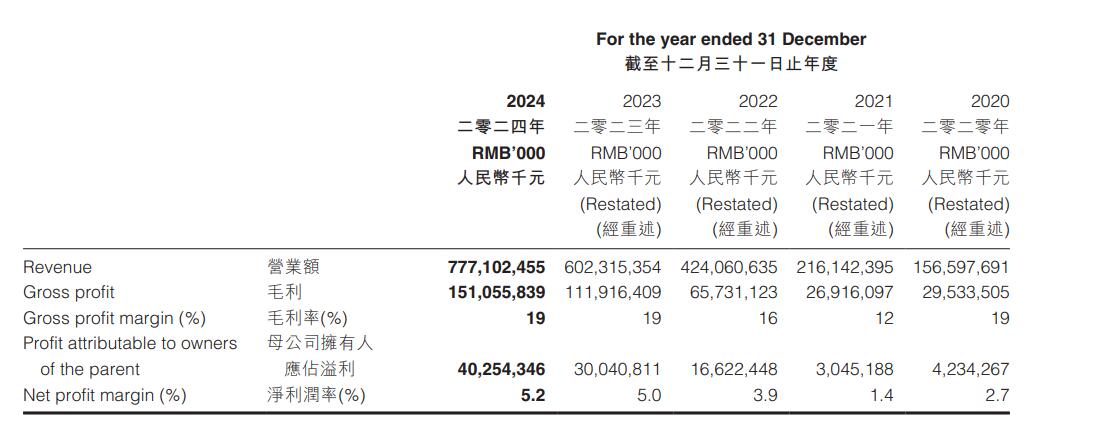

日赚1.1亿,营收超特斯拉!比亚迪史上最强财报两大看点

机器学习模型市场前景如何

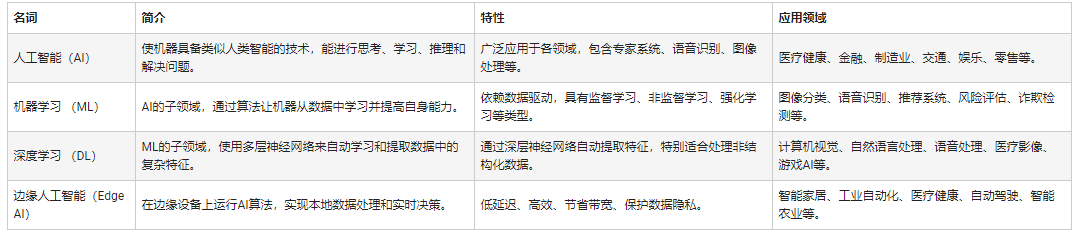

人工智能和机器学习以及Edge AI的概念与应用

了解什么是音高以及历史上机器学习如何检测歌曲中的音高

了解什么是音高以及历史上机器学习如何检测歌曲中的音高

评论