今天上午据软件绿色联盟消息,阿里MNN已经接入华为 HiAI生态,正式支持华为NPU。

据了解,阿里MNN为Mobile Neural Network,是阿里巴巴淘系技术部开源的端侧推理引擎,目前已覆盖淘宝、天猫、优酷和UC等20多个手机应用,每天稳定运行超过500亿次,已经接受了两届“双11”的考验。

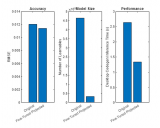

官方表示,当App功能日益强大时,性能和精度的矛盾就逾显尖锐;官方表示利用HiAI Foundation芯片能力开放,阿里MNN快速转化和迁移已有模型,并借助异构调度和NPU加速,大幅提升应用算力和能效比,可以优化MNN的性能和精度问题。比如会加快以图搜图的搜索速度,耗电方面也会降低;此外,扫商家Logo也是运用了此功能。

责任编辑:gt

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

华为

+关注

关注

217文章

35783浏览量

260717 -

阿里

+关注

关注

6文章

462浏览量

34026

发布评论请先 登录

相关推荐

热点推荐

如何利用NPU与模型压缩技术优化边缘AI

随着人工智能模型从设计阶段走向实际部署,工程师面临着双重挑战:在计算能力和内存受限的嵌入式设备上实现实时性能。神经处理单元(NPU)作为强大的硬件解决方案,擅长处理 AI 模型密集的计算需求。然而

基于米尔瑞芯微RK3576开发板的Qwen2-VL-3B模型NPU多模态部署评测

RKLLM-Toolkit),支持 Hugging Face 格式模型的量化(如 w4a16、w8a8)和优化,适配 RK3588、RK3576 等高性能 NPU 芯片,通过降低模型

发表于 08-29 18:08

无法在NPU上推理OpenVINO™优化的 TinyLlama 模型怎么解决?

在 NPU 上推断 OpenVINO™优化的 TinyLlama 模型。

遇到的错误:

get_shape was called on a descriptor::Tensor with dynamic shape

发表于 07-11 06:58

芯原超低能耗NPU可为移动端大语言模型推理提供超40 TOPS算力

AI需求而设计,不仅能够为AI PC等终端设备提供强劲算力支持,而且能够应对智慧手机等移动终端对低能耗更为严苛的挑战。 芯原的超低能耗NPU IP具备高度可配置、可扩展的架构,支持混合精度

HarmonyOS优化应用内存占用问题性能优化一

应用开发过程中注重内存管理,积极采取措施来减少内存占用,以优化应用程序的性能和用户体验。

HarmonyOS提供了一些内存管理的工具和接口,帮助开发者有效地管理内存资源:

onMemoryLevel接口

发表于 05-21 11:27

Arm CPU适配通义千问Qwen3系列模型

与阿里巴巴开源的轻量级深度学习框架 MNN 已深度集成。得益于此,Qwen3-0.6B、Qwen3-1.7B 及 Qwen3-4B 三款模型能够在搭载 Arm 架构 CPU 的移动设备上无缝运行,为用户提供卓越的端侧 AI 推理能力。

超越CPU/GPU:NPU如何让AI“轻装上阵”?

和计算速度上更具优势,尤其适合移动设备、边缘计算和嵌入式AI场景。 NPU有几大核心特点:其一是专用架构,针对神经网络计算优化,支持并行处理大量矩阵运算(如INT8/FP16低精度

Arm与阿里巴巴合作加速端侧多模态AI体验

Arm 控股有限公司(纳斯达克股票代码:ARM,以下简称“Arm”)近日发布与阿里巴巴淘天集团轻量级深度学习框架 MNN 的又一新合作。

安谋科技“周易”NPU成功部署DeepSeek-R1

近日,安谋科技宣布其最新一代“周易”NPU处理器硬件平台已成功运行DeepSeek-R1系列模型,实现了软硬件协同优化的卓越性能与成本效益。这一突破性进展为用户带来了更加高效、便捷的AI

MPLS网络性能优化技巧

MPLS(多协议标签交换)网络性能优化是一个复杂的过程,涉及多个方面的技术和策略。以下是一些关键的MPLS网络性能优化技巧: 一、确保网络设备支持

软硬协同优化,安谋科技新一代“周易”NPU实现DeepSeek-R1端侧高效部署

优化的架构设计,其beta版本在2024年底已面向早期用户开放评估测试,并获得了广泛认可与积极反馈。 预计今年上半年,这款备受期待的 NPU 产品将正式亮相市场,届时将为更多用户带来突破性的端侧算力体验。 DeepSeek自发布以来,凭借其出色的

发表于 02-14 10:52

•297次阅读

阿里MNN支持华为NPU,优化MNN的性能和精度问题

阿里MNN支持华为NPU,优化MNN的性能和精度问题

评论