Groq LPU 如何让万亿参数模型「飞」起来?揭秘 Kimi K2 40 倍提速背后的黑科技

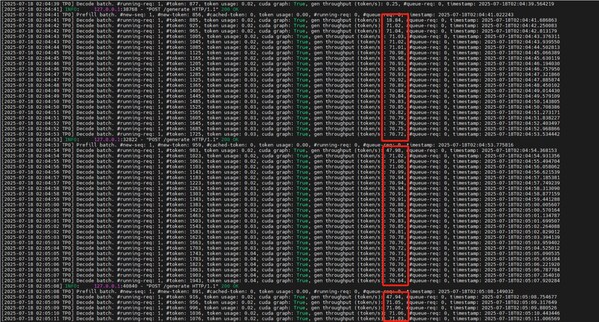

最近,Moonshot AI 的千亿参数大模型 Kimi K2 在 GroqCloud 上开放预览,引发了开发者社区的疯狂讨论——为什么 Groq 能跑得这么快?

传统 AI 推理硬件(如 GPU)往往面临一个两难选择:

✅ 快(但牺牲精度)

⛔ 准(但延迟高到无法接受)

而 Groq 的 LPU(Language Processing Unit) 却打破了这一魔咒,既快又准。

1. 精度与速度的「鱼与熊掌」:如何兼得?

传统硬件的「量化陷阱」

大多数 AI 加速器(如 GPU)为了提升推理速度,会采用 INT8/FP8 等低精度计算,但这会导致累积误差,模型质量大幅下降。

Groq 的「TruePoint Numerics」黑科技

Groq 的解决方案是 动态精度调整:

权重/激活函数:用低精度存储(节省内存)

矩阵运算:全精度计算(保证结果无损)

输出阶段:根据下游需求智能选择量化策略

这样一来,速度比 BF16 快 2-4 倍,但精度无损(MMLU/HumanEval 等基准测试验证)。

传统 AI 芯片(如 GPU)依赖 HBM/DRAM 作为主存,每次权重访问延迟高达数百纳秒,严重影响推理速度。

而 Groq 直接集成数百兆片上 SRAM,让权重加载零延迟,计算单元全速运转。

审核编辑 黄宇

-

AI

+关注

关注

89文章

38160浏览量

296831 -

大模型

+关注

关注

2文章

3447浏览量

4974

发布评论请先 登录

开源大模型算力革命下:电子谷连接技术的坚守与未来

Dynamo 0.4在NVIDIA Blackwell上通过PD分离将性能提升4倍

浪潮信息发布"元脑SD200"超节点,面向万亿参数大模型创新设计

奇异摩尔邀您相约2025 AI网络技术应用创新大会

硅基流动携手沐曦首发基于曦云的Kimi K2推理服务

API让电商“飞”起来,告别手动操作

Groq LPU 如何让万亿参数模型「飞」起来?揭秘 Kimi K2 40 倍提速背后的黑科技

Groq LPU 如何让万亿参数模型「飞」起来?揭秘 Kimi K2 40 倍提速背后的黑科技

评论