随着AI大模型训练与推理需求的爆发式增长,高功率密度服务器的热管理正面临前所未有的挑战。当GPU集群功率突破20kW/柜时,传统风冷系统的散热效率已逼近物理极限,液冷技术凭借其单位体积散热能力提升百倍以上的优势,正成为AI算力基础设施的核心支撑。

在液冷系统实际应用中,流量控制精度直接影响着散热效能与系统安全。当前行业面临三大技术痛点:

1、动态流量匹配失衡

在服务器负载剧烈波动场景下,固定流量模式易导致局部热点形成,GPU核心温度骤升可能引发运算降频甚至硬件损伤。

2、能耗效率瓶颈

为应对峰值散热需求过量配置流量,不仅造成30%以上的泵机功耗浪费,更可能因系统压力激增导致管路泄漏风险。

3、多物理场耦合干扰

冷却液粘度随温度变化产生的流量测量漂移,以及高频振动引发的传感器信号失真,严重影响流量监测的长期稳定性。

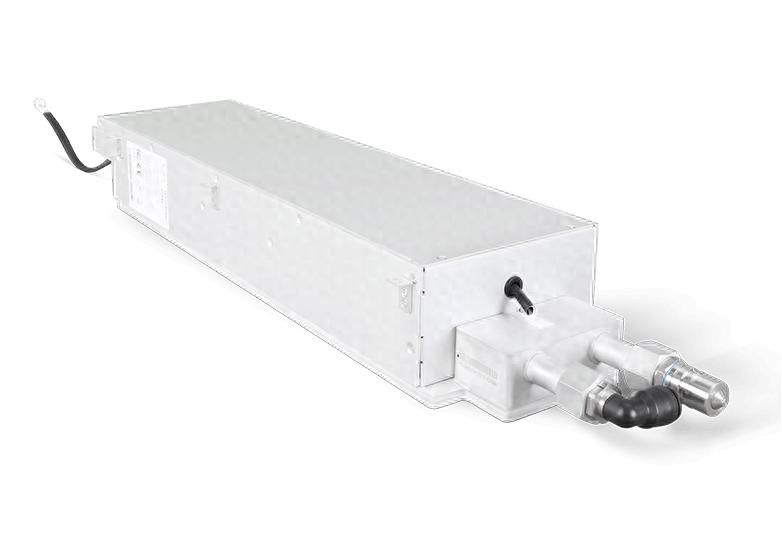

奥迪威为此特别推出AI服务器液冷散热专用系列流量传感器。专为AI液冷系统研发的系列流量传感器,采用超声波与涡街双技术架构,构建从芯片级散热到机柜级热管理的全链路流量监测体系。通过+3%的测量精度与毫秒级响应速度,实现散热系统能耗与效能的动态平衡。

涡街流量传感器适用于大流量、高流速及高粘度冷冷却液场景的涡街传感器,基于卡门涡街效应原理,通过精准检测流体通过旋涡发生体时产生的涡街频率,结合流体动力学模型与信号处理技术,实现稳定、实时的流量测量。产品可动态调节冷却液流量,保障高负载运算下硬件的持续高效散热。

超声波流量传感器基于超声波时差法原理,通过精确测量超声波在冷却液中顺流与逆流传播的时间差,结合数字信号处理与流量算法,实现无干扰、高精度的液体流量监测,可无缝集成于 AI服务器液冷散热系统,实时管控冷却液流量,确保 GPU/CPU等核心部件在超频运算下的高效散热。

双模态协同应用场景

瞬态热冲击防护

在GPU集群启动瞬间,超声波传感器即时捕捉流量脉冲信号,联动变频泵完成流量补偿,将芯片温度波动控制在安全区间。

能效优化闭环

涡街传感器持续监测主管道流量基线,结合服务器负载曲线生成动态流量图谱,实现散热系统综合能效提升。

冗余安全保障

通过双传感器交叉验证机制可识别异常流量事件,在检测到微泄漏或气泡积聚时,自动切换备用循环回路并触发预警。

随着液冷渗透率向80%迈进,流量感知技术正成为智能热管理的核心中枢。奥迪威的智能流量监测解决方案将持续推动散热系统向“感知-决策-执行”一体化方向演进,为A算力的可持续增长构建可靠基石。

-

服务器

+关注

关注

13文章

10100浏览量

90912 -

散热

+关注

关注

3文章

574浏览量

33066 -

AI

+关注

关注

90文章

38207浏览量

297064

发布评论请先 登录

英特尔携本地生态伙伴发布双路冷板式全域液冷服务器,引领数据中心散热与能效革新

对话|AI服务器电源对磁性元件提出的新需求

数据中心液冷服务器该配什么样的 UPS 不间断电源?

新品 | 破局散热困境!捷智算5090 浸没式液冷服务器全新来袭!

AI 服务器电源如何迭代升级?

曙光数创推出液冷数据中心全生命周期定制新服务

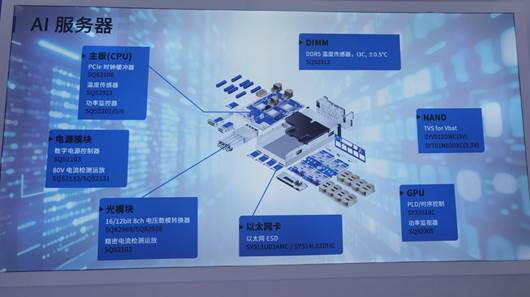

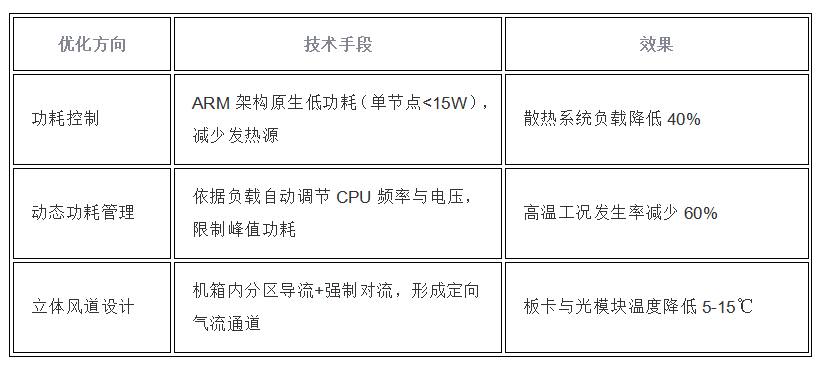

AI服务器硬件攻坚战,从时钟缓冲到电容,解决功耗、带宽、散热难题

AI 推理服务器都有什么?2025年服务器品牌排行TOP10与选购技巧

如何在RAKsmart服务器上实现企业AI模型部署

首个液冷整机柜服务器行业标准发布,兰洋科技核心参编!

AI服务器液冷散热如何实现动态平衡?

AI服务器液冷散热如何实现动态平衡?

评论