最近,开源中国 OSCHINA、Gitee 与 Gitee AI 联合发布了《2024 中国开源开发者报告》。

报告聚焦 AI 大模型领域,对过去一年的技术演进动态、技术趋势、以及开源开发者生态数据进行多方位的总结和梳理。

在第二章《TOP 101-2024 大模型观点》中,苏州盛派网络科技有限公司创始人兼首席架构师苏震巍分析了大模型训练过程中开源数据集和算法的重要性和影响,分析其在促进 AI 研究和应用中的机遇,并警示相关的风险与挑战。

全文如下:

大模型训练中的开源数据和算法:机遇及挑战

随着人工智能(AI)技术的迅猛发展,尤其是大模型(如 GPT、OpenAI o1、Llama 等)的崛起,开源数据和算法在大模型训练中的重要性愈发显著。开源数据集和算法不仅推动了 AI 研究的进步,也在应用层面带来了深远的影响。然而,伴随这些机遇的还有诸多风险与挑战,如数据质量、版权问题和算法透明性等。本文将浅析大模型训练过程中开源数据集和算法的重要性和影响,分析其在促进 AI 研究和应用中的机遇,并警示相关的风险与挑战。

任何方案都具有两面性和在特殊环境下的讨论的意义和前提,因此,本文不讨论开源或对立面(闭源)的绝对取舍问题,仅对开源的有利之处加以浅析。

重要的开源数据集和算法在大模型训练中的角色

开源数据集是大模型训练的基石。没有高质量的数据,大模型的性能和应用场景将受到极大限制。ImageNet、COCO、Wikipedia 和 Common Crawl 是非常重要一批高质量的开源数据集。以下是这几个数据集在大模型训练历程中的重要角色。

ImageNet:ImageNet 是计算机视觉领域最著名的开源数据集之一,包含数百万张带有标签的图像。它为图像分类、物体检测等任务提供了丰富的数据资源,使得模型能够在视觉理解方面取得突破。它由普林斯顿大学的计算机科学家李飞飞(Fei-Fei Li)及其团队在 2009 年创建。ImageNet 包含超过 1400 万张图像,这些图像分为超过 2 万个类别,每个类别都与 WordNet 中的一个词条对应。每个类别的图像数量从数百到数千不等。ImageNet 每年都会举办一个大型的视觉识别竞赛,即 ImageNet Large Scale Visual Recognition Challenge (ILSVRC)。该竞赛吸引了全球众多研究团队参与,并在推动深度学习和卷积神经网络(CNN)技术的发展中发挥了重要作用。今年的诺贝尔物理学奖得主之一 Geoffrey Hinton 带领的团队成员 AlexNet 在 2012 年的 ILSVRC 中取得了显著的成功,使得深度学习在计算机视觉领域迅速崛起。也为如今我们看到的种类繁多的视觉大模型(VLMs)开启了新的篇章。

COCO(Common Objects in Context):COCO 数据集由微软于 2014 年发布,涵盖了数十万张日常生活中的图像,并附有详细的标注信息。虽然 COCO 对比 ImageNet 具有更少的类别,但每一个类别拥有更多的实例,假定这能帮助复杂模型提高物体定位的准确率。它的设计初衷适用于具有上下文信息的图片中的物体检测和分割,目前在目标检测、分割等任务中发挥了重要作用,推动了计算机视觉技术的进步。

Wikipedia 和 Common Crawl:Wikipedia 是一个由全球用户共同编辑和维护的高质量在线百科全书,以文字为主,知识高度结构化,Common Crawl 是一个非营利组织,定期抓取互联网公开网页,生成大量的网页数据集,可提供大量的互联网用户知识及非结构化数据。他们的共同点是为模型训练提供了充沛的文字素材。这些大型文本数据集为自然语言处理(NLP)模型的训练提供了丰富的语料库。像 GPT 这样的语言模型正是通过大规模爬取和处理这些数据集,才能在文本生成和理解方面表现出色。

开源算法的角色

开源算法是 AI 研究和应用的核心驱动力。开源算法的共享和复用使得研究者和开发者能够在前人工作的基础上迅速迭代和创新。以下是一些在这一轮 AI 大模型浪潮中扮演重要角色的的开源算法及其在大模型训练中的角色:

TensorFlow 和 PyTorch:这两个深度学习框架是当前最流行的开源工具,提供了强大的计算能力和灵活的模型构建方式。它们为大模型的训练和部署提供了基础设施支持,使得复杂的 AI 模型得以实现。

Transformer 架构:Transformer 架构是一种用于处理序列数据的开源算法,广泛应用于 NLP 任务,也是作为这一轮 AI 浪潮推动者 GPT 模型的基础算法。基于 Transformer 的模型,如 BERT 和 GPT,已经成为自然语言理解和生成的事实标准。

GAN(生成对抗网络):GAN 是一种用于生成数据的开源算法,广泛应用于图像生成、数据增强等领域。它通过生成器和判别器的对抗训练,能够生成高质量的图像和其他数据。

除此以外,如果把 Pre-Train 之后的微调(Fine-Tuning)等环节也看做广义 “训练” 的一部分,还有一系列开源方法及配套的工具,例如比较常见的 LoRA(Low-Rank Adaptation of Large Language Models)。

机遇

从上述开源数据和算法在模型训练过程中所扮演的角色可以看到,大模型训练中的开源数据和算法为 AI 研究和应用带来了诸多机遇,在加速创新、促进合作、资源共享等方便提供了广泛而可靠的基础条件和资源,围绕这些资源,技术人员得以进行更加开放的交流和合作,并展开更加深入的教育和培训,以此不断提升整个行业人才的技术水平。

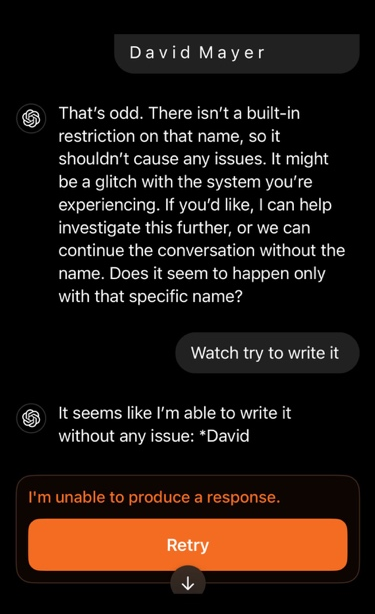

由于目前主流的模型训练算法都需要依靠对训练数据(样本)的统计(概率),因此,开放的数据和算法能够在更大程度上确保样本的质量,从而避免更多未知的风险。例如就在 2024 年 12 月 1 日,用户发现 ChatGPT 在需要输出 “David Mayer” 这个名字的时候会突然提示拒绝:

此事件一度被解读为 GPT 模型在训练过程中被植入了特定的样本或算法,以避免讨论特定的人名。虽然后续的一系列测试表明,这种限制似乎只存在于 ChatGPT 产品中,通过 OpenAI 对外提供的模型接口并不会触发这样的屏蔽机制。

OpenAI 在随后周二(12 月 3 日)立即确认 “David Mayer” 这个名字已经被内部隐私工具标记,其在一份声明中说:“可能有些情况下,ChatGPT 不提供关于人们的某些信息,以保护他们的隐私。” 公司不会提供有关工具或流程的更多细节。

无论真实的原因是什么,这个事件是一个反例,其显示了封闭的系统以及中心化的模型提供者所具备的风险,也说明了不透明的处理环节对模型的输出结果带来更多的不确定性。类似的拒绝服务也是在模型服务过程中表现出来的另外一种偏见(Bias)行为,而偏见也是目前所有模型都在极力避免的情形,要进一步解决这个问题,使用更加开放的数据集和算法是一种更负责任的做法。

种种事件的发生并不是坏事,这是所有技术在发展过程中接受实践检验的必经之路,通过种种尝试和反馈,目前对于开源数据集和算法的呼声正在越来越高涨。

除了对于训练集和算法的开源之外,对于模型的 “开源” 定义也经受着各种议论。笔者比较认同的观点是:开源模型不应该只把模型文件公布出来,同时应该把对应的训练集和算法进行公开,并能够提供相应的训练流程,是所有人能够对结果进行重现。这好比我们讨论开源项目的时候,通常不会指我们只能够下载某个应用程序,而是我们能够查看源码,甚至通过修改源码编译出自己想要的应用程序。

在今年 10 月 29 日,开放源代码促进会(Open Source Initiative,OSI)发布了关于 “开源 AI 定义(OSAID)”1.0 版本,其规定了 AI 大模型若要被视为开源必须具备三个三个:训练数据透明性、完整代码、模型参数。虽然对比目前市面上的 “开源模型”,少有能力较高的模型能完全符合,但这种声明本身就是一种开源开放态度的彰显。

我相信,在更加透明的数据集和算法的支持下,模型将在可控性上获得更好的发展机遇,相关的技术社区也将迎来更大的发展。

挑战

当然,大模型训练中的开源数据和算法也伴随着一定的风险和挑战,这些风险需要在模型开发和应用的过程中被认真对待和解决。例如前文提到的 “偏见” 问题,以及数据质量问题,可能是最显著的风险。由于开源数据集质量参差不齐,虽然一些广泛使用的数据集如开头介绍的 ImageNet 和 COCO 被认为是高质量的数据集,但其他开源数据集可能包含噪声、错误标签和不完整的信息。这种数据质量问题会直接影响模型的训练效果,导致模型性能的下降,甚至可能产生错误的预测结果。

除此以外,在 GPT 爆火之后,由于相关法律和政策的滞后,已经有大量大模型生成的文字、图像、视频、音频内容被发布于互联网,当这些内容再次被作为开放数据被采集,并再次进行训练,可能会带来更大的数据质量问题。因此,笔者认为对 AI 生成的观点进行标注再发布是一种更加负责任的做法,当然,在实际操作过程中,要实现仍然有极大的难度。

开源数据集的版权问题也是一个需要重视的风险。尽管开源数据集通常是公开的,但其使用仍然受版权法的约束。未经授权使用受版权保护的数据,可能会导致法律纠纷。此外,某些数据集可能包含敏感信息,涉及个人隐私甚至危害公共安全。

在使用这些数据时,必须遵守相关的隐私保护法规,如欧盟的《通用数据保护条例》(GDPR)和美国的《健康保险可携性和责任法案》(HIPAA)。在实际操作过程中,出于成本、工艺、能力、时间的制约,数据集的筛选和正确使用仍然将会是一个持久的挑战。对于这个问题,闭源的数据集以及方法并不是不存在,只是更加隐蔽了。

也可能会有人担心,所有的数据集和算法开放后,模型是否会面临更多被操控的风险?笔者认为,这确实是一个很大的问题,例如模型可能会更容易被 “越狱”,从而被操控或输出原本不应输出的内容,这是一个需要尤其重点关注的风险点。

在应对策略方面,这场攻防战的 “蓝方” 同时也获得了更多的信息,可以再次加固相关能力,在这个过程中,模型得以进行更加充沛的发展,就如同当下的互联网一样。只有黑暗才能隐藏更多风险尤其中心化的控制风险,只有让核心数据和算法经受阳光的洗礼,并在所有人的监督下不断完善,才能让模型在更多场景中被更深入地使用(即便如此,训练完的模型本身对人类来说也仍然是一个 “黑盒”)。目前我们已经看到的大量开源的模型在各行各业中展现出强大的生命力和生产力,相关的开源社区也正在迎来新的繁荣期,长期来看,大模型将继续在各种风险、机遇、挑战、伦理等复杂环境中不断发展。

结论

开源数据和算法在大模型训练中的重要性不言而喻,它们为 AI 研究和应用带来了前所未有的机遇。然而,这些机遇也伴随着一定的风险和挑战,需要在模型开发和应用的过程中被认真对待和解决。通过采取适当的应对策略,我们可以在充分利用开源数据和算法的同时,尽量减少其潜在的风险,推动 AI 技术的健康发展。

相信在未来,随着技术的不断进步和相关政策的完善,开源数据和算法将在大模型训练中发挥更加重要的作用,为 AI 及大模型的研究和应用带来更多的创新和机遇。

-

算法

+关注

关注

23文章

4760浏览量

97123 -

开源

+关注

关注

3文章

4031浏览量

45548 -

大模型

+关注

关注

2文章

3440浏览量

4960

原文标题:大模型训练中的开源数据和算法:机遇及挑战

文章出处:【微信号:OSC开源社区,微信公众号:OSC开源社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

模板驱动 无需训练数据 SmartDP解决小样本AI算法模型开发难题

请问如何在imx8mplus上部署和运行YOLOv5训练的模型?

模型原生操作系统:机遇、挑战与展望 CCCF精选

让大模型训练更高效,奇异摩尔用互联创新方案定义下一代AI计算

大模型训练:开源数据与算法的机遇与挑战分析

大模型训练:开源数据与算法的机遇与挑战分析

评论