优化输入提示(prompt engineering)是提高人工智能模型输出质量的关键步骤。对于Llama 3这样的模型,优化输入提示可以帮助模型更准确地理解用户的意图,从而生成更相关和高质量的内容。

- 明确和具体的指令 :

- 确保你的指令清晰、具体,避免模糊不清的表达。例如,而不是说“写一篇关于AI的文章”,你可以说“写一篇2000字的文章,探讨人工智能在医疗领域的应用”。

- 使用关键词 :

- 包含关键词可以帮助模型更快地定位到相关的信息和上下文。例如,“人工智能”、“医疗领域”、“应用案例”等。

- 上下文信息 :

- 提供足够的背景信息,帮助模型理解文章的背景和目的。例如,如果你的文章是为了一个特定的读者群体,比如医疗行业的专业人士,确保在提示中提及这一点。

- 结构化提示 :

- 将文章分成几个部分,并为每个部分提供具体的指令。例如,“引言部分介绍人工智能的基本概念;主体部分分为三个小节,分别讨论AI在诊断、治疗和患者监护中的应用;结论部分总结AI在医疗领域的潜力和挑战”。

- 避免歧义 :

- 使用精确的语言来避免歧义。例如,避免使用“可能”、“或许”等模糊词汇,而是使用“将”、“能够”等确定性词汇。

- 使用例子 :

- 提供具体的例子可以帮助模型生成更具体和详细的内容。例如,“在讨论AI在诊断中的应用时,可以提到IBM的Watson如何帮助医生分析医学影像”。

- 风格和语调 :

- 指定文章的风格和语调,比如正式、非正式、幽默或严肃,这可以帮助模型生成符合预期的文本。

- 长度限制 :

- 明确指出文章的长度要求,比如“2000字”,这样模型可以更好地控制输出的长度。

- 避免过度复杂 :

- 避免在提示中使用过于复杂或技术性的语言,这可能会导致模型输出难以理解的内容。

- 反馈和迭代 :

- 如果可能,对模型的输出进行评估,并根据反馈调整你的输入提示。这有助于不断优化提示,以获得更好的结果。

- 使用模板 :

- 如果你经常需要撰写类似的文章,可以创建一个或多个模板,这些模板可以快速调整以适应不同的主题。

- 避免偏见 :

- 确保你的提示中不包含任何偏见或歧视性语言,这有助于生成公正和包容的内容。

- 创造性元素 :

- 如果适用,可以在提示中加入一些创造性元素,比如故事讲述或案例研究,以增加文章的吸引力。

- 明确截止日期 :

- 如果有特定的截止日期,确保在提示中提及,这样模型可以更快地生成内容。

- 使用引用和数据 :

- 如果需要,可以在提示中要求模型引用特定的研究或数据,以增强文章的可信度。

通过这些策略,你可以更有效地优化Llama 3的输入提示,从而生成更高质量的2000字文章。记住,优化输入提示是一个迭代的过程,可能需要多次尝试和调整才能达到最佳效果。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

人工智能

+关注

关注

1813文章

49734浏览量

261500 -

模型

+关注

关注

1文章

3648浏览量

51710

发布评论请先 登录

相关推荐

热点推荐

idf.py --version` 提示“不是内部或外部命令”(ESP32S3小智调试中遇到)

idf.py --version` 提示“不是内部或外部命令”(ESP32S3小智调试中遇到)

【CIE全国RISC-V创新应用大赛】基于 K1 AI CPU 的大模型部署落地

://archive.spacemit.com/spacemit-ai/llama.cpp/spacemit-llama.cpp.riscv64.0.0.4.tar.gz

# 3. 解压

tar -xzvf

发表于 11-27 14:43

利用Arm i8mm指令优化llama.cpp

本文将为你介绍如何利用 Arm i8mm 指令,具体来说,是通过带符号 8 位整数矩阵乘加指令 smmla,来优化 llama.cpp 中 Q6_K 和 Q4_K 量化模型推理。

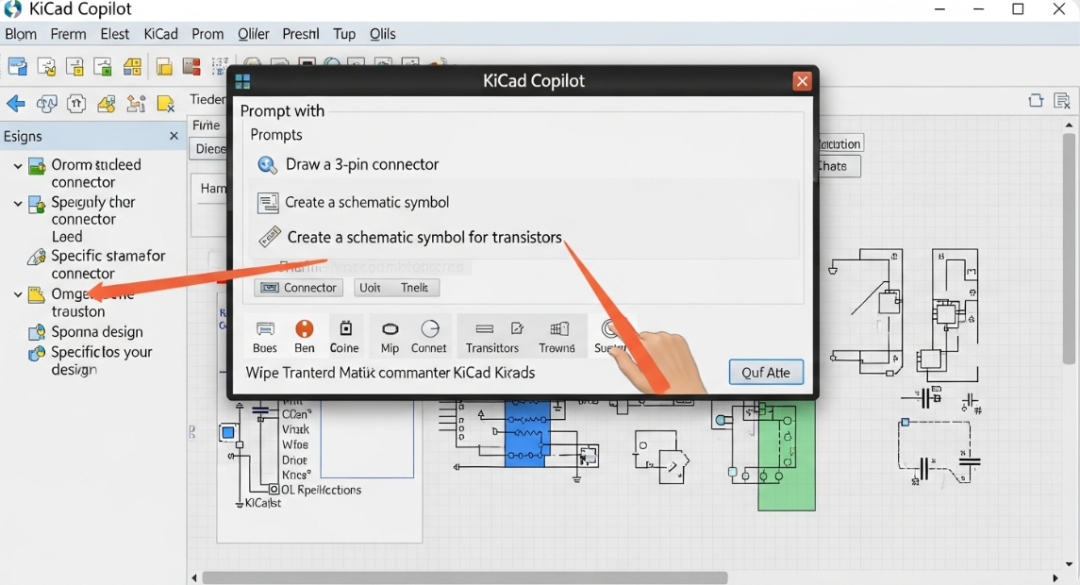

Copilot操作指南(二):使用预置提示词管理您自己的“工具”

“ 新版本的 Copilot 支持 Prompt 提示词的保存、导入及导出。您可以直接调用常用的提示词,结合与图纸的交互功能,快速实现一些非常酷的功能。 ” 预置 Prompt 提示词

使用 NPU 插件对量化的 Llama 3.1 8b 模型进行推理时出现“从 __Int64 转换为无符号 int 的错误”,怎么解决?

安装了 OpenVINO™ GenAI 2024.4。

使用以下命令量化 Llama 3.1 8B 模型:

optimum-cli export openvino -m meta-llama

发表于 06-25 07:20

鸿蒙5开发宝藏案例分享---性能优化案例解析

)

}

})

}

}

Code Linter警告 :

⚠️ AvoidDeepNestLayout :检测到3层嵌套布局,可能导致渲染卡顿!

优化方案 :用<span class

发表于 06-12 16:36

今日看点丨台积电、Intel合资运营代工业务;韩国计划向当地汽车行业注入3万亿韩元援助

1. Meta 发布人工智能新模型系列 Llama 4 ,首次采用“混合专家”架构 当地时间周六(4月5日),美国科技巨头Meta推出了其最强大的开源人工智能(AI)模型Llama 4

发表于 04-07 11:26

•590次阅读

开关电源输入滤波电路的优化设计研究

滤波电路相比,该滤波电路去掉了差模电感,滤波器的输入输出也不需再加共模电容。

图1.优化的输入滤波电路 上图中:R1为放电电阻;L1、L3为低频共模电感;L2为高频共模电感;CX

发表于 03-12 15:00

无法在OVMS上运行来自Meta的大型语言模型 (LLM),为什么?

无法在 OVMS 上运行来自 Meta 的大型语言模型 (LLM),例如 LLaMa2。

从 OVMS GitHub* 存储库运行 llama_chat Python* Demo 时遇到错误。

发表于 03-05 08:07

FRED应用:LED发光颜色优化

。第四个无光线追迹面用于优化后的颜色对比。

优化变量

优化的第一步涉及到变量的定义,本例中,优化3个LED光源的光功率。因为没有对应的光源

发表于 01-17 09:39

NVIDIA推出开放式Llama Nemotron系列模型

作为 NVIDIA NIM 微服务,开放式 Llama Nemotron 大语言模型和 Cosmos Nemotron 视觉语言模型可在任何加速系统上为 AI 智能体提供强效助力。

FRED应用:LED发光颜色优化

。第四个无光线追迹面用于优化后的颜色对比。

优化变量

优化的第一步涉及到变量的定义,本例中,优化3个LED光源的光功率。因为没有对应的光源

发表于 01-07 08:51

Meta重磅发布Llama 3.3 70B:开源AI模型的新里程碑

在人工智能领域,Meta的最新动作再次引起了全球的关注。今天,我们见证了Meta发布的 Llama 3.3 70B 模型,这是一个开源的人工智能模型,它不仅令人印象深刻,而且在性能上达到了一个

Meta推出Llama 3.3 70B,AI大模型竞争白热化

在今年的AI领域,Meta也不甘落后,推出了其压轴之作——Llama 3.3 70B大模型。与此同时,马斯克的xAI也宣布其Grok模型从今天起全球免费开放(但存在一定的使用限制)。 Meta

如何优化 Llama 3 的输入提示

如何优化 Llama 3 的输入提示

评论