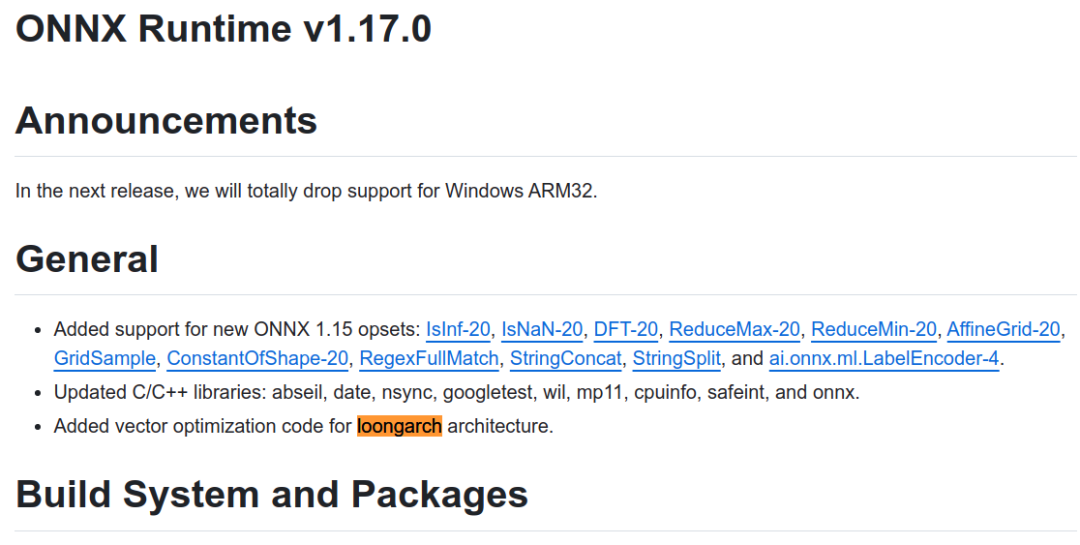

近日,知名AI推理框架开源社区ONNX Runtime正式发布支持龙架构的版本1.17.0。今后,用户可以直接使用ONNX Runtime开源社区发布的版本在龙芯平台完成AI推理类应用的开发和部署,标志着龙架构软件生态得到进一步完善。

ONNX Runtime(ORT)是近年来兴起的AI推理框架软件,被大量AI应用作为基础AI推理引擎。ORT可支持PyTorch、Tensorflow、TFLite等多种格式的模型输入,以及CPU、GPU、IoT、NPU、FPGA等多样化算力后端。

在ONNX Runtime 社区1.17.0版本的研制过程中,龙芯中科技术团队与社区保持紧密合作,期间向ONNX Runtime社区代码仓库提交了7697行代码,对矩阵乘法、卷积、转置等核心算子进行深度向量优化。在社区支持下,龙架构优化代码通过了检视、测试验证等质量保证流程,ONNX Runtime社区自1.17.0版本起正式实现对龙架构的原生支持。

未来,龙芯中科将继续与AI领域的国际开源软件社区携手合作,助力AI领域的生态发展和技术创新,为用户带来更优产品,实现更大价值。

审核编辑:刘清

-

FPGA

+关注

关注

1655文章

22283浏览量

630183 -

龙芯中科

+关注

关注

0文章

353浏览量

8429 -

NPU

+关注

关注

2文章

358浏览量

20830

原文标题:AI推理框架软件ONNX Runtime正式支持龙架构

文章出处:【微信号:gh_53fadbdbd4d4,微信公众号:龙芯中科】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

Alif Semiconductor的Ensemble MCU新增对ExecuTorch Runtime的支持,助力其推动边缘生成式AI发展

NVIDIA TensorRT LLM 1.0推理框架正式上线

onnx模型转换rknn模型出现问题

请问如何在RK3588上使用npu,用onnx模型来推理

信而泰×DeepSeek:AI推理引擎驱动网络智能诊断迈向 “自愈”时代

Nordic收购 Neuton.AI 关于产品技术的分析

润和软件StackRUNS异构分布式推理框架的应用案例

润和软件发布StackRUNS异构分布式推理框架

【米尔MYC-YM90X安路飞龙DR1开发板】安路科技 SALDRAGON开发板介绍

首创开源架构,天玑AI开发套件让端侧AI模型接入得心应手

边缘AI新突破:MemryX AI加速卡与RK3588打造高效多路物体检测方案

无法在GPU上运行ONNX模型的Benchmark_app怎么解决?

《AI Agent 应用与项目实战》第1-2章阅读心得——理解Agent框架与Coze平台的应用

迅龙软件受邀参加华为昇思人工智能框架峰会,展示昇思X香橙派的创新AI案例

AI推理框架软件ONNX Runtime正式支持龙架构

AI推理框架软件ONNX Runtime正式支持龙架构

评论