电子发烧友网报道(文/李弯弯)大模型的边缘部署是将大模型部署在边缘设备上,以实现更快速、更低延迟的计算和推理。边缘设备可以是各种终端设备,如智能手机、平板电脑、智能家居设备等。通过将大模型部署在边缘设备上,可以减少数据传输的延迟和带宽需求,提高模型的实时性和响应速度。

边缘端部署大模型的优势

边缘侧部署大模型有诸多优势。低延迟:由于边缘计算将数据处理在离用户较近的设备上,大大减少了数据传输的延迟,提高了服务的实时性。这对于许多需要快速响应的应用场景,如智能家居、智能安防等,非常重要。

降低带宽成本:在边缘侧部署大模型可以减少数据传输的需求,因为只有经过处理的结果需要传输到中心服务器或云端。这大大降低了数据传输的带宽成本,对于物联网和5G等高带宽需求的场景尤其有益。

隐私保护:由于数据处理在边缘设备上进行,减少了数据传输和存储的风险,更好地保护了用户隐私。这在处理敏感数据的应用场景中尤为重要。

可扩展性:随着物联网和5G技术的不断发展,边缘设备的数量和数据处理能力也在快速增长。这为大模型在边缘侧部署提供了更好的可扩展性。

应对突发状况:在某些情况下,如网络拥堵或设备故障,边缘部署可以提供更加稳定的服务,因为数据处理是在本地进行的,可以快速响应并处理突发状况。

在边缘侧部署大模型需要综合考虑多个因素,包括硬件资源、网络环境、模型优化等。软硬件适配方面,需要选择合适的硬件设备,确保其具备足够的计算和存储资源来部署大模型。同时,需要考虑操作系统和框架的适配性,确保它们能够支持大模型的运行。

模型优化方面,对大模型进行优化,以减小其大小和计算复杂度。这可以通过模型剪枝、量化感知训练等技术实现。优化后的模型可以更好地适应边缘设备的资源限制。

数据预处理方面,在部署前对数据进行预处理,包括数据清洗、数据压缩等,以减小数据传输和存储的开销。边缘计算框架选择方面,需要选择合适的边缘计算框架,如TensorFlow Edge TPU、KFServing等,这些框架可以帮助简化大模型在边缘侧的部署过程。

安全和隐私保护方面,在部署过程中要考虑数据的安全性和隐私保护。采取适当的加密和安全传输技术,确保数据不被泄露或被恶意攻击。

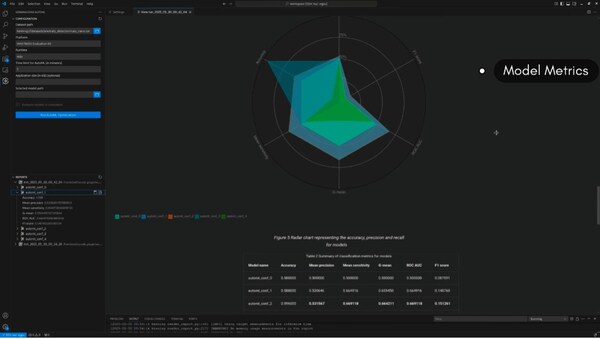

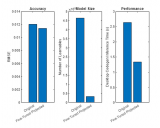

持续模型更新方面,由于技术和数据的变化,可能需要不断更新大模型。因此,需要考虑如何方便地对模型进行更新和维护,以保证其持续的有效性。性能评估和监控方面,部署后,需要定期对模型进行性能评估和监控,以确保其运行稳定且满足预期的性能要求。

模型量化的原理及局限性

大模型边缘部署需要解决计算限制和部署高精度模型的需求之间的矛盾,而模型量化正是解决这一问题的关键技术之一。模型量化是一种有效的技术,用于减小模型的大小和计算复杂度,提高计算效率和能效。在边缘侧部署大模型时,由于硬件资源有限,模型量化成为一种重要的技术来适应边缘设备的资源限制。

模型量化的基本原理是将模型的参数从原来的32位浮点数表示转换为较低精度的表示,如8位或4位定点数。通过量化,可以大大减小模型的大小和内存消耗,同时加速模型的推理速度。在边缘计算中,这种技术有助于提高设备的能效和响应速度,满足低延迟和高实时性的需求。

模型量化的方法有多种,包括非饱和量化、饱和量化和仿射量化等。非饱和量化是将浮点数的最大值和最小值映射到定点数的最大值和最小值,而饱和量化则是先计算浮点数的阈值,然后根据阈值将浮点数映射到定点数的最大值或最小值。仿射量化则是将浮点数的最大值和最小值对应映射到定点数的最大值和最小值。

在边缘部署大模型时,模型量化需要注意一些问题。首先,量化的精度和效果需要平衡考虑,过度的量化可能会影响模型的准确性和性能。其次,需要考虑硬件设备的支持和兼容性,不同的设备可能支持不同的量化位数和格式。此外,还需要注意数据的一致性和可靠性,以及模型的稳定性和可维护性。

模型量化技术对于边缘人工智能等应用场景具有重要的意义,可以减小模型大小和计算复杂度,提高计算效率和能效,从而加速边缘计算的发展和应用。

同时模型量化也有它的局限性。比如,模型量化通过降低数值精度来减小模型大小和计算复杂度,这可能导致模型在量化后准确率的降低,尤其是在一些复杂的任务和数据集上。另外,模型量化需要硬件设备支持低精度的数据表示和计算,一些老旧或低端的硬件设备可能不支持所需的量化位数,导致无法充分利用模型量化的优势。

模型量化还可能导致数据的一致性和可靠性下降,由于量化引入了一定的误差,因此在一些需要高精度计算或判断的场景中,量化后的模型可能无法满足要求;模型量化也可能对模型的稳定性和可维护性产生影响,在量化的过程中,需要仔细选择合适的参数和量化方法,以确保模型的性能和稳定性。此外,模型量化可能不适用于所有任务和场景,对于一些需要高精度和复杂计算的场景,如科学计算、金融分析等,模型量化可能不是最佳选择。

除了模型量化之外,大模型的边缘部署还可以采用其他一些方法来提高效率和能效。如:1、模型剪枝和压缩:通过删除模型中的冗余参数和降低模型的复杂性,可以实现模型的剪枝和压缩。这种方法可以减小模型的大小,提高计算效率和能效。

硬件优化:针对边缘设备的硬件特点进行优化,可以提高设备的计算效率和能效。例如,优化设备的内存管理、使用更高效的处理器和加速器等;3、模型压缩和推理优化:通过优化模型的推理过程,可以减小计算量和提高计算效率。例如,使用更高效的算法和数据结构,优化模型的并行化等。

4、端侧设备计算能力提升:随着技术的不断发展,边缘设备的计算能力也在不断提高。通过提升设备的计算能力,可以更好地支持大模型的部署和计算;5、模型缓存和离线预热:通过缓存模型推理结果或提前预热模型,可以减少在线计算量和提高计算效率。这种方法适用于一些静态任务或周期性任务。

总结

当下全球科技企业都在争相探索大模型的落地商用,在边缘侧部署无疑是大模型能够实现规模应用的关键。然而与云端不同,边缘设备存在计算资源较为有限的问题,如何让大模型适应边缘设备资源就成了需要重点解决的重点问题。模型量化可以在保证模型有效性的同时减少模型部分精度,使得模型大小减少和计算复杂度降低,从而来适应边缘设备的资源。

-

大模型

+关注

关注

2文章

3440浏览量

4964

发布评论请先 登录

如何精准驱动菜品识别模型--基于米尔瑞芯微RK3576边缘计算盒

基于米尔瑞芯微RK3576开发板的Qwen2-VL-3B模型NPU多模态部署评测

边缘智能网关在水务行业中的应用—龙兴物联

Arm方案 基于Arm架构的边缘侧设备(树莓派或 NVIDIA Jetson Nano)上部署PyTorch模型

打通边缘智能之路:面向嵌入式设备的开源AutoML正式发布----加速边缘AI创新

【幸狐Omni3576边缘计算套件试用体验】DeepSeek 部署及测试

研华边缘AI平台测试DeepSeek蒸馏版模型的最新数据

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略

研华边缘AI Box MIC-ATL3S部署Deepseek R1模型

边缘侧部署大模型优势多!模型量化解决边缘设备资源限制问题

边缘侧部署大模型优势多!模型量化解决边缘设备资源限制问题

评论